Actualidad informática

Noticias y novedades sobre informática

Cómo una tarjeta MicroSD puede almacenar hasta 400GB de datos

El 31 de agosto de 2017 la empesa SanDisk anunció una tarjeta microSD de gran capacidad de almacenamiento, capaz de introducir 400 GB de datos en ella. ¡Eso es correcto! Una tarjeta de memoria del tamaño de un centavo puede almacenar unas increíbles 40 horas de vídeo 1080p en bruto, algo que era absolutamente incomprensible para los expertos en tecnología hace apenas una década. Pero, ¿es este realmente el límite superior? ¿Hemos llegado a la memoria máxima? ¿O podemos encajar aún más en este pequeño espacio de cinco milímetros cuadrados?

Un problema teórico

Medio centímetro no le da mucho espacio, y los dispositivos que se fabrican para tarjetas microSD no pueden volver a ser utilizados para otra cosa. Esto significa que tendrás que trabajar dentro de estas limitaciones. Por lo general, los fabricantes de tarjetas como SanDisk reducirían el tamaño de sus transistores para que quepan más de ellos en un espacio minúsculo. En 2013 este tamaño era de aproximadamente 19 nm. Una lámina de estos transistores dentro de un espacio de medio centímetro daría 8 GB de espacio de almacenamiento, que era abundante para la mayoría de los dispositivos de consumo a pequeña escala.

Para hacer que más memoria quepa en la misma cantidad de espacio, necesitaría apilar los transistores uno encima del otro, creando capas de transistores que doblarían o cuadruplicarían la cantidad de espacio de almacenamiento disponible. Así es como empezaron a aparecer las tarjetas microSD con capacidades de 32 GB. Llega un momento en el tiempo, sin embargo, donde las cosas se ponen un poco demasiado cómodas y tienes que empezar a comer en el marco para encajar más capas.

En el nivel de 19 nm, se necesitarían ocho capas de transistores para ajustar 64 GB de memoria. Para encajar 400 GB, se necesitarían exactamente cincuenta capas. Aunque esto es teóricamente posible, es extraordinariamente difícil de hacer en un espacio tan reducido.

Cuando no hay otra opción que doblar la apuesta

Ya hemos discutido el hecho de que no es posible cambiar las dimensiones de cada ranura en cada dispositivo para que quepa una tarjeta más grande. La única opción que queda es sumergirse aún más en la tecnología de fabricación de microtransistores. ¡Tenemos que hacerlos más pequeños!

Teóricamente, un transistor podría ser tan pequeño como una sola molécula. El 14 de agosto, hemos conseguido hacer transistores de molécula única que funcionaban de forma sostenible a temperatura ambiente. Debido a que el proceso de hacerlas es tan complicado, no podemos esperar que se conviertan en algo dominante en el futuro, pero presentan una ventana a lo que parece el futuro. Pronto veremos transistores de tan sólo 5 nm.

Recuerde, los transistores caben en un espacio tridimensional, lo que significa que a medida que se hacen más pequeños, también se obtiene más espacio para apilarlos. Esto es lo que debe haber sucedido para que SanDisk sea capaz de crear una tarjeta microSD de 400 GB. Bajo la especificación de transistores de 10 nm disponible para los fabricantes a partir de 2017, puede ajustar 400 GB de memoria utilizando 25 capas de transistores, ahora pueden caber aproximadamente 16 GB por capa.

Con los transistores de 5 nm, podríamos terminar creando tarjetas microSD que se ajusten a un terabyte de memoria, que es aproximadamente donde veo el límite. Puede que no seamos capaces de superar ese nivel y probablemente ni siquiera lo necesitemos en un futuro previsible.

Ampliar en: Maketecheasyer

Los bits se vuelven antiesquirmions

El mundo actual, que cambia rápidamente debido a «big data», está encapsulado en miles de millones de pequeños objetos magnéticos -bits magnéticos- cada uno de los cuales almacena un bit de datos en unidades de disco magnético. Un grupo de científicos de los Institutos Max Planck de Halle y Dresde han descubierto un nuevo tipo de nano-objeto magnético en un material novedoso que podría servir como un bit magnético con propiedades de invisibilidad para hacer realidad en un futuro próximo una unidad de disco magnético sin partes móviles – una memoria Racetrack.

La mayoría de los datos digitales se almacenan en la nube como bits magnéticos dentro de números masivos de unidades de disco magnético. En las últimas décadas, estos bits magnéticos se han reducido en muchos órdenes de magnitud, llegando a límites donde los límites de estas regiones magnéticas pueden tener propiedades especiales. En algunos materiales especiales estos límites – «paredes de dominio magnético» – pueden ser descritos como topológicos. Lo que esto significa es que se puede pensar que estas paredes tienen un manto mágico especial – lo que los científicos llaman «protección topológica». Una consecuencia importante es que tales paredes magnéticas son más estables a las perturbaciones que los bits magnéticos similares sin protección topológica que se forman en materiales magnéticos convencionales. Así pues, estos objetos magnéticos «topológicos» podrían ser especialmente útiles para almacenar «1»y «0»los elementos básicos de los datos digitales.

Uno de estos objetos es un «esqurmión magnético» que es una pequeña región magnética, tal vez de decenas a cientos de átomos de ancho, separado de una región magnética circundante por una pared de dominio quiral. Hasta hace poco solo se ha encontrado un tipo de esqurmión, el que está rodeado por una pared de dominio quiral que toma la misma forma en todas las direcciones. Pero hanbhabido predicciones de varios otros tipos de esqurmiones que aún no se han observado. En un artículo publicado en Nature, científicos del departamento NISE del Prof. Stuart Parkin en el Instituto Max Planck para la Física de Microestructuras en Halle, Alemania, han encontrado una segunda clase de esquirmiones, lo que se llama «antisesquirmiones», en materiales sintetizados en el Departamento de Química de Estado Sólido del Prof. Claudia Felser en el Instituto Max Planck para CPFS, Dresden, Alemania.

Los científicos de Halle y Dresden han encontrado estos diminutos objetos magnéticos en una clase especial de compuestos magnéticos versátiles llamados Heusler que Claudia Felser y sus colegas han explorado extensamente durante los últimos 20 años. De estos compuestos de Heusler, un pequeño subconjunto tiene la simetría cristalina justa para permitir la posibilidad de formar antiesquirmiones pero no sesquirmiones. Utilizando un microscopio electrónico de transmisión altamente sensible en el Instituto Max Planck para Física de Microestructuras, Halle, que fue especialmente modificado para permitir la detección de pequeños momentos magnéticos, se crearon y detectaron antiesquirmiones sobre una amplia gama de temperaturas y campos magnéticos. Y lo que es más importante, los antiesquirmiones, tanto en arreglos ordenados como en objetos aislados, se podían ver incluso a temperatura ambiente y en campos magnéticos cero.

Las propiedades especiales de ocultación de los esquirmiones los hace de gran interés para una forma radicalmente nueva de memoria de estado sólido – Memoria Racetrak – que fue propuesta por Stuart Parkin hace una década. En Racetrack, los datos digitales están codificados dentro de las paredes del dominio magnético, que se encuentran dentro de cables magnéticos nanoscópicos. Una de las características únicas de Racetrack, que es diferente a todas las demás memorias, es que las paredes se mueven alrededor de los nanocables usando descubrimientos recientes en la espin-orbitrónica. Los pulsos muy cortos de corriente mueven todas las paredes del dominio hacia atrás y hacia adelante a lo largo de los nanocables. Las paredes -las puntas magnéticas- pueden ser leídas y escritas por dispositivos incorporados directamente en los propios nanohilos, eliminando así cualquier pieza mecánica. Las paredes magnéticas protegidas topológicamente son muy prometedoras para las memorias Racetrack.

Por lo tanto, los antisesquirmiones podrían aplicarse a las memorias Racetrack pronto. Yendo incluso más allá de los antiesquirmiones el siguiente objetivo es la realización de una tercera clase de esquirmiones – esquirmiones antiferromagnéticos- que son diminutos objetos magnéticos que realmente no tienen ningún momento magnético neto. Son magnéticamente casi invisibles pero tienen propiedades únicas que los hacen de gran interés.

Ampliar en: Ajaya K. Nayak et al, Magnetic antiskyrmions above room temperature in tetragonal Heusler materials, Nature (2017). DOI: 10.1038/nature23466

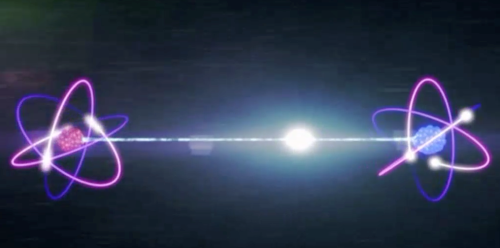

El entrelazamiento es una característica inevitable de la realidad

¿Es realmente necesario el entrelazamiento para describir el mundo físico, o es posible tener alguna teoría post-cuántica sin entrelazamiento?

¿Es realmente necesario el entrelazamiento para describir el mundo físico, o es posible tener alguna teoría post-cuántica sin entrelazamiento?

En un nuevo estudio, físicos han probado matemáticamente que cualquier teoría que tenga un límite clásico -es decir, que pueda describir nuestras observaciones del mundo clásico recuperando la teoría clásica bajo ciertas condiciones- debe contener entrelazamientos. Así que a pesar de que el entrelazamiento va en contra de la intuición clásica, el entrelazamiento debe ser una característica inevitable no sólo de la teoría cuántica, sino también de cualquier teoría no clásica, incluso de las que aún están por desarrollar.

Los físicos, Jonathan G. Richens en el Imperial College London y el University College London, John H. Selby en el Imperial College London y la Universidad de Oxford, y Sabri W. Al-Safi en la Universidad de Nottingham Trent, han publicado un artículo estableciendo el entrelazamiento como una característica necesaria de cualquier teoría no clásica en un número reciente de Physical Review Letters.

«La teoría cuántica tiene muchas características extrañas en comparación con la teoría clásica», dijo Richens a Phys. org. «Tradicionalmente estudiamos cómo el mundo clásico emerge del cuántico, pero nos propusimos revertir este razonamiento para ver cómo el mundo clásico da forma al cuántico. Al hacerlo, demostramos que uno de sus rasgos más extraños, el entrelazamiento, no es nada sorprendente. Esto insinúa que gran parte de la aparente extrañeza de la teoría cuántica es una consecuencia inevitable de ir más allá de la teoría clásica, o tal vez incluso una consecuencia de nuestra incapacidad para dejar atrás la teoría clásica».

Aunque la prueba completa es muy detallada, la idea principal detrás de ella es simplemente que cualquier teoría que describa la realidad debe comportarse como una teoría clásica en algún límite. Este requisito parece bastante obvio, pero como muestran los físicos, imparte fuertes restricciones a la estructura de cualquier teoría no clásica.

La teoría cuántica cumple este requisito de tener un límite clásico a través del proceso de decoherencia. Cuando un sistema cuántico interactúa con el entorno externo, el sistema pierde su coherencia cuántica y todo lo que lo hace cuántico. Así que el sistema se vuelve clásico y se comporta como se espera de la teoría clásica.

Aquí, los físicos muestran que cualquier teoría no clásica que recupere la teoría clásica debe contener estados entrelazados. Para demostrarlo, asumen lo contrario: que tal teoría no tiene entrelazamiento. Entonces demuestran que, sin entrelazarse, cualquier teoría que recupere la teoría clásica debe ser la teoría clásica en sí misma, una contradicción de la hipótesis original de que la teoría en cuestión no es clásica. Este resultado implica que la suposición de que tal teoría no tiene entrelazado es falsa, lo que significa que cualquier teoría de este tipo debe tener entrelazado.

Este resultado puede ser sólo el comienzo de muchos otros descubrimientos relacionados, ya que abre la posibilidad de que otros rasgos físicos de la teoría cuántica puedan reproducirse simplemente exigiendo que la teoría tenga un límite clásico. Los físicos anticipan que características como la causalidad de la información, la simetría de bits y la ubicación macroscópica pueden aparecer como resultado de este único requisito. Los resultados también proporcionan una idea más clara de cómo debe ser cualquier teoría futura no clásica, post-cuántica.

«Mis metas futuras serían ver si la no-localidad de Bell también puede derivarse de la existencia de un límite clásico», dijo Richens. «Sería interesante si todas las teorías que reemplazan a la teoría clásica violaran el realismo local. También estoy trabajando para ver si ciertas extensiones de la teoría cuántica (como la interferencia de orden superior) pueden ser descartadas por la existencia de un límite clásico, o si este límite imparte restricciones útiles a estas’ teorías post-cuántico'».

Ampliar en: Jonathan G. Richens, John H. Selby, and Sabri W. Al-Safi. «Entanglement is Necessary for Emergent Classicality in All Physical Theories.» Physical Review Letters. DOI: 10.1103/PhysRevLett.119.080503

DeepL instruye a otros traductores en línea con aprendizaje automático inteligente

Los gigantes tecnológicos Google, Microsoft y Facebook están aplicando las lecciones de aprendizaje automático (machine learning) a la traducción, pero una pequeña empresa llamada DeepL las ha superado a todas y ha elevado el listón en este campo. Su herramienta de traducción es tan rápida como la competencia, pero más precisa y matizada que cualquiera de las que se conocen.

Mientras que Google Translate a menudo busca una traducción muy literal que no tiene en cuenta algunos matices y expresiones idiomáticas (o que la traducción de estas expresiones idiomáticas es un error), DeepL a menudo proporciona una traducción más natural que se acerca más a la de un traductor capacitado.

Algunas pruebas de mi propia experiencia con alguna literatura francesa que conozco lo suficientemente bien como para juzgar que DeepL gana habitualmente. Menos errores de tensión, intención y concordancia, además de una mejor comprensión y despliegue del lenguaje hacen que la traducción sea mucho más legible. Nosotros pensamos que sí, y también los traductores en las pruebas ciegas de DeepL.

Si bien es cierto que el significado puede transmitirse con éxito a pesar de los errores, como lo demuestra la utilidad que todos hemos encontrado en las traducciones automáticas más pobres, está lejos de garantizar que cualquier traducción valga.

Linguee evolucionado

DeepL nació de Linguee, una herramienta de traducción que existe desde hace años y, aunque popular, nunca llegó a alcanzar el nivel de Google Translate, esta última tiene una enorme ventaja en marca y posición. El cofundador de Linguee, Gereon Frahling, solía trabajar para Google Research, pero en 2007 abandonó la empresa para dedicarse a esta nueva empresa.

El equipo ha estado trabajando con el aprendizaje automático durante años, para tareas adyacentes a la traducción principal, pero fue sólo el año pasado que comenzaron a trabajar en serio en un sistema y una empresa completamente nuevos, que llevarían el nombre de DeepL.

Frahling dijo que había llegado el momento:»Hemos construido una red de traducción neuronal que incorpora la mayoría de los últimos desarrollos, a los que hemos añadido nuestras propias ideas».

Una enorme base de datos de más de mil millones de traducciones y consultas, además de un método de traducción mediante la búsqueda de fragmentos similares en la web, sirvió para una base sólida en el entrenamiento del nuevo modelo. También armaron lo que dicen que es el 23º superordenador más poderoso del mundo, convenientemente ubicado en Islandia.

Los desarrollos publicados por universidades, agencias de investigación y competidores de Lingueee demostraron que las redes neuronales convolucionales eran el camino a seguir, en lugar de las redes neuronales recurrentes que la empresa había estado utilizando anteriormente. Este no es realmente el lugar para entrar en las diferencias entre las CNNs y las RNNs, por lo que debe ser suficiente decir que para una traducción precisa de largas y complejas cadenas de palabras relacionadas, la primera es una mejor opción siempre y cuando se pueda controlar sus debilidades.

Por ejemplo, de una CNN podría se puede decir que aborda una palabra de la oración a la vez. Esto se convierte en un problema cuando, por ejemplo, como sucede comúnmente, una palabra al final de la oración determina cómo debe formarse una palabra al principio de la oración. Es un desperdicio repasar toda la oración sólo para encontrar que la primera palabra que la red escogida está equivocada, y luego empezar de nuevo con ese conocimiento, así que DeepL y otros en el campo de aprendizaje automático aplican «mecanismos de atención» que monitorean esos posibles tropiezos y los resuelven antes de que la CNN pase a la siguiente palabra o frase.

Hay otras técnicas secretas en juego, por supuesto, y su resultado es una herramienta de traducción que personalmente usaré por fefecto. Espero con impaciencia ver a los demás mejorar su juego.

Google Transformer resuelve un problema complicado en la traducción automática

El aprendizaje automático ha resultado ser una herramienta muy útil para la traducción, pero tiene algunos puntos débiles. La tendencia de los modelos de traducción a hacer su trabajo palabra por palabra es una de ellas, y puede llevar a errores graves. Google detalla la naturaleza de este problema, y su solución, en un interesante post en su blog de Investigación.

El problema se explica bien por Jakob Uszkoreit, del departamento de procesamiento del lenguaje natural de la empresa. Considere las dos oraciones siguientes:

Llegué al banco después de cruzar la calle.

Llegué al banco después de cruzar el río.

Obviamente,»banco» significa algo diferente en cada oración, pero un algoritmo que mastica su camino podría fácilmente escoger el equivocado, ya que no sabe qué «banco» es el correcto hasta que llega al final de la oración. Esta clase de ambigüedad está en todas partes una vez que empiezas a buscarla.

Yo, yo sólo reescribiría la oración (Strunk and White advirtió sobre esto), pero por supuesto que no es una opción para un sistema de traducción. Y sería muy ineficaz modificar las redes neuronales para traducir básicamente toda la oración y ver si está pasando algo raro, y luego intentarlo de nuevo si lo hay.

La solución de Google es lo que se llama un mecanismo de atención, integrado en un sistema que llama Transformer. Compara cada palabra con cada palabra de la oración para ver si alguna de ellas afectará la una a la otra de alguna manera clave – para ver si «él» o «ella» está hablando, por ejemplo, o si una palabra como «banco» significa algo en particular.

Cuando la oración traducida está siendo construida, el mecanismo de atención compara cada palabra como se agrega a cada otra. Este gif ilustra todo el proceso. Bueno, más o menos.

Una empresa de traducción competidora de Google, DeepL, también utiliza un mecanismo de atención. Su co-fundador citó este problema como uno en el que también habían trabajado duro, e incluso mencionó queestá basado en el artículo de Google (atención es todo lo que necesitas), aunque obviamente hicieron su propia versión. Y una muy efectiva, quizás incluso mejor que la de Google.

Un efecto secundario interesante del enfoque de Google es que da una ventana a la lógica del sistema: porque Transformer le da a cada palabra una puntuación en relación con cada otra palabra, se puede ver qué palabras «piensa» que están relacionadas, o potencialmente relacionadas:

Este es otro tipo de ambigüedad, donde «él» podría referirse a la calle o al animal, y sólo la última palabra lo delata. Lo resolveríamos automáticamente, pero las máquinas deben ser enseñadas.

Almacenamiento de datos en imanes del tamaño de un átomo

Hay un dicho que indica que los datos se expandirán hasta llenar toda la capacidad disponible. Tal vez hace diez o veinte años, era común almacenar programas de software, música MP3, películas y otros archivos, que podáin haber sido recopilados durante años. En los días en que las unidades de disco duro ofrecían unas pocas decenas de gigabytes de almacenamiento, la falta de espacio era casi inevitable.

Ahora que tenemos internet de banda ancha rápida y no pensamos en la descarga de un DVD de 4,7 gigabytes, podemos acumular datos aún más rápidamente. Las estimaciones de la cantidad total de datos almacenados en todo el mundo aumentarán de 4,4 billones de gigabytes en 2013 a 44 billones de gigabytes en 2020. Esto significa que estamos generando un promedio de 15 millones de gigabytes al día. A pesar de que las unidades de disco duro ahora se miden en miles de gigabytes en lugar de decenas, todavía tenemos un problema de almacenamiento.

La investigación y el desarrollo se centran en el desarrollo de nuevos medios de almacenamiento de datos que son más densos y por lo que puede almacenar una mayor cantidad de datos, y hacerlo de una manera más eficiente de la energía. A veces esto implica actualizar técnicas establecidas: recientemente IBM anunció una nueva tecnología de cinta magnética que puede almacenar 25 gigabytes por pulgada cuadrada (una pulgada equivale a 2,54 cm), un nuevo récord mundial para la tecnología de 60 años de edad. Mientras que los actuales discos duros magnéticos o de estado sólido son más densos alrededor de 200 gigabytes por pulgada cuadrada, las cintas magnéticas todavía se utilizan con frecuencia para la copia de seguridad de datos.

Sin embargo, la vanguardia de la investigación de almacenamiento de datos está trabajando a nivel de átomos y moléculas individuales, representando el límite máximo de la miniaturización tecnológica.

Búsqueda de los imanes atómicos

Las tecnologías actuales de almacenamiento de datos magnéticos -las utilizadas en los discos duros tradicionales con platos giratorios, estándar hasta hace unos años y que todavía son comunes hoy en día- se basan en métodos «top-down». Esto implica hacer capas delgadas de una gran pieza de material ferromagnético, cada uno conteniendo muchos dominios magnéticos que se utilizan para contener datos. Cada uno de estos dominios magnéticos está hecho de una gran colección de átomos magnetizados, cuya polaridad magnética es establecida por la cabeza de lectura / escritura del disco duro para representar datos como binarios uno o cero.

Un método «ascendente» alternativo implicaría construir dispositivos de almacenamiento colocando átomos o moléculas individuales uno por uno, cada uno capaz de almacenar un solo bit de información. Los dominios magnéticos conservan su memoria magnética debido a la comunicación entre grupos de átomos magnetizados vecinos.

Los imanes de un solo átomo o de una sola molécula por otro lado no requieren esta comunicación con sus vecinos para retener su memoria magnética. En cambio, el efecto de memoria surge de la mecánica cuántica. Por lo tanto, debido a que los átomos o las moléculas son mucho, mucho más pequeños que los dominios magnéticos actualmente utilizados, y pueden usarse individualmente en lugar de en grupos, pueden ser empacados más estrechamente, lo que podría dar lugar a un enorme aumento en la densidad de datos.

Trabajar con átomos y moléculas como éste no es ciencia ficción. Los efectos de la memoria magnética en imanes de una sola molécula (SMMs) se demostró por primera vez en 1993, y efectos similares para los imanes de átomo único se mostraron en 2016.

Aumentar la temperatura

El problema principal que está en el camino de mover estas tecnologías fuera del laboratorio y en la corriente principal es que todavía no trabajan a temperaturas ambiente. Tanto los átomos individuales como los SMM requieren enfriamiento con helio líquido (a una temperatura de -269 ° C), un recurso costoso y limitado. Así, el esfuerzo de investigación durante los últimos 25 años se ha concentrado en elevar la temperatura a la que se puede observar la histéresis magnética, una demostración del efecto de la memoria magnética. Un objetivo importante es -196 ° C, porque esta es la temperatura que se puede lograr con el nitrógeno líquido, que es abundante y barato.

Tomó 18 años para el primer paso sustancial para elevar la temperatura en la que la memoria magnética es posible en SMMs – un aumento de 10 ° C logrado por los investigadores en California. Pero ahora el equipo de investigación en la Escuela de Química de la Universidad de Manchester ha logrado histéresis magnéticas en un SMM a -213 ° C usando una nueva molécula basada en el elemento de tierras raras disprosio, según se informa en una carta a la revista Nature. Con un salto de 56 ° C, esto está a sólo 17 ° C de la temperatura del nitrógeno líquido.

Usos futuros

Sin embargo, hay otros desafíos. Con el fin de almacenar prácticamente bits individuales de datos, las moléculas deben fijarse a las superficies. Esto se ha demostrado con SMMs en el pasado, pero no para esta última generación de SMMs de alta temperatura. Por otra parte, la memoria magnética en átomos individuales ya se ha demostrado en una superficie.

La prueba definitiva es la demostración de la escritura y la lectura no destructiva de datos en átomos o moléculas individuales. Esto ha sido logrado por primera vez en 2017 por un grupo de investigadores de IBM que demostró el dispositivo de almacenamiento de memoria magnética más pequeño del mundo, construido alrededor de un solo átomo.

Sin embargo, independientemente de si los dispositivos de almacenamiento de un solo átomo o de una sola molécula se vuelven verdaderamente prácticos, los avances en la ciencia fundamental que se están realizando a lo largo de este camino son fenomenales. Las técnicas de química sintética desarrolladas por los grupos que trabajan en SMM ahora nos permiten diseñar moléculas con propiedades magnéticas personalizadas, que tendrán aplicaciones en la computación cuántica e incluso la resonancia magnética.

Ampliar en: The Conversation

Nuevo ordenador resistente a la radiación espacial

La compañía de tecnología aeroespacial y de defensa BAE Systems estrena su nueva generación de ordenadores diseñados para el uso espacial. La nueva computadora RAD5545 supera a su predecesora en cuanto a tamaño, velocidad y eficiencia, afirma BAE, con mejoras «exponenciales» en todas las categorías, todo ello en un paquete que se protege por hardware contra la radiación ambiental, lo que significa que puede funcionar de manera fiable en condiciones difíciles en el espacio ultraterrestre durante períodos prolongados.

El RAD5545 está diseñado para ser más simple que los equipos usados en generaciones anteriores de vehículos espaciales y satélites, ya que reemplaza varias tarjetas con una sola. También puede desbloquear nuevas capacidades para futuras naves espaciales, incluyendo cifrado, ejecutar múltiples sistemas operativos a la vez, procesar imágenes de alta resolución, operar de manera autónoma y mucho más.

Cada una de estas tareas estaba más allá de las capacidades de los ordenadores individuales de una sola placa electrónica diseñados para el espacio, según BAE. El historial de BAE Systems en la protección de equipos informáticos está bien probado, ya que ha suministrado procesadores de satélites y naves espaciales y ordenadores durante casi 30 años, con más de 900 instalados en más de 300 satélites lanzados en ese período.

Los ordenadores industriales reforzados son clave para la informática basada en el espacio y serán cruciales para las misiones planificadas a largo plazo hacia Marte, lo que podría aumentar los riesgos de exposición para la electrónica. HPE está ahora realizando una prueba de endurecimiento del software de su propio superordenador, pero los ordenadores de una sola placa como éste seguirán siendo instrumentales en el suministro de capacidad operacional básica para cualquier nave espacial con la esperanza de alcanzar el planeta rojo.

Block-chain en la cadena de suministros alimentarios

IBM anunció hoy que está trabajando con un consorcio que incluye Dole, Golden State Foods, Kroger, McCormick y Company, Nestlé, Tyson Foods, Unilever y Walmart para llevar el beneficio de las cadenas de bloques (block-chains) a la cadena de suministro de alimentos.

IBM anunció hoy que está trabajando con un consorcio que incluye Dole, Golden State Foods, Kroger, McCormick y Company, Nestlé, Tyson Foods, Unilever y Walmart para llevar el beneficio de las cadenas de bloques (block-chains) a la cadena de suministro de alimentos.

IBM, al igual que la mayoría de sus competidores en el espacio de computación en la nube pública, ha estado trabajando en varios proyectos de cadenas de bloques en los últimos meses.

Dada la complejidad de la cadena de suministro de alimentos de productor a consumidor, block-chains podría encontrar un nicho muy interesante aquí porque permitiría más transparencia y trazabilidad (especialmente cuando las cosas van mal). La idea detrás de este proyecto y la colaboración entre estas diferentes empresas es averiguar dónde exactamente puede beneficiar el ecosistema de alimentos.

«La tecnología de Blockchain permite una nueva era de transparencia de extremo a extremo en el sistema alimentario mundial», escribe Frank Yiannas, vicepresidente de seguridad alimentaria de Walmart. «También permite a todos los participantes compartir información rápidamente y con confianza a través de una sólida red de confianza».

No es de sorprender que la Plataforma Blockchain de IBM constituya la base de gran parte de este trabajo. Soporta las tecnologías Hyperledger Fabric y Hyperledger Composer de Linux Foundation para la creación de aplicaciones basadas en cadenas de bloques.

Es interesante ver cómo una serie de grandes jugadores están trabajando para llevar block-chains a las empresas. A principios de este mes, por ejemplo, Microsoft lanzó un nuevo proyecto para hacer block-chains listos para la empresa, también, por ejemplo. A principios de este año, un estudio de IBM también encontró que un tercio de las empresas están buscando en cómo esta tecnología puede beneficiar a su negocio.

autobus las palmas aeropuerto cetona de frambuesa