Actualidad informática

Noticias y novedades sobre informática

Según simulación informática, el whisky está mejor con agua añadida

Según dos científicos suecos, la mejor manera de disfrutar un whisky es agregar un poco de agua. La dilución liberaría una pequeña molécula aromática, el guaiacol, particularmente presente en los whiskies escoceses.

Según dos científicos suecos, la mejor manera de disfrutar un whisky es agregar un poco de agua. La dilución liberaría una pequeña molécula aromática, el guaiacol, particularmente presente en los whiskies escoceses.

La fabricación del whisky comienza con etapas de fermentación y destilación. El whisky, que contiene aproximadamente el 70 % de alcohol por volumen en esta etapa, se envejece con los años. El alcohol se evapora durante esta maduración, resultando en un nivel de alcohol de aproximadamente 55-65 %. Antes del embotellado, el whisky se diluye hasta aproximadamente el 40 % añadiendo agua, lo que altera su sabor. Pero algunos aficionados todavía afirman verter un poco de agua en su copa para probar y mejorar su sabor.

En un artículo en Scientific Reports, Bjorn Karlsson y Ran Friedman querían saber si la adición de agua en el whisky realmente le dio más sabor. Para ello, utilizaron una simulación por ordenador y modelaron la composición del whisky. Hay dos hipótesis para explicar que la adición de agua mejora las cualidades gustativas del whisky, como explicó Bjorn Karlsson en el Washington Post. La primera es que el agua atrapa compuestos desagradables: ésteres de ácidos grasos. Pero según los investigadores, estos ésteres están presentes en concentraciones demasiado bajas para desempeñar un papel.

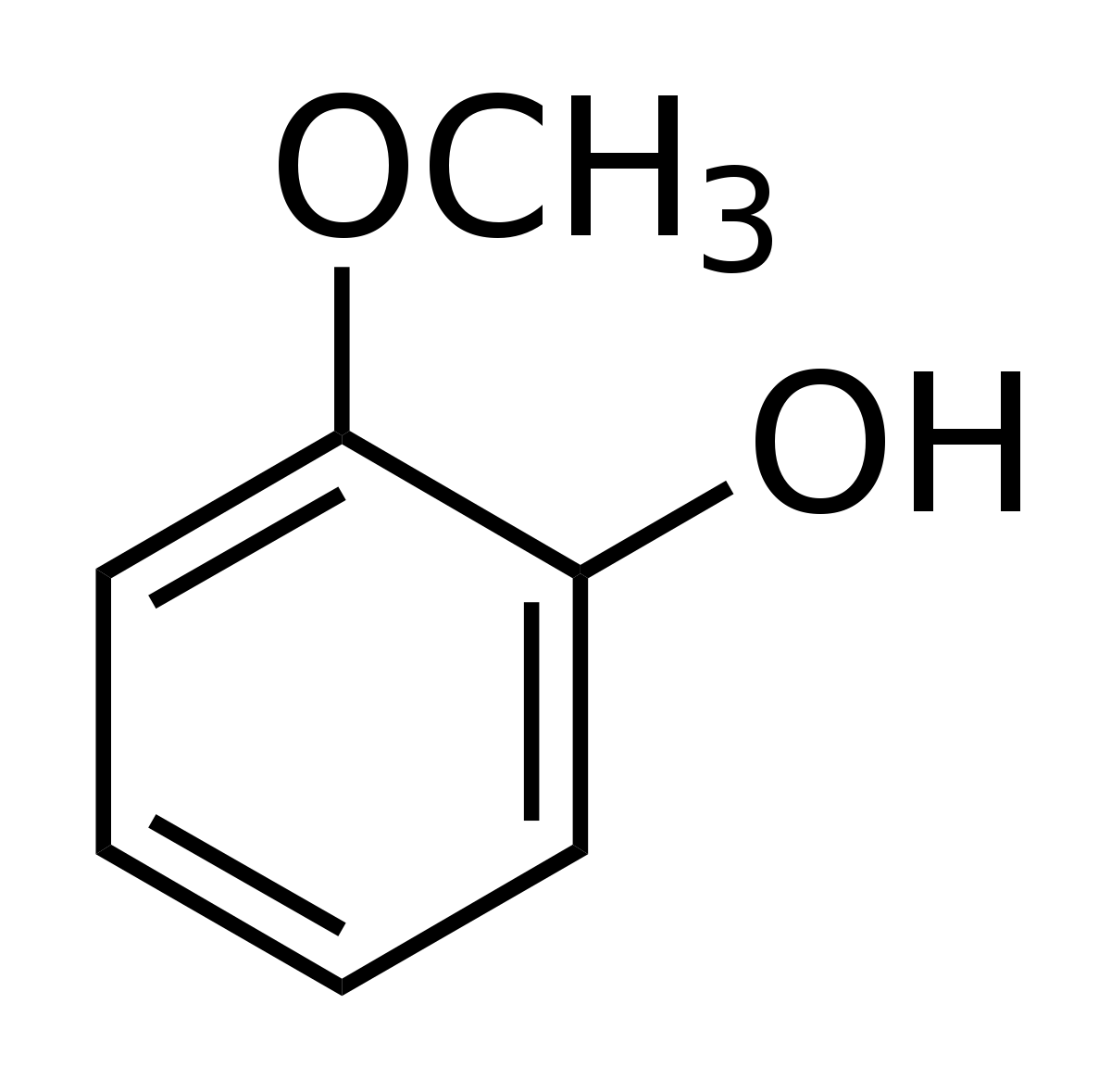

Guaiacol en la superficie del whisky diluido

La segunda hipótesis es que el agua libera moléculas que mejoran el sabor. El agua y el alcohol no se mezclan bien, los compuestos aromáticos pueden quedar atrapados en etanol y no llegar a la superficie. El whisky contiene muchos compuestos, pero los investigadores se han concentrado en guaiacol (C7H8O2), una pequeña molécula hidrofóbica que da un sabor ahumado, y más común en whisky escocés que whisky americano o irlandés.

Basándose en estas simulaciones, la concentración de etanol tuvo un efecto sobre el guaiacol. A diluciones por debajo del 45 %, es decir, a concentraciones de embotellado, el etanol se acumula en la superficie con guaiacol, donde se puede consumir. Pero por encima del 59 % de etanol, la concentración después de la destilación y antes de la dilución, el guaiacol está más rodeado de moléculas de etanol y menos presente en la superficie, y por lo tanto, en los eflujos liberados

Ordenadores «inteligentes» para procesar EEG

Filtrar información para los motores de búsqueda, actuar como oponente en juegos o reconocer imágenes: La inteligencia artificial ha superado con mucho la inteligencia humana en ciertas tareas. Varios grupos del clúster de excelencia de Friburgo, BrainLinks-BrainTools, dirigidos por el profesor de neurociencias Dr. Tonio Ball, están demostrando cómo las ideas de la informática podrían revolucionar la investigación del cerebro. En la revista científica Human Brain Mapping, ilustran cómo un algoritmo de autoaprendizaje decodifica las señales del cerebro humano que fueron medidas por un electroencefalograma (EEG). Incluye movimientos realizados, pero también movimientos de manos y pies que eran meramente pensamientos o una rotación imaginaria de objetos. A pesar de que al algoritmo no se le dio ninguna característica previamente, funciona de forma tan rápida y precisa como los sistemas tradicionales que han sido creados para resolver ciertas tareas basadas en señales cerebrales predeterminadas, que por lo tanto no son apropiadas para cada situación. La demanda de intersecciones tan diversas entre el hombre y la máquina es enorme: en el Hospital Universitario de Friburgo, por ejemplo, podría utilizarse para la detección temprana de crisis epilépticas. También podría utilizarse para mejorar las posibilidades de comunicación para los pacientes gravemente paralizados o para un diagnóstico neurológico automático.

«Nuestro software se basa en modelos inspirados en el cerebro que han demostrado ser más útiles para descifrar diversas señales naturales como los sonidos fonéticos», dice el científico informático Robin Tibor Schirrmeister. El investigador lo está utilizando para reescribir los métodos que el equipo ha utilizado para decodificar datos de EEG: las denominadas redes neuronales artificiales son el corazón del proyecto actual en BrainLinks-BrainTools. «Lo destacado acerca del programa es que no es necesario predeterminar las características. La información es procesada capa por capa, es decir, en varios pasos con la ayuda de una función no lineal. El sistema aprende a reconocer y diferenciar entre ciertos patrones de comportamiento de varios movimientos a medida que suceden», explica Schirrmeister. El modelo se basa en las conexiones entre las células nerviosas en el cuerpo humano en el que las señales eléctricas de las sinapsis se dirigen desde las protuberancias celulares al núcleo de la célula y viceversa. «Las teorías han estado en circulación durante décadas, pero no fue sino hasta el surgimiento de la potencia de procesamiento de los ordenadores actuales que el modelo se ha hecho factible», comenta Schirrmeister.

Habitualmente, la precisión del modelo mejora con un gran número de capas de procesamiento. Hasta 31 se utilizaron durante el estudio, también conocido como «Aprendizaje Profundo». Hasta ahora, había sido problemático interpretar los circuitos de la red después de completar el proceso de aprendizaje. Todos los procesos algorítmicos tienen lugar en el fondo y son invisibles. Es por eso que los investigadores desarrollaron el software para crear tarjetas a partir de las cuales podían entender las decisiones de decodificación. Los investigadores pueden insertar nuevos conjuntos de datos en el sistema en cualquier momento. «A diferencia del método antiguo, ahora podemos ir directamente a las señales crudas que el EEG registra del cerebro, nuestro sistema es tan preciso, si no mejor, que el antiguo», dice el investigador jefe Tonio Ball, resumiendo el estudio de la investigación. El potencial de la tecnología aún no se ha agotado – junto con su equipo, el investigador desea continuar su desarrollo: «Nuestra visión para el futuro incluye algoritmos de autoaprendizaje que pueden confiable y rápidamente reconocer las diversas intenciones del usuario basadas en sus señales cerebrales Además, estos algoritmos podrían ayudar a los diagnósticos neurológicos «.

Ampliar en: https://arxiv.org/abs/1703.05051

Primera transmisión de datos a través de un multiplexor de terahercios

La multiplexación, capacidad de enviar múltiples señales a través de un solo canal, es una característica fundamental de cualquier sistema de comunicación de voz o datos. Un equipo de investigación internacional ha mostrado por primera vez un método para multiplexar datos transmitidos por ondas de terahercios, radiación de alta frecuencia que puede posibilitar una próxima generación de redes inalámbricas de ancho de banda ultra-alto.

En la revista Nature Communications, los investigadores informan de la transmisión de dos señales de vídeo en tiempo real a través de un multiplexor de terahercios a una velocidad de datos agregada de 50 gigabits por segundo, aproximadamente 100 veces la velocidad óptima de datos de la red móvil celular más rápida de las actuales.

«Demostramos que podemos transmitir flujos de datos separados en ondas terahercios a velocidades muy altas y con tasas de errores muy bajas», dijo Daniel Mittleman, profesor de la Escuela de Ingeniería de Brown y coautor del documento. «Esta es la primera vez que alguien ha caracterizado un sistema de multiplexación terahercios utilizando datos reales, y los resultados muestran que nuestro enfoque podría ser viable en futuras redes inalámbricas a frecuencias de terahercios».

Las redes actuales de voz y datos utilizan microondas para llevar señales inalámbricas. Pero la demanda de transmisión de datos se está convirtiendo rápidamente en algo más de lo que las redes de microondas pueden manejar. Las ondas de terahercio tienen frecuencias más altas que las microondas y por lo tanto una capacidad mucho mayor para transportar datos. Sin embargo, los científicos apenas han comenzado a experimentar con estas frecuencias, y muchos de los componentes básicos necesarios para la comunicación teraherciios todavía no existen.

Un sistema para multiplexar y demultiplexar (también conocido como mux/demux) es uno de esos componentes básicos. Es la tecnología que permite a un cable llevar múltiples canales de televisión o a cientos de usuarios acceder a una red wifi inalámbrica.

Enfoque mux/demux

Mittleman y sus colegas desarrollaron dos placas de metal colocadas paralelas entre sí para formar una guía de ondas. Una de las placas tiene un corte. Cuando las ondas viajan a través de la guía de ondas, parte de la radiación se escapa a través de la hendidura. El ángulo en el que los haces de radiación escapan depende de la frecuencia de la onda.

«Podemos poner varias ondas a varias frecuencias diferentes – cada una de las cuales lleva una corriente de datos – en la guía de ondas, y no interferirán entre sí porque son frecuencias diferentes, eso es multiplexar», dijo Mittleman. «Cada una de esas frecuencias se escapa de la hendidura en un ángulo diferente, separando los flujos de datos, eso es demultiplexar».

Debido a la naturaleza de las ondas de terahercios, las señales en estas redes de comunicaciones se propagarán como haces direccionales, no transmisiones omnidireccionales como en los sistemas inalámbricos existentes. Esta relación direccional entre el ángulo de propagación y la frecuencia es la clave para habilitar mux/demux en estos sistemas. Un usuario en una ubicación particular (y por lo tanto en un ángulo particular desde el sistema de multiplexación) se comunicará en una frecuencia particular.

En 2015, el laboratorio de Mittleman publicó por primera vez un artículo describiendo su concepto de guía de ondas. Para ese trabajo inicial, el equipo utilizó una fuente de luz terahercios de banda ancha para confirmar que diferentes frecuencias surgieron del dispositivo en diferentes ángulos. Si bien esa fue una prueba efectiva de concepto, Mittleman dijo, este último trabajo tomó el paso crítico de probar el dispositivo con datos reales.

Trabajando con Guillaume Ducournau en el Instituto de Electrónica, Microelectrónica y Nanotecnología, CNRS / Universidad de Lille, en Francia, los investigadores codificaron dos emisiones de televisión de alta definición en ondas terahertz de dos frecuencias diferentes: 264,7 GHz y 322,5 GHz. Entonces transmitieron ambas frecuencias juntas en el sistema multiplexor, con un receptor de televisión fijado para detectar las señales como emergieron del dispositivo. Cuando los investigadores alinearon su receptor al ángulo desde el cual se emitieron las ondas de 264,7 GHz, vieron el primer canal. Cuando se alinearon con 322,5 GHz, vieron el segundo.

Otros experimentos mostraron que las transmisiones estaban libres de errores hasta 10 gigabits por segundo, lo cual es mucho más rápido que las velocidades wifi estándar actuales. Las tasas de error aumentaron algo cuando la velocidad aumentó a 50 gigabits por segundo (25 gigabits por canal), pero todavía estaban dentro del rango que se puede ajustar mediante la corrección de errores, que se utiliza comúnmente en las redes de comunicaciones actuales.

Además de demostrar que el dispositivo funcionó, Mittleman dice que la investigación reveló algunos detalles sorprendentes sobre la transmisión de datos en las ondas a terahercios. Cuando una onda se modula para codificar datos – es decir, activado y desactivado para hacer ceros y unos – la onda principal está acompañada por frecuencias de banda lateral que también deben ser detectadas por un receptor para transmitir todos los datos. La investigación mostró que el ángulo del detector con respecto a las bandas laterales es importante para mantener la tasa de error baja.

«Si el ángulo está un poco desfasado, podríamos estar detectando toda la potencia de la señal, pero estamos recibiendo una banda lateral un poco mejor que la otra, lo que aumenta la tasa de error». Mittleman explicó. «Así que es importante tener el ángulo correcto.»

Detalles fundamentales como ese serán críticos, dijo Mittleman, cuando llegue el momento de comenzar a diseñar la arquitectura para sistemas completos. «Es algo que no esperábamos, y muestra lo importante que es caracterizar estos sistemas usando datos en lugar de una fuente de radiación no modulada».

Los investigadores planean continuar desarrollando este y otros componentes. Recientemente recibió una licencia de la FCC para realizar pruebas al aire libre en frecuencias de terahercios en el campus de la Universidad Brown «Creemos que tenemos la licencia de mayor frecuencia emitida actualmente por la FCC, y esperamos que sea una señal de que la agencia esté empezando a pensar. Las compañías van a ser renuentes a desarrollar tecnologías de terahercios hasta que haya un serio esfuerzo de los reguladores para asignar las bandas de equencia para usos específicos, por lo que este es un paso en la dirección correcta.»

Ampliar en: EurekaAlert¡

El manifiesto de Google no es sexista o anti-diversidad. Es ciencia

En estos días se ha oído hablar del llamado manifiesto de «anti-diversidad» de Google y cómo James Damore, el ingeniero que lo escribió, ha sido despedido de su trabajo.

Damore dijo que la brecha de género en la diversidad de Google no se debía a la discriminación, sino a diferencias inherentes en lo que los hombres y las mujeres consideran interesante. Danielle Brown, nueva vicepresidenta de Google para la diversidad, integridad y gobernabilidad, acusó al manifiesto de avanzar «suposiciones incorrectas sobre género», y Damore confirmó anoche que fue despedido por «perpetuar los estereotipos de género».

A pesar de cómo se ha valorado, el memorándum era justo y factualmente exacto. Los estudios científicos han confirmado las diferencias sexuales en el cerebro que conducen a diferencias en nuestros intereses y comportamiento.

Como se menciona en el memorándum, los intereses de género se predicen por la exposición a la testosterona prenatal – niveles más altos se asocian con una preferencia por las cosas mecánicamente interesantes y las ocupaciones en la edad adulta. Los niveles más bajos se asocian con una preferencia por las actividades y ocupaciones orientadas a las personas.Esta es la razón por la cual los campos STEM (ciencia, tecnología, ingeniería y matemáticas) tienden a ser mayoritariamente ocupados por los hombres.

Se ven pruebas de esto en las niñas con una condición genética llamada hiperplasia suprarrenal congénita, que están expuestas a niveles inusualmente altos de testosterona en el útero. Cuando nacen, estas niñas prefieren los juguetes con ruedas, como los camiones, incluso si sus padres ofrecen más retroalimentación positiva cuando juegan con juguetes típicos femeninos, como muñecas. Del mismo modo, los hombres que están interesados en las actividades típicas de la mujer, probablemente estuvieron expuestos a niveles más bajos de testosterona.

Además, nuevas investigaciones en el campo de la genética demuestran que la testosterona altera la programación de células madre neurales, lo que lleva a las diferencias sexuales en el cerebro, incluso antes de que termine de desarrollarse en el útero. Esto sugiere además que nuestros intereses están fuertemente influenciados por la biología, en oposición a ser aprendidos o socialmente construidos.

Muchas personas, entre ellas el ex empleado de Google, han intentado refutar los puntos del memorandum, alegando que contradicen las últimas investigaciones.

Me encantaría saber qué «investigación hecha […] durante décadas» se refiere, porque miles de estudios sugieren lo contrario. Un solo estudio, publicado en 2015, afirmó que los cerebros masculinos y femeninos existían a lo largo de un «mosaico» y que no es posible diferenciarlos por sexo, pero esto ha sido refutado por cuatro – sí, cuatro – estudios académicos desde entonces.

Esto incluye un estudio que analizó exactamente los mismos datos del cerebro del estudio original y encontró que el sexo de un cerebro determinado podría ser correctamente identificado con un 69 a 77 por ciento de precisión.

Por supuesto, las diferencias existen a nivel individual, y esto no significa que el medio ambiente no juega ningún papel en nuestra formación. Pero afirmar que no hay diferencias entre los sexos cuando se miran los promedios grupales, o que la cultura tiene mayor influencia que la biología, simplemente no es cierto.

De hecho, la investigación ha demostrado que las culturas con mayor equidad de género tienen mayores diferencias sexuales en lo que respecta a las preferencias de trabajo, porque en estas sociedades, las personas son libres de elegir sus ocupaciones en función de lo que disfrutan.

Como sugiere el memorandum, no es realista tratar de cumplir una cuota de 50 por ciento de mujeres en STEM. A medida que la equidad de género continúa mejorando en las sociedades en desarrollo, debemos esperar que esta brecha de género se amplíe.

Esta tendencia continúa en el área de la personalidad, también. Contrariamente a lo que los detractores le harían creer, las mujeres tienen, en promedio, un nivel más alto en neuroticismo y ser agradables, y menor tolerancia al estrés.

Algunos intencionalmente niegan la ciencia porque temen que se utilice para justificar el mantenimiento de las mujeres de STEM. Pero el sexismo no es el resultado de conocer hechos. Es el resultado de lo que la gente elige hacer con ellos. Esto es exactamente lo que la muchedumbre de indignación debe movilizarse para, en lugar de negar la realidad biológica y estar contento de pasar un fin de semana doxxing un hombre para que él perdería su trabajo. En este punto, como se anunció en el manifiesto de Damore, deberíamos estar más preocupados por la diversidad de puntos de vista que la diversidad que gira alrededor del género.

Ampliar en: The Globe and Mail

Walmart escaneará la cara de los clientes para detectar insatisfacción

La cadena estadounidense de comercios Walmart podría usar la inteligencia artificial para identificar si sus clientes no están satisfechos en sus compras, usando las cámaras de seguridad existentes.

En un patente muestra como se puede detectar el sentimiento después de escanear la cara de un cliente, aunque no indica ninguna solución para el problema que esto puede generar: el cliente puede estar insatisfecho por otras causas agenas a Walmart.

El objetivo es reaccionar de forma rápida, para identificar si hay algún problema, por lo que seguramente las alarmas internas se activarán si hay muchos “positivos” en poco tiempo, ya que pueden ser síntoma de un problema mayor.

Wal-Mart Stores, Inc. es una multinacional estadounidense de venta al por menor que opera como una cadena de hipermercados, grandes almacenes, tiendas de descuento y tiendas de abarrotes. Con sede en Bentonville, Arkansas (EE.UU.), la compañía fue fundada por Sam Walton en 1962. Al 31 de enero de 2017, Walmart tenía 11695 tiendas y clubes en 28 países, con un total de 63 marcas. [ La compañía opera bajo el nombre de Walmart en Estados Unidos y Canadá. Opera como Walmart de México y Centroamérica en México y América Central, como Asda en el Reino Unido, como el Grupo Seiyu en Japón y como Best Price en India.

Heinz Nixdorf

Heinz Nixdorf nació en la ciudad westfaliana de Paderborn , Alemania, siendo el hijo mayor de cinco hermanos, de Walter Nixdorf, vendedor ambulante y más tarde empleado de los ferrocarriles alemanes, y su esposa Anne. Fue a una escuela de la junta católica donde mostró por primera vez su talento para las matemáticas y la ciencia. La infancia y la juventud de Heinz Nixdorf fueron gastadas en circunstancias empobrecidas. Debido al desempleo de su padre en los años veinte y treinta durante la depresión mundial, su infancia fue moldeada por la pobreza. Sin embargo, Nixdorf consiguió una beca en un establecimiento de formación de maestros en Vallendar / Rhein cuando terminó su educación primaria. Pero la profesión de profesor no le convenía, ya que se sentía demasiado limitado en sus intereses y habilidades. No podía convencer ni a su madre ni a sus maestros. Así, escribió una carta al Ministerio de Educación de Berlín. En 1941 le permitieron visitar el Reismann-Gymnasium en Paderborn. En 1942, Nixdorf fue reclutado por la Wehrmacht y sirvió en el Frente Oriental. Desde que su padre murió en 1944, el joven Nixdorf, como hijo mayor, tuvo que asumir la responsabilidad de su familia después del final de la guerra en 1945 al asumir el trabajo estacional en una granja. En 1947 finalmente pudo terminar su educación después de hacer su Abitur (examen de ingreso a la universidad) en el Reisman Gymnasium de Paderborn.

Heinz Nixdorf nació en la ciudad westfaliana de Paderborn , Alemania, siendo el hijo mayor de cinco hermanos, de Walter Nixdorf, vendedor ambulante y más tarde empleado de los ferrocarriles alemanes, y su esposa Anne. Fue a una escuela de la junta católica donde mostró por primera vez su talento para las matemáticas y la ciencia. La infancia y la juventud de Heinz Nixdorf fueron gastadas en circunstancias empobrecidas. Debido al desempleo de su padre en los años veinte y treinta durante la depresión mundial, su infancia fue moldeada por la pobreza. Sin embargo, Nixdorf consiguió una beca en un establecimiento de formación de maestros en Vallendar / Rhein cuando terminó su educación primaria. Pero la profesión de profesor no le convenía, ya que se sentía demasiado limitado en sus intereses y habilidades. No podía convencer ni a su madre ni a sus maestros. Así, escribió una carta al Ministerio de Educación de Berlín. En 1941 le permitieron visitar el Reismann-Gymnasium en Paderborn. En 1942, Nixdorf fue reclutado por la Wehrmacht y sirvió en el Frente Oriental. Desde que su padre murió en 1944, el joven Nixdorf, como hijo mayor, tuvo que asumir la responsabilidad de su familia después del final de la guerra en 1945 al asumir el trabajo estacional en una granja. En 1947 finalmente pudo terminar su educación después de hacer su Abitur (examen de ingreso a la universidad) en el Reisman Gymnasium de Paderborn.

Con la ayuda de una beca Nixdorf pudo estudiar física en la Johann-Wolfgang-von-Goethe Universität en Fráncfort del Meno en 1947. Allí también tuvo seminarios en economía empresarial. En 1951 Nixdorf obtuvo un trabajo como estudiante aprendiz en el departamento de desarrollo de Remington Rand Corp. , donde aprendió los conocimientos básicos de las calculadoras de luz. Allí también se reunió con el físico y experto en procesamiento de datos Walter Sprick y se convirtió en su asistente. Cuando Sprick dejó la compañía para trabajar en IBM, le dio a Nixdorf sus inventos. Sprick fue referido por IBM como el padre de los lectores de texto automáticos y obtuvo dos patentes importantes. Con eso, Nixdorf desarrolló el Elektronensaldierer y el Elektronenmultiplizierer.

Nixdorf finalmente encontró un interés por sus máquinas en la central eléctrica Rheinisch-Westfalsche (RWE), en Essen, el mayor proveedor de energía en Alemania. La compañía concedió a Nixdorf una subvención de 30000 DM para el desarrollo de calculadoras basadas en tubos de vacío. Nixdorf también construyó las máquinas de calcuular que podrían ser conectadas a las máquinas de tarjetas perforadoras. En 1952, Nixdorf tomó la decisión de abandonar sus estudios y fundó el Labor für Impulstechnik en Essen. Contrató a su primer empleado Alfred Wierzioch y ambos estaban convencidos por la idea de la calculadora. En 1954 se publicó la primera computadora de tubo de vacío, llamada ES, y la LFI se amplió a diez técnicos.La joven empresa evolucionó muy rápido.

La compañía de Nixdorf se vio obligada a trasladarse a otra oficina, porque necesitaban más espacio. Inventaron muchos productos como el Wanderer Conti, la primera calculadora de escritorio del mundo con una impresora y el Nixdorf-Universal 820. La rápida expansión fue la razón por la que la empresa alquiló habitaciones en Paderborn, la ciudad natal de Nixdorf. Allí tenía más espacio para hacer su compañía más grande. En 1961 comenzó a construir su empresa con 60 empleados. En 1965 Nixdorf introdujo una calculadora de escritorio en Hannover Messe . Técnicamente fue una revolución. La empresa Nixdorf inventó el sistema Nixdorf 820 en 1967, que tuvo mucho éxito. El sistema 820 que se construyó sobre una base de componentes fue el primer ordenador pequeño que se basó en semiconductores. El mismo año, Nixdorf tuvo la idea de no sólo vender a través de distribuidores más, sino vender los productos por sí mismo. En 1968 Nixdorf compró el Wanderer-Werke y renombró la compañía en Nixdorf Computer AG.

Los productores como IBM eran de confianza en mainframes, pero Heinz Nixdorf reconoció que los mainframes eran demasiado caros para muchas preocupaciones, por lo que presentó su Nixdorf 820. Con eso trajo la computadora directamente a la oficina y la gente podía permitírselo. El tiempo más exitoso para la Nixdorf Computer AG se inició en la década de 1970, cuando Nixdorf Computer AG se convirtió en el líder del mercado de la informática de gama media en Alemania y fue la cuarta empresa informática en Europa con lugares en Alemania, Irlanda, Estados Unidos y Singapur. En 1972, estaba representada en 22 países. En 1975, la Heinz Nixdorf Company produjo una nueva generación de captura de datos: la línea 88xx.

El 17 de marzo de 1986, Nixdorf murió de un ataque al corazón en Hannover en la primera feria de informática de CeBIT. Nixdorf estaba muy interesado en la educación de sus empleados, por lo que puso mucho esfuerzo personal y dinero en ella. Debido a eso, 1969 él fundó una escuela de comercio en las premisas de la compañía. También quería que sus empleados hicieran deporte. Las lecciones deportivas eran obligatorias y para una mejor oportunidad de hacer deporte, estableció el Ahorn-Sportpark en 1984.

Ampliar en: SciHi Blog

Tim Berners-Lee recibe el Premio Turing 2016

Tim Berners-Lee (MIT) ha ganado el millón de dólares del Premio Turing 2016 que concede la ACM (Association for Computing Machinery). Como ya sabrás, trabajando en el CERN en 1989, implementó el primer servidor web vía HTTP (Hypertext Transfer Protocol), desarrolló en 1990 el lenguaje de hipertextos HTML (Hypertext Markup Language) y el primer navegador (llamado WorldWideWeb, luego renombrado Nexus), inventó en 1991 la WWW (World Wide Web), y escribió la primera página web de la historia (The Project). Más tarde fundó el consorcio W3C (World Wide Web Consortium) que desarrolla los estándares para la web actual (llamada web 2.0) y futura (que se llamará web 3.0, o web semántica).

Sir Timothy John Berners-Lee (n. 1955) ha recibido un merecido premio Turing (que cumple 50 años, ya que fue instaurado por la ACM en 1966). Todo el mundo compara este premio con el Premio Nobel, sobre todo desde que Google dotó el premio con un millón de dólares. Berners-Lee está considerado por muchos como el informático más influyente de la historia. Enhorabuena Tim.

El anuncio oficial está en esta web (se publicó el 04 de abril de 2017); nota de prensa oficial [PDF]. Como ha dicho Julián Estévez? @Jeibros, “no encuentro ni un solo medio español generalista que se haya [hecho] eco del Turing Award de Tim Berners Lee”. Una pena. Más información en Adam Conner-Simons, “Tim Berners-Lee wins $1 million Turing Award,” MIT News, 04 Apr 2017. También en Brian Owens, “Happy birthday, WWW,” News, Nature, 05 Aug 2011.

El primer servidor web nació en 06 de agosto de 1991 implementado en el ordenador de la fotografía (una estación de trabajo de la marca NEXT situada en un laboratorio del CERN). Berners-Lee y varios colegas llevaron a la práctica la idea desarrollada por él en una propuesta de 1989. El proyecto fue financiado en 1990 lo que le llevó a desarrollar el lenguaje HTML. No se conservan ni fotografías ni tomas de pantalla de la página original, aunque aún se puede acceder a su última versión de 1992 (The Project); el dominio original (info.cern.ch) aún existe con el mensaje “home of the first website”.

Ampliar en: NAUKAS

autobus las palmas aeropuerto cetona de frambuesa