Actualidad informática

Noticias y novedades sobre informática

Ordenador cuántico de Google

«Deberíamos tener listo un chip de 20 qubit muy pronto … en los próximos dos meses lo más probable», dice John Martinis de Google, mientras nos apoyamos contra una pared en un rincón relativamente tranquilo del centro de convenciones en Nueva Orleans. Martinis, un hombre alto con pelo plateado y una manera Alan Alda-es que, está muy ocupado y tengo suerte de haberlo atrapado. Anteriormente ese día, dio una de las discusiones más populares de la APS March Meeting 2017 sobre «la supremacía cuántica: comparar una computadora cuántica con un supercomputador clásico«. Martinis, cuyo equipo está basado en la UC Santa Bárbara, habló sobre cómo están trabajando Hacia el desarrollo de una «computadora cuántica científica y comercialmente útil» compuesta de 50 qubits – una matriz 7 por 7 de qubits superconductores (cada uno de los cuales está acoplado a su vecino más cercano) que se puede programar con una puerta de uno o dos qubit – que Tiene una tasa de error de alrededor del 0,1% y realmente hace cálculos cuánticos.

Aquí es donde el concepto de «supremacía cuántica» – será capaz de demostrar de manera concluyente la capacidad de realizar un cálculo que una computadora clásica no puede – entra en juego. Para comprobar la validez de tal cálculo, se requerirían los mejores supercomputadores de hoy, y de acuerdo con Martinis, lo más que podrían competir con una computadora cuántica de 50 qubit – más qubits y un supercomputador no serán suficientes. A pesar de eso, Martinis me dice que al entrar en «la era de un montón de qubit», utilizando la supremacía cuántica como una herramienta de evaluación comparativa para ver qué tan bien funciona su sistema es crucial. Para su actual simulador de 9 qubit, «la supremacía nos dio datos muy valiosos y tenemos algoritmos extremadamente precisos para ello», dice.

Aparte de eso, el equipo de Google también está trabajando duro para predecir y corregir los posibles problemas de hardware que puedan surgir a medida que aumentan el número de qubits, cada uno de los cuales debe ser «muy bueno y coherente». Esto incluye algunos requisitos específicos de ingeniería del sistema . Para diseñar mejores procesadores de computación cuántica, el equipo de Martinis contrató a la compañía canadiense Anyon Systems. Por suerte, el director general de la empresa, Alireza Najafi-Yazdi, también estuvo en la reunión de marzo e incluso dio una conferencia de prensa. Najafi-Yazdi, un ingeniero de formación, cofundó la puesta en marcha en 2014 para desarrollar sistemas de software y simulación que ayudan a diseñar y optimizar la electrónica cuántica y otros dispositivos a nanoescala en los que los efectos cuánticos entran en juego.

Anyon Systems se especializa en el desarrollo de herramientas computacionales y simulaciones «masivamente paralelas», utilizando supercomputadoras para ayudar a diseñar el hardware para futuras computadoras cuánticas. La compañía actualmente está colaborando con el equipo de Martinis para «usar el software de simulación de Anyon Systems para predecir la conversación cruzada entre los diferentes componentes de un procesador cuántico de 6 bits», explica Najafi-Yazdi, agregando que «una comparación entre las mediciones experimentales y los resultados numéricos muestran Excelentes acuerdos que demuestran la promesa de herramientas paralelas masivas en la ingeniería de nuevos procesadores cuánticos «. Añadió que algunas simulaciones ya habían revelado posibles problemas con el chip superconductor que podría ser abordado durante la simulación, en lugar de pasar meses construyendo el dispositivo sólo para encontrarlo No funciona como se esperaba.

Antes de que Martinis y yo nos separáramos después de nuestra charla rápida, mencionó que tanto se discute en estas sesiones que todo su equipo se reúne cada noche para discutir ideas, dice que el equipo está realmente trabajando para llegar a 20 qubits muy pronto. «Todo depende de cómo van nuestras soluciones finales. El objetivo de Google es que nuestro equipo de 50 qubit esté listo para finales de este año. Puede suceder, pero estoy más centrado en perfeccionar el chip de 20 qubit ahora. «En cualquier caso, Martinis confía en que su 50-qubit no está tan lejos y es sólo una cuestión de tiempo antes de que tengan un funcionamiento y relativamente libre de errores de la computadora cuántica en su mira … momentos emocionantes de hecho.

Ampliar en: IOP

Antiguo megaprocesador

Casi todo lo que es genial sobre la tecnología de hoy es gracias al microprocesador. Miles de millones de ellos se fabrican cada año y son una de las muchas razones por las que puede leer esta web. Pero pocas personas entienden lo que está pasando dentro de ese pequeño circuito integrado. Vamos con un curso acelerado.

La gente del Centro de Informática de Cambridge tiene una máquina de media tonelada que muestra todos los pequeños detalles que ocurren en un microprocesador a un tamaño que es más fácil de inspeccionar. La máquina ha sido apodada The Megaprocessor y su creador, James Newman, nos guía a través de cómo funciona en el vídeo de abajo.

La creación de Newman es lo suficientemente vistosa como para admirarla por sí sola. Usando unos 40000 transistores y 10000 LEDs, la máquina diagrama todas las comunicaciones y sistemas numéricos que se están llevando a cabo dentro de un microprocesador, todo ello y como vemos, con el fin de jugar en última instancia a una partida de Tetris.

Los 100 sitios web más importantes en internet

Teniendo en cuenta que le ranking de Alexa no es muy fiable, esta representación titulada 100 Websites that Rule the Internet –bellamente ilustrada– sirve para ver de un vistazo cuáles son los 100 sitios web más visitados de toda la red, la posición que ocupan en el ránking y la relación entre ellos (por ejemplo, todos los que son propiedad de Google, Facebook, etcétera) además del tipo de sitio del que se trata, clasificado por colores.

De estos 100 sitios tan solo hay uno español, que irónicamente es Google.es, en el puesto #40. Comparativamente otros sitios locales como Hola.com o ElPais.com están mucho más abajo, alrededor del puesto #400; incluso Amazon.es está mejor, en el #300, señal de su poderío.

Ampliar en: microsiervos

CWI y Google anuncian la primera colisión para el estándar de seguridad industrial SHA-1

Investigadores del instituto de investigación holandés CWI y Google anunciaron conjuntamente que han roto en la práctica el estándar de seguridad de Internet SHA-1. Este estándar industrial se utiliza para firmas digitales y verificación de integridad de archivos, que protegen transacciones de tarjetas de crédito, documentos electrónicos, repositorios de software de código abierto GIT y distribución de software. El cryptanalista de CWI Marc Stevens dice: «Muchas aplicaciones todavía utilizan SHA-1, aunque fue oficialmente desaprobado por NIST en 2011 después de debilidades expuestas desde 2005. Nuestro resultado demuestra que su abandono por una gran parte de la industria ha sido demasiado lento y que la migración a normas más seguras debería darse lo antes posible «.

El esfuerzo conjunto dirigido por Marc Stevens (CWI) y Elie Bursztein (Google) comenzó hace más de dos años para realizar la investigación avanzada de criptoanalítica de Stevens en la práctica con la infraestructura de computación de Google. Ahora lograron romper con éxito el estándar de la industria SHA-1 usando un llamado ataque de colisión. SHA-1, es un algoritmo criptográfico diseñado por la NSA y que fue estandarizado por NIST en 1995 para computar de forma segura las huellas dactilares de los mensajes. Estas huellas dactilares se utilizan en el cómputo de firmas digitales, que son fundamentales para la seguridad en internet, como la seguridad HTTPS (TLS, SSL), banca electrónica, firma de documentos y software. Las colisiones – diferentes mensajes con la misma huella digital – pueden conducir a falsificaciones de firmas digitales. Por ejemplo, una firma SHA-1 obtenida para un archivo también puede ser mal utilizada como una firma válida para cualquier otro archivo colisionado.

La colisión SHA-1 anunciada es la culminación de una línea de investigación iniciada en el CWI hace más de siete años para desarrollar un ataque práctico óptimo de colisión contra SHA-1. Esto dio lugar previamente al ataque teórico actualmente mejor conocido de Stevens en 2012 en el cual el resultado anunciado se ha construido más adelante. Elie Bursztein dice: «Encontrar la colisión en la práctica llevó un gran esfuerzo tanto en la construcción del ataque criptoanalítico y en su ejecución a gran escala.Requería más de 9.223.372.036.854.775.808 cálculos SHA1 que lgastaría 6500 años de cálculo de la CPU y 100 años de computación GPU. Es más de 100000 veces más rápido que un ataque de fuerza bruta.Usamos la misma infraestructura que potencian muchos proyectos de Google AI, incluyendo Alpha Go y Google Photo, así como Google Cloud «.

Stevens dice: «Las lecciones deberían haberse aprendido de las advertencias sobre ataques similares contra el predecesor MD5 de SHA-1, como la creación de una Autoridad de Certificación deshonesta en 2009 por un equipo internacional del que formé parte y un ataque de los estados nacionales en 2012 para elaborar actualizaciones maliciosas de Windows para infectar las máquinas de destino en el Oriente Medio para el espionaje, que demostré ser una variante de ataque criptográfico desconocido». En el otoño de 2015, Stevens, junto con dos coautores, advirtió que encontrar una colisión SHA-1 podría costar alrededor de $ 75K- $ 120K mediante la explotación de recursos de bajo costo GPU en Amazon EC2, que era significativamente más barato de lo esperado anteriormente.

Para ayudar a prevenir el uso indebido de dichos documentos PDF falsos, el equipo ofrece una herramienta gratuita en línea para buscar colisiones SHA-1 en documentos, que se basa en la técnica de contra-criptoanálisis de Stevens 2013 para detectar si se ha creado un solo archivo con un Ataque de colisión cryptanalítica. Se puede encontrar en: shatterered.io . La misma protección para los documentos PDF es ahora automática para los usuarios de Gmail y Google Drive. Para defenderse contra ataques de colisión SHA-1 los sistemas deben migrar a SHA-2 o SHA-3. En el caso de HTTPS, el esfuerzo para pasar de certificados SHA-1 a certificados SHA-2 comenzó en 2015. Y a partir de este año los navegadores marcarán los certificados basados ??en SHA-1 como inseguros. De forma similar, los sistemas de respaldo y los sistemas de firmas de documentos deben pasar a SHA-2.

Este resultado es fruto de una colaboración a largo plazo entre el Grupo de Criptología de Centrum Wiskunde & Informatica, el instituto nacional de investigación para las matemáticas y la informática en los Países Bajos, y el Grupo de Seguridad de Investigación, Privacidad y Anti-abuso de Google. Hace dos años Marc Stevens y Elie Bursztein, líder del equipo de investigación anti-abuso de Google, comenzaron a colaborar en hacer criptoanalíticas de Marc ataques contra SHA-1 práctica usando la infraestructura de Google. Desde entonces, muchos investigadores de CWI y Googlers han ayudado a hacer posible este proyecto, incluyendo a Pierre Karpman (CWI) que trabajó en el cryptanalísis y la implementación de prototipos de GPU, y de Google Ange Albertini que desarrolló el ataque PDF, Yarik Markov que se encargó de la GPU distribuida Código y Clement Blaisse que supervisaron la confiabilidad de los cálculos.

Más detalles sobre el ataque SHA1, cómo detectarla y el trabajo de investigación que detalla el ataque está disponible en https://shattered.io .

Encuentra el enlace directo de descarga de cualquier archivo

Es habitual que cuando llegamos a una web para descargar algo, simplemente pulsamos el botón “Descargar” y directamente comienza el proceso en nuestro navegador.

FileChef te lleva al enlace directo de descarga

En cualquier caso, a lo que queremos llegar es que cuando pulsas el botón “Descargar”, la página automáticamente solicita el archivo y lo pone en tu cola de descargas. En la mayoría de ocasiones no sabemos de dónde viene ni dónde está alojado (aunque si utilizas un gestor de descargar, sí).

FileChef es un buscador que nos lleva a los enlaces directos de descarga de cualquier archivo en Internet. En realidad FileChef no es un buscador en sí mismo, sino que utiliza Google para mostrarnos los resultados.

Ampliar en: omicrono

Así funcionaba la primera calculadora de la historia

La primera calculadora de la historia fue creada en Grecia

En 1900, se descubrió un artefacto cerca de la Isla de Anticitera, en Grecia. Este artefacto fue encontrado entre dinero, estatuas y vasijas, por lo que no se le dio importancia por algún tiempo. Varios años después, el arqueólogo Valerios Stais, notó que se trataba de una especie de conjunto de engranes y comenzó a estudiarlo.

No fue sino hasta 50 años después que se llevaron a cabo estudios metódicos del objeto, mediante Derek de Solla Price. A él y a su colega, un físico, les tomó 25 años descubrir los secretos que ocultaba.

Necesitaron de rayos X para estudiar el interior del mecanismo y lo que encontraron fue una computadora antigua.

Ampliar en: Conéctica

2016 fue el quinto año consecutivo de descenso de ventas de PC

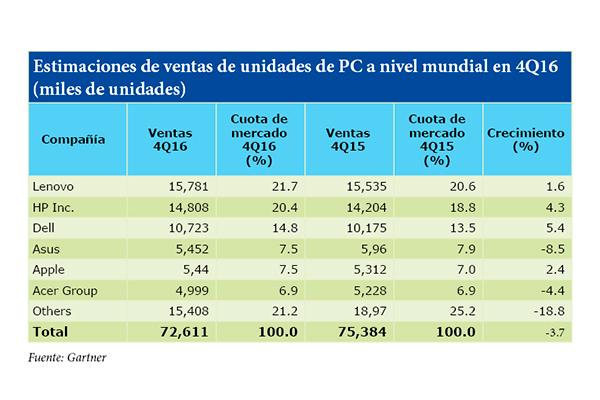

Los últimos datos aportados por Gartner, la consultora y empresa de investigación en el ámbito de las tecnologías de la información, señalan que las ventas mundiales de ordenadores totalizaron los72,6 millones de unidades en el útltimo trimestre de 2016. Una cifra que supone una disminución de 3,7% desde el cuarto trimestre de 2015. De hecho, según la consultora, a partir del año 2015, las ventas de PC han disminuido anualmente. «El estancamiento en el mercado de los ordenadores continuó en el cuarto trimestre de 2016, ya que las ventas durante el periodo de vacaciones de navidad han sido generalmente muy débiles, debido, sobre todo, al cambio fundamental en el comportamiento de compra de ordenadores», apuntó Mikako Kitagawa,analista principal de Gartner. Toda una serie de condicionando que ha provocado que este último año haya sido bautizado como el quinto año consecutivo en el que los ordenadores han perdido en número de ventas. Una tendencia que según los analistas de Gartner comenzó en el año 2012. Y aunque Kitagawa señaló que, por lo general, el mercado de PCs sufrirá un estancamiento, también existen oportunidades de crecimiento dentro del mercado, tales como el mercado de usuarios de PC, el mercado empresarial y los juegos. Sin embargo, estas áreas de crecimiento no evitarán la caída general del mercado de ordenadores, al menos en el próximo año. Con todo ello, cuatro de los seis principales proveedores experimentaron un aumento en los envíos de PC a nivel mundial en el cuarto trimestre de 2016, mientras que los tres principales proveedores aumentaron su cuota de mercado global en el cuarto trimestre.

Ampliar en: Electromarket

El nuevo ordenador de Intel tiene el tamaño de una tarjeta bancaria

Los dispositivos conectados a internet están por todas partes, no importa el tipo de producto ni la finalidad de su conexión, internet de las cosas (IoT) es el futuro y en el CES 2017 se han presentado multitud de productos inteligentes conectados.

Por ejemplo, se dispone de un televisor de un última generación, de lo más potente y avanzado en el mercado. Dentro de tres años probablemente no lo sea y, su hardware ya no será lo suficientemente potente como para soportar el nuevos software y las nuevas funciones.

Botones que no hacen nada (aunque creas que sí): los de los semáforos o los ascensores

Un gesto tan sencillo como pulsar un botón y que posteriormente ocurra algo provoca en nosotros una agradable sensación de bienestar. A nuestro cerebro no le gusta que las cosas ocurran por azar e inconscientemente necesitamos tener el control de cuanto pasa.

Un gesto tan sencillo como pulsar un botón y que posteriormente ocurra algo provoca en nosotros una agradable sensación de bienestar. A nuestro cerebro no le gusta que las cosas ocurran por azar e inconscientemente necesitamos tener el control de cuanto pasa.

Por tal motivo, el simple hecho de encontrarnos con un botón, apretarlo y que se abra una puerta, suba el ascensor o cambie el canal del televisor nos hace sentir bien.

Pero cada vez son más aquellos aparatos que en su día tenían algún botón con un objetivo específicoy que, actualmente, dicha función se controla de forma automatizada -por un ordenador central- y el hecho de pulsarlo no cambia absolutamente nada.

Es el caso de numerosos semáforos en los que se puede ver la típica cajita en el que indican al peatón que pulse para cambiar a verde o el botón que se encuentra en muchos ascensores y que en teoría sirve para que se cierren las puertas desde el interior.

Hoy en día muchos de estos botones no tienen función alguna, pero continúan estando ahí porque es beneficioso para nosotros, ya que el hecho de pulsarlos nos provoca un efecto placebo al saber que mantenemos el control sobre ellos.

Actualmente, la mayoría de los semáforos están controlados por un ordenador central que regula el tráfico y cada vez son menos aquellos en los que el pulsar el botón tenga incidencia alguna.

El hecho de que sigan manteniéndose en muchos lugares los semáforos con botón se debe a dos sencillas razones: por un lado el prevenir atropellos, debido a que al apretar estamos convencidos de que el disco cambiará en breve y, por tanto, nos esperaremos a que esto ocurra.

Y por otra parte –y como principal razón- el hecho de ahorrarse el enorme desembolso que representaría cambiar todos los postes de los semáforos. De ahí que se haga paulatinamente y cuando realmente toca reemplazarlos, siendo entonces cuando éstos ya no llevaran botón alguno.

Evidentemente hay que destacar que sí que hay semáforos en los que pulsar el botón incide sobre el tiempo en que tardará en ponerse verde pero cada vez son menos, están destinados a calles con menor tránsito y escaso paso de peatones o esta función se deja únicamente activa durante las horas nocturnas.

El otro botón puesto en cuestión es el de cerrar las puertas desde el interior de un ascensor. Durante largo tiempo sí que sirvió para ello, pero desde hace un par de décadas los ascensores están regulados para que las puertas no puedan cerrarse antes de tiempo y así evitar accidentes entre aquellas personas con movilidad reducida y que deben acceder a ellos.

Así se recogió en una ley aprobada en Estados Unidos en 1990 en la que se obligaba a tener un tiempo de espera antes del cierre automático de puertas para facilitar el acceso a las personas con algún tipo de discapacidad o ancianos. Fue a partir de ahí cuando paulatinamente fue anulándose la función del botón de cierre. Pero ¿si ha pasado un cuarto de siglo por qué siguen estando?: por puro placebo.

Un viaje en ascensor es uno de los momentos más incómodos para casi todas las personas. Accedemos a él y queremos que rápidamente nos lleve al piso al que debemos ir. Muchas son las personas a las que les incomoda viajar con individuos desconocidos y por tal motivo nada más entrar en el ascensor pulsan el botón de cierre.

Evidentemente, se cierra cuando el ordenador del aparato decide –que para eso está programado- pero a los usuarios nos queda la satisfactoria sensación de que hemos sido nosotros los que hemos logrado que las puertas se cierren más rápidamente.

Pero existe un tercer botón –aunque en la mayoría de ocasiones se trata de una ruedecilla- que también suele tener en algunos lugares una nula incidencia y que de nada sirve toquetearlo: el que regula la temperatura del aire acondicionado o calefacción de numerosísimas oficinas.

Y es que las oficinas son un lugar de continuo conflicto entre los trabajadores ya que cuando unos tienen calor otros se están pelando de frío, siendo incapaces de ponerse de acuerdo en cuál es la temperatura idónea en la que todos estarían a gusto –a pesar de que esté regulado por Real Decreto cuál es la temperatura que debe haber en estos lugares de trabajo-.

Estas disputas entre compañeros han llevado a que cada vez sean más las empresas que opten por esconder el control de temperatura e incluso aquellos que están a la vista estén desconectados, dando la sensación al trabajador que lo manipula de que hay los grados que éste ha puesto y sin ser consciente que en nada ha influido… todo por pudo placebo.

Según indica un artículo de The New York Times, el hecho de colocar termostatos placebos en algunas oficinas ha llegado a reducir hasta en un 75 por ciento las llamadas que se realizan al servicio técnico.

Obviamente, hay numerosos botones que sí sirven para algo cuando los pulsas y muchas las personas que pueden atestiguar que han regulado el termostato de su oficina o logrado que el disco del semáforo cambiase tras haber apretado el botón. Pero, placebo o no, el solo hecho de saber que incidimos en ello nos hace sentir mejor.

Fuente: Tecnoexplora

autobus las palmas aeropuerto cetona de frambuesa