Actualidad informática

Noticias y novedades sobre informática

2012: El año de Alan Turing

Ayudó a ganar la Segunda Guerra Mundial al descifrar el código alemán Enigma, pero fue perseguido por Gran Bretaña por ser gay. Hoy, su nombre es sinónimo de la prueba de que inventó en 1950 para determinar la capacidad de una máquina para tener un comportamiento inteligente. http://www.loebner.net/Prizef/TuringArticle.html

El 23 de junio 2012 será el centenario del nacimiento de Alan Turing, y una celebración del centenario se ha planificado con actividades en todo el mundo. Es quizás lo más apropiado que Royal Mail emitirá un sello conmemorativo, un homenaje póstumo a uno de los héroes de Inglaterra, que fue tan maltratado durante su vida. http://www.mathcomp.leeds.ac.uk/turing2012/give-page.php?13

El Año de Turing también presenta un marco interesante para nosotros, para medir el progreso de la informática. Cuando Turing inventó su prueba en 1950, algunos predijeron que la llamada «Inteligencia Artificial fuerte», es decir, la inteligencia artificial que iguala o supera la inteligencia humana, se podría lograr en unas pocas décadas. Más de sesenta años después, cada máquina que se ha encargado de simular la inteligencia humana no ha pasado la prueba llamada Turing.

Y, sin embargo, los científicos han llegado a impresionarse y alarmarse por los saltos hacia adelante de las capacidades de la Inteligencia Artificial en los últimos años. Se ha usado de forma habitual por las instituciones financieras, y se encontraron aplicaciones prometedoras en equipos médicos, la tecnología de búsqueda, juegos y sistemas de transporte. Por otro lado, los avances se han realizado en creaciones aparentemente Frankenstein tales como virus informáticos y depredadores.

Vigencia del Test de Turing

Alan Turing (1912-1954), famoso matemático inglés, fue uno de los creadores de la moderna computación junto con Von Newmann, y Shannon entre otros.

Alan Turing (1912-1954), famoso matemático inglés, fue uno de los creadores de la moderna computación junto con Von Newmann, y Shannon entre otros.

En la Segunda Guerra Mundial descubrió el código de Enigma, la máquina de criptografía de los nazis y formuló la máquina de Turing. En su artículo “La maquinaria de la computación y la inteligencia” planteó el llamado Test de Turing.

El final de Turing fue trágico siendo condenado por homosexualidad. Optó por la castración química frente a la cárcel. Dos años después se suicidó.

Hace más de medio siglo Alan Turing se planteó la pregunta ¿Pueden pensar las máquinas? Para no tener que resolver la ambigüedad de los conceptos máquina y pensar, diseñó una prueba que sustituyera a la citada pregunta creando con ello el célebre Test de Turing.

Predijo en los años 50, que a final del siglo XX los ordenadores podrán superar el juego de imitación. No ocurre antes no porque el hardware no sea potente sino porque hay que programar las máquinas y eso llevará 50 años. La predicción de Turing es completamente errónea. Ni las máquinas actuales ni las de un futuro próximo ni mucho menos las de su época pueden remotamente superar el Test de Turing en una tarea verbal como propone.

Creo que a finales del siglo el uso de las palabras y la opinión educada general se habrán modificado de tal manera que se podrá hablar de máquinas que piensan sin esperar que lo contradigan.

A menudo se da importancia al hecho de que las computadoras digitales son eléctricas y que el sistema nervioso también lo es. Puesto que la máquina de Babbage (anterior a Turing) no era eléctrica y puesto que todas las computadoras digitales son equivalentes en cierto sentido, observamos que el uso de la electricidad no puede tener importancia teórica.() Si realmente deseamos encontrar tales semejanzas, deberíamos buscar analogías matemáticas en el funcionamiento.

Las consecuencias de que las máquinas pensaran serían demasiado terribles. Esperemos y creamos que no pueden hacerlo.() Nos gusta creer que el hombre es, en cierto modo, superior al resto de la creación, pero sería mejor si pudiéramos demostrar que es necesariamente superior, puesto que así no habría peligro de que perdiera su posición dominante.

A fecha de hoy el Test de Turing está lejos de ser superado por ningún ordenador en un entorno de lenguaje natural sin restricciones.

Sin embargo, si usamos el test en tareas concretas, un ordenador lo superará en muchos casos. Cada vez más y más sorprendentes. De modo que sugiero reformular el Test de Turing de la siguientes manera:

Un ordenador supera el Test de Turing para una tarea X cuando un juez humano no pueda distinguir entre un concursante humano y un concursante ordenador ejecutando la tarea X

¿En qué tareas un ordenador supera el test?

- Cuanto más acotada sea la tarea, más posibilidades tiene un ordenador de superarla. En los entornos de ejecución abiertos, que por su naturaleza no han sido programados por completo, fracasará con mayor facilidad.

- Los ordenadores están construidos por humanos para que les descarguen de trabajo, realizando tareas humanas. Por ello superan el test en multitud de tareas. Por ejemplo todas las tareas de informática empresarial: contabilidad, control de almacén, nóminas, cálculos diversos…

- Matemáticas. El propio Turing advirtió que ya en su tiempo lo único adicional que debería requerir un programa matemático era ralentizar su respuesta e introducir algún error para confundir al juez humano.

- Ajedrez. En 1997 Deep Blue ganó a Garry Kasparov estableciendo un nuevo escenario en la relación hombre máquina. Hoy los programas comerciales modernos no solo ganan a cualquier maestro, sino que ajustan su nivel (juegan deliberadamente peor) al de su contrincante para no desanimarle.

- Música. Puedes bajarte una composición del programa Emmy al estilo Bach. Una audiencia especializada no distinguió si el compositor era Bach o Emmy.

- Poesía. Aunque los ordenadores están lejos de crear largos textos en prosa, pueden confundir en un poema corto:

Velada , velada , gozosa ,gozosa.

¡Señor! , cuán estrechamente el pretendiente expira.

Los vapores son sensatos cuando un masculino hechizo

canta sosegadamente .

El sonido es una marea gozosa que gime perdidamente

junto a los serenos veleros.

Una caricia en la noche , helada , es una encantadora y helada poesía. Velada , velada , gozosa ,gozosa .

¡Oh! , cuán calmadamente un ganador vive. - Reconocimiento de caras. Poco a poco se van adentrando en este terreno. Policías del mundo están usando estos programas que empiezan a estar disponibles en smartphones y ordenadores domésticos.

- Síntesis de voz. Disponible desde hace tiempo,se va refinando. Aun distinguimos con claridad una voz humana de una sintética.

- Reconocimiento de voz. Asignatura pendiente donde el camino por recorrer es aún grande. Su importancia comercial es enorme y en los últimos meses el avance es espectacular.

- Lenguaje natural. Watson, Es el enfoque más ambicioso de los últimos tiempos. Watson supera el test en la tarea “jugar en el concurso televisivo Jeopardy” No es un entorno abierto, pero el avance en “entendimiento” de lenguaje natural es asombroso.

Artículo completo en: ALT1040

Bajo licencia Creative Commons

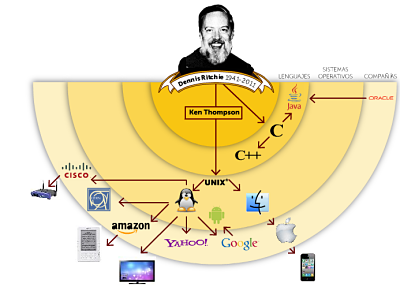

¿Qué podemos aprender de Dennis Ritchie?

Como se ha difundido por diversos medios de comunicación, uno de los padres fundadores de UNIX y el creador del lenguaje C, Dennis Ritchie, falleció el ocho de octubre. Aunque creo que muchos en la informática y otros campos relacionados sabía de la importancia de Ritchie para el crecimiento y desarrollo de todo lo relacionado con la informática, creo que es valioso mirar hacia atrás en sus logros y ubicarlo en lo alto en el panteón de las ciencias de la computación, ya poblado por Lovelace, Turing, y (aunque este canto será controvertido, al menos hasta que la historia tenga algo que decir) el recién fallecido Steve Jobs.

UNIX fue uno de los primeros sistemas operativos multiusuario, permitiendo a los científicos e investigadores compartir tiempo de computadora en lo que se ha basado tradicionalmente en el proceso por lotes en las máquinas. El concepto de múltiples usuarios y múltiples tareas fueron de gran interés para los investigadores, simplemente por el tiempo necesario para escribir, ejecutar y recibir los resultados de los programas por lotes. El tiempo en la computadora, en modo batch, era caro, como esta anécdota ilustra:

Aunque reflexionando sobre los problemas de los sistemas operativos en 1969, Ken Thompson [el cocreador de Unix] en su tiempo libre desarrolló un juego de computadora llamado «Viaje Espacial». El juego simula el movimiento de los planetas del sistema solar. Un jugador podía viajar entre los planetas, disfrutar del paisaje, e incluso aterrizar la nave en los planetas y las lunas.

El juego, primeramente escrito en Multics y luego transcrito a Fortran para el sistema operativo GECOS, corrió en un equipo GE 635. La pantalla del juego fue desigual y difícil de controlar debido a que el jugador tenía que teclear comandos para controlar la nave. Además, costaba alrededor de 75 $ en tiempo de CPU en el gran GE 635, un costo elevado.

A los 75 dólares el juego, sobre todo en dólares de 1960, era difícil para un hacker tener diversión.Dennis Ritchie y Thompson trabajaron juntos para construir UNIX como el paraíso de un hacker, un lugar para poner a prueba los programas y compartir los resultados. Él era físico y matemático de formación, pero entró en el mundo emergente del mainframe y la microinformática en el momento justo. Los años 1960 y 1970 fueron una época de grandes cambios en la manera de interactuar con la informática. Considerando que el punto de vista común es que «Estas computadoras malditas va a estropear mi cuenta de teléfono», en realidad las computadoras fueron arruinando el status quo. En unos pocos años, los registros en papel se erosionaron lentamente por el cómputo, centrales telefónicas fueron cambiando de naturaleza, hacia un sistema cuasimecánico de routers y terminales. Los laboratorios Bell estaban a la vanguardia de todo esto, la tarea de conectar el mundo a través del cable de cobre. Lo más importante es lo que estaba haciendo era difícil, algo que se ha olvidado en los días de arrastrar y soltar.

La clave para UNIX fue el concepto de compartir. El sistema operativo se inició en 1969 como una reacción de los Laboratorios Bell de cerrar Thompson y el sistema operativo favorito de Ritchie, Multics. Con la colaboración de varias organizaciones incluyendo el MIT, un grupo de cuatro, programadores de New Jersey Bell Labs comenzaron a trabajar en un equipo olvidado de la máquina PDP-7 en el que se portó el juego de los viajes espaciales y comenzaron a construir un sistema de archivos para guardar los juegos. Poco a poco, crearon una estructura de comandos que cualquiera que esté familiarizado con Linux modernos se entiende por acreción en torno a este sistema de archivos. Poco a poco la palabra UNIX corría fuera de la pequeña camarilla de los usuarios originales y en 1971 los Bell Labs comenzaron a utilizalor para dar formato a los documentos con nroff .

También es importante tener en cuenta que Linus Torvalds nació en 1969, haciendo de él un candidato ideal para aprovechar los beneficios de lo que podríamos denominar la era UNIX. La mayoría de edad en el tumulto de una nueva industria es importante y Gates, Torvalds, y Ritchie todos fueron excelentes ejemplos de esto.

Ritchie llegó a crear una serie de otras mejoras y, en el desarrollo del sistema operativo C, le dio al mundo su primer multimáquina, con el estándar de codificación que cualquier persona, desde un veterano canoso de lenguaje máquina a un joven estudiante en Helsinki , podrían usar y comprender. El código fuente de UNIX pasó de programador a programador, como la «Sagrada Escritura», incluso después AT & T se negó a ponerlo a disposición de las instituciones de educación. Fue escrito en C con algunos de sus componentes básicos escritos en lenguaje máquina para ganar tiempo en los ciclos, y lo más importante, para mantener una elegancia que Ritchie y Thompson han inculcado a través de la polinización cruzada de ideas. Ningún hombre, ni siquiera Ritchie, entiende la complejidad de la bestia que se convirtió en UNIX y que fue por el diseño. El objetivo era la simplicidad de frente y complejidad en el interior, un modelo que todo el mundo de la informática harían bien en emular.

También fue importante el deseo de alcanzar un ideal de oro en la claridad y la elegancia. «La presión de grupo y el simple orgullo de la mano de obra ha causado que montones de código sea reformado o desechado frente a ideas surgidas mejores o más básicas», escribió Doug McIlroy, un miembro del equipo de UNIX. «Rivalidad profesional y la protección eran prácticamente desconocidas: tantas cosas buenas estaban ocurriendo que nadie debía tener la propiedad sobre las innovaciones».

La pregunta es, entonces, ¿qué podemos aprender acerca de la construcción de nuestros propios productos de este gigante de la informática? En primer lugar, Ritchie y Thompson querían divertirse. No hubo impulso inicial de hacer dinero y, de hecho, su objetivo era ahorrar dinero o al menos ocultar su juego para que pase a un equipo menos costoso.

El segundo es la necesidad de trabajar fuera de su zona de confort. Ritchie fue un físico y un matemático. Sin embargo, se convirtió en un programador. Si bien es claro que sus antecedentes le ayudóaron enormemente en la creación de UNIX y C, como Bjarne Stroustrup señaló , Ritchie no tuvo miedo de intentar trabajar en un territorio nuevo y desconocido. «Si Dennis había decidido pasar de esa década en las matemáticas esotéricas, Unix habría muerto», escribe.

Tercero, la importancia de un enfoque de no intervención a la innovación. Ritchie tuvo la suerte de que los Laboratorios Bell tenían el dinero y el personal que le permitía esconderse en las sombras con sus amigos, creando lo que querían en su propia línea de tiempo. Google parece haber capturado el mismo sentido de la experimentación interna, obviamente, con sus proyectos del 20%, así como sus productos de los laboratorios que poco a poco se transforman en herramientas convencionales. Que los fundadores de Google permitan a estos proyectos un 20%, casi inmediatamente después de la creación de la empresa es un testimonio de Thompson y la metodología de Ritchie. Las personas tienden a construir herramientas cuando el capataz está observando y obras de arte cuando se le deja a su suerte.

Por último, tenemos la importancia de compartir. Me divierte sin fin ver una pequeña start-up encubrir sus productos detrás de acuerdos de confidencialidad y el secreto o intentar confundir los empresarios contentos. Cuando esto sucede, está claro que su idea no es nueva ni será un éxito particular, ni su actitud es particularmente propicia para el crecimiento. Yo diría que muchos empresarios actuales, tiene un producto de éxito pero no tienen éxito porque hablan mucho y no saben jugar.

Podría decirse que el proyecto de software más importantes en el mundo de hoy, Linux, es importante porque gloriosamente está disponible y abierto. Hay quienes dirá que no es sinónimo de rentabilidad, pero esas personas son en el mejor de los casos pesimistas y en el peor necios.

Al final, Dennis Ritchie nos enseñó que la informática no era una sociedad secreta, que requiere largos años de servicio y encantamientos especiales para unirse. Su generosidad intelectual es importante sobre todo lo que hacemos en línea actualmente.

No deja ser curioso que habiendo fallecido unos días después de Steve Jobs, la crónica, con retraso, quede resumida en: Dennis Ritchie de 70 años, jubilado desde 2007, su último puesto de trabajo fue el de ingeniero jefe del departamento de Investigación en software de sistemas de Alcatel-Lucent, falleció el pasado fin de semana, víctima de una larga enfermedad. Fue premio Turing en 1983 por la teoría de sistemas operativos genéricos y recibió la Medalla Nacional de Tecnología de EEUU en 1998.

Fuente: TC

¿Quién era Dennis Ritchie?

Gracias a Dennis Ritchie funcionan dispositivos electrónicos como los iPhones (Apple), nuestras conexiones ADSL o instituciones como el CERN. El pasado fin de semana falleció a los 70 años de edad uno de los más influyentes ingenieros informáticos, capaz de sentar las bases de la informática moderna.

Ada Lovelace y los luditas

Los luditas originales eran parte de un movimiento obrero en Inglaterra en el siglo 19. Estos luditas estaban en contra de las máquinas mecánicas incluyendo telares que cambiaron la producción textil de las manos de expertas de los tejedores a una fuerza de trabajo poco cualificado que atiende a las máquinas. En el clima económico actual, no es demasiado difícil ver por lo que los luditas estaban preocupados: incluso si las tecnologías de la Revolución Industrial no se tradujeran en una disminución global de puestos de trabajo (ya que había necesidad de trabajadores para atender las máquinas), no habría ni hay razón para suponer que los propietarios de fábricas textiles estarían interesados en la reconversión de las expertos tejedores que ya existen por la ofertas de las máquinas Y la estabilidad neta (incluso aumento) del número de puestos de trabajo puede ser un consuelo cuando su trabajo se pierde.

Por lo tanto, los luditas rompieron los telares, cometieron otros actos de sabotaje industrial, fueron acosados por las tropas del gobierno, se vio a algunos de ellos ejecutados por romper las máquinas (y otros exiliados a Australia) después de la aprobación de la ley, se asesinó al dueño de un molino , y luego casi se desvaneció como un movimiento.

Antes de la aprobación de la ley Frame Breaking Act, un miembro de la Cámara de los Lores argumentó vehementemente en contra de imponer la pena capital en el marco de infracciones, dando a los lores un discurso teatral, cargado de referencias sarcásticas a los» beneficios» de la automatización, que él vio como una forma de producir material de calidad inferior, así como dejar a la gente sin trabajo. «Ese miembro del Parlamento fue George Gordon, Lord Byron , quien, como es el caso, era también el padre de Ada Lovelace .

Ada Lovelace es a menudo considerada como la primera programadora de computadoras del mundo. El equipo en cuestión fue la máquina analítica de Charles Babbage – una máquina que Babbage propuso, pero nunca fue realmente construida. Por lo tanto la realización de Lovelace requiere un poco de explicación :

Durante un período de nueve meses en 1842-43, Lovelace tradujo las memorias del matemático italiano Luigi Menabrea es [en francés] a las nuevas propuestas de la máquina de Babbage, la Máquina Analítica . Con el artículo, se adjunta una serie de notas. Las notas son más largas que el propio libro de memorias e incluyen (Sección G) con todo detalle un método para calcular los números de Bernoulli, reconocido por los historiadores como el programa de la primera computadora del mundo. Los biógrafos se debaten en la medida sobre que sus aportaciones fueran originales, pues algunos de que los programas fueron escritos por el propio Babbage.Babbage escribió lo siguiente sobre el tema, en sus pasajes de la vida de un filósofo(1846):

Entonces le sugerí que añadiera las notas de las memorias de Menabrea, una idea que fue aprobada de inmediato. Discutimos juntos las ilustraciones diferentes que podrían ser introducidas: sugerí varias, pero la selección fue totalmente suya. Así también fue el trabajo algebraico de los diferentes problemas, a excepción, de un hecho, relativo a los números de Bernoulli, que me había ofrecido a hacer para salvar a Lady Lovelace del error. Esta me lo envió de nuevo a mí para una enmienda, después de haber detectado un error grave que había hecho en el proceso.

El nivel de impacto de Lovelace en los motores de Babbage es objeto de debate. El debate es difícil de resolver debido a la tendencia de Charles Babbage en no reconocer (ya sea verbalmente o por escrito) la influencia de otras personas en su trabajo. Lovelace fue sin duda una de las pocas personas que entendió completamente las ideas de Babbage y creó un programa para la máquina analítica. No tenía la máquina analítica, en realidad nunca se ha construido, su programa hubiera sido capaz de calcular una secuencia de números de Bernoulli. En base a este trabajo, Lovelace es ampliamente acreditado con ser el primer programador de computadoras.La prosa de Lovelace también reconoció algunas de las posibilidades de la máquina de Babbage, que nunca se publicaron, como la especulación de que «el motor podría componer piezas científicas, y música de cualquier grado de complejidad o extensión».

Para aquellos que tienden a dar crédito a Babbage, en lugar de a Lovelace, con el programa de ordenador en la sección G, Lovelace sigue siendo indiscutiblemente el primer depurador de programas del mundo.

Si el motor analítico se hubiera construido, el plan consistía en emitir su opinión sobre las tarjetas perforadas de la misma clase que las se utilizan para ejecutar los telares mecánicos. A pesar de que Lovelace nunca conoció a su padre, es curioso tratar de conciliar el padre que defendió a los luditas con la hija, que establece una base importante de nuestra era de la informática. Sin duda, los ordenadores han dado paso a los cambios socioeconómicos que eclipsan los traídos por la mecanización de los molinos.

Sin embargo, lo hizo Lovelace era bastante interesante. Por un lado, los procedimientos que desarrolló para el uso de una máquina de computación (que había sido diseñada, pero no construida) para llevar a cabo cálculos complejos fueron una demostración concreta de lo bonito que era posible. Sus programas de trazado como la máquina de Babbage propuesta podría ser objeto de un uso práctico. En otras palabras, el trabajo de Lovelace demostró que un equipo mecánico, que no era sólo una cosa fría en sí, sino una tecnología que podría hacer «clic» en el trabajo y en el mundo de un cierto tipo de trabajador intelectual. Mientras tanto, hasta que un equipo mecánico de Babbage propuso una realidad material, la gente realmente tenía que hacer sus cálculos a mano.

Y mientras Lovelace y Babbage son la madrina y el padrino intelectual de un salto tecnológico importante, hay una manera en la que el cambio de su trabajo puesto en marcha se siente diferente a la industrialización de la producción textil que los luditas originales denunciaban. Las máquinas de tejer, pueden dar lugar a que los expertos tejedores humanos quedaran obsoletos. Las computadoras mecánicas, por otro lado, no era tan evidente que hiciera obsoletos a la fuerza de trabajo existente de los equipos humanos. Mientras que la mecanización de complejos cálculos matemáticos elimina un cierto nivel de trabajo de intelectuales de humanos, que de otra manera se hacen con lápiz y papel, las energías intelectuales podrían ser dirigidas a otros problemas, relacionados (incluyendo la formulación de nuevas ideas que conduzcan a nuevos cálculos, o sacar conclusiones de los resultados de los cálculos). Por otra parte, la mecanización de los cálculos genera la demanda de un nuevo tipo de trabajo intelectual – la elaboración de las instrucciones para la máquina de computación para realizar los cálculos.

Autor: Janet D. Stemwedel es profesor asociado de filosofía en la Universidad Estatal de San José. Su exploración de la ética, la creación del conocimiento científico, y cómo se entrelazan son informados por su juventud perdida científica como físico-químico. Síguenos en Twitter @ docfreeride .

Muere Gordon Foster, figura pionera en el mundo de la informática y la computación

Gordon Foster murió recientement a los 89, fue profesor de estadística en el Trinity College de Dublín (Irlanda) y exdecano de la facultad de engineering and system sciences.

Antes de unirse al Trinity College ocupó la cátedra de métodos computacionales en la London School of Economics.

Entre sus muchos logros uno destacado fue crear el código de nueve dígitos International Standard Book Number o ISBN. Esto surgió de una decisión de la Asociación de Editores en 1966 para llevar a cabo una investigación sobre la viabilidad por parte de la industria del libro del Reino Unido de adoptar un sistema estándar de numeración de todos los libros publicados.

Un formato ISBN de 10 dígitos fue adoptada por la Organización Internacional de Normalización en 1970; desde 2007 el ISBN contiene 13 dígitos.

Nacido en Belfast en 1921, fue uno de los tres hijos de Robert Foster y su esposa Florencia Evelyn (de soltera Magee). Cursó estudios en la Royal Belfast Academical Institution, luego estudió matemáticas en la Queen’s University Belfast.

A partir de ahí fue reclutado por el MI6 como descifrador de códigos de Bletchley Park. Lo recordaba como un trabajo de rutina. Él y sus colegas rastreaban mensajes cifrados en busca de errores humanos y con el tiempo llegó a reconocer el estilo de encr?iptadores individuales.

Después de la guerra, continuó sus estudios en el Magdalen College de Oxford. Una conferencia de Norbert Wiener, considerado como el creador de la cibernética, fue muy influyente en su investigación. Después de completar su doctorado fue invitado para dar conferencias sobre sus investigaciones en la Universidad de Manchester. Allí conoció a Alan Turing, otro veterano de Bletchley Park y ampliamente conocido como el padre de la informática.

En 1952, Foster, se unió al personal de la London School of Economics, primero como profesor ayudante de estadística, a continuación, profesor y lector. En 1964, fue nombrado para la cátedra de métodos computacionales. Fue en la Bolsa de Londres que él ayudó a desarrollar la Investigación Operativa como disciplina académica.

Se convirtió en profesor de estadística en TCD en 1967. Tuvo éxito en la promoción de análisis estadístico y aplicaciones informáticas en muchas escuelas y departamentos. Y él construyó su propio departamento con un fuerte postgrado, así como el programa de pregrado. También puso en marcha la divulgación para la industria y la administración pública mediante la creación de las estadísticas y del laboratorio de Investigación Operativa.

Además, inició en 1977 un programa de desarrollo de sistemas, un programa de maestría para estudiantes de países en desarrollo. Dio lugar a una gran satisfacción y el disfrute del asesoramiento a sus estudiantes en el extranjero, y visitar proyectos de campo en las universidades colaboradoras.

Dirigió una serie de proyectos internacionales y ha trabajado en los estudios de evaluación de los efectos socioeconómicos de la informática. Actuó como consultor de la ONU para el desarrollo de la política sobre el papel de la informática en el desarrollo del Tercer Mundo.

En 1997, fundó Informatics and Social Development Research Institute (IDI). Dirigió el proyecto de IDI Trinet con el fin de facilitar las conexiones entre las zonas remotas en todo el mundo utilizando tecnología de bajo costo.

Después de haber investigado los satélites en órbita terrestre baja, los mensajes fueron enviados y descargados desde un satélite a la antena de radio, y en equipos a través de un controlador de nodo terminal – el equivalente de un módem. La estación de tierra también tenía una puerta de acceso a internet para que los mensajes recibidos de los satélites pudieran ser transferidos directamente a internet y viceversa.

Una de las conexiones más dramáticas fue en 1995, derivada del brote del virus Ebola en Zaire, cuando dos médicos en el hospital de Vanga lograron contactar con la estación de Foster en Dublín. Se estableció contacto con el Centro para el Control y la Prevención de Atlanta (EE.UU.), asegurando un intercambio de información vital en todo el brote.

autobus las palmas aeropuerto cetona de frambuesa