Actualidad informática

Noticias y novedades sobre informática

Un proyecto europeo aborda los retos de la informática a gran escala

Un proyecto paneuropeo ha comenzado este mes para reunir las tecnologías necesarias para la computación a gran escala, abordando el reto clave del uso de la energía.

El proyecto EuroEXA, de 20 millones de euros, ha comenzado este mes reuniendo tres proyectos a gran escala sobre aceleradores FPGA, interconexiones y tecnologías de chip 3D para alcanzar un rendimiento de 1018 operaciones, 10 veces superior al de los superordenadores más rápidos de la actualidad.

El factor limitante para la computación a gran escala es la eficiencia energética, dice el Dr. Dirk Koch de la Universidad de Manchester, que forma parte del proyecto Ecoscale. Señala al superordenador chino Sunway Taihulight como no muy lejos de la exascala, con 10000 núcleos que utilizan 28 MW de potencia para 125 petaflops de rendimiento. Si se considera la exascala, necesitamos 8 veces ese rendimiento, pero esto es más que todo el rendimiento de los 500 mejores superordenadores «, dijo. «Serían más de 85000 núcleos que necesitarían 224 MW de potencia. Son 40000 dólares por hora o 340 millones de dólares al año en EE. UU., y costaría más de 2000 millones de dólares «.

Así que la eficiencia energética es la clave última, y la integración es la clave para el rendimiento, cuanto más se puede hacer en un solo chip mejor «, dijo. Señala que el rendimiento de un FPGA es el doble del de una GPU en un problema específico para una décima parte de la potencia. «Es exactamente a donde queremos ir», dijo. «Eso usaría 40 MW a exascala. Esta es la belleza de los FPGA, que integran más funciones en un solo chip. La gestión de datos es clave. No se mueven los datos para computar, sino que se mueven la computación a los datos, lo que significa reconfigurar la FPGA donde están los datos «.

El mero uso de CPUS y GPU no hará el trabajo y tiene que hacerse con FPGA que necesitarán nuevos modelos de programación. En Manchester estamos trabajando en OpenCL como modelo de programación para módulos configurables que se pueden conectar a un sistema como acelerador HPC «.

Los otros dos proyectos se centran en la interconexión informática de alto rendimiento y el empaquetado de chips en 3D para lograr interconexiones locales más rápidas.

Ampliar en: eeNews

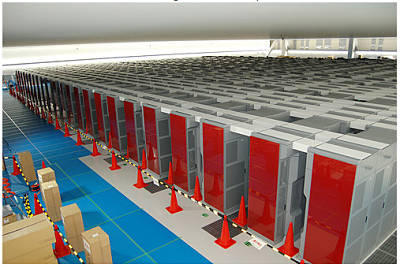

Instalación de un superordenador Cray XC40

En KAUST (King Abdullah University of Science and Technology) de Arabia Saudita compraron un superordenador Cray XC40, con las siguientes prestaciones: 793 terabytes de memoria y 17 petabytes de almacenamiento, 6192 nodos que se comunican hasta a 500 GB/s. Y en cuanto a consumo eléctrico es capaz de procesar 2,6 gigaFLOP por vatio, de modo que es unas 30 veces mejor que las versiones anteriores.

El supercomputador Watson de IBM crea recetas de cocina

IBM creó ChefWatson, un programa que corre en el supercomputador, después de haber ingerido todos los datos de Bon Appétit, un sitio de recetas de cocina. Watson no utiliza las recetas en el sitio, en lugar de eso, clasifica todos los ingredientes por tipo de comida, estilo, lugar de origen, etc. Todo con el fin de hacer lazos entre los ingredientes y decidir cuáles se llevan bien entre ellos.

Fuente: conéctica

Licencia CC 4.0

La simulación más exacta del universo

La masa, tamaño y edad de las galaxias creadas gracias al uso de la supercomputadora EAGLE son casi idénticas a las reales

Fuente: mdz online

Crecimiento de la velocidad de los superordenadores

Esta pequeña gráfica muestra cómo ha crecido con el paso de los años la velocidad máxima que cada año marcan los superordenadores más poderosos del mundo: Fastest supercomputers (Science News).

El de más potencia de cálculo hasta el momento sigue siendo el Tianhe-2 chino con sus 3,1 millones de núcleos, un petabyte de RAM y 33 petaFLOPS de capacidad de cálculo (sobre 54 petaFLOPS «teóricos»).

Raspberry Pi y unas piezas de Lego se pueden convertir en un superordenador

Los ingenieros de la Universidad de Southampton, en Reino Unido, han juntado 64 Raspberry Pi y han montado un “superordenador” low cost, con la que pueden realizar experimentos los estudiantes en este tipo de plataformas propias de los centros de procesamiento, pero con un precio asumible, nada más que 3000€ (sin contar cableado y switches).

La capacidad a simple vista puede ser poca, pero tenemos que tener en cuenta las especificaciones de cada Raspberry, que contaban con su procesador de 700MHz, 512 MB de RAM y 16GB de almacenamiento en sus respectivas tarjetas SD… que multiplicado por 64 nos arroja la cifra de 44.8GHz para procesar, 32GB de RAM y 1TBde memoria de estado sólido, que claro está estos datos son bastante irrelevantes ya que tenemos que tener en cuenta que cada una tiene su sistema corriendo y su porción de memoria ocupada (y por desgracia no han comunicado datos del rendimiento) pero probablemente se aproveche más de la mitad del potencial de todas ellas.

El sistema Iridis-Pi uso como entorno de desarrollo el “Python Tools for Virtual Studio“ y partió de el sistema con más soporte (oficial para este dispositivo) Debian Wheezy y han creado una guía para realizar el proyecto cualquiera de nosotros, pudiendo juntar dos nodos o mil, ya que tiene una ampliación muy sencilla y prácticamente automática una vez realizada la primera unión de nodos.

Ampliar en: GENBETA: dev

Bajo licencia Creative Commons

Fujitsu suministra un nuevo superordenador a la universidad de Tokio

El nuevo sistema, una supercomputadora Fujitsu PRIMEHPC FX10, se compone de cuatro bastidores, con un total de 384 nodos para un rendimiento teórico computacional de 90,8 teraflops (1). El sistema se utilizará principalmente para apoyar la investigación nacional realizada en colaboración con sólidos investigadores científicos estatales, además de ser empleado en la investigación y desarrollo de aplicaciones para el segundo campo del Programa estratégico del equipo de K computer (2), es decir, «New Materials and Energy Creation«. Los investigadores en este campo tienen el objetivo de promover el desarrollo de nuevos materiales y producir tecnologías clave que conducen a la creación de nuevas energías, mientras que la realización de I + D que ayude a crear una sociedad sostenible. El nuevo sistema se espera impulse grandes avances en el campo de la investigación en ciencias de estado sólido y contribuir al desarrollo de dispositivos de alto rendimiento y de alta eficiencia de células de combustible, y nuevos fármacos.

Antecedentes de la implementación del nuevo sistema

Desde su creación en 1957, el ISSP se ha desempeñado como institución central de Japón para la investigación en ciencias de estado sólido, teniendo como objetivo conocer las diferentes características de los materiales, a partir de su composición atómica con el comportamiento de los electrones. Además, como el instituto representante para el segundo campo del programa estratégico del equipo de K, «New Materials and Energy Creation«, ISSP ha llevado a la creación de la Computational Materials Science Initiative (CMSI), que se centra en el Instituto de Ciencia Molecular del Instituto Nacional de Ciencias Naturales, el Instituto de Investigación de Materiales de la Universidad de Tohoku, y otras 11 instituciones participantes. CMSI promueve activamente la investigación en el campo de la ciencia computacional de materiales (3).

Para facilitar el desarrollo de aplicaciones para su uso en el programa estratégico de la computadora K y otras áreas, el ISSP ha seleccionado Fujitsu PRIMEHPC supercomputadora FX10, que es altamente compatible con el ordenador K, con las últimas tecnologías ultra-paralelas de computación. Como resultado, los investigadores serán capaces de desarrollar y afinar los programas de una manera aún más práctico, contribuyendo así a facilitar los logros revolucionarios en una sólida investigación científica estado durante el entrenamiento la próxima generación de investigadores que lideran el campo de la ciencia computacional de materiales.

Visión general del nuevo sistema

La combinación de alto rendimiento, escalabilidad y fiabilidad con una eficiencia energética superior, PRIMEHPC FX10 mejora aún más la tecnología de Fujitsu que utiliza en el equipo K.

El nuevo sistema utiliza una supercomputadora FX10 PRIMEHPC, se compone de cuatro bastidores y 384 nodos, logrando en total un rendimiento teórico computacional de 90,8 teraflops. El sistema HPC middleware, empleará la suite informática técnica (4) para sistemas de escala peta, junto con 12 servidores PRIMERGY como nodos de acceso y servidores de administración. Los sistemas de almacenamiento ETERNUS, junto con una capacidad total de 126,9 terabytes, se desplegará para su almacenamiento. El sistema de archivos se construye con los de alta capacidad, FEFS de alto rendimiento y alta fiabilidad (5) sistema de archivos distribuido.

PRIMEHPC FX10 ha recibido elogios de ISSP por su alto rendimiento y fiabilidad, así como su mayor eficiencia energética que pueden mantenerse al día con las exigencias actuales de la energía y el rendimiento ultra-alto y uso de FEFS.

Perspectivas para el futuro

Con el nuevo sistema, el ISSP se esforzará para formar investigadores que puedan desarrollar aplicaciones para el equipo K, junto con la aceleración de las actividades de investigación llevadas a cabo en el equipo K. Esto, a su vez, se espera que conduzca a los espectaculares avances en la ciencia de estado sólido y contribuir al desarrollo de dispositivos de alto rendimiento y de alta eficiencia de las células de combustible, y nuevos fármacos.

Comentario de Osamu Sugino, Ph.D., Profesor Asociado, ISSP, la Universidad de Tokio

«Es de gran importancia que el nuevo sistema, que es altamente compatible con el ordenador K, se despliegue en ISSP para ayudar en la investigación y el desarrollo de aplicaciones. Se espera que el sistema sea de ayuda en la promoción de la investigación de no sólo los que participan en el programa estratégico, pero la mayor comunidad sólida ciencia estatal. Además, anticipamos que será de gran utilidad, desde una perspectiva a largo plazo, en nuestro desarrollo de software y las iniciativas educativas «.

(1) Teraflops: Un billón de operaciones de punto flotante por segundo.

(2) Equipo K: Una supercomputadora desarrollada por Fujitsu y RIKEN que logra mejores del mundo en el ranking rendimiento en la lista TOP500 anunciada en junio y noviembre de 2011.

(3) La ciencia computacional de materiales: Establecido como un nuevo enfoque para conectar la teoría con la experimentación, un campo de ciencias de los materiales que emplea simulaciones, estadísticas y otras herramientas computacionales.

(4) Technical Computing Suite: Fujitsu-producido HPC middleware, que incluye la gestión del sistema y las funciones de trabajo de gestión de operaciones, así como un compilador y biblioteca, resultando en un rendimiento de alta ejecución para aplicaciones masivamente paralelas.

(5) FEFS: FEFS proviene de Sistema de Archivo Exabyte Fujitsu. Un alto rendimiento de sistema de archivos distribuido que permite compartir a través de 100000 nodos.

IBM de nuevo número uno en la lista Top500

La organización Top500 publica su clasificación de superordenadores dos veces al año. En la lista publicada en Junio de 2012, IBM alcanzó de nuevo la primera posición.

La lista ha sido publicada en la Conferencia Internacional de Supercomputación que se celebra en Hamburgo (Alemania). Por primera vez desde noviembre de 2009, la lista está encabezada por un ordenador de un fabricante de Estados Unidos.

El ordenador Sequoia consigue una potencia de 16 petaflop/s y usa la friolera de millón y medio de núcleos (cores). La tecnología usada es BlueGene/Q. Sequoia es también la de mayor eficiencia energética de la lista.

Hace relativamente poco se alcanzó la cifra de 1 petaflop/s y ya estamos camino del exaflop/s. Tan solo tenemos que multiplicar la potencia por 50. La progresión de los superordenadores es fulgurante.

BlueGene/Q sigue la tecnología de las máquinas previas BlueGene, caracterizadas por baja frecuencia de reloj (solo 1,6 GHz) y bajo consumo. Esto hace que el gasto energético sea muy inferior al de sus competidores. Los superordenadores son máquinas muy complejas y el balanceo de todas sus partes es esencial. Es por ello que los núcleos no son muy rápidos y es el conjunto de las piezas el que proporciona el rendimiento global.

El número dos en la lista es el llamado K de Fujitsu con tecnología SPARC64. Con la mitad de cores alcanza 10 petaflop/s y su gasto energético es casi el doble. China posicionó su deslumbrante Tianhe (rio del cielo) en el tope de la lista en 2010, pero la lista cambia deprisa y ya ha bajado al quinto puesto.

IBM no solo ha logrado alcanzar el número 1. Ha sido capaz de colocar 5 en la lista de los 10 más potentes, gracias sobre todo a la tecnología BlueGene/Q que implementan el 1, 3, 7 y 8. El número 4, también de IBM incorpora la tecnología iDataPlex basada en procesadores X86.

El comprador, como casi siempre es el Departamento de Energía de Estados Unidos, DOE y la instalación es en el Lawrence Livermore National Laboratory.

______________

Este es el TOP10 de superordenadores más potentes del mundo en 2015:

- Tianhe-2: en China, con 3.12 millones de núcleos y un rendimiento máximo de 33.86 petaflops/s.

- Titan: en EEUU, 560.640 núcleos, 17.59 petaflops/s.

- Sequoia: en EEUU, 1.57 millones de núcleos, 17.17 petaflops/s.

- K Computer: en Japón, 705.024 núcleos, 10.51 petaflops/s.

- Mira: en EEUU, 786.432 núcleos, 8.58 petaflops/s.

- Piz Daint: en Suiza, 115.984 núcleos, 6.27 petaflops/s.

- Shaheen II: en Arabia Saudí, 196.608 núcleos, 5.53 petaflops/s.

- Stampede: en EEUU, 462.462 núcleos, 5.16 petaflops/s.

- JUQUEEN: en Alemania, 458.752 núcleos, 5.00 petaflops/s.

- Vulcan: en EEUU, 393.216 núcleos, 4.29 petaflops/s.

Fuente: ALT1040

Bajo licencia Creative Commons

Superordenador IBM para probar la relación materia-antimateria

Las rupturas son a menudo desordenada, y en la división de las partículas subatómicas, las partículas hijas no son una excepción. Ahora la capacidad de simular un famoso decaimiento de partícula podría ayudar a responder a una de las cuestiones más candentes en la física: por qué el universo parece contener más materia que antimateria.

De acuerdo a nuestra imagen actual, el Big Bang produjo partículas y antipartículas en cantidades iguales, la mayoría de las cuales se aniquilaron mutuamente para liberar energía. En algún momento, algún factor desconocido ha llevado a la existencia de más partículas que antipartículas.

Una pista de lo que esto podría ser surgió en 1964, cuando James Cronin y Val Fitch, en la Universidad de Chicago, observaron partículas subatómicas llamadas kaones, decaer en dos piones, otro tipo de partículas.

Creemos que la antimateria es como una copia exacta de la materia, pero a la inversa, con ciertas propiedades – por ejemplo, la antipartícula de una partícula cargada tiene la carga opuesta. Sin embargo, en la descomposición de Fitch y Cronin observaron que la antimateria deben diferir en algún otro modo fundamental. Ese es el tipo de asimetría necesaria para explicar el puzzle más grande de materia-antimateria, y en 1980, la pareja ganó el premio Nobel de Física.

La comprensión de las interacciones que participan en este decaimiento del kaón ha demostrado ser difícil, sin embargo. Un mecanismo teórico de la decadencia existe, pero nadie podía saber si sus predicciones estaban a la altura de las observaciones experimentales.

Ahora un equipo de investigadores del Reino Unido, EE.UU. y Alemania han utilizado el superordenador IBM BlueGene / P del Laboratorio Nacional Argonne en Illinois, además de otras supercomputadoras, para simular un kaon decaer en dos piones, por primera vez.

El equipo utilizauna técnica llamada celosía QCD para simular una región del espacio a través de cinco femtometros, en la que cientos de interacciones entre quarks y gluones que llevan la fuerza, se llevará a cabo. «El resultado es una especie de enjambre de todos los diferentes tipos de partículas, antipartículas y gluones», dice el miembro del equipo de Norman Christ de la Universidad de Columbia en Nueva York.

El equipo comenzó mediante la simulación de un kaon compuesto por un quark down y un antiquark extraño, y luego cambió a éste en un quark abajo. El modelo estándar de física de partículas, dice que este cambio se debe generar dos pares quark-antiquark necesarias para hacer dos piones. A continuación, el equipo hace la simulación de los piones, que permita calcular la probabilidad de que efectivamente se produjo por el Kaon. Después de 281 días de tiempo en la computadora, el resultado fue un valor para la probabilidad de que el kaon decaería en dos piones, que coincide con las mediciones experimentales (arxiv.org/abs/1111.1699).

«Este es un cálculo que no podíamos siquiera hemos tocado sin este superordenador», dice Christ. Sin embargo, el trabajo, que será publicado en Physical Review Letters, no explica del todo la asimetría materia-antimateria a apuntalar la decadencia kaon. Eso requerirá una simulación más complicada en una supercomputadora más potente. Si eso está de acuerdo con el experimento también puede significar que el modelo estándar, que abarca todas las partículas y fuerzas conocidas, pero es casi seguro que incompleto, es suficiente para explicar el enigma de materia-antimateria.

Aaron Roodman del SLAC National Accelerator Laboratory, en Palo Alto, California, quien no estuvo involucrado en el trabajo, dice que cualquier desajuste todavía puede revelar la necesidad de una nueva física. «Si no están de acuerdo, entonces puede ser que tengamos algo nuevo».

Fuente: NewScientist

autobus las palmas aeropuerto cetona de frambuesa