Actualidad informática

Noticias y novedades sobre informática

Primera fase del proyecto Sinapsis, inspirado en el cerebro humano

El objetivo del proyecto sinapsis es la creación de sistemas electrónicos, inspirados en el cerebro humano, que puedan comprender, adaptarse y responder a la información de manera radicalmente diferente a como lo hacen los ordenadores tradicionales. Mientras que las computadoras actuales están organizadas en diferentes procesadores y unidades de memoria que funcionan de acuerdo con una programación, el cerebro está organizado como una red interna y distribuida de procesadores muy simples (neuronas) y la memoria (sinapsis) que espontáneamente se comunican y aprenden de sus funciones. Utilizando el conocimiento de la organización del cerebro como una plataforma, Sinapsis está desarrollando circuitos integrados de alta densidad con dispositivos electrónicos y redes integradas de comunicación que se aproximan a la función y la conectividad de las neuronas y las sinapsis. Este programa también ha desarrollado herramientas de apoyo a esta área específica del desarrollo de hardware, tales como herramientas de diseño de circuitos, simulaciones por ordenador a gran escala de la función hardware y entornos virtuales de formación que puede probar y comparar estos sistemas.

La primera fase de Sinapsis ha desarrollado componentes a escala nanométrica capaces de adaptar la fuerza de la conexión entre dos neuronas electrónicas, similar a lo que ocurre en los sistemas biológicos, la utilidad de la simulación de estos componentes en microcircuitos base que soportan la arquitectura general del sistema. La siguiente fase especifica la arquitectura del sistema a gran escala, las conductas simuladas de núcleos dinámicos de grandes redes, y demostración de microcircuitos electrónicos de sinapsis y neuronas que se organizan espontáneamente en ambientes simples.

«Hasta ahora, Sinapsis ha tenido éxito con todo el hardware básico, la arquitectura, la simulación y evaluación de las capacidades necesarias para una nueva generación de máquinas electrónicas inteligentes», dijo Todd Hylton, director del programa DARPA SYNAPSE.

Los objetivos para la próxima fase incluyen el desarrollo de chips, proceso de fabricación, diseño y validación de sistemas de un solo chip, y la demostración de estos sistemas en entornos virtuales que hacen hincapié en las tareas de comportamiento relacionados con la navegación y la percepción. «Ahora que todos los bloques de construcción están disponibles», dijo Hylton, «nuestra próxima tarea es comenzar a construir sus sistemas de funcionamiento.

Nueva nanoestructura combina memoria con elementos lógicos

Se ha desvelado por parte de físicos alemanes, una nueva forma de crear circuitos lógicos completos y programables que combinen memoria y procesado lógico en una única estructura. Tales estructuras podrían llevar a circuitos integrados más rápidos, pequeños y más eficientes energéticamente y su desarrollo ha sido uno de los objetivos principales de la espintrónica – una tecnología relativamente nueva que explota el espín de un electrón así como su carga. Los investigadores creen que la estructura podría llevar a una nueva forma de diseñar circuitos lógicos en los cuales la memoria y los elementos lógicos no estén separados.

“Se han hecho demostraciones de dispositivos espintrónicos aislados desde hace tiempo, pero ahora hemos demostrado un circuito lógico programable – y eso es algo nuevo”, dice el líder del equipo Laurens Molenkamp de la Universidad de Würzburg. El nuevo circuito está hecho de un semiconductor ferromagnético que contiene una mezcla de galio, manganeso y arsénico ((Ga,Mn)As) que combina la capacidad de lectura/escritura con un proceso lógico.

Los dispositivos espintrónicos aprovechan el hecho de que el espín del electrón puede apuntar en la dirección “arriba” o “abajo”, y cambiar entre estos dos sentidos es una propiedad que podría usarse para almacenar y procesar información. Tales circuitos serían menores y más eficientes que los circuitos electrónicos basados en el silicio convencional – los cuales dependen de la carga – debido a que, en principio, cambiar espines de arriba a abajo puede hacerse usando muy poca energía. Los dispositivos espintrónicos podría transportar o manipular información a través de una “corriente de espín”, la cual consiste en electrones con espines opuestos que se mueven en sentidos opuestos.

Fuente: CienciaKanija

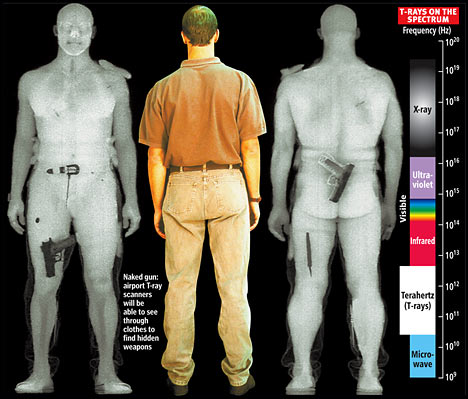

Nueva fuente de emisión eficiente a frecuencia de Terahercios

Investigadores han desarrollado un láser basado en fuentes de radiación de terahercios que es excepcionalmente eficiente y menos propenso a daños que los sistemas similares. La tecnología podría ser útil en aplicaciones como la detección de trazas de gases o imágenes de armas en controles de seguridad.

JILA es un instituto conjunto del Instituto Nacional de Estándares y Tecnología de EE.UU. (NIST) y la Universidad de Colorado en Boulder (EE.UU.).

La radiación de Terahercios – que se halla entre las bandas de radio y óptica del espectro electromagnético – penetra materiales como ropa y plástico, y se puede utilizar para detectar muchas sustancias que tienen características únicas de absorción en estas longitudes de onda. Los sistemas de Terahercios son difíciles de construir, ya que requieren una combinación de métodos electrónicos y ópticos.

La tecnología JILA, que se describe en Optics Letters, es un nuevo giro en una fuente de terahercios común, un semiconductor superficial con electrodos de metal y excitado por pulsos láser ultrarrápidos. Un campo eléctrico se aplica a través del semiconductor, mientras que pulsos en el infrarrojo cercano duran unos 70 femtosegundos, se producen 89 000 000 de veces por segundo lugar, desalojando electrones del semiconductor. Los electrones se aceleran en el campo eléctrico y emiten ondas de radiación de Terahercios.

Las innovaciones JILA eliminar dos problemas conocidos con estos dispositivos. Añadiendo una capa de aislante de óxido de silicio entre el semiconductor de arseniuro de galio y los electrodos de oro, se impide que los electrones queden atrapados en defectos de los cristales semiconductores produciendo picos en el campo eléctrico. Haciendo que el campo eléctrico oscile rápidamente mediante la aplicación de una señal de radiofrecuencia se garantiza que los electrones generados por la luz no puede reaccionar con la suficiente rapidez para cancelar el campo eléctrico.

El resultado es un campo eléctrico uniforme sobre un área grande, lo que permite el uso de un láser de gran tamaño de punto de haz y la mejora de la eficiencia del sistema. Significativamente, los usuarios pueden aumentar la potencia a terahercios aumentando la potencia óptica sin dañar el semiconductor. Daños en la muestra fue común con sistemas anteriores, incluso a baja potencia. Entre otras ventajas, la nueva técnica no requiere una muestra modelada al microscopio o electrónica de alto voltaje. El sistema produce un campo Terahercios pico (de 20 voltios por centímetro para una potencia de entrada de 160 milivatios) comparable a la de otros métodos.

Si bien hay un número de maneras diferentes para generar la radiación de terahercios, los sistemas que utilizan láseres ultrarrápidos y semiconductores son de importancia comercial, ya que ofrecen una combinación inusual de amplia gama de frecuencias, frecuencias altas, y la salida de alta intensidad.

NIST ha solicitado una patente provisional sobre la nueva tecnología. Actualmente, el sistema utiliza un láser basado en un gran cristal de zafiro dopado con titanio, pero podría ser más compacto con el uso de un semiconductor diferente y un láser de fibra más pequeños, dice el autor principal, Steven Cundiff, físico del NIST.

Fuente: ScienceDaily

_______________

Enlaces de interés:

– Apuntes Introducción a la Informática. GAP. UMU. Redes y comunicaciones

– Observa las ondas electromagnéticas de un horno microondas

– Apuntes Introduccion a la Informática. GAP. UMU. La Información

¿Qué diferencias tienen los procesadores de smartphones?

El mundo de los smartphones ha evolucionado muchísimo en los últimos años, cada vez hay más procesadores diferentes y aunque creamos que lo que los define son su frecuencia de reloj, las grandes diferencias las marcan detalles más concretos. Tras el salto te explicamos por encima los principales procesadores actuales para tu sabiduría personal y para que puedas sorprender a conocidos y extraños con tu frikismo tecnológico.

Hummingbird de Samsung

Apareció con el genial Galaxy S y usa una arquitectura ARM Cortex A8 de 45nm con el juego de instrucciones ARMv7. El cambio en el diseño de la lógica del A8 permitió mejorar la velocidad en 5-10% y aunque los actuales suelen ser de 1GHz los nuevos serán de 1,2GHz. Su principal ventaja es ARM NEON que permite gráficos y sonidos de mayor calidad y una GPU, la PowerVR SG540, que permite 90 millones de triángulos por segundo.

Snapdragon de Qualcomm

Fueron los primeros en alcanzar 1GHz. Utiliza un núcleo, llamado Scorpion, similar al ARM Cortex A8 y el juego de instrucciones ARMv7. La diferencia está es que los primeros en salir usaban 65nm mientras que los actuales usan lo más eficaces 45nm. Como GPU usan Adreno, pero mientras los primeros como el Nexus One usaban el Adreno 200 pero los actuales utilizan el mucho mejor Adreno 205. Al incluir el GPS y la antena, los telefonos con Snapdragon son mucho más fáciles de diseñar y construir.

OMAP 3 de Texas Instruments

Comenzaron su andadura con el Motorola Droid y utiliza un Cortex A8 sin apenas modificaciones. Los OMAP 3 cuentan con numerosas variantes. A pesar de usar también ARM NEON su principal problema es la no tan potente GPU Power SGX530. El futuro OMAP 4 utilizará la GPU PowerVR SGX540, el acelerador de imagen IVA 3 y un doble núcelo Cortex A9 de 1GHz.

Tegra 2 de NVIDIA

El más nuevo de todos los procesadores y que este año será el cerebro de numerosos móviles Android. Usa un doble núcleo de Cortex A9 a 1GHz en 40nm y el juego de instrucciones ARMv7. Su gran ventaja realmente la proporciona su increíblemente rápida GPU que además ofrece el menor consumo energético del mercado y soporte directo para HDMI.

Fuente: GIZMODO

_____________

Enlaces de interés:

– Actualidad informática: Electrónica

– Actualidad informática: Telefonía móvil celular

– Ley de Moore. Divulgación electrónica

– Breve historia de la electrotécnica. Divulgación electrónica

– Apuntes Introducción a la Informática. UMU. GAP. Redes y comunicaciones

Microprocesadores de 1000 núcleos

El núcleo es la parte del equipo, de la unidad central de procesamiento (CPU), que lee y ejecuta las instrucciones. Originalmente, los ordenadores se desarrollaron con un único procesador por núcleo único , pero, actualmente los procesadores con dos, cuatro o incluso dieciséis núcleos son comunes.

Sin embargo, el Dr. Wim Vanderbauwhede y sus colegas de la Universidad de Massachusetts Lowell (EE.UU.) han creado un procesador que de hecho contiene más de un millar de núcleos en un solo chip.

Para ello, los científicos utilizaron un chip llamado Field Programmable Gate Array (FPGA), que como todos los microchips contiene millones de transistores – los pequeños interruptores de encendido y apagado que están en la base de cualquier circuito electrónico.

FPGA se pueden configurar en circuitos específicos del usuario, en lugar de tener su función fijada en una fábrica, lo que permitió el Dr. Vanderbauwhede dividir los transistores dentro del chip en pequeños grupos y programar cada uno para realizar una tarea diferente.

Mediante la creación de más de 1000 mini-circuitos en el chip FPGA, los investigadores han convertido de hecho el chip en un procesador 1000 núcleos, con cada núcleo de trabajo dotado de sus propias instrucciones.

Luego, los investigadores utilizaron el chip para procesar un algoritmo que es fundamental para el formato de película MPEG – utilizado por ejemplo en los vídeos de YouTube – a una velocidad de cinco gigabytes por segundo: en torno a 20 veces más rápido que los actuales ordenadores de escritorio.

El Dr. Vanderbauwhede dijo: «los FPGAs no se utilizan en ordenadores estándares, ya que son bastante difíciles de programar, pero su poder de procesamiento es enorme, mientras que su consumo de energía es muy pequeño debido a que son mucho más rápidos – así que también son una opción más verde».

Aunque la mayoría de ordenadores vendidos hoy en día ya contienen más de un núcleo de procesamiento, lo que les permite llevar a cabo procesos diferentes al mismo tiempo, los tradicionales procesadores multinúcleo debe compartir el acceso a una fuente de memoria, lo que ralentiza el sistema.

Los científicos en esta investigación fueron capaces de hacer el procesador más rápido, dotando a cada núcleo de una cierta cantidad de memoria dedicada.

El Dr. Vanderbauwhede, que espera presentar su investigación en el Simposio Internacional sobre Computación Reconfigurable Aplicada, en marzo de 2011, agregó: «Esto es una prueba muy inicial de concepto de trabajo en el que estamos tratando de demostrar una manera conveniente de programar FPGAs, que por su potencial para proporcionar potencia de procesamiento muy rápida podría ser utilizado mucho más ampliamente en la computación y la electrónica del futuro».

«Si bien muchas de las tecnologías existentes en la actualidad hacen uso de FPGAs, incluyendo televisores de plasma y LCD y routers de redes informáticas, se limita su uso en computadoras de escritorio estándares.

«Sin embargo, ya estamos viendo algunos microchips que combinan las CPUs tradicionales con chips de FPGA que se anuncian por los desarrolladores, incluyendo Intel y ARM.

Creo que estos tipos de procesadores sólo se harán más comunes y ayudan a acelerar las computadoras aún más en los próximos años. »

Fuente: PHYSORG.COM

__________________

Enlaces de interés:

– ¡La informática en un garaje! 1971 – 1976

– Apuntes Informática Aplicada al Trabajo Social. Ordenadores en la actualidad

Fujitsu crea fuentes de alimentación sobre superficies planas

Fujitsu Laboratories ha anunciado el desarrollo de una tecnología que permite la fabricación de transistores de fuentes de alimentación en casi cualquier superficie plana, incluyendo vidrio, plástico o cobre.

Esta innovación ha sido posible, gracias a la distribución de alta tensión, mediante la formación de un transistor de gran potencia que ha sido diseñado a partir de óxido de zinc (ZnO) y a la protección de este, con una capa de polímero.

La nueva tecnología permitirá a los circuitos de alimentación de energía, ser fabricados en una amplia gama de superficies planas, lo cual conlleva el desarrollo de numerosas aplicaciones potenciales. La presentación de esta gran innovación, se realizó en Boston, en la pasada Reunión de Otoño de Materials Research Society del 2010.

La elección, como material del oxido de zinc, es debido a sus características de semiconductor que puede ser utilizado como un transistor de alimentación con pocas pérdidas, ya que es un material que tiene un potencial para la creación de circuitos en cualquier superficie plana. En la actualidad se trabaja en la implantación de óxido de zinc sobre sustratos de vidrio, en superficies de cristal líquido de televisores y monitores.

En definitiva, los laboratorios de Fujitsu han sido capaces de producir un transistor de 100V para uso de fuente de alimentación a base de indio-galio-zinc-oxido (IGZO) como material y protegerlo bajo un capa de polímero. Esta solución permite que sea fabricado directamente sobre substrato de cobre que se utiliza como material de packaging, facilitando una mayor disipación del calor y, en consecuencia, reduciéndose los costos.

Fuente: diarioTi.com

________________

Enlaces relacionados:

– Fuentes de alimentación, para PC. Homologadas y compatibilidad CE

– Actualidad informática: Hardware

– Apuntes Informática Aplicada a la Gestión Pública. UMU. Calidad en informática

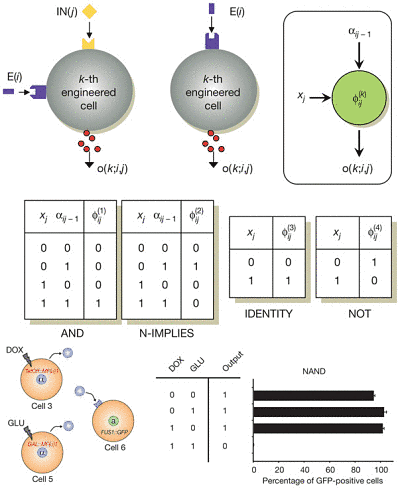

Circuitos lógicos combinacionales implementados gracias a consorcios de células que se comunican entre sí

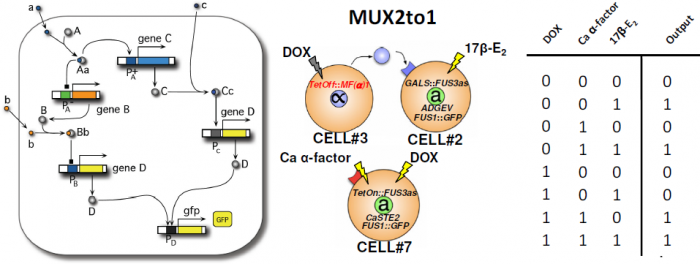

La biología sintética trata de diseñar sistemas biológicos complejos a base de combinar piezas (bioladrillos) que interactúan entre sí. El bioladrillo más obvio es una célula completa. Ricard Solé (Institut de Biologia Evolutiva, CSIC-UPF, Barcelona) y sus colegas han desarrollado un nuevo procedimiento para implementar circuitos lógicos combinacionales complejos utilizando puertas lógicas elementales implementadas mediante células de levadura modificadas por ingeniería genética. Células que actúan como puertas lógicas de tipo AND, NOT, o IMPLICA permiten construir otras puertas lógicas como NAND o NOR y circuitos lógicos de 2 o 3 entradas como un multiplexor MUX2-1 o un sumador de un bit con acarreo. El artículo técnico ha sido aceptado por Nature y promete iniciar una nueva era en la biología sintética, la era de la computación con circuitos combinacionales reprogramables y reusables gracias a “consorcios celulares.” El artículo técnico es Sergi Regot, Javier Macia, et al. “Distributed biological computation with multicellular engineered networks,” Nature, Published online 08 December 2010. Las aplicaciones futuras en biomedicina y bioingeniería son enormes, pero habrá que comprender mejor los problemas de escalabilidad, la robustez ante ruido, y los problemas de fan in y fan out de esta nueva técnica para implementar circuitos biológicos de lógica combinacional. Aún así, los resultados obtenidos hasta ahora son muy espectaculares.

La computación basada en consorcios celulares se basa en la idea de utilizar la comunicación intercelular en una población tanto entre células idénticas y células diferentes entre sí cuyo genoma ha sido modificado genéticamente aplicando técnicas de biología sintética. Cada célula responde a una o dos entradas posibles y puede producir una salida. Construyendo una pequeña librería de células que implementen ciertas puertas lógicas básicas (como las puertas AND o IMPLICA) se pueden construir circuitos más complejos que implementen una función booleana arbitraria. Cada célula responde a entradas externas y a moléculas mensajeras (que se producen en unas células, se difunden por el medio de cultivo y son recibidas por otras células). La mayoría de las funciones lógicas de 2 y 3 entradas se pueden construir con entre 2 y 5 células. Más aún, utilizando tres células se pueden implementar más de 100 funciones lógicas, y usando cuatro células mása de 200. Los investigadores han implementado in vivo puertas lógicas OR, NAND, XNOR, XOR y varios circuitos complejos, como un multiplexador MUX2to1 (que selecciona una entre dos entradas y dirige su valor a la salida) y un sumador de un bit con acarreo (que en serie permite construir un sumador de varios dígitos binarios).

Fuente: Francis (th)E mule Science’s News

________________________________

Enlaces de interés:

– Historia de la Informática. La era de la electrónica

– Actualidad informática: Electrónica

– Apuntes Informática Aplicada al Trabajo Social. UMU. Ordenadores en la actualidad

El éxito de la espintrónica podría conducir a un único «chip» para el procesamiento y la memoria

Investigadores de la Universidad Queen Mary de Londres (Reino Unido) y la Universidad de Friburgo (Suiza) han demostrado que una corriente polarizada magnéticamente puede ser manipulada por campos eléctricos.

Publicado esta semana en la revista Nature Materials, este importante descubrimiento abre la posibilidad de la combinación de memoria del ordenador y procesamiento en el mismo chip.

«Esto es especialmente emocionante, ya que este descubrimiento ha sido realizado con semiconductores orgánicos flexibles, que podrían dar lugar a la nueva generación de pantallas para dispositivos móviles, televisores y monitores de computadora, y podrían ofrecer un cambio radical en la eficiencia energética y reducir el peso de estos dispositivos, «dijo el Dr. Alan Drew, de la Escuela Queen Mary de Física, quien dirigió la investigación.

La «espintrónica» – giro de los electrones de transporte – se ha convertido rápidamente en la tecnología de uso universal para los discos duros de ordenador. Diseñadas en capas delgadas de materiales magnéticos y no magnéticos, las válvulas de espín Magnetorresistivo Gigante (GMR) utilizan las propiedades magnéticas, o ‘spin’, de los electrones para la detección de datos informáticos almacenados en bits magnéticos. Por el contrario, el tratamiento por ordenador se basa en flujos de electrones con carga eléctrica que fluyen alrededor de un circuito pequeño grabado en un microchip.

El Dr. Drew y su equipo han investigado cómo las capas de fluoruro de litio (LiF) – un material que tiene un campo eléctrico intrínseco – puede modificar el espín de los electrones transportados a través de estas válvulas de espín. Él explica: «Si bien en teoría, dispositivos que combinan la carga del electrón y el espín son conceptualmente sencillos, esta es la primera vez que alguien ha demostrado que es posible controlar de forma proactiva el espín con los campos eléctricos.»

El profesor Christian Bernhard, de la Universidad de Friburgo, Departamento de Física, describe su técnica con éxito: «Usando la técnica espectroscópica Low Energy Muon Spin Rotation (LE-?SR), nuestros experimentos han visualizado la polarización de espín cerca de interfaces de una válvula de espín . »

Los experimentos se realizaron en el Instituto Paul Scherrer, la única institución en todo el mundo, donde esta técnica está disponible. El método utiliza las propiedades magnéticas de los muones – partículas subatómicas inestables. «En un experimento los muones se arrojan al material y cuando se descomponen, los productos de desintegración llevar información acerca de los procesos magnéticos en el interior del material», explica el profesor Elvezio Morenzoni de la ISP, donde se ha desarrollado la técnica. «Lo único acerca de muones de baja energía es que se pueden colocar en una capa específica en un sistema multi-capa. Por lo tanto con este método se puede estudiar el magnetismo en un sola capa por separado.»

Fuente: ScienceDaily

_____________

Enlaces de interés:

– Actualidad informática: Sistemas almacenamiento

– Apuntes Periféricos de un ordenador. GAP. UMU. Introducción Informática

– Apuntes Informática Aplicada al Trabajo Social. UMU. Introducción al Hardware

______________

Enlaces de no interés:

abogados alicante

desarrollo web

diseño pagina web

trabajar en casa

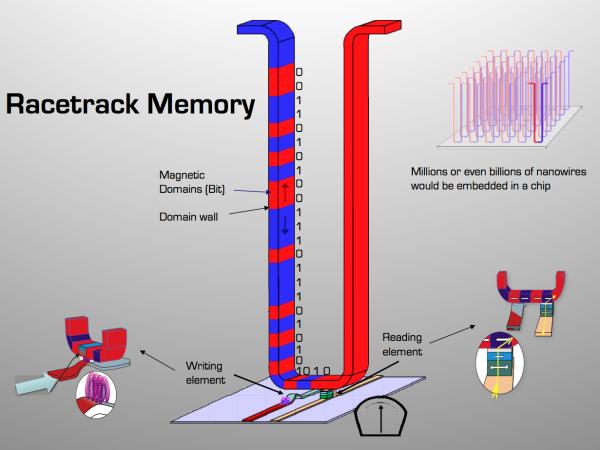

Memoria magnética «Racetrak», 100000 veces más rápida

Imagine un ordenador equipado con memoria a prueba de choque que es 100 000 veces más rápido y consume menos energía que los discos duros actuales. El profesor Mathias Kläui está trabajando en un nuevo tipo de memoria, ultra-rápida y no volátil, de lectura y escritura magnética que puede hacer que este dispositivo pronto sea posible.

Molesto por el tiempo que tardó su equipo en el arranque, Kläui comenzó a pensar en una alternativa. Los discos duros son baratos y pueden almacenar cantidades enormes de datos, pero son lentos; cada vez que un ordenador arranca, 2-3 minutos se pierden mientras se transfiere la información desde el disco duro a la memoria RAM (memoria de acceso aleatorio). El coste global en términos de pérdida de productividad y consumo de energía asciende a varios centenares de millones de dólares al día.

Al igual que la cinta de vídeo VHS probada y auténtica, la solución propuesta consiste en los datos grabados en cinta magnética. Pero la similitud termina ahí, en este sistema la cinta sería un nanocable de níquel-hierro, un millón de veces más pequeño que la cinta clásica. Y a diferencia de una cinta de vídeo magnética, este sistema no se mueve mecánicamente. Los bits de información almacenada en el cable son simplemente empujados dentro de la cinta mediante una corriente de espín polarizado, alcanzando la velocidad vertiginosa de varios cientos de metros por segundo en el proceso. Es como leer toda una cinta de VHS en menos de un segundo.

Para que la idea sea factible, cada bit de información debe estar claramente separado del siguiente, de manera que los datos se pueden leer con fiabilidad. Esto se logra mediante el uso de paredes de dominio con vórtices magnéticos para delinear dos bits adyacentes. Para estimar la velocidad máxima a la que los bits se pueden mover, Kläui y sus colegas llevaron a cabo mediciones en los vórtices y encontraron que el mecanismo físico podría permitir posibles velocidades de acceso más altas de lo esperado.

Sus resultados fueron publicados en línea el 25 de octubre 2010, en la revista Physical Review Letters. Scientists at the Zurich Los científicos en el Centro de Investigación Zurich de IBM (que está desarrollo de un circuito de memoria racetrak) han confirmado la importancia de los resultados en un artículo. Millones o incluso miles de millones de nanocables estaría incorporados en un chip, proporcionando una capacidad enorme en una plataforma a prueba de choques. Un dispositivo listo para el mercado podría estar disponible en tan sólo 5-7 años.

La memoria Racetrack promete ser un verdadero avance en el almacenamiento y recuperación de datos. Ordenadores equipads con Racetrack van a arrancar de inmediato, y su información se puede acceder 100 000 veces más rápidamente que con un disco duro tradicional. También se ahorra energía. RAM debe ser alimentado cada millonésima de segundo, por lo que un equipo inactivo consume hasta 300 mW sólo por mantener los datos en la RAM. Como la memoria Racetrack no tiene esta limitación, el consumo de energía puede ser reducido en casi un factor de 300, a unos pocos mW mientras que la memoria está inactivo. Es una consideración importante: la informática y la electrónica de consumo actualmente gastan el 6% de la electricidad en todo el mundo, y se prevé que aumentará a 15% en 2025.

Fuente: ScienceDaily

autobus las palmas aeropuerto cetona de frambuesa