Actualidad informática

Noticias y novedades sobre informática

Imitan el sistema nervioso: un nuevo transistor de los ordenadores del futuro

Un nuevo tipo de transistor basado en el funcionamiento del sistema nervioso, puede facilitar el reconocimiento de imagen y realización de otras tareas complejas con las nuevas generaciones de ordenadores, según estudios publicados el viernes.

El transistor, en base a un circuito electrónico se puede limitar o no para transmitir una señal, interpretadas como una respuesta «sí» o «no». Como decir si un píxel de una imagen es negro o blanco.

Este tipo de respuesta «congelada» es poco adecuado para tareas complejas, como el tratamiento o el reconocimiento de imagen, según Dominique Vuillaume, investigador en el Instituto de Electrónica, Microelectrónica y Nanotecnología en Lille (IEMN-CNRS).

El nuevo tipo de transistor de que ha desarrollado con sus colaboradores del CNRS y el CEA introduce una mayor flexibilidad, plasticidad, imitando el funcionamiento de los sistemas biológicos, tales como las redes neuronales.. Estas células nerviosas puedan comunicarse con sus vecinas a través de miles de puntos de conexión llamados sinapsis.

El nuevo tipo de transistor debe conducir a una «respuesta colectiva» como la que puede proporcionar una red neuronal integrando de múltiples informaciones, según Vuillaume.

Esto da lugar a un «sistema con una flexibilidad tal que puede ser programado por el aprendizaje».

El transistor llamado NOMFET (nanopartículas orgánicas Memoria Transistor) combina una molécula que contiene carbono, el pentaceno, actuando como semiconductor, y nanopartículas de oro que los electrones pueden atrapar. Estas nanopartículas son capaces de modular la señal electrónica y así imitar la plasticidad de las sinapsis en el cerebro.

NOMFET por sí solo podría reemplazar siete transistores basados en CMOS de silicio actualmente necesarios para imitar la plasticidad de una sinapsis biológica, lo que resulta en ahorro de espacio, según un estudio publicado el viernes en la revista Advanced Functional Materials.

«El objetivo de estos sistemas como las redes neuronales no es necesariamente competir con los chips de silicio en los ordenadores, las aplicaciones no son todas iguales», señala el Sr. Vuillaume. Esto «sirve para hacer frente a una gran cantidad de información en paralelo», como reconocimiento de imagen, pero «no vamos a hacer computación científica con él», concluye.

Fuente: France24

________________

Enlaces de interés:

- Las cinco “leyes” de la informática: Moore, Rock, Wirth, Metcalfe y Machrone

- Las compañías tecnológicas que más patentes registran

- Posible Memoria Molecular, utiliza 10 átomos de ancho

- Sesenta años de evolución, para que el tamaño de un transistor no se vea

- Transistores moleculares construidos con molécula de benceno

- Un Nobel de Física predice que el fin de la electrónica convencional llegará en diez años

- IBM consigue almacenar información en átomos y moléculas

Nueva interface USB 3.0

CES 2010 fue el marco elegido por los grandes fabricantes para dar el pistoletazo de salida del USB 3.0. A partir de la primavera empezarán a llegar nuevos dispositivos diseñados especificamente para obtener el máximo provecho de esta tecnología. En este breve artículo te apuntamos las novedaes que presenta el USB 3.0 y sus principales diferencias con USB 2.0

La gran diferencia entre el nuevo estándar USB 3.0 y su predecesor USB 2.0 es la sorprendente velocidad del USB 3.0. Si en USB 2.0 el cable dispone de cuatro líneas, un par para datos, una de corriente y una de toma de tierra, en USB 3.0 se añade cinco líneas.

Dos de ellas se usarán para el envío de información y otras dos para la recepción, de forma que se permite el tráfico bidireccional, en ambos sentidos al mismo tiempo, logrando un alto aumento de velocidad de transmisión.

Otra mejora del USB 3.0 es el aumento de intensidad de la energía. Con el USB 2.0, la cantidad de energía que transporta un cable USB resulta insuficiente en muchas ocasiones para recargar algunos dispositivos, especialmente si se utiliza hubs donde se conecta varios dispositivos a la vez.

En USB3.0, se aumenta la intensidad de la corriente de 100 miliamperios a 900 miliamperios, con lo que se puede cargar más dispositivos o hacerlos más rápidos. Además, el USB 3.0 administra mejor la energía que el USB 2.0 ya que utiliza una nueva arquitectura de interrupciones, que evita que la PC esté ocupado y consumiendo energía innecesariamente, como sucede con el USB 2.0 que chequea en forma constante el bus para ver si algún dispositivo se encuentra conectado. Esta nueva arquitectura ignora los dispositivos conectados y deja de hacerlo una vez que el dispositivo comienza su trabajo, ahorrando así energía.

Fuente: Gadgetmanía

Bajo licencia Creative Commons

___________________

Enlaces relacionados:

– Bus USB

– Apuntes Informática Aplicada al Trabajo Social. Introducción al hardware

Transistores moleculares construidos con molécula de benceno

Un grupo de científicos ha tenido éxito en crear el primer transistor hecho solo de una molécula. El equipo, el cual incluye investigadores de la Universidad de Yale y el Instituto de Ciencia y Tecnología de Gwangju en Corea del Sur, publica sus hallazgos en el número del 24 de Diciembre de la revista Nature.

El equipo, incluyendo a Mark Reed, al profesor de Ingeniería y Ciencia aplicada en Yale Harold Hodgkinson, mostró que una molécula de benceno unida a contactos de oro podría actuar como un transistor de silicio.

Los investigadores fueron capaces de manipular los diferentes estados energéticos de la molécula en función de la tensión aplicada a través de los contactos. Mediante la manipulación de los estados energéticos, fueron capaces de controlar la corriente pasando a través de la molécula.

«Es como hacer rodar una pelota arriba y abajo por una montaña, donde la pelota representa la corriente eléctrica y la altura de la montaña representa los diferentes estados energéticos de la molécula.» dijo Reed. «Fuimos capaces de ajustar la altura de la montaña, permitiendo a la corriente pasar cuendo era baja, y parando la corriente cuando era alta.» De esta manera, el equipo fue capaz de usar la molécula más o menos de la misma manera que son usados los transistores corrientes.

El trabajo está construido a partir de investigaciones previas hechas por Reed en 1990, el cual demostró que las moléculas individuales podrían estar atrapadas entre los contactos eléctricos. Desde entonces, él y Takhee Lee, un antiguo postdoctorado asociado en Yale y ahora un profesor en el Instituto de Ciencia y Tecnología de Gwangju, desarrollaron técnicas adicionales a lo largo de los años que les capacitaron para «ver» que estaba ocurriendo a nivel molecular.

Al ser capaces de fabricar contactos eléctricos a mucha menor escala, identificando las moléculas ideales a usar, y comprendiendo donde colocarlas y como unirlas a los contactos fueron también componentes clave del descubrimiento. «Había muchos avances tecnológicos y la comprensión construida durante años hizo esto posible,» dijo Reed.

Hay mucho interés en usar las moléculas en circutos de ordenadores porque los transistores tradicionales no son aprovechables a mucha menor escala. Pero Reed declaró que esto es estríctamente un avance científico y que las aplicaciones prácticas tales como «ordenadores moleculares» más pequeños y rápidos – si al final es posible – están a muchas décadas de distancia.

«No estamos a punto de crear la próxima generación de circuitos integrados,» dijo. «Pero tras muchos años de trabajo preparándonos para esto, hemos completado una década de búsqueda y mostrado que las moléculas pueden actuar como transistores.»

Los otros autores del artículo incluyen a Hyrunwook Song y Yun Hee Jang (Instituto de Ciencia y Tecnología de Gwangju); y Youngsang Kim y Heejun Jeong (Universidad Hanyang).

Noticia publicada por la Universidad de Yale en inglés.

Fuente: NLC – Astronomía y tecnología

Bajo licencia Creative Commons

Procesadores Atom con gráficos y controlador de memoria integrados

Los nuevos procesadores Atom, que llevan la mayoría de ordenadores miniportátiles (netbooks), integran los gráficos y el controlador de memoria en la CPU «para reducir el consumo energético, facilitar el diseño de sistemas más pequeños y mejorar el rendimiento de los equipos», según informa su fabricante, Intel.

Se trata de tres nuevos chips que funcionan a 1.66 GHz. El N450, para miniportátiles, es de un núcleo. El D410 y el D510 son para equipos de sobremesa. El primero lleva un solo núcleo y el segundo doble núcleo conun mega de memoria caché. La familia Atom estará disponible a partir del 4 de enero.

Atom ha sido fabricado desde cero, asegura el principal fabricante de chips del mundo, pensando en los aparatospequeños y de bajo consumo. El tamaño general, incluido el chipset, «se ha podido miniaturizar aún más gracias a la integración que ha permitido el proceso de fabricación de 45 nanómetros (nm) ya que facilita la creación de unos diseños de menor tamaño, más compactos, reduciendo costes de fabricación y mejorando el rendimiento de los equipos», informa en un comunicado.

Desde que Intel anunció los primeros procesadores Atom para miniportátiles y PC de sobremesa en junio de 2008, la compañía ha distribuido más de 40 millones de chips Atom. Según la consultora ABI Research, se espera que el total de procesadores Atom distribuidos a todos los segmentos siga aumentando hasta los centenares de millones en el 2011.

Intel ya ha cerrado más de 80 contratos para el diseño de mini portátiles con los principales fabricantes de equipos informáticos, entre los que se incluyen ASUS, Acer, Dell, Toshiba, Fujitsu, Lenovo, Samsung y MSI .

Fuente: ElPaís.com

__________________

Enlaces de interés:

– Intel y la guerra de los derechos de autor DMR

– La Comisión Europea impone a Intel la multa récord de 1060 millones de euros

– ¡La informática en un garaje! 1971 – 1976

– Historia microordenadores. Divulgacion informatica

– Ley de Moore. Divulgación electrónica. Rafael Barzanallana

Los límites físicos de la carrera de los megapixeles

Desde Caborian hemos hablado en ocasiones del sinsentido en el que se ha convertido la carrera de los fabricantes por ofrecer más y más megapíxels. Esta semana leemos un interesantísimo artículo en Luminous Landscape acerca de un fenómeno óptico que acaba con esta batalla, al menos en el plano técnico que no siempre sigue el mismo camino que el marketing.

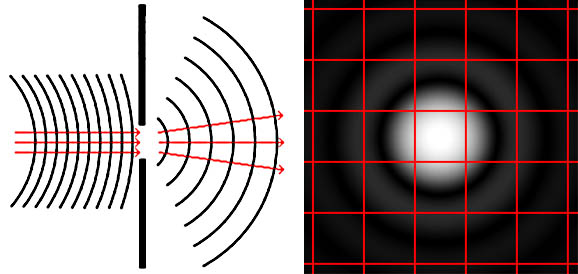

Luminous Landscape cita a su vez a un artículo de Cambridge in Colour acerca de cómo la difracción afecta a la nitidez de las imágenes y cómo esto limita la resolución posible máxima de los sensores. En numerosos artículos técnicos se habla de la difracción sin que mucha gente sepa exactamente lo que es. Un antiguo profesor mío decía que la luz dobla las esquinas, como explicación más sencilla a este fenómeno.

En lo que se refiere a imagen fotográfica, la difracción provoca que un haz de luz, al atravesar un orificio pequeño como el diafragma, se disperse llegando al sensor (o película) no ya como como tal rayo de luz sino que se extiende dando lugar a una mancha que se llama disco de Airy. A medida que cerramos más el diafragma, la luz se dispersa más y el disco de Airy crece emborronando la imagen. Cuando llega a tener un tamaño físico mayor que el de un píxel, simplemente ya no podremos resolver tanto detalle.

En la página de Cambridge in Colour, existe una sencilla calculadora para saber cuándo la difracción del diafragma está afectando a la nitidez. Introduciendo en ella la resolución y el tamaño –formato- del sensor , la apertura del diafragma, y fijando como límite del círculo de confusión dos píxels, podemos ver cuándo la difracción está afectando a la nitidez de nuestra imagen, y ya no se puede resolver más detalle. A partir de un valor de apertura, cerrar más el diafragma hará que perdamos detalle. Como resumen, el límite que impone este fenómeno para las cámaras DSLR más típicas podría ser el siguiente

- – Para las cámaras de formato Cuatro Tercios: f:8 para 12mpix

- – Para las cámaras APS-C con factor de recorte 1,5-1,6: f:11 para 12 mpix, y de f:8 para 15 mpix

- – Para las cámara con sensor FF: f:16 para 12 mpix y de f:11 para 24mpix

La evolución de la tecnología de los sensores hará sin ninguna duda que ganemos rango dinámico e imágenes limpias de ruido para valores de ISO mayores, pero el límite que fija la difracción para que no se pueda aumentar la resolución de los sensores simplemente no se puede superar, va contra las leyes de la física.

Via | Luminous Landscape

Fuente: CABORIAN

Resistir los pulsos electromagnéticos

Una de las mayores debilidades de los ejércitos modernos es la dependencia de la electricidad y la electrónica. De hecho ya se ha demostrado que un golpe a la logística de la energía puede asestar el golpe definitivo, pero algo que tienen muy en cuenta a la hora de diseñar dispositivos es la resistencia frente a los pulsos electromagnéticos.

Un pulso electromagnético se produce en una gran explosión, se trata de un campo magnético producido por el efecto Compton en electrones que varía rapidísimamente. Este tipo de campos pueden inducir corrientes en los circuitos electrónicos muy intensas que los destruyen por completo si no están apropiadamente aislados. Sucedería en caso de una explosión nuclear o de un impacto de un asteroide y en frecuencias de hasta 30 kHz.

Durante las numerosas pruebas nucleares llevadas a cabo por Estados Unidos, una de ellas realizada a gran altitud, la Starfish Prime era una bomba nuclear de 1.4 megatones detonada a 400 kilómetros de altura. Produjo un pulso electromagnético tan intenso que hizo saltar por los aires farolas en Hawaii, además de dejar sin luz a miles de hogares, a más de mil kilómetros de distancia. Se observaron además auroras típicas de las regiones polares.

Como dice una de las leyes de Murphy del combate, si hay algo que tiene más puntería que el fuego enemigo es el fuego amigo. Y en el caso de las explosiones nucleares, aunque el efecto devastador de la bola de fuego sea localizado, el pulso electromagnético puede freir cualquier dispositivo electrónico a centenares de kilómetros de distancia. Desde un avión hasta un teléfono. Todo quedaría inutilizado inmediatamente. Sobre este tema aberron escribió un buen artículo en Fogonazos llamado Las bombas del arcoiris.

Artículo compelto en: Migui

Bajo licencia Creative Commons

Sistema de visión artificial para invidentes para ver utilizando la lengua

Vemos con el cerebro, no con los ojos.” Un nuevo dispositivo permite ver a los invidentes utilizando las terminaciones nerviosas de la superficie de la lengua. Las imágenes de una cámara son enviadas a una matriz de electrodos que se coloca sobre la lengua permitiendo, tras cierto entrenamiento, ver a una persona ciega. BrainPort sustituye los dos millones de nervios ópticos de un ojo por una matriz cuadrada de 400 elecrodos que se coloca sobre la lengua. Cada electrodo genera un pulso eléctrico correspondiente a un promedio de ciertos píxeles en la imagen de una cámara, siendo el blanco un pulso eléctrico fuerte y el negro la ausencia de pulso eléctrico. “Tan fácil como aprender a montar en bicicleta.” Los estudios indican que unos 15 minutos de entrenamiento son suficientes para que una persona invidente logre obtener información espacial de su entorno que le permita moverse y evitar obstáculos. Tras una semana, la mayoría de los sujetos aprenden a encontrar puertas y botones de ascensores, a leer letras y números, y a agarrar vasos o tenedores colocados en una mesa. BrainPort es un sistema de visión para invidentes no invasivo que se sometió a evaluación por el gobierno americano (U.S. Food and Drug Administration) a finales de agosto, por lo que podrá comercializarse a inicios del año próximo, con un precio estimado de 10 mil dólares americanos. Nos lo cuenta Mandy Kendrick ,”Tasting the Light. Device lets the visually impaired “see” with their tongues,” Scientific American, october 2009, pp. 22-24.

Memoria F-RAM permanente que permite mantener los datos diez años de los datos

Ramtron ha anunciado la disponibilidad de su memoria de 8-Megabit (Mb) F-RAM en un encapsulado FBGA. El FM23MLD16 es una RAM permanente de 8-Mbit, 3 voltios, que ofrece ciclos de lectura/grabación de rápido acceso, virtualmente ilimitados, con bajo consumo de energía.

Es ccompatible a nivel de pines con la RAM estática asincróna (SRAM), está orientada hacia sistemas de control industriales tales como robótica, soluciones del almacenaje RAID de red, impresoras multifuncións, sistemas de navegación en autos, y como anfitrión de otros diseños de sistemas basados en SRAM.

Fuente: EETimes europe

Un Nobel de Física predice que el fin de la electrónica convencional llegará en diez años

Fert (Carcassone, Francia, 1938), quien ganó el Premio Nobel en 2007 junto con el alemán Peter Grünberg por descubrir, por separado, la «magneto-resistencia gigante», ha comparecido hoy en rueda de prensa con motivo de su investidura, mañana, como doctor «honoris causa» por la Universidad de Zaragoza.

La magneto-resistencia es un efecto mecánico cuántico que ha permitido multiplicar por cincuenta la capacidad de almacenamiento en discos duros de ordenador, aparatos musicales, aplicaciones electrónicas y cámaras de vídeo.

Al aumentar la capacidad de almacenamiento de los discos duros hasta centenares de gigabites, reduciendo la unidad de almacenamiento y haciendo de la magnetoelectrónica, o la espintrónica, un nuevo campo de la ciencia llamado a sustituir a la electrónica actual.

Fert ha insistido, en esta línea, en que la espintrónica es «una gran oportunidad» para la nanoelectrónica y la nanotecnología, que son una «maravillosa oportunidad» para la física, porque «abre muchos caminos para predecir determinados fenómenos».

La nanotecnología es muy importante, ha dicho, para otras disciplinas científicas, como la Biología, la Medicina o la Química, y para llegar a crear dispositivos útiles que generen nuevos materiales y, por añadidura, nuevos fenómenos físicos.

UN CAMPO «PROMETEDOR»

Los desarrollos más conocidos de la spintrónica son los relacionados con la lectura de información de discos duros, pero hay un campo «prometedor», ha dicho Fert, relacionado con la mejora de las aplicaciones para telecomunicaciones, con dispositivos que puedan emitir y recibir microondas de modo muy eficiente y que se puede aplicar a los teléfonos móviles.

Sobre el descubrimiento que le hizo merecer el Nobel, Albert Fert ha reconocido que fue difícil predecir las «implicaciones económicas» que llegaron después de las relacionadas con la computación, como las que tiene para los iPods, las cámaras fotográficas o los teléfonos móviles.

Se trató, ha precisado, de un descubrimiento de «investigación básica», un tipo de investigación que tiene mucha importancia.

Fert también se ha referido a la necesidad de que los países europeos inviertan en tecnología para hacer frente a la «amenaza» que suponen para Europa, en este campo, nuevos países, sobre todo de Asia, como China y Singapur, además de Japón.

Aragón cuenta con un Instituto de Investigación en Nanotecnología, una ciencia que, ha dicho el profesor Ricardo Ibarra, de la Universidad de Zaragoza, nace con «gran potencia» porque aborda problemas que están «en el límite de las disciplinas convencionales» y que abre, por tanto, nuevas perspectivas en el ámbito, por ejemplo, de la terapia y el diagnóstico en Medicina.

Fuente: hoy tecnología

Las cinco “leyes” de la informática: Moore, Rock, Wirth, Metcalfe y Machrone

La ley de Moore no está demostrada. Más aún, es indemostrable que “el número de transistores integrados en un chip se duplica cada 24 meses,” (en los 1970 cada 18 meses). Evidencia empírica, que algún dejará de ser válida. Una “ley” que no es una ley. Una ley indemostrable. La ley de Rock afirma que cada 4 años el coste de una fábrica de chips se duplica (luego algún día dejará de ser económicamente rentable). La ley de Wirth afirma que el software se ralentiza más deprisa de lo que acelera el hardware (por eso, para hacer lo mismo, cada día se necesita un ordenador más potente); algunos la llaman ley de Page. La ley de Machrone afirma que el próximo ordenador personal que querrás comprarte siempre tiene el mismo precio, unos 1000 euros (ahora parece que habrá que bajarlo a 500 euros). La ley de Metcalfe afirma que el valor económico de una red crece con el cuadrado del número de usuarios (a más usuarios, más beneficios). Leyes que no son leyes, sólo evidencia empírica; leyes que algún día dejarán de ser válidas. Nos cuenta las 5 leyes de la informática Philip E. Ross, “5 Commandments. The rules engineers live by weren’t always set in stone,” IEEE Spectrum, December 2003. En inglés a este tipo de leyes les llaman “rule-of-thumb” algo que podríamos traducir al español como “la cuenta de la vieja.” Reglas (elevadas a “leyes”) que nos permiten estimar cosas.

¿Matará la ley de Rock a la ley de Moore? Sí, según Jack Schofield, que afirma en ”When the chips are down,” The Guardian, 29 July 2009, que la economía y no la física (ingeniería) parará la ley de Moore, aludiendo a la ley de Rock. Un ejemplo, Intel se está gastando (ha presupuestado) 7000 millones de dólares para la mejora (upgrade) de sus 7 plantas de fabricación de chips en EEUU. Global Foundries (chips AMD) ha empezado a construir una planta en el Estado de Saratoga, New York, por 4200 millones de dólares que empezará a funcionar en 2012.

Intel ha pasado de fabricar chips con transistores cuyo canal tenía 3000 nm. (3 micrómetros) a finales de los 1970, hasta los actuales 45 nm., con un objetivo a corto plazo en los 22 nm. Algunos proclaman que el límite teórico son los 18 nm., que se alcanzarán en 2014. Leo Jelinek, analista jefe la fábrica de semiconductores iSuppli afirma que la barrera de 18 nm. no es física en 2014 no es física sino económica: será demasiado caro fabricar chips más integrados.

Si el canal de los transistores no puede ser más pequeña, la única manera de fabricar chips con más transistores es hacer las obleas (y los chips) más grandes. La tecnología actual utiliza obleas de 30 cm. y se espera que para 2017 ya haya obleas de 45 cm. Otra posibilidad es hacer chips en 3D (tres dimensiones).

Obviamente, el futuro es impredecible.

Fuente: Francis (th)E mule Science’s News

_________________

Enlaces relacionados:

– Construyendo un chip molecular para computadoras

– Ordenadores en la actualidad. Apuntes Informática Aplicada al Trabajo Social.

autobus las palmas aeropuerto cetona de frambuesa