Física

Física

Imagínese que posee un televisor con el grosor y el peso de una hoja de papel. Será posible, algún día, gracias a la creciente industria de la electrónica impresa. El proceso, que permite a los fabricantes imprimir, literalmente sobre superficies de materiales para producir un dispositivo electrónico funcional, ya se utiliza en las células solares orgánicas y diodos orgánicos emisores de luz (OLED), que forman las pantallas de los modernos teléfonos móviles celulares.

A pesar de que esta nueva tecnología se espera que crezca por decenas de miles de millones de dólares en los próximos 10 años, uno de los desafíos es la fabricación a bajo costo en condiciones ambientales. Con el fin de crear la luz o energía mediante la inyección o recolección de electrones, la electrónica impresa requiere conductores, generalmente calcio, magnesio o litio, con una baja función de trabajo. Estos metales son químicamente muy reactivo. Se oxidan y dejan de funcionar si se exponen al oxígeno y la humedad. Esta es la razón por la que la electrónica en células solares y televisores, por ejemplo, debe ser cubierta con una barrera rígida, gruesa, como vidrio o caras capas de encapsulación.

Sin embargo, en los nuevos hallazgos publicados en la revista Science, investigadores de Georgia Tech han introducido lo que parece ser una técnica universal para reducir la función de trabajo de un conductor. Se extendió una capa muy delgada de un polímero, aproximadamente de unos 10 nanómetros de espesor, sobre la superficie del conductor para crear una superficie sólida dipolar. La interacción vuelve estables al aire a los conductores en electrodos eficientes, con una baja función de trabajo.

Los polímeros disponibles comercialmente pueden ser procesado fácilmente a partir de soluciones diluidas en disolventes tales como agua y metoxietanol.

«Estos polímeros son de bajo costo, ambientalmente amigables y compatibles con las técnicas existentes para producción en masa rollo a rollo», dijo Bernard Kippelen, director del Centro de Tecnología de Georgia para la Fotónica y Electrónica Orgánica (COPE). «La sustitución de los metales reactivos con los conductores estables, incluyendo polímeros conductores, cambia por completo los requisitos de cómo se fabrican productos electrónicos protegidos. Su uso puede allanar el camino para un menor coste y dispositivos más flexibles.»

Para ilustrar el nuevo método, Kippelen y sus colegas evaluaron el desempeño de los polímeros orgánicos, en los transistores de película delgada y OLED. También han construido un prototipo: por primera vez, células solares completamente plásticas.

«El modificador de polímero reduce la función de trabajo en una amplia gama de conductores, incluyendo plata, oro y aluminio», señaló Seth Marder, director asociado de COPE y profesor en School of Chemistry and Biochemistry. «El proceso también es eficaz en metal-óxidos transparentes y grafeno».

Un chip fabricado por Broadcom mejora la precisión de la geolocalización mediante la combinación de información procedente de múltiples sistemas de posicionamiento por satélite. Esto hace que sea muy fácil la ubicación dentro de un edificio utilizando ingeniosamente los diversos sensores en un terminal móvil.

Al entrar en un hipermercado, nos gustaría que la ubicación del GPS siguiera activa para encontrar fácilmente las zanahorias, destornilladores y la comida para gatos que vinimos a buscar. Un día a un precio, tal vez, una letanía de las promociones en curso en la tienda, esta geolocalización muy precisa interna será posible, si se juzga por la presentación del BCM4752, un chip de nueva generación desarrollado por Broadcom. Esta compañía norteamericana especializada en semiconductores para terminales móviles ofrece circuitos integrados que incluyen los usados por Bluetooth y Wi-Fi y los teléfonos inteligentes de Apple.

La peculiaridad es que el chip BCM4752 es al mismo tiempo puede recibir señales de cuatro constelaciones de satélites con un total de 59 satélites: el GPS estadounidense, el sistema ruso Glonass, el sistema japonés QZSS (Quasi-Zenith Satellite System) y SBAS (Sistema de satelite basado en aumento) que gestiona la corrección de las normas de colocación para una mayor precisión. Broadcom dice que esta recepción de varios canales, no sólo mejora la precisión de localización en tiempo real sino que también permite una adquisición más rápida mediante la selección de la mejor señal disponible dependiendo de la ubicación. El BCM4752 reduce el TTFF o el tiempo para la primera fijación, es decir, el tiempo requerido para que un sistema de navegación por satélite (Global Navigation Satellite System o GNSS) establezca la conexión inicial.

Esta velocidad puede, por ejemplo, permitir un lanzamiento más rápido del mapeo de la pérdida de señal o limitaciones al pasar a través de un túnel o en un entorno urbano denso. «Debido a que el BCM4752 pueden acceder simultáneamente a más satélites que otros chips, se puede calcular esta información con mayor rapidez, proporcionando así una experiencia de usuario más cómoda», explicó un responsable técnico de Broadcom. La otra ventaja pone de relieve el consumo de energía, que sería menor en un 50% en comparación con los chips actuales.

Localización en interiores

Además, el BMC4752 también tiene la capacidad para asegurar la ubicación dentro de un edificio, donde GNSS no siempre es operativo. ¿Cómo? Al recoger la señal de radio emitida por módulos Bluetooth, WiFi, NFC, chips GSM, sino también con varios sensores (acelerómetro, brújula, giroscopio o altímetro) presentes en un smartphone o una tableta. Broadcom cree que su innovación puede allanar el camino para nuevos servicios basados en localización a través del cual los proveedores pueden, por ejemplo, saber con exactitud cuando un cliente entra en su tienda.

Otra hipótesis, una empresa podría crear una aplicación que pusiera automáticamente un teléfono inteligente en modo silencio cuando alguien llegara a su lugar de trabajo. Esto también podría ser utilizado por las administraciones o en ciertos lugares públicos (cines, teatros, museos …). Henry Rael, de Broadcom, que señaló que el chip ha sido diseñado para integrarse fácilmente en las arquitecturas existentes de los teléfonos inteligentes. «El chip funciona en la CPU del teléfono inteligente. Aparte de eso, no hay requisitos técnicos específicos. «Broadcom ha indicado que los primeros dispositivos que ofrecen el nuevo chip será comercializado durante el último trimestre de 2012».

Las rupturas son a menudo desordenada, y en la división de las partículas subatómicas, las partículas hijas no son una excepción. Ahora la capacidad de simular un famoso decaimiento de partícula podría ayudar a responder a una de las cuestiones más candentes en la física: por qué el universo parece contener más materia que antimateria.

De acuerdo a nuestra imagen actual, el Big Bang produjo partículas y antipartículas en cantidades iguales, la mayoría de las cuales se aniquilaron mutuamente para liberar energía. En algún momento, algún factor desconocido ha llevado a la existencia de más partículas que antipartículas.

Una pista de lo que esto podría ser surgió en 1964, cuando James Cronin y Val Fitch, en la Universidad de Chicago, observaron partículas subatómicas llamadas kaones, decaer en dos piones, otro tipo de partículas.

Creemos que la antimateria es como una copia exacta de la materia, pero a la inversa, con ciertas propiedades – por ejemplo, la antipartícula de una partícula cargada tiene la carga opuesta. Sin embargo, en la descomposición de Fitch y Cronin observaron que la antimateria deben diferir en algún otro modo fundamental. Ese es el tipo de asimetría necesaria para explicar el puzzle más grande de materia-antimateria, y en 1980, la pareja ganó el premio Nobel de Física.

La comprensión de las interacciones que participan en este decaimiento del kaón ha demostrado ser difícil, sin embargo. Un mecanismo teórico de la decadencia existe, pero nadie podía saber si sus predicciones estaban a la altura de las observaciones experimentales.

Ahora un equipo de investigadores del Reino Unido, EE.UU. y Alemania han utilizado el superordenador IBM BlueGene / P del Laboratorio Nacional Argonne en Illinois, además de otras supercomputadoras, para simular un kaon decaer en dos piones, por primera vez.

El equipo utilizauna técnica llamada celosía QCD para simular una región del espacio a través de cinco femtometros, en la que cientos de interacciones entre quarks y gluones que llevan la fuerza, se llevará a cabo. «El resultado es una especie de enjambre de todos los diferentes tipos de partículas, antipartículas y gluones», dice el miembro del equipo de Norman Christ de la Universidad de Columbia en Nueva York.

El equipo comenzó mediante la simulación de un kaon compuesto por un quark down y un antiquark extraño, y luego cambió a éste en un quark abajo. El modelo estándar de física de partículas, dice que este cambio se debe generar dos pares quark-antiquark necesarias para hacer dos piones. A continuación, el equipo hace la simulación de los piones, que permita calcular la probabilidad de que efectivamente se produjo por el Kaon. Después de 281 días de tiempo en la computadora, el resultado fue un valor para la probabilidad de que el kaon decaería en dos piones, que coincide con las mediciones experimentales (arxiv.org/abs/1111.1699).

«Este es un cálculo que no podíamos siquiera hemos tocado sin este superordenador», dice Christ. Sin embargo, el trabajo, que será publicado en Physical Review Letters, no explica del todo la asimetría materia-antimateria a apuntalar la decadencia kaon. Eso requerirá una simulación más complicada en una supercomputadora más potente. Si eso está de acuerdo con el experimento también puede significar que el modelo estándar, que abarca todas las partículas y fuerzas conocidas, pero es casi seguro que incompleto, es suficiente para explicar el enigma de materia-antimateria.

Aaron Roodman del SLAC National Accelerator Laboratory, en Palo Alto, California, quien no estuvo involucrado en el trabajo, dice que cualquier desajuste todavía puede revelar la necesidad de una nueva física. «Si no están de acuerdo, entonces puede ser que tengamos algo nuevo».

Fuente: NewScientist

En Nature de esta semana, Abraham Loeb, jefe del departamento de astronomía de Harvard, en su columna propone la creación de un sitio web que actuaría como una especie de «agencia de calificación», la aplicación de algún modelo matemático que mida la salud de los diversos subcampos de la física. Esto proporcionará a los científicos jóvenes una información más objetiva sobre que subcampos lo están haciendo bien y vale la pena involucrarse en ellos, a diferencia de aquellos que son persistentes en la falta de progreso. ¿El principal ejemplo de Loeb es de la «persistencia en» categoría?

En física, el valor de una teoría se mide por lo bien que está de acuerdo con los datos experimentales. Pero, ¿cómo la comunidad de físicos mide el valor de una teoría emergente que aún no puede ser probada experimentalmente? Sin verificación de la realidad , como una hipótesis menos rigurosa de la teoría de cuerdas puede permanecer en él, a pesar de que los físicos han sido capaces de elaborar su valor real en la descripción de la naturaleza …

Teoría de las burbujas

El estudio del fondo cósmico de microondas es un ejemplo de cómo la teoría y los datos pueden generar oportunidades para los jóvenes científicos. Tan pronto como el satélite Cosmic Background Explorer de la NASA, informó de evidencias concluyentes de las fluctuaciones de temperatura del fondo cósmico de microondas a través del cielo en 1992, el trabajo experimental posterior generó muchas oportunidades para que las teorías de los jóvenes y los observadores se unieran a este campo. Por el contrario, una hipótesis como la teoría de cuerdas, que pretende unificar la mecánica cuántica con la teoría general de Albert Einstein de la relatividad, hasta ahora no han sido probados críticamente los datos experimentales, incluso en un lapso de tiempo equivalente a la carrera de un físico.

El problema por supuesto es el de decidir quién va a hacer evaluaciones de lo que es un campo sano y cuál no lo es. Las personas con una gran cantidad invertida en un tema moribundoso muerto tienen fuertes incentivos para tergiversar la situación (véase, por ejemplo, el famoso sketch de Monty Python loro muerto). Loeb compara implícitamente la situación actual con la teoría de cuerdas a la que, tras la crisis financiera, que se vio agravada por las agencias de calificación de la asignación de una calificación AAA a la deuda no muy lejos de la habitual.

Los científicos de alto nivel, pueden parecer los que mejor se adapten para trabajar en las fronteras de la investigación. Pero muchos de estos físicos están ya involucrados en la evaluación de la promesa de estas teorías especulativas, lo que implica que podría tener un conflicto de intereses o ser ilusos. Tener este tipo de científicos de alto nivel como promesa para el futuro sería similar a la calificación AAA que los organismos financieros le dieron a los mismos títulos de deuda de las que disfrutaron. Esta situación indecorosa ha contribuido a la última recesión, y una tendencia de larga duración de este tipo en el mundo de la física de manera similar podría conducir a consecuencias devastadoras, como un período prolongado de estancamiento intelectual y una comunidad de físicos con talento invirtiendo tiempo en proyectos de investigación que probablemente no aclaren nuestra comprensión de la naturaleza – teoría de una «burbuja», para contraer empréstitos con el mundo financiero.

En cuanto a la idea de Loeb sobre un sitio web donde los científicos jóvenes puedan acudir para obtener información sobre la salud de un campo, se mantiene escéptico sobre las perspectivas de que implementa un modelo matemático. Sin embargo, un sitio web dedicado a la discusión honesta e informada sobre lo que está pasando en el campo si es saludable, proporcionando un lugar para estudiantes y otras personas a escuchar y participar en el debate, ayudándoles a tomar sus propias decisiones, me parece una excelente idea …

Actualización: me acabo de dar cuenta que Loeb tuvo un papel en el arXiv el año pasado detallando su propuesta con más detalle.

Fuente: Not Even Wrong

La Universidad de Stanford ha elaborado una base de datos de los microprocesadores que se han comercializado desde 1970 hasta ahora; para cada microprocesador se ha redactado una ficha bastante completa, lo que permite comparar diferentes modelos y ver como han evolucionado la tecnología a lo largo de los años.

| Modelo | Año | Transistores | Tran./mm2 | Watios |

| Procesadores de 8 bits, era previa al PC | ||||

| 4004 | 1971 | 2.300 | 192 | 0,5 |

| 8008 | 1972 | 3.500 | 219 | 1,0 |

| 8080 | 1974 | 6.000 | 300 | 0,8 |

| Procesadores de PC de 16 bits | ||||

| 8086 | 1979 | 29.000 | 879 | 1,7 |

| 80286 | 1982 | 134.000 | 2.851 | 3,3 |

| Procesadores de PC de 32 bits | ||||

| 80386DX | 1986 | 275.000 | 2.670 | 1,7 |

| 80486DX | 1989 | 1.200.000 | 14.815 | 3,0 |

| Pentium | 1993 | 3.200.000 | 10.884 | 13,0 |

| Pentium II | 1997 | 7.500.000 | 36.946 | 12,0 |

| Pentium III | 1999 | 28.000.000 | 264.151 | 16,0 |

| Pentium 4 | 2000 | 42.000.000 | 193.548 | 52,0 |

| Pentium 4 P. | 2004 | 169.000.000 | 1.251.852 | 115,0 |

| Procesadores de PC de 2 núcleos | ||||

| Core 2 Duo | 2006 | 291.000.000 | 2.034.965 | 65,0 |

| Procesadores de PC de 4 núcleos | ||||

| Core i7 N. | 2008 | 774.000.000 | 2.614.865 | 45,0 |

| Core i7 S. B. | 2011 | 995.000.000 | 4.606.481 | 95,0 |

| Procesador de PC de 6 núcleos | ||||

| Core i7 980X | 2011 | 1.170.000.000 | 4.717.742 | 130,0 |

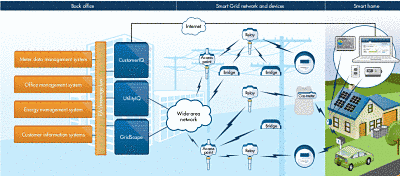

El término Smart Grid aparece con frecuencia en las noticias desde hace varios años, a pesar de que la mayoría de la gente no sabe lo que es reciente pero ha ganado mucho interés últimamente. Pero eso no ha impedido que varias empresas de semiconductores tomen una posición seria en el diseño y comercialización de productos para dicha «red inteligente».

Estas compañías han establecido su presencia con los frontales y microcontroladores de medidores eléctricos y chips ZigBee para red local de área (HAN). Tres empresas han sido particularmente agresivas en este campo. las desconocidas Bloom Energy y Silver

Spring Networks y la muy conocida Maxim Integrated Products.

La red eléctrica tal y como la conocemos no ha evolucionado desde su concepción. Sin embargo, los requerimientos actuales respecto al ahorro energético y la integración de nuevos elementos en la red eléctrica, como el vehículo eléctrico o las energías renovables, requieren de la evolución de la red eléctrica tal y como la conocemos a día de hoy.

La Smart Grid es esta evolución, la idea principal es ser capaces de controlar toda la red eléctrica desde la red de alta tensión (actualmente muy monitorizada), así como la de media y baja tensión, de la cual actualmente sólo se monitoriza el 20% aproximadamente.

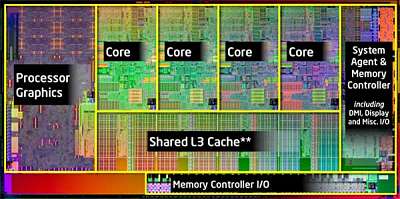

Los chips han dejado de ser cada vez más rápidos. A fin de mantener el aumento del potencia de los chips de computación a la tasa a la que nos hemos acostumbrado, los fabricantes de chips están dando lugar a otros «núcleos» o unidades de procesamiento.

Actualmente, un chip típico puede tener seis u ocho núcleos, todos comunican entre sí sobre un solo haz de «cables», llamado bus. Con un bus, sin embargo, sólo un par de núcleos pueden comunicarse a la vez, lo que sería una grave limitación en chips con cientos o incluso miles de núcleos, que muchos ingenieros eléctricos imaginan como el futuro de la computación.

Li-Shiuan Pe, profesor asociado de ingeniería eléctrica y ciencias de la computación en el MIT (EE.UU.), quiere que los núcleos de de los ordenadores entren en comunicación de la misma manera que opera internet, haciendo lo siguiente: «paquetes» para transmitir la información, cada núcleo tendrá su propio router, que podría enviar un paquete por cualquiera de varios caminos, dependiendo de la condición de la red como un todo.

En la Conferencia de automatización de diseño en junio, Pe y sus colegas presentarán un documento que describe como «resumen 10 años de investigación» en estas «redes en chips.» No sólo los investigadores establecen límites teóricos de la eficiencia de la conmutación de paquetes de –chip– redes de comunicación, pero también las mediciones actuales realizadas en un chip de prueba en la que estuvo muy cerca de llegar a varios de esos límites.

La última parada para los buses

En principio, los chips de varios núcleos son más rápidos que los chips de un solo núcleo, ya que pueden dividirse las tareas computacionales y ejecutarlas en varios núcleos a la vez. Los núcleos de trabajo en la misma tarea en ocasiones tendrán que compartir los datos, pero hasta hace poco, el recuento de núcleos en los chips comerciales ha sido suficientemente bajo para que un solo bus fuera capaz de manejar la carga de comunicaciones adicional. Eso ya está cambiando, sin embargo: «Los buses han llegado a un límite», dice Pe. «Por lo general se escala a cerca de ocho núcleos.» Los chips de 10 núcleos que se encuentran en servidores de gama alta con frecuencia añaden un segundo bus, pero ese método no funciona para chips con cientos de núcleos.

Por un lado, Pe, dice, «los buses consumen mucha potencia, porque están tratando de manejar ocho o 10 núcleos, al mismo tiempo.» En el tipo de red Pe propone, por el contrario, que cada central se comunica sólo con los cuatro núcleos más cercanos a él. «Aquí, usted está conduciendo a través de segmentos cortos de «cables», lo que les permite ir por debajo de la tensión», explica.

Con visión de futuro

Pe y sus colegas han desarrollado dos técnicas para hacer frente a estas preocupaciones. Una de ellas es algo que llaman «bifurcación virtual» (virtual bypassing). En internet, cuando un paquete llega a un router, el router inspecciona la información de direccionamiento antes de decidir cuál es el camino para circular. Con enrutado virtual, sin embargo, cada router envía una señal de avance a la siguiente, de manera que puede predeterminar el interruptor, lo que acelera el paquete sin ningún cálculo adicional. En los chips de prueba de su grupo, dice Pe, permiten un enfoque muy cercano al máximo de transmisión de datos, sobre las tasas predichas por el análisis teórico.

La otra técnica es algo que se llama «señalización de baja oscilación» (low-swing signaling). Los datos digitales se componen de unos y ceros que se transmiten a través de canales de comunicación como tensión alta y baja. Sunghyun Park, un estudiante de doctorado asesorado por Pe y Chandrakasan Anantha, F. José y Nancy P. Keithley profesor de Ingeniería Eléctrica, ha desarrollado un circuito que reduce la oscilación entre las tensiones altas y bajas de un voltio hasta 300 milivoltios. Con la combinación de señalización virtual, pasando por alto y bajo, el chip de ensayo de los investigadores consumía energía un 38 por ciento menos que los anteriores chips de prueba de conmutación de paquetes. Los investigadores tienen mucho trabajo por hacer, dice Pe, el consumo de potencia del chip de prueba se pone tan cerca del límite teórico como su velocidad de transmisión de datos lo hace. Pero, añade, «si lo comparamos contra un bus, tenemos varios órdenes de magnitud de ahorro».

Luca Carloni, profesor asociado de ciencias informáticas en la Universidad de Columbia, que también investiga las redes en el chip, dice que «el jurado está todavía fuera», sobre el futuro del diseño de chips, pero que «las ventajas de las redes de conmutación de paquetes de chips parecen convincentes». Se hace hincapié en que esas ventajas incluyen no sólo la eficiencia operativa de los chips mismos, sino también» un nivel de regularidad y productividad en tiempo de diseño que es muy importante. «Y en el campo, añade,» las contribuciones de Li-Shiuan son fundamentales. »

Esta historia se publica por cortesía de las noticias del MIT (http://web.mit.edu/newsoffice/ ), un sitio popular que cubre las noticias sobre la investigación del MIT, la innovación y la enseñanza.

La primera (Oil’d) explica nuestra dependencia del petróleo, contando qué se podría haber hecho con los 205 millones de galones de petróleo (o sea, 776000 m3: 1 US gal = 3,78 litros) que se derramaron hace dos años en el Golfo de Mexico, el 20 de abril de 2010.

La otra infografía, How green is your internet?, muestra que por muy virtual que sea la información, demanda un montón de energía: los data servers tienen que estar encendidos, pero además hay que refrigerarlos; todo cuesta energía. Cada segundo de vídeo en internet supone emitir 0,2 g de CO2 a la atmósfera. Internet produce la misma cantidad de emisiones que toda la aviación, o que un país de tamaño medio, como Suecia o Argentina.

Fuente: tgacebo

Los investigadores de Georgia Tech han encontrado una manera de captar y aprovechar la energía del ambiente transmitida por fuentes tales como transmisores de radio y televisión, redes de teléfonos móviles, y sistemas de comunicaciones por satélite. Se cree que la técnica podría proporcionar una nueva forma de energía a redes eléctricas, sensores inalámbricos, microprocesadores y chips de comunicaciones.

«Hay una gran cantidad de energía electromagnética a nuestro alrededor, pero nadie ha sido capaz de acceder a ella,» Manos Tentzeris, profesor en la Escuela Técnica de Ingeniería Eléctrica e Informática, de Georgia, que dirige la investigación, dijo en un comunicado. «Estamos utilizando una antena de banda ultra ancha que nos permite explotar una variedad de señales en diferentes rangos de frecuencia, que nos da mucha mayor capacidad de recolección».

«De acuerdo con la universidad, los dispositivos de barrido pueden capturar la energía transmitida por los dispositivos de comunicaciones, conversión de AC a DC, y luego almacenado en condensadores y baterías. La tecnología de barrido en la actualidad puede tomar ventaja de las frecuencias de radio FM para el radar, que abarca una gama de 100 MHz a 15 GHz o superior.

Experimentos de barrido que utilizan bandas de televisión han dado una potencia que asciende a cientos de microvatios, y se espera que multi-sistemas de banda generen un milivatio o más, informaron en el centro. La universidad agregó que esa cantidad de energía es suficiente para operar muchos pequeños dispositivos electrónicos, incluyendo una variedad de sensores y microprocesadores.

Los investigadores esperan que mediante la combinación de tecnología de barrido con supercondensadores y un funcionamiento cíclico, la tecnología será capaz de alimentar dispositivos que requieran más de 50 milivatios. En este enfoque, la energía se acumula en una batería de tipo supercondensador y se utiliza cuando se alcanza el nivel de potencia deseada.

Los investigadores dijeron que ya han operado con éxito un sensor de temperatura con la energía electromagnética capturada de una estación de televisión que estaba a medio kilómetro de distancia. Se está preparando otro experimento en la que un microcontrolador basado en un microprocesador se activa simplemente al sostenerlo en el aire.

Tentzeris señaló que la explotación de una amplia gama de bandas electromagnéticas aumenta la fiabilidad de los dispositivos de barrido de energía, porque si uno se desvanece en un rango de frecuencia de forma temporal debido a las variaciones de uso, el sistema aún puede explotar otras frecuencias.

Los investigadores también tomó nota de que el dispositivo de barrido puede ser usado solo o en combinación con otras tecnologías de generación o podría proporcionar una forma de copia de seguridad del sistema. Por ejemplo, si una batería o un paquete solar-colector falla completamente, la energía capturada podría permitir al sistema para transmitir una señal a través de un móvil, de socorro mientras también potencialmente podría mantener funcionalidades críticas.

Los investigadores están utilizando impresoras de inyección de tinta suministrada con nanopartículas de plata y / o otras nanopartículas en una emulsión para combinar sensores, antenas, y capacidades de barrido de energía de polímeros de papel o flexibles. Este enfoque permite que el equipo sirva para imprimir no sólo los componentes de RF y circuitos, sino también nuevos dispositivos sensores basados ??en nanomateriales como los nanotubos de carbono.

Cuando Tentzeris y su grupo de investigación iniciaron la impresión de inyección de tinta de las antenas en el año 2006, los circuitos basados ??en papel sólo funcionaban en las frecuencias de 100 a 200 MHz, recordó Rushi Vyas, un estudiante de posgrado del Tecnológico de Georgia trabajando en el proyecto.

«Ahora podemos imprimir circuitos que son capaces de funcionar a velocidades de hasta 15 GHz – 60 GHz si se imprime en un polímero», dijo Vyas en el comunicado. «Así que hemos visto una mejora de la frecuencia de operación de dos órdenes de magnitud».

Los investigadores dijeron que sensores inalámbricos autoalimentados podrían ser utilizados para productos químicos, calor , biología, detección de tensión para defensa e industria, RFID (identificación por radiofrecuencia) marcado para las tareas de fabricación y envío, y el seguimiento en muchos campos, incluyendo las comunicaciones y el uso de energía. Los investigadores creen que estos sensores autoalimentados, inalámbricos basados ??en papel pronto estará ampliamente disponible a un costo muy bajo.