Física

Física

En las últimas horas hemos visto a dos de los nombres más importantes en la tecnología de revelando el futuro de los chips para computadoras -ya sea intencionalmente o no.

Un documento filtrado de Intel muestra que la pautade compañía la para la siguiente generación de procesadores, que debe comenzar a rodar a principios del año que viene. Mientras tanto, IBM ha presentado su visión a largo plazo de la tecnología de procesamiento, comienza a trazar los desarrollos sin descubrir lo que viene después de silicio cuando se vuelva obsoleto. La compañía ha mostrado algunas de estas técnicas emergentes, que a menudo superan a sus equivalentes de silicio y se puede construir utilizando técnicas de producción similares.

En un documento filtrado reportados por X-bit Labs , Intel revela su hoja de ruta de productos para Ivy Bridge, la nueva generación de chips de computadora que se encontrará pronto en PCs y Macs. Ivy Bridge lleva a la compañía al rango de 22 nanómetros en los microprocesadores. Los chips más pequeños logran mayor frecuencia de procesamiento.

Ivy Bridge sinifica máquinas con cerca de 4 GHz de potencia de procesamiento, de acuerdo con el documento Top-of-the-line, el Intel Core i7 3.9 GHz contará con un diseño de cuatro núcleos, lo que significa que las distintas partes del chip puede trabajar de forma independiente. Esto es útil en software, como juegos, que pueden tener múltiples operaciones a la vez. El chip más bajo de gama, un diseño de Core i5, seguirá siendo de cuatro núcleos funcionando a 2,7 GHz, siendo bastante rápido para los estándares actuales.

Aunque estos chips utilizan una nueva tecnología conocida como Tri-Gate, todavía están basados en el silicio. El cofundador de Intel Gordon Moore escribió la célebre frase acerca de cómo el número de transistores en los chips de silicio se duplicaría aproximadamente cada dos años, y la tecnología en general ha seguido ese paso. Es tan consistente que la observación se conoce como Ley de Moore.

Mientras los fabricantes de chips están todavía investigando las profundidades a las que llegan en términos de mantener el número de transistores cada vez más reducidos, se llegará a ese límite muy pronto, dicen los expertos. Una vez que los circuitos se reduzcan a alrededor de siete nanómetros, los efectos cuánticos empiezan a suceder, y será imposible lograr chips más pequeños – no con silicio, de todos modos.

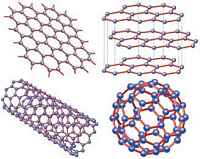

Mientras tanto, IBM presentó su plan a largo plazo, como se informó en el Wall Street Journal , para ir más allá de silicio y la toma del poder de procesamiento a nuevos niveles. La compañía está apostando en tres tecnologías: los nanotubos de carbono, el grafeno, y algo que llama «memoria de circuito.»

El primer enfoque implica el cambio de silicio en favor de carbono. IBM describe cómo la compañía ha construido un transistor hecho de nanotubos de carbono en el rango de 10 nanómetros. Además del pequeño tamaño atractivo, superó al silicio en varias métricas clave.

El grafeno, descubierto en 2004, ha sido aclamado como un nuevo tipo de sustancia se preguntan – a pesar de que es esencialmente una forma de carbono y, al igual que la punta del lápiz. El grafeno es el rey de lo pequeño – tiene sólo un átomo de espesor – y es altamente conductor. IBM construyó el primer circuito de grafeno a principios de este año, y ahora dice que se pueden construir chips de grafeno utilizando las líneas de producción por lo general utilizados para el silicio, que es un buen augurio para la producción masiva.

La memoria de circuito consiste en reemplazar la memoria flash, usado en todo desde iPhones a las tarjetas SD, con imanes microscópicos cambiado a lo largo de alambre pequeño bucles llamados nanocables. IBM ha demostrado esta técnica, también, que también se construye conlas líneas defabricación de productos normales.

¿Crees que tu equipo es lo suficientemente rápido? Eso está muy bien, pero hay un montón de aplicaciones para las tecnologías emergentes que están deseando más avances en potencia de procesamiento. Los juegos como Call of Duty: Modern Warfare 3 empujan las máquinas de hoy a sus límites, y la visión de los desarrolladores sólo está limitado por la potencia de procesamiento de las máquinas.

Además, el campo entero de la computación cuántica y hypercomputing dependen de la toma de potencia de procesamiento a niveles hasta ahora desconocidos. La propia IBM tiene grandes planes para las nuevas plataformas que surgen de su muy publicitado proyecto Watson , y aquellos que necesitan la potencia de procesamiento avanzadas.

Mientras que el futuro de las computadoras es todavía incierto, en definitiva, los fabricantes de chips están trabajando frenéticamente para asegurarse de que no llegan a un punto muerto.

Fuente: mashable Tech

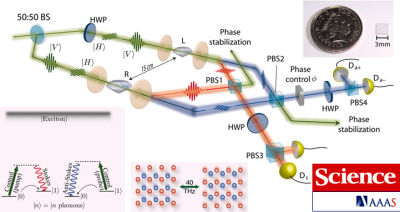

Un par de cristales de diamante ha sido relacionados mediante el entrelazamiento cuántico. Esto significa que una vibración en los cristales no podría ser significativamente asignada a uno u otro de ambos, los cristales eran al mismo tiempo vibrantes y no vibrantes. El entrelazamiento cuántico – la interdependencia de los estados cuánticos entre partículas que no están en contacto físico – ha sido bien establecida entre las partículas cuánticas como los átomos ultrafríos. Pero como la mayoría de los efectos cuánticos, que no tienden a sobrevivir ya sea a temperatura ambiente o en objetos lo suficientemente grandes como para percibirlos a simple vista. Los diamantes han sido vinculados con el entrelazamiento cuántico – «acción fantasmal a distancia».

Un equipo dirigido por Ian Walmsley, físico de la Universidad de Oxford (Reino Unido), encontró una manera de superar las limitaciones, lo que demuestra que las consecuencias extrañas de la teoría cuántica se aplican a gran escala, así como en las más pequeñas. El trabajo se ha publicado en Science . El resultado es «inteligente y convincente», dice Andrew Cleland, un especialista en el comportamiento cuántico de los objetos a escala nanométrica en la Universidad de California en Santa Bárbara (EE.UU.).

Entrelazamiento

El entrelazamiento se produce cuando dos partículas cuánticas interactúan entre sí para que sus estados cuánticos se vuelven interdependientes. Si está la primera partícula en el estado A, por ejemplo, entonces el otro debe estar en el estado B, y viceversa.

Hasta que lse efectúa a medición de una de las partículas, su estado es indeterminado: puede ser considerado como en los dos estados A y B al mismo tiempo, esto se conoce como una superposición. El acto de medir ‘colapsa’ esta superposición en uno sólo de los estados posibles.

Sin embargo, si las partículas se entrelazan, entonces esta medida también determina el estado de la otra partícula – incluso si han sido separadas por una distancia inmensa. El efecto de la medida se transmite instantáneamente a la otra partícula, a través de lo que Albert Einstein con escepticismo llamó «acción fantasmal a distancia».

Extraño, ya que el entrelazamiento cuántico es real – y podría ser útil. En una técnica llamada criptografía cuántica, los fotones entrelazados de luz se han utilizado para transmitir información de tal manera que cualquier intercepción es detectable. Los estados cuánticos entrelazados de los átomos o fotones pueden ser utilizados en la computación cuántica. Los estados superpuestos codifican mucha más información que la que es posible con el sistema convencional de bit de dos estados .

Sin embargo, superposiciones y entrelazado son usualmente vistos como estados delicados, fácilmente perturbados por movimientos al azar de los átomos en un ambiente cálido. Esta codificación también tiende a ocurrir muy rápidamente, si los estados cuánticos contienen muchas partículas que interactúan – en otras palabras, para objetos grandes.

Fotones y fonones

Walmsley y colaboradores han estudiado las vibraciones atómicas sincronizadas llamadas fonones en el diamante. Los fonones son movimientos ondulatorios de átomos en una red, algo así como las ondas de sonido en el aire, y se producen en todos los sólidos. Pero en el diamante, la rigidez de la red significa que los fonones tienen frecuencias y energía muy altas, y por lo tanto habitualmente no activos, incluso a temperatura ambiente.

Los investigadores utilizaron un pulso láser para estimular las vibraciones de fonones en dos cristales de tres milímetros de ancho y a 15 centímetros de distancia. Cada fonón implica la vibración coherente de unos 10^16 átomos, que corresponde a una región del cristal de 0.05 milímetros de ancho y 0.25 milímetros de largo – lo suficientemente grande como para verla a simple vista.

Hay tres condiciones esenciales que se deben cumplir para obtener los fonones entrelazados en los dos cristales de diamante. En primer lugar, un fonón debe ser excitado con un solo fotón de la corriente de fotones del láser. En segundo lugar, este fotón debe ser enviado a través de un «divisor de haz» que lo dirige a un cristal o al otro. Si la ruta no es detectada, entonces el fotón puede ser considerado en ambos sentidos a la vez: está en una superposición de trayectorias. El fonón resultante se entrelaza demasiado en una superposición. La tercera condición es que el fotón debe convertir parte de su energía en un fotón de menor energía, denominada fotón Stokes, que indica la presencia de los fonones.

«Cuando se detecta el fotón Stokes sabemos que hemos creado un fonón, pero no podemos saber ni siquiera en principio en que diamante se encuentra», dice Walmsley. «Este es el estado entrelazado, para el que la declaración: este diamante está vibrando, este diamante no está vibrando es verdadera».

Para verificar que el estado se ha logrado, los investigadores lanzan un segundo pulso láser a los dos cristales para ‘extraer’ los fonones, de los que el fotón láser extrae energía adicional. Todas las condiciones necesarias se cumplen muy pocas veces durante el experimento. «Tienen que realizar un número astronómico de intentos de obtener un número muy limitado de resultados deseados», dice Cleland.

Duda de que habrá alguna aplicación inmediata de la técnica, en parte porque la relación es muy corta. «No estoy seguro de que esto va a salir de aquí», dijo Cleland. «No puedo pensar en un uso particular de entrelazamientos que duran sólo unos pocos picosegundos» (10^-12 segundos).

Pero Walmsley es más optimista. «El diamante podría ser la base de una poderosa tecnología para el procesamiento de información cuántica práctica», dice. «Las propiedades ópticas del diamante hacen que sea ideal para la producción de pequeños circuitos ópticos en los chips.»

La empresa noruega FXI technologies mostró un prototipo de memoria USB del tamaño de una llave electrónica (pendrive), con una CPU de núcleo doble a 1.2 GHz ARM de Samsung Exynos (igual que en el teléfono móvil celular Galaxy S II), Wi-Fi 802.11n, Bluetooth, HDMI- y una ranura para tarjetas microSD para memoria. Con nombre en código Cotton Candy (dulce de algodón) por sus 21 gramos, el PC permite lo que su inventor denomina «Cualquier Informática de la pantalla,» la capacidad de convertir cualquier televisor, ordenador portátil, teléfono, tableta en un terminal «tonto» de su sistema operativo Android.

Tiene un conector USB 2.0 en un extremo y un conector HDMI en el otro. Cuando se conecta a una televisión de alta definición, utiliza el puerto HDMI para vídeo, el cable USB para la alimentación eléctrica, y Bluetooth para conectarse a un teclado, un ratón o tableta, para controlar el sistema operativo. El dispositivo admite una resolución de hasta 1080 p por lo que incluso una pantalla Full HD puede mostrar el sistema operativo preinstalado en su resolución nativa el Candy Android 2.3. La CPU de doble núcleo es lo suficientemente potente como para reproducir vídeo a 1080 p y vídeos de alta definición desde la web. Obtenga más información en el vídeo a continuación.

Ampliar información en: FXI Technologies/a>

El paralelismo es una forma de computación basada en un principio aparentemente simple: dividir los problemas grandes en varios pequeños y solucionarlos simultáneamente, lo que permite ejecutar más instrucciones en menos tiempo. Pero llevado a la práctica es una cuestión compleja en la que se encuentran investigando grupos científicos de todo el mundo.

“El problema que pretendemos resolver es que los ordenadores de hoy en día han dejado de ser cada vez más rápidos y, los fabricantes, en vez de hacer un único microprocesador más avanzado, que tiene unos consumos muy elevados, lo que hacen es poner dos, cuatro o más, incluso 80 en algunos ordenadores experimentales”, detallan los investigadores Diego Llanos y Arturo González (Universidad de Valladolid). Esto ha sido posible gracias a una mejora en la tecnología de fabricación, que ha posibilitado una reducción en el tamaño de los elementos que componen estos microprocesadores y, por tanto, que se puedan incluir más dispositivos en la misma área.

“En lugar de introducir un microprocesador se colocan varios, juntos, para consumir menos. El problema es cómo sacarle partido a varios núcleos, ya que los microprocesadores funcionan de manera secuencial, es decir, si tienen que ejecutar un único programa y con un núcleo alcanza, el resto no hace nada”, explican.

Se trata, pues, de una “cuestión de eficiencia”. “Nosotros trabajamos en paralelización de algoritmos. Aprovechar dos núcleos es posible, pero cuando se habla de 4, 8, 16, etc, si se tiene una sola aplicación de cálculo intensivo, la cuestión es cómo aprovecharlos, es decir, qué hacer para que realmente funcionen todos a la vez”, subrayan. La resolución de este problema ocupa a la comunidad científica internacional, que está intentado obtener “una versión paralela que distribuya la tarea entre todos los obreros y por tanto aprovechar de forma automática un programa que ahora es secuencial, que primero hace una tarea y luego otra”.

Ampliar información en: sinc

La basura electrónica (e-basura) de los países ricos se recicla en los países más pobres, donde causa gran contaminación y pone en peligro la salud de sus habitantes, según un estudio publicado este domingo.

Los envíos al extranjero de basura electrónica están prohibidos por acuerdo internacional, sin embargo empresarios «sin escrúpulos» envían muchos de estos residuos a África y Asia en contenedores de carga, junto con equipos nuevos, cuya importación y exportación sí está permitida.

Las pruebas realizadas en una escuela cercana a un depósito de residuos electrónicos en el suburbio de Agbogbloshie a las afueras de Accra, capital de Ghana, revelaron unacontaminación por plomo, cadmio y otros contaminantes perjudiciales para la salud de más de 50 veces por encima de los niveles libres de riesgo.

Por otra parte el valor de los elementos de los residuos electrónicos y el gran número de personas que trabajan en el reciclaje informal «dificulta cada vez más acabar con ese lugar», ya que «el sustento de muchas personas depende ahora de los ingresos generados por estas actividades».

La ONU, organismos de EE UU y empresas informáticas se han unido a la iniciativa para acabar con la e-basuraSe calcula que, por ejemplo, 100 000 teléfonos móviles pueden contener unos 2.4 kilos de oro, equivalentes a 130 000 dólares, más de 900 kilos de cobre, valorados en 100 000 dólares, y 25 kilos de plata igual a 27 300 dólares.

Ampliar información en: 20Minutos.es

Bajo licencia Creative Commons

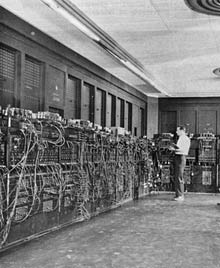

Julius Blank, un ingeniero mecánico,que fue uno de los fundadores de una empresa fabricante de chips para ordenador en la década de 1950, que se convirtió en prototipo de alta tecnología, innovación y campo de entrenamiento para una generación de empresarios de Silicon Valley, murió el sábado en Palo Alto, California (EE.UU.). Tenía 86 años.

Blank fue uno de los ocho científicos de la computación, que en 1957 fundaron la influyente empresa de Palo Alto Fairchild Semiconductor Corporation. Él fue uno de los dos en el grupo que tenía experiencia en fabricación.

Así que después de la investigación inicial de los científicos, para encontrar una manera barata de fabricar chips de silicio mediante un equipo específico avanzado, convenció a un inversionista para una participación con US $ 1,5 millones. La tarea de construir la maquinaria para producirlos en masa correspondió a Blank y al ingeniero Eugene Kleiner.

Las dos partes consiguieron un equipo improvisado y fabricaron un conjunto de máquinas que, en esencia se convirtieron en la primera línea de montaje de los elementos básicos del mundo de la electrónica: circuitos electrónicos que se fabrican a partir de obleas de silicio o chips de silicio.

Blank y sus socios – que incluían a Robert N. Noyce y Gordon E. Moore, los futuros fundadores de la Corporación Intel – comenzón su aventura como el científico de la empresa, a raíz de un motín en contra de su previo empleador común, el ganador del Nobel de física, William B. Shockley.

El dr. Shockley, se convirtió en un pararrayos para las tensiones raciales años después, cuando abogó por la eugenesia (genética), había reclutado a los ocho científicos de todo el país en 1956 para trabajar en su laboratorio de semiconductores, en las inmediaciones de Montain View, California

El grupo abandonó en masa al año siguiente por lo que sus miembros describne como estilo de gestión autoritaria del Dr. Shockley y sus diferencias con él sobre su enfoque científico. Shockley lo consideró una traición.

Los fundadores de Fairchild llegaron a ser conocidos en la tradición de Silicon Valley como los «ocho traidores». Cómo ocurrió eso, sigue siendo un misterio. «Nunca pude localizarlo», dijo Brock, el autor de la historia de la compañía. Sin embargo, el epíteto, siempre que sea su procedencia, se unió a sus nombres en casi todas las noticias del éxito de la compañía durante años.

Blank, en una entrevista con The San Jose Mercury News, dijo que nunca había traicionadoal Dr. Shockley. Pero, añadió, «Una vez que llegó a publicarse, es difícil de borrar.»

Julius Blank y los demás componentes del grupo de los ocho traidores demostraron ser unos auténticos emprendedores de los que nacieron grandes empresas como Fairchild, Intel, Advanced Micro Devices y National Semiconductor, grandes compañías tecnológicas que aún siguen teniendo su hueco en el sector tecnológico.

Los ingenieros de la Universidad de California, Berkeley (EE.UU.) , han demostrado que es posible reducir la tensión mínima necesaria para almacenar la carga en un condensador, un logro que podría reducir el consumo de energía y la generación de calor de los actuales dispositivos electrónicos.

En la imagen se muestra una versión experimental de una pila hecha con una capa de titanato de plomo y zirconio, un material ferroeléctrico. Investigadores de UC Berkeley demostraron que esta configuración podría amplificar la carga en la capa de titanato de estroncio, un aislante eléctrico, para un determinado voltaje, un fenómeno conocido como capacidad negativa. (Imagen Asif Khan)

Los investigadores han presentado una demostración que prueba el concepto de efecto negativo de capacidad en una escala nanométrica en una heteroestructura ferroeléctrico-dieléctrico. En una bicapa de ferroeléctricos Pb (Zr0.2Ti0.8) O3 y el dieléctrico SrTiO3, la capacidad del compuesto se observó era superior que la del constituyente SrTiO3, lo que indica una capacidad efectiva negativa del constituyentes Pb(Zr0.2Ti0.8)O3 . La temperatura se muestra como un parámetro de ajuste efectivo de la capacidad ferroeléctrica negativa y el grado de mejora de capacidad en la heteroestructura. Los cálculos basados en la teoría del campo medio de Landau muestran un acuerdo cualitativo con los efectos observados. Este trabajo sostiene la posibilidad de que mediante la sustitución de las puertas de óxido por ferroeléctricos en transistores a nanoescala, la pendiente puede descender por debajo del umbral límite clásico (60 mV / década).

El equipo publicó sus resultados el 12 de septiembre ne la revista Applied Physics Letters. El experimento prepara el escenario para una importante actualización de los transistores, el interruptor de encendido y apagado que genera los ceros y unos del lenguaje binario de los ordenadores.

«Este trabajo es la prueba del principio que es necesario para llevar adelante la capacidad negativa como una estrategia viable para superar el consumo de energía de los actuales transistores», dijo Salahuddin, el primero que teorizó la existencia de capacidad negativa en materiales ferroeléctricos, como estudiante de posgrado con el profesor de ingeniería Supriyo Datta en la Universidad de Purdue (EE.UU.). «Si podemos usar esto para crear transistores de bajo consumo de energía sin comprometer el rendimiento y la velocidad con la que trabajan, se podría cambiar la industria de la informática general.»

Los investigadores han emparejado un material ferroeléctrico, titanato de plomo y zirconio (PZT), con un aislante dieléctrico, titanato de estroncio (STO), para crear una pila de dos capas. El voltaje se aplica a esta estructura PZT-STO, así como a una capa de STO sola, y se compara la cantidad de carga almacenada en ambos dispositivos.

«Hubo una caída de tensión en espera de obtener una carga específica con el material dieléctrico», dijo Salahuddin. «Pero con la estructura ferroeléctrica, hemos demostrado una mejora de la tensión de dos veces con la carga con el mismo voltaje, y que el aumento podría ser mucho más elevado.»

La solución propuesta por Saladino y su equipo consiste en modificar los transistores actuales para que incorporen materiales ferroeléctricos en su diseño, un cambio que podría generar una carga mayor de un voltaje menor. Esto permitirá a los ingenieros hacer un transistor que disipe menos calor.

En particular, el sistema con el material que los investigadores de UC Berkeley informaron, muestra este efecto por encima de 200 grados Celsius, mucho más caliente que los 85 grados a que trabajan los actuales microprocesadores.

Los investigadores ahora están explorando nuevos materiales ferroeléctricos para capacidad negativa a temperatura ambiente, además de la incorporación de los materiales en un nuevo transistor

Hasta entonces, Salahuddin señala que existen otras posibles aplicaciones en la electrónica para los ferroeléctricos. «Este es un buen sistema para memorias dinámicas de acceso aleatorio, dispositivos de almacenamiento de energía, súpercondensadores que impulsen los coches eléctricos y condensadores de potencia para su uso en comunicaciones de radio frecuencia».

Fuente: Experimental evidence of ferroelectric negative capacitance in nanoscale heterostructures

Los investigadores, por primera vez, han mostrado que la eficiencia energética de los ordenadores se duplica aproximadamente cada 18 meses.

La conclusión, respaldada por seis décadas de datos, refleja la ley de Moore, debido a observación del fundador de Intel Gordon Moore de que el poder de procesamiento del equipo se duplica cada 18 meses. Sin embargo, la tendencia de consumo de energía podría tener una mayor relevancia que la ley de Moore en dispositivos como, teléfonos, tabletas, y los sensores, que han proliferado recientemente.

En julio, Koomey dio a conocer un informe que mostró, entre otras conclusiones, que la electricidad utilizada en los centros de datos en todo el mundo aumentó en un 56 por ciento entre 2005 2010, una tasa mucho más baja que la duplicación que se observa desde 2000 a 2005.

Mientras que una mayor eficiencia energética juega un papel importante en este cambio, el total de la electricidad utilizada en los centros de datos era menor que el previsto para 2010 debido en parte a que un menor número de servidores se instalaron frente a lo esperado, debido a las tecnologías como la virtualización, que permite a los sistemas existentes para ejecutar más programas al mismo tiempo. Koomey señala que los ordenadores del centro de datos rara vez funcionan a máxima potencia. La mayoría de los ordenadores son, de hecho, «tremendamente infrautilizados», afirmó.

Para Koomey, el aspecto más interesante de la tendencia es pensar en las posibilidades de la informática. Los límites teóricos están todavía muy lejos. En 1985, el físico Richard Feynman analizó las necesidades de electricidad para las computadoras y se estima que la eficiencia teóricamente podría mejorar en un factor de cien mil millones antes de que llegara un límite, con exclusión de las nuevas tecnologías como la computación cuántica. Desde entonces, la mejora de eficiencia han sido alrededor de 40000. «Hay que ir muy lejos», dice Koomey. «Está sólo limitado por nuestra inteligencia, no por la física.

Ampliar información en: technology review MIT

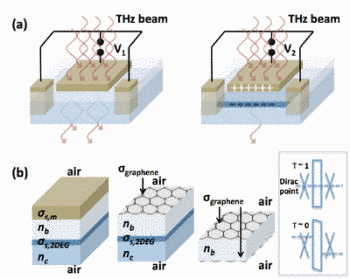

La profundidad de la modulación en moduladores de THz basados en gas de electrones 2-D (2DEG) utilizando heteroestructuras de AlGaAs / GaAs con puertas metálicas está de por sí limitada a menos del 30%. La puerta de metal no sólo atenúa la señal de THz (más del 90%), sino que también degrada severamente la profundidad de modulación. Las pérdidas en el metal pueden reducirse significativamente con un material alternativo que tenga una conductividad ajustable. El grafeno presenta una solución única a este problema debido a su estructura de bandas simétricas y movilidad extraordinariamente alta de los huecos, que es comparable a la movilidad de los electrones en semiconductores convencionales. La conductividad de huecos en el grafeno puede ser sintonizada electrostáticamente en la configuración de condensadores paralelos de grafeno-2DEG, modulando de manera más eficiente la transmisión a frecuencia de THz. En eltrabajo, se demuestra que es posible alcanzar una profundidad de modulación de más del 90%, mientras que al mismo tiempo se minimiza la atenuación de la señal a menos del 5%, mediante la regulación del nivel de Fermi en el punto de Dirac en el grafeno.

A) Principio de funcionamiento de un modulador de THz basado en 2DEG. La transmisión de THz a través de un medio (2DEG) se modula con un voltaje aplicado entre la puerta superior y la 2DEG. La transmisión a THz es alta, con bajas densidades de 2DEG, y baja con altas densidades de 2DEG, debido a la absorción y reflexión. (B) Estructuras de capas tradicionales de metal-puerta/2DEG y grafeno/2DEG y propuestas de grafeno / grafeno para moduladores a THz. La muestra en el cuadro son los diagramas esquemáticos de bandas de energía de un modulador de grafeno / aislante / grafeno que promete cerca de cero atenuación del haz de y profundidad de modulación unidad. Cuando el nivel de Fermi está en el punto de Dirac de las capas de grafeno, tanto la superior como la inferior, la transmisión de THz se aproxima a la unidad, cuando las láminas de electrones y de huecos de cargas se forman en las capas de grafeno superior e inferior, la transmisión de THz se acerca a cero.

En conclusión, se ha presentado un estudio analítico sobre los límites actuales de rendimiento moduladores a THz basados en 2DEG, y cómo la incorporación de grafeno como puerta de ‘metal ajustable’ que promete mejoras significativas en el rendimiento. En las estructuras propuestas anteriormente metal/AlGaAs/2DEG/GaAs, la profundidad de modulación máxima es de por sí limitada a menos del 30% por el efecto adverso de la puerta de metal de alta conductividad, así como la conductividad máxima alcanzable de la lámina 2DEG. Una monocapa de grafeno puede ser casi transparente, cuando su nivel de Fermi se sintoniza en el punto de Dirac y bloquea casi todo el haz de THz cuando se ajusta a su máxima conductividad, lo cual es extraordinario en comparación con cualquier otro sistema 2DEG. Mediante la adopción de grafeno en moduladores 2DEG a THz, la atenuación del haz es baja y despreciable y profundidad de modulación próxima a la unidad es alcanzable, proporcionando ventajas incluyendo RT, banda ancha, y polarización independiente de la operación.

Fuente: Next Big Future