Física

Física

Los investigadores están estudiando la ciencia de «dispositivos nanoplasmónicos» cuyos componentes clave son pequeñas estructuras de metal a nanoescala, más de 1 000 veces más pequeños que el tamaño de un cabello humano, que guían y dirigen la luz.

La información es sistemáticamente ordenada y dirigida en diferentes direcciones para permitir la computación, conexiones a internet o conversaciones telefónicas. En la actualidad, sin embargo, la información de los ordenadores se procesa mediante la codificación de señales eléctricas. Sería mucho más rápida de procesar y transmitir información en forma de luz en lugar de señales eléctricas, pero hasta ahora, ha sido difícil para los rayos de luz «ser cambiados’, que es interactuar con otros rayos de luz, durante el viaje través de un material.

Los científicos han resuelto esto con el diseño de un nuevo material artificial, que permite a los rayos de luz interactuar de manera eficiente y cambiar de intensidad, por lo tanto permitiendo que la información sea ordenada por haces de luz a una velocidad muy alta. La estructura del material a la medida es similar a una pila de barras de escala nanométrica, a lo largo de la cual la luz puede viajar y lo más importante interactuar.

Profesor Anatoly Zayats, en el Departamento de Física en el King’s, explica: «Si fuéramos capaces de controlar un flujo de luz en la misma forma que el control de un flujo de electrones en los chips de computadora, se puede construir una nueva generación de máquinas procesadoras de datos, que sería capaz de hacer frente a enormes cantidades de información mucho más rápido que las computadoras modernas.

«El nuevo material que hemos desarrollado, a menudo llamados» metamateriales «, se podría incorporar en los actuales chips electrónicos para mejorar su rendimiento, o utilizarse para construir chips totalmente ópticos completamente nuevos y por lo tanto revolucionar la velocidad de procesamiento de datos.

«Mientras que hay muchos retos que superar, nos anticipan que en el futuro esta tecnología podría estar en nuestro PC, teléfonos móviles, aviones y automóviles, por ejemplo.»

Otros miembros del equipo involucrado en esta última investigación incluyen el Laboratorio Nacional Argonne en EE.UU., la Universidad del Norte de Florida, la Universidad de Massachusetts en Lowell, y la Queen’s University de Belfast en el Reino Unido.

La investigación se publica en la revista Nature Nanotechnology .

En el estudio, los físicos Joan Vaccaro de la Universidad Griffith de Queensland, Australia, y Stephen Barnett, de la Universidad de Strathclyde en Glasgow, Reino Unido, han descrito cómo la información cuantitativa se pueden borrar sin consumo de ningún tipo de energía. Su trabajo se ha publicado en una edición reciente de Proceedings of the Royal Society A.

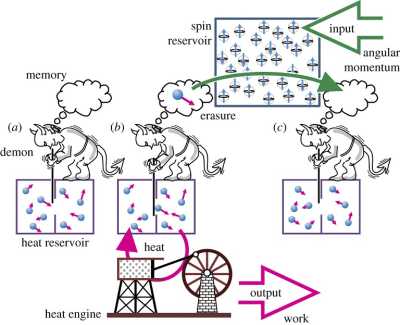

El demonio de Maxwell puede extraer trabajo de un solo reservorio de calor a costo de momento angular de espín. En el paso (a), el demonio no tiene memoria y el gas en el reservorio de calor está en equilibrio térmico. En el paso (b), el demonio divide el reservorio en dos, atrapando las moléculas de mayor movimiento en el lado derecho, y utiliza un ingenio de calor entre las dos particiones para obtener trabajo. En el paso (c), la memoria del demonio se borra usando un reservorio de espín y a las dos particiones se les permite regresar al equilibrio. Crédito de la imagen: Joan A. Vaccaro, et al. Fig. 1. © 2011 Royal Society.

Tradicionalmente, el proceso de borrado de información requiere de un costo que se calcula en términos de energía – disipación de calor más concretamente. En 1961, Rolf Landauer argumentó que había una cantidad mínima de energía necesaria para borrar un bit de información, es decir, poner un bit en el estado lógico cero. La energía necesaria se relaciona positivamente con la temperatura del reservorio del sistema térmico, y puede considerarse como la entropía termodinámica del sistema. Como tal, esta entropía se considera un costo fundamental para borrar un bit de información.

Sin embargo, Vaccaro y Barnett han demostrado que un gasto de energía puede ser totalmente evitado mediante el uso de un depósito basado en algo distinto de la energía, tal como momento angular de espín. Las partículas subatómicas tienen momento angular de espín, una cantidad que, como la energía, debe ser conservado. Básicamente, en vez de calor que se intercambia entre un qubit y el reservorio térmico, cuantos discretos de momento angular se intercambian entre un qubit y el reservorio de espín. Los científicos describen cómo repetidas operaciones lógicas entre el espín del qubit y un espín secundario en el estado cero eventualmente da lugar a que ambos espines alcancen el estado lógico cero. Más importante aún, los científicos demostraron que el costo de borrar la memoria del qubit se da en términos de la cantidad que define los estados lógicos, que en este caso es el momento angular de espín y no la energía.

Los científicos explicaron que experimentalmente la realización de este esquema sería muy difícil. Sin embargo, sus resultados muestran que las leyes físicas no impiden borrar la información con un coste energético cero, lo que es contrario a los estudios anteriores. Los investigadores observaron que, en la práctica, será especialmente difícil garantizar la degeneración del sistema de energía (que los diferentes estados de espín del qubit y el reservorio tienen exactamente el nivel de energía). Pero incluso si las condiciones son imperfectas y causan la pérdida de energía, no hay razón fundamental para asumir que el costo será mayor que lo predicho por la fórmula de Landauer.

La posibilidad de borrar la información sin necesidad de utilizar la energía tiene implicaciones para diversas áreas. Un ejemplo es la paradoja del demonio de Maxwell, que parece ofrecer una forma de violar la segunda ley de la termodinámica. Al abrir y cerrar una puerta para separar las moléculas calientes y frías, el demonio supuestamente extrae trabajo del depósito, la conversión de todo el calor en energía mecánica útil. La resolución de Bennett de la paradoja en 1982 sostiene que la memoria del demonio tiene que ser borrada para completar el ciclo, y el costo de eliminación es por lo menos tanto como la energía liberada. Sin embargo, los resultados de Vaccaro y Barnett sugiere que la memoria del demonio se pueden borrar sin costo de energía mediante el uso de otro tipo de depósito, donde el costo sería en términos del momento angular de espín. En este esquema, el demonio puede extraer toda la energía de una reserva de calor como energía útil a un costo de otro recurso.

Como explicaron los científicos, este resultado no se contradice con las afirmaciones históricas de la segunda ley de la termodinámica, que están exclusivamente en el contexto de reservorios de calor y térmicos, y no permiten una clase más amplia de reservorios. Por otra parte, a pesar de que el ejemplo con el demonio de Maxwell sugiere que el trabajo mecánico se puede extraer a un costo cero de energía, esta extracción se asocia con un aumento en la entropía de la información teórica del sistema en general.

«La maximización de la entropía sujeta a una restricción es necesario aplicar no sólo para calentar los reservorios y la conservación de la energía», explicó Vaccaro a PhysOrg.com.

Los resultados también podrían aplicarse a hipotéticos motores de calor de Carnot, que operan con la máxima eficacia. Si estos motores utilizan depósitos de momento angular en lugar de depósitos térmicos, podrían generar esfuerzos de momento angular en lugar de trabajo mecánico.

Para demostrar el concepto de borrar información a un coste energético cero, los científicos dijeron que se necesitarían más investigaciones y tiempo.

Añadió que el resultado es de importancia fundamental, y no es probable que tenga aplicaciones prácticas para dispositivos de memoria. «No vemos esto como que tenga un impacto directo en términos de aplicaciones prácticas, ya que el coste energético actual de la supresión de información está próximo al teórico de Landauer «, dijo. «Es más un caso de lo que dice acerca de conceptos fundamentales. Por ejemplo, Landauer, dijo que la información es física, porque se necesita energía para borrarla. Estamos diciendo que la razón es física, tiene un contexto más amplio que eso. »

AMpliar información en: Joan A. Vaccaro and Stephen M. Barnett. “Information erasure without an energy cost.” Proceedings of the Royal Society A.DOI:10.1098/rspa.2010.0577

El núcleo es la parte del equipo, de la unidad central de procesamiento (CPU), que lee y ejecuta las instrucciones. Originalmente, los ordenadores se desarrollaron con un único procesador por núcleo único , pero, actualmente los procesadores con dos, cuatro o incluso dieciséis núcleos son comunes.

Sin embargo, el Dr. Wim Vanderbauwhede y sus colegas de la Universidad de Massachusetts Lowell (EE.UU.) han creado un procesador que de hecho contiene más de un millar de núcleos en un solo chip.

Para ello, los científicos utilizaron un chip llamado Field Programmable Gate Array (FPGA), que como todos los microchips contiene millones de transistores – los pequeños interruptores de encendido y apagado que están en la base de cualquier circuito electrónico.

FPGA se pueden configurar en circuitos específicos del usuario, en lugar de tener su función fijada en una fábrica, lo que permitió el Dr. Vanderbauwhede dividir los transistores dentro del chip en pequeños grupos y programar cada uno para realizar una tarea diferente.

Mediante la creación de más de 1000 mini-circuitos en el chip FPGA, los investigadores han convertido de hecho el chip en un procesador 1000 núcleos, con cada núcleo de trabajo dotado de sus propias instrucciones.

Luego, los investigadores utilizaron el chip para procesar un algoritmo que es fundamental para el formato de película MPEG – utilizado por ejemplo en los vídeos de YouTube – a una velocidad de cinco gigabytes por segundo: en torno a 20 veces más rápido que los actuales ordenadores de escritorio.

El Dr. Vanderbauwhede dijo: «los FPGAs no se utilizan en ordenadores estándares, ya que son bastante difíciles de programar, pero su poder de procesamiento es enorme, mientras que su consumo de energía es muy pequeño debido a que son mucho más rápidos – así que también son una opción más verde».

Aunque la mayoría de ordenadores vendidos hoy en día ya contienen más de un núcleo de procesamiento, lo que les permite llevar a cabo procesos diferentes al mismo tiempo, los tradicionales procesadores multinúcleo debe compartir el acceso a una fuente de memoria, lo que ralentiza el sistema.

Los científicos en esta investigación fueron capaces de hacer el procesador más rápido, dotando a cada núcleo de una cierta cantidad de memoria dedicada.

El Dr. Vanderbauwhede, que espera presentar su investigación en el Simposio Internacional sobre Computación Reconfigurable Aplicada, en marzo de 2011, agregó: «Esto es una prueba muy inicial de concepto de trabajo en el que estamos tratando de demostrar una manera conveniente de programar FPGAs, que por su potencial para proporcionar potencia de procesamiento muy rápida podría ser utilizado mucho más ampliamente en la computación y la electrónica del futuro».

«Si bien muchas de las tecnologías existentes en la actualidad hacen uso de FPGAs, incluyendo televisores de plasma y LCD y routers de redes informáticas, se limita su uso en computadoras de escritorio estándares.

«Sin embargo, ya estamos viendo algunos microchips que combinan las CPUs tradicionales con chips de FPGA que se anuncian por los desarrolladores, incluyendo Intel y ARM.

Creo que estos tipos de procesadores sólo se harán más comunes y ayudan a acelerar las computadoras aún más en los próximos años. »

Fuente: PHYSORG.COM

__________________

Enlaces de interés:

– ¡La informática en un garaje! 1971 – 1976

– Apuntes Informática Aplicada al Trabajo Social. Ordenadores en la actualidad

Durante el año pasado se presentarone un par de dispositivos que prometían “cargar las baterías” de nuestros teléfonos móviles etc. sin tener que conectarlos a la electricidad, todo por medio de inducción electromagnética, ¿el problema?, actualmente necesitamos utilizar un “aditamento” en cada uno de los dispositivos que quisiéramos cargar. Caso típico de una publicidad engañosa de un cargador por inducción para teléfonos móviles celulares, que aparece estos días en televisión.

Obviamente este aditamento implica un aumento en la masa y dimensiones, por ejemplo, de nuestro smartphone, algo poco práctico si lo que se quiere es no tener la necesidad de “poner y quitar” cables, en base a eso, dos empresas están trabajando seriamente en el tema, esas compañías son Fulton innovation y eCoupled, cuyos avances se han podido ver en el CES.

Se indica que la transferencia de energía es un 98% eficaz y que primeras versiones de esta tecnología ya se han puesto en marcha, por ejemplo, en la Dell Latitute Z, esta tecnología básicamente funciona de manera similar a los accesorios que les comentaba anteriormente, la ventaja es que se intenta adoptar como un estándar y así evitar el “agregar aditamentos” pues los dispositivos ya vendrían con compatibilidad integrada con este sistema de transferencia de energía.

Empresas comoe Dell, Energizer, Bosch y Motorola, entre otras, son las que actualmente forman parte de los socios de ecoupled, quien sueña que en un futuro no muy lejano podamos ver casas, oficinas y negocios “sin cables”, el sueño de muchas personas que podría volverse una realidad, siempre que la industria esté dispuesta adoptar el sistema como un estándar .

Fuente: Tech Radar

Fujitsu Laboratories ha anunciado el desarrollo de una tecnología que permite la fabricación de transistores de fuentes de alimentación en casi cualquier superficie plana, incluyendo vidrio, plástico o cobre.

Esta innovación ha sido posible, gracias a la distribución de alta tensión, mediante la formación de un transistor de gran potencia que ha sido diseñado a partir de óxido de zinc (ZnO) y a la protección de este, con una capa de polímero.

La nueva tecnología permitirá a los circuitos de alimentación de energía, ser fabricados en una amplia gama de superficies planas, lo cual conlleva el desarrollo de numerosas aplicaciones potenciales. La presentación de esta gran innovación, se realizó en Boston, en la pasada Reunión de Otoño de Materials Research Society del 2010.

La elección, como material del oxido de zinc, es debido a sus características de semiconductor que puede ser utilizado como un transistor de alimentación con pocas pérdidas, ya que es un material que tiene un potencial para la creación de circuitos en cualquier superficie plana. En la actualidad se trabaja en la implantación de óxido de zinc sobre sustratos de vidrio, en superficies de cristal líquido de televisores y monitores.

En definitiva, los laboratorios de Fujitsu han sido capaces de producir un transistor de 100V para uso de fuente de alimentación a base de indio-galio-zinc-oxido (IGZO) como material y protegerlo bajo un capa de polímero. Esta solución permite que sea fabricado directamente sobre substrato de cobre que se utiliza como material de packaging, facilitando una mayor disipación del calor y, en consecuencia, reduciéndose los costos.

Fuente: diarioTi.com

________________

Enlaces relacionados:

– Fuentes de alimentación, para PC. Homologadas y compatibilidad CE

– Actualidad informática: Hardware

– Apuntes Informática Aplicada a la Gestión Pública. UMU. Calidad en informática

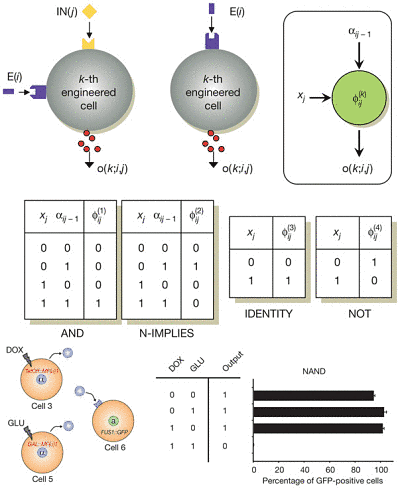

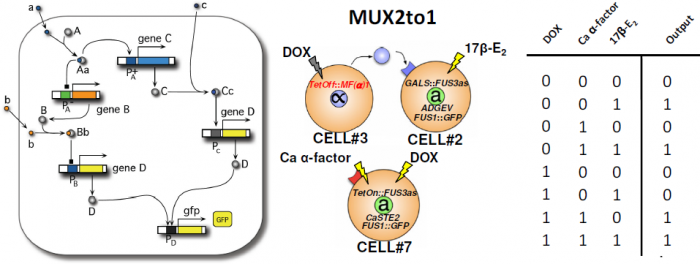

La biología sintética trata de diseñar sistemas biológicos complejos a base de combinar piezas (bioladrillos) que interactúan entre sí. El bioladrillo más obvio es una célula completa. Ricard Solé (Institut de Biologia Evolutiva, CSIC-UPF, Barcelona) y sus colegas han desarrollado un nuevo procedimiento para implementar circuitos lógicos combinacionales complejos utilizando puertas lógicas elementales implementadas mediante células de levadura modificadas por ingeniería genética. Células que actúan como puertas lógicas de tipo AND, NOT, o IMPLICA permiten construir otras puertas lógicas como NAND o NOR y circuitos lógicos de 2 o 3 entradas como un multiplexor MUX2-1 o un sumador de un bit con acarreo. El artículo técnico ha sido aceptado por Nature y promete iniciar una nueva era en la biología sintética, la era de la computación con circuitos combinacionales reprogramables y reusables gracias a “consorcios celulares.” El artículo técnico es Sergi Regot, Javier Macia, et al. “Distributed biological computation with multicellular engineered networks,” Nature, Published online 08 December 2010. Las aplicaciones futuras en biomedicina y bioingeniería son enormes, pero habrá que comprender mejor los problemas de escalabilidad, la robustez ante ruido, y los problemas de fan in y fan out de esta nueva técnica para implementar circuitos biológicos de lógica combinacional. Aún así, los resultados obtenidos hasta ahora son muy espectaculares.

La computación basada en consorcios celulares se basa en la idea de utilizar la comunicación intercelular en una población tanto entre células idénticas y células diferentes entre sí cuyo genoma ha sido modificado genéticamente aplicando técnicas de biología sintética. Cada célula responde a una o dos entradas posibles y puede producir una salida. Construyendo una pequeña librería de células que implementen ciertas puertas lógicas básicas (como las puertas AND o IMPLICA) se pueden construir circuitos más complejos que implementen una función booleana arbitraria. Cada célula responde a entradas externas y a moléculas mensajeras (que se producen en unas células, se difunden por el medio de cultivo y son recibidas por otras células). La mayoría de las funciones lógicas de 2 y 3 entradas se pueden construir con entre 2 y 5 células. Más aún, utilizando tres células se pueden implementar más de 100 funciones lógicas, y usando cuatro células mása de 200. Los investigadores han implementado in vivo puertas lógicas OR, NAND, XNOR, XOR y varios circuitos complejos, como un multiplexador MUX2to1 (que selecciona una entre dos entradas y dirige su valor a la salida) y un sumador de un bit con acarreo (que en serie permite construir un sumador de varios dígitos binarios).

Fuente: Francis (th)E mule Science’s News

________________________________

Enlaces de interés:

– Historia de la Informática. La era de la electrónica

– Actualidad informática: Electrónica

– Apuntes Informática Aplicada al Trabajo Social. UMU. Ordenadores en la actualidad

Investigadores de la Universidad Queen Mary de Londres (Reino Unido) y la Universidad de Friburgo (Suiza) han demostrado que una corriente polarizada magnéticamente puede ser manipulada por campos eléctricos.

Publicado esta semana en la revista Nature Materials, este importante descubrimiento abre la posibilidad de la combinación de memoria del ordenador y procesamiento en el mismo chip.

«Esto es especialmente emocionante, ya que este descubrimiento ha sido realizado con semiconductores orgánicos flexibles, que podrían dar lugar a la nueva generación de pantallas para dispositivos móviles, televisores y monitores de computadora, y podrían ofrecer un cambio radical en la eficiencia energética y reducir el peso de estos dispositivos, «dijo el Dr. Alan Drew, de la Escuela Queen Mary de Física, quien dirigió la investigación.

La «espintrónica» – giro de los electrones de transporte – se ha convertido rápidamente en la tecnología de uso universal para los discos duros de ordenador. Diseñadas en capas delgadas de materiales magnéticos y no magnéticos, las válvulas de espín Magnetorresistivo Gigante (GMR) utilizan las propiedades magnéticas, o ‘spin’, de los electrones para la detección de datos informáticos almacenados en bits magnéticos. Por el contrario, el tratamiento por ordenador se basa en flujos de electrones con carga eléctrica que fluyen alrededor de un circuito pequeño grabado en un microchip.

El Dr. Drew y su equipo han investigado cómo las capas de fluoruro de litio (LiF) – un material que tiene un campo eléctrico intrínseco – puede modificar el espín de los electrones transportados a través de estas válvulas de espín. Él explica: «Si bien en teoría, dispositivos que combinan la carga del electrón y el espín son conceptualmente sencillos, esta es la primera vez que alguien ha demostrado que es posible controlar de forma proactiva el espín con los campos eléctricos.»

El profesor Christian Bernhard, de la Universidad de Friburgo, Departamento de Física, describe su técnica con éxito: «Usando la técnica espectroscópica Low Energy Muon Spin Rotation (LE-?SR), nuestros experimentos han visualizado la polarización de espín cerca de interfaces de una válvula de espín . »

Los experimentos se realizaron en el Instituto Paul Scherrer, la única institución en todo el mundo, donde esta técnica está disponible. El método utiliza las propiedades magnéticas de los muones – partículas subatómicas inestables. «En un experimento los muones se arrojan al material y cuando se descomponen, los productos de desintegración llevar información acerca de los procesos magnéticos en el interior del material», explica el profesor Elvezio Morenzoni de la ISP, donde se ha desarrollado la técnica. «Lo único acerca de muones de baja energía es que se pueden colocar en una capa específica en un sistema multi-capa. Por lo tanto con este método se puede estudiar el magnetismo en un sola capa por separado.»

Fuente: ScienceDaily

_____________

Enlaces de interés:

– Actualidad informática: Sistemas almacenamiento

– Apuntes Periféricos de un ordenador. GAP. UMU. Introducción Informática

– Apuntes Informática Aplicada al Trabajo Social. UMU. Introducción al Hardware

______________

Enlaces de no interés:

abogados alicante

desarrollo web

diseño pagina web

trabajar en casa

Bajo condiciones ideales – que implican una alta intensidad de un haz láser y 1 600 metros de largo y dos aceleradores de partículas – podría ser posible crear algo de la nada, de acuerdo con investigadores de la Universidad de Michigan (EE.UU.).

Los científicos e ingenieros han desarrollado nuevas ecuaciones que muestran cómo un haz de electrones de alta energía en combinación con un pulso láser intenso puede destrozar un vacío dando origen a componentes fundamentales de materia y antimateria, y se desataría una cascada de eventos que generan pares adicionales de partículas y antipartículas.

«Ahora podemos calcular como, a partir de un solo electrón, varios cientos de partículas pueden ser producidas. Creemos que esto sucede en la naturaleza, cerca de púlsares y estrellas de neutrones», dijo Igor Sokolov, un científico de investigación en ingeniería que realizó esta investigación junto con el científico investigador asociado John Nees, profesor emérito de ingeniería eléctrica Gerard Mourou y sus colegas de Francia.

En el corazón de este trabajo está la idea de que el vacío no es exactamente nada. «Es mejor decir, siguiendo al físico teórico Paul Dirac, que el vacío, o nada, es la combinación de materia y antimateria – partículas y antiparticles. Es tremendo, pero no podemos percibir cualquiera de ellos, porque sus efectos observables por completo se anulan entre sí «, dijo Sokolov.

La materia y la antimateria se destruyen entre sí cuando entran en contacto en condiciones normales.

«Pero en un fuerte campo electromagnético, esta aniquilación, que suele ser un mecanismo disipador, puede ser el origen de nuevas partículas,» dijo Nees. «En el curso de la aniquilación, los fotones gamma aparecen, y pueden producir electrones y positrones adicionales. »

Un fotón gamma es una partícula de luz de alta energía. Un positrón es un anti-electrón, una partícula de imagen especular con las mismas propiedades que un electrón, pero una carga opuesta, positiva.

Los investigadores describen este trabajo como un gran avance teórico, y un «salto cualitativo en la teoría.»

Un experimento de finales de los 90 del siglo pasado logró generar a partir de un vacío fotones gamma y un par electrón-positrón ocasional. Estas nuevas ecuaciones llevan este trabajo un paso más al modelo de cómo un campo láser fuerte podría promover la creación de más partículas que las que se inyectan inicialmente en un experimento a través de un acelerador de partículas.

«Si el electrón tiene una capacidad para convertirse en tres partículas dentro de un plazo muy corto, esto significa que no es un electrón por más tiempo», dijo Sokolov. «La teoría del electrón se basa en el hecho de que será un electrón para siempre. Pero en nuestros cálculos, cada una de las partículas cargadas se convierte en una combinación de tres partículas, más un cierto número de fotones.»

Los investigadores han desarrollado una herramienta para poner en práctica sus ecuaciones en el futuro en una escala muy pequeña con el láser HERCULES en la UM. ara probar el potencial completo de su teoría, un láser tipo HERCULES tendría que ser construido en un acelerador de partículas como el SLAC National Accelerator Laboratory en la Universidad de Stanford. Dicha infraestructura no está actualmente prevista.

Este trabajo podría tener aplicaciones en la fusión por confinamiento inercial, lo que podría producir energía más limpia en las reacciones de fusión nuclear, dicen los investigadores. Para Sokolov, es fascinante desde una perspectiva filosófica.

«La pregunta básica ¿qué es un vacío, y lo que es nada, va más allá de la ciencia», dijo. «Está profundamente arraigado en la base no sólo de la física teórica, sino de nuestra percepción filosófica de todo – de la realidad, de la vida, incluso la cuestión religiosa, que todo el mundo podría haber venido de la nada.»

Un artículo sobre este trabajo ha sido publicado en Physical Review Letters.

Sokolov es un científico investigador del Laboratorio de Investigación de Física Espacial del Departamento de Atmospheric, Oceanic and Space Sciences. Nees es un científico investigador asociado en Center for Ultrafast Optical Science y profesor asociado adjunto en el Departamento de Electrical Engineering and Computer Science. Mourou es el AD Moore distinguido profesor emérito de Ingeniería Eléctrica que se encuentra actualmente en el Institut de la Lumiere Extreme en Francia. También contribuyeron Natalia M. Naumova, en el Laboratoire d’Optique Appliquee en Francia.

Esta investigación fue financiada en parte por el Departamento de Energía de EE.UU.

Fuente: ScienceDaily

_____________

Enlaces de interés:

– Actualidad informática: Física

La ciencia trabaja desde hace más de un siglo en la creación de un posible manto de la invisibilidad que podría, mediante el uso de las propiedades refractoras de un material, desviar las ondas de luz de un objeto y convertirlo en invisible en el espacio es algo en lo que.

El nuevo mecanismo creado por el equipo liderado por Martin MacCall, cuyas conclusiones se publican en el Journal of Optics, da un paso más al poner en práctica esta técnica en una cuarta dimensión, el tiempo, abriendo la posibilidad de esconder u ocultar eventos enteros.

El trabajo del equipo de MacCall sugiere que un objeto podría moverse de una región del espacio a otra sin que ninguno de los potenciales espectadores lo detectara.

Para conseguir este efecto, los investigadores manipularon las propiedades de la luz y crearon un manto de “vacío temporal” en el que los eventos no serían percibidos por el espectador.

“Hemos mostrado que es posible ocultar el paso del tiempo. De forma que no sólo pueden oscurecerse eventos específicos sino que sería posible para mí estar viendo a una persona que de repente desaparece y reaparece en un lugar distinto”, señala a MacCall.

“Normalmente tienes una fuente de luz detrás de un objeto que te permite ver su historia. Imagina que la historia es como una película y a esa película se le quita una escena, eso es lo que hemos conseguido”, explica el italiano Alberto Favaro, de Imperial College, también coautor del estudio.

¿Cómo ha sido posible este “truco de magia”?

“Nuestro manto de invisibilidad de eventos en el espacio y en el tiempo funciona al dividir la fuente de luz en fotones. Se determina un punto en el que se decide que los fotones que se encuentran delante se aceleren y los que están en la parte de atrás se retrasen. De esta forma, en el centro se crea un área en la que no hay fotones. El evento que no recibe iluminación se esconde en este vacío. Mientras el espectador percibe sólo un flujo continuo de eventos”, ilustra Favaro.

“Al contrario de lo que ocurre con otros mantos, este sistema no trata de desviar la luz de un objeto, sino que estrecha los rayos de luz en el tiempo, abriendo como una cortina de teatro y creando un pasillo temporal en el que la energía, la información y la materia puede ser manipulada o transportada sin ser detectada”, continúa el investigador.

Además, Favaro señala que mientras los mantos de invisibilidad hacen que el objeto desaparezca de forma definitiva (“nunca se ve”), el mecanismo inventado por ellos hace que el evento desaparezca en un determinado momento, en una escena que se ha cortado, pero puede volver (o no) a aparecer después.

Las aplicaciones del invento permitirían en un principio sentar las bases para la creación de un manto que permitiera la invisibilidad en el tiempo.

Pero mucho antes de que esto ocurra y la ciencia gane la partida a la ficción, podría tener un gran impacto en la comunicación con fibras ópticas y en el desarrollo de los ‘ordenadores cuánticos’, que se basan en la manipulación de la luz para la transmisión segura de una enorme cantidad de datos.

Es una transmisión de datos en un canal por vía de luz en una fibra óptica. Por un lado, tienes un canal que envía información continua, como la circulación continua coches de una carretera. “Por otro lado, tienes la persona que intenta cruzar la carretera, que sería información ocasional y prioritaria”, ejemplifica Favaro.

“Lo ideal es procesar la información prioritaria siempre, pero no sabes cuándo se va a producir, porque es ocasional. Nuestro invento permitiría utilizar el manto para que la persona pudiera cruzar la carretera y la información fuera procesada rápidamente. Después de esto se podría cerrar el vacío del medio de forma que la etapa de procesar información prioritaria no se vea y todo siga como si no hubiera interrupción”, asegura el investigador.

Al contrario del resto de las aplicaciones, el impacto del nuevo hallazgo en ordenadores cuánticos podría aplicarse, según Favaro, en tan sólo un par de años.

Fuente: L3TRC

__________

Enlaces de interés:

– Nuevo material que supone avance en la computación cuántica

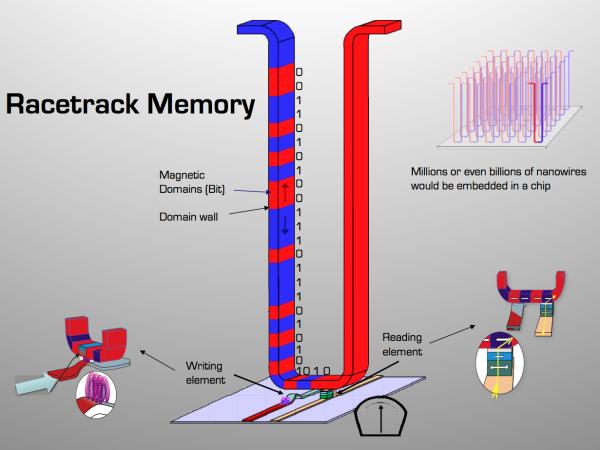

Imagine un ordenador equipado con memoria a prueba de choque que es 100 000 veces más rápido y consume menos energía que los discos duros actuales. El profesor Mathias Kläui está trabajando en un nuevo tipo de memoria, ultra-rápida y no volátil, de lectura y escritura magnética que puede hacer que este dispositivo pronto sea posible.

Molesto por el tiempo que tardó su equipo en el arranque, Kläui comenzó a pensar en una alternativa. Los discos duros son baratos y pueden almacenar cantidades enormes de datos, pero son lentos; cada vez que un ordenador arranca, 2-3 minutos se pierden mientras se transfiere la información desde el disco duro a la memoria RAM (memoria de acceso aleatorio). El coste global en términos de pérdida de productividad y consumo de energía asciende a varios centenares de millones de dólares al día.

Al igual que la cinta de vídeo VHS probada y auténtica, la solución propuesta consiste en los datos grabados en cinta magnética. Pero la similitud termina ahí, en este sistema la cinta sería un nanocable de níquel-hierro, un millón de veces más pequeño que la cinta clásica. Y a diferencia de una cinta de vídeo magnética, este sistema no se mueve mecánicamente. Los bits de información almacenada en el cable son simplemente empujados dentro de la cinta mediante una corriente de espín polarizado, alcanzando la velocidad vertiginosa de varios cientos de metros por segundo en el proceso. Es como leer toda una cinta de VHS en menos de un segundo.

Para que la idea sea factible, cada bit de información debe estar claramente separado del siguiente, de manera que los datos se pueden leer con fiabilidad. Esto se logra mediante el uso de paredes de dominio con vórtices magnéticos para delinear dos bits adyacentes. Para estimar la velocidad máxima a la que los bits se pueden mover, Kläui y sus colegas llevaron a cabo mediciones en los vórtices y encontraron que el mecanismo físico podría permitir posibles velocidades de acceso más altas de lo esperado.

Sus resultados fueron publicados en línea el 25 de octubre 2010, en la revista Physical Review Letters. Scientists at the Zurich Los científicos en el Centro de Investigación Zurich de IBM (que está desarrollo de un circuito de memoria racetrak) han confirmado la importancia de los resultados en un artículo. Millones o incluso miles de millones de nanocables estaría incorporados en un chip, proporcionando una capacidad enorme en una plataforma a prueba de choques. Un dispositivo listo para el mercado podría estar disponible en tan sólo 5-7 años.

La memoria Racetrack promete ser un verdadero avance en el almacenamiento y recuperación de datos. Ordenadores equipads con Racetrack van a arrancar de inmediato, y su información se puede acceder 100 000 veces más rápidamente que con un disco duro tradicional. También se ahorra energía. RAM debe ser alimentado cada millonésima de segundo, por lo que un equipo inactivo consume hasta 300 mW sólo por mantener los datos en la RAM. Como la memoria Racetrack no tiene esta limitación, el consumo de energía puede ser reducido en casi un factor de 300, a unos pocos mW mientras que la memoria está inactivo. Es una consideración importante: la informática y la electrónica de consumo actualmente gastan el 6% de la electricidad en todo el mundo, y se prevé que aumentará a 15% en 2025.

Fuente: ScienceDaily