Actualidad informática

Noticias y novedades sobre informática

Una «bombe» criptográfica por dentro

Durante la segunda guerra mundial el Reino Unido y los Estados Unidos utilizaron varios centenares de dispositivos electromecánicos conocidos como «bombe» para descifrar los mensajes alemanes codificados con máquinas Enigma.

Básicamente cada bombe emulaba el funcionamiento de varias Enigma a la vez y lo que hacía era comparar un texto sin cifrar que se creía que se correspondía con el interceptado para averiguar en qué configuración estaban funcionando las máquinas Enigma ese día.

La bombe iba probando y probando combinaciones de los discos y cables hasta que daba con una posición que podía ser válida, posición que servía a los analistas humanos para seguir trabajando en el análisis, ya que las bombe no podían indicar exactamente cual era la posición correcta de los discos sino descartar aquellas que no tenían sentido.

Las bombe británicas eran un desarrollo de la bomba criptológica creada por el criptologista polaco polaco Marian Rejewski; las estadounidenses, a su vez, eran un desarrollo de las británicas, y además a su vez el ejército y la marina de los Estados Unidos usaban modelos ligeramente distintos.

Ampliar en: Microservos

Selenio y fotófono

En 1873 un ingeniero británico, Willoughby Smith, descubrió algo realmente inusual en el selenio, por total y completa casualidad una vez más. Willoughby estaba involucrado en la fabricación e instalación de cables submarinos de telégrafo eléctrico, y se hallaba intentando diseñar circuitos de prueba que permitiesen comprobar que el cable submarino transmitía perfectamente según se iba soltando bajo el agua.

Para su circuito de prueba hacía falta un semiconductor, y Willoughby empleó cilindros de selenio gris (recuerda, la forma cristalina), que no funcionaron bien: eran inconsistentes en sus propiedades eléctricas, de modo que presentaban una resistencia en el laboratorio y otra distinta –mucho mayor –al meterlos bajo el agua. El británico no hizo lo que imagino que hubiera hecho yo –sustituir el selenio por otro semiconductor– sino que intentó determinar por qué el selenio cambiaba su resistencia eléctrica.

Tras realizar experimentos en laboratorio Willoughby llegó a una conclusión sorprendente, que publicó en Nature bajo el título Effect of Light on Selenium during the passage of an Electric Current (Efecto de la luz sobre el selenio durante el paso de una corriente eléctrica): el selenio gris era extraordinariamente sensible a la luz. Al iluminarlo su resistencia eléctrica disminuía, de modo que al probar los circuitos bajo la luz del Sol el selenio gris conducía relativamente bien –para ser un semiconductor, por supuesto– pero al sumergirlo en las profundidades y la consecuente oscuridad su resistencia aumentaba mucho. Esto era un problema para probar cables telegráficos, pero una propiedad utilísima para muchas otras cosas.

Se trataba del primer semiconductor fotosensible que conocíamos, y los ojos de los ingenieros de todo el mundo se pusieron a hacer chiribitas. Entre ellos se encontraba nada menos que Alexander Graham Bell, que se planteó lo siguiente: ¿no sería posible convertir la voz en pulsos luminosos en un emisor y luego recibir esos pulsos con un receptor de selenio para convertirlos en impulsos eléctricos? Junto con su ayudante, Charles Sumner Tainter, Bell puso manos a la obra y los dos hombres consiguieron su propósito en 1880.

El aparato, bautizado con el magnífico nombre de fotófono, era de una sencillez propia de los genios. El emisor tenía un espejo parabólico de gran tamaño con una bombilla en su foco, que recibía directamente la voz de quien hablaba. El sonido hacía vibrar el espejo, con lo que los rayos de luz eran reflejados en distintas direcciones cuando el espejo vibraba: el haz se “esparcía” o se “concentraba” según la forma del espejo vibrante.

El receptor, a su vez, tenía otro espejo parabólico con una pieza de selenio en el foco unida a un circuito eléctrico: allí pasaba justo lo contrario. El receptor de selenio recibía pulsos de luz acompasados a la luz que llegaba al espejo, de modo que el circuito recibía pulsos eléctricos cuando el selenio recibía luz y, en consecuencia, disminuía su resistencia eléctrica. El aparato funcionaba estupendamente bien e imagino que a muchos les hubiera parecido magia. A mí lo que me sorprende es su absoluta sencillez.

El fotófono fue eclipsado unos años más tarde por la radio, pero siguió utilizándose con usos muy concretos pero importantísimos. A diferencia de las ondas de radio, mucho más difíciles de enfocar, el fotófono permitía comunicarse a distancia y sin cables de un modo muy preciso, con lo que en la guerra era muchísimo más útil que la radio… siempre que hubiera una línea de visión ininterrumpida entre emisor y receptor, por supuesto. Ése era uno de sus puntos flacos, ya que la niebla, la lluvia o una cadena montañosa lo dejaban fuera de juego.

Sin embargo, Alexander Graham Bell lo consideró hasta su muerte su mayor invento –más importante que el teléfono–, y el concepto no es tan diferente del que utilizaríamos muchos años más tarde al desarrollar la fibra óptica, que también convierte la información en pulsos luminosos que luego se transforman, en el receptor, en impulsos eléctricos. Sin embargo, ahora ya no usamos selenio como hizo Bell.

Durante un tiempo el selenio fue muy utilizado como fotorreceptor en muchos circuitos fotosensibles, como los de los fotómetros en fotografía o incluso células fotoeléctricas que usaban luz en vez de radiación ultravioleta o infrarroja como las modernas. Y es que el selenio, como otros semiconductores fotosensibles, es capaz no sólo de disminuir su resistencia eléctrica ante la luz: es capaz, si las condiciones son las adecuadas, de generar una corriente eléctrica al exponerlo a la luz. Es un material no sólo fotosensible, sino fotovoltaico. De hecho, algunos de los fotómetros de selenio usados en fotografía ni siquiera necesitan una pila para funcionar, sino que la pieza de selenio genera el suficiente voltaje para el aparato al exponerlo a la luz.

Ampliar en: El Tamiz

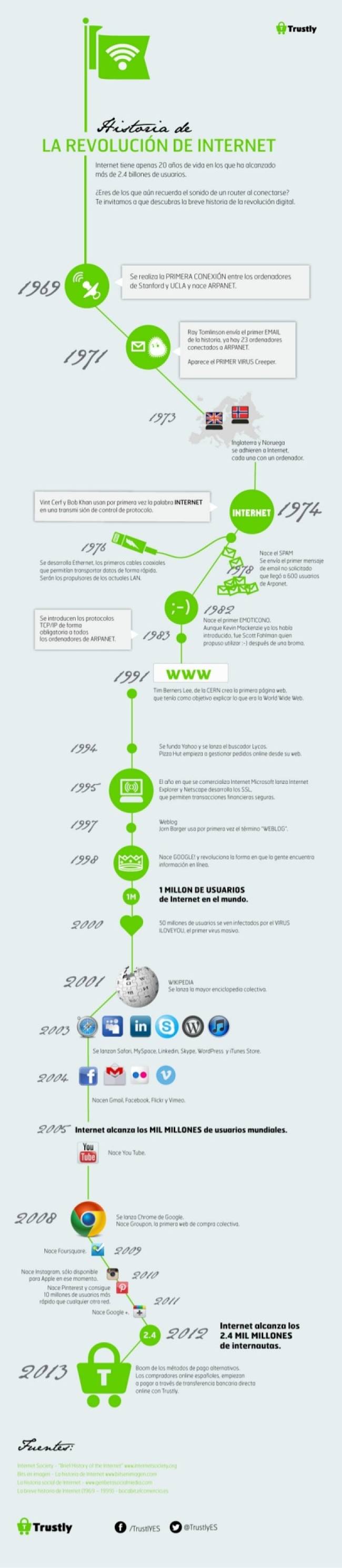

Segundo aniversario de la muerte de Dennis Ritchie

Hoy, 12 de octubre se cumple el segundo aniversario de la muerte de Dennis Ritchie, el hombre que nos ha legado la base de todos los sistemas operativos actuales, el lenguaje C y el sistema operativo Unix (que actualmente perdura de una forma u otra a través de BSD, Linux y Mac OSX). No podíamos dejar pasar la ocasión para recordar todo lo que sus avances han hecho por nosotros, ya que sin ellos probablemente no conoceríamos ningún sistema operativo tal como hoy lo conocemos y los lenguajes de programación actuales serían muy distintos (ya que muchísimos se basan o están influenciados por C).

La creación de Unix es un tanto anecdótica, ya que fue fruto de la experiencia trabajando en Bell Labs con Multics y las ganas de crear un sistema más ligero (Unics) donde poder ejecutar de forma mucho más eficiente el juego Space Travel, que desarrolló Ken Thompson, que también colaboró en el desarrollo de Unix. Por esos entonces cada computadora tenía un lenguajes bastante distinto y había que cambiar el código para cada una, pero con este sistema les resultó fácil portarlo a una computadora mayor, en este momento el proyecto recibió un gran apoyo económico y prosperó. En esta etapa fue también en la que desarrolló el lenguaje C, para aprovechar las cualidades de la computadora PDP-11, ya que no era posible con el lenguaje B.

También es conocido por escribir el libro K&R C (aunque el nombre original era El lenguaje de programación C), junto a Brian Kernighan. Ha sido considerado prácticamente la biblia del lenguaje C durante muchos años, hasta que llegó ANSI C.

Fuente: GENBETA:dev

Autor: Pedro Gutiérrez

Licencia Creative Commons

Conferencia sobre el ordenador Commodore 64

La charla cuenta algo de la historia y el hardware del C-64, cómo era su programación en el código máquina del 6502/6510 y de algunas de sus espectaculares característica para la época: sprites para juegos, varios modos de vídeo, color y demás – incluyendo las razones subyacentes que llevaron a aquel diseño.

Como curiosidad histórica en la charla se muestran algunas líneas de código máquina de la ROM del C-64 que se dice fueron escritas por el mismísimo Bill Gates en persona. Tenían que ver con el BASIC que el C-64 llevaba incorporado y Microsoft licenció a Commodore a cambio de 25000 dólares (un solo pago, sin royalties).

Ampliar en: Microsiervos

El origen del error ‘404’

En el inicio de los tiempos, cuando Internet era un mundo extraño en la que todo se llevaba a cabo mediante consola y compartiendo archivos, un grupo de jóvenes científicos del CERN (Suiza) se dedicó a lanzar la World Wide Web, conocida mundialmente como “www”.

Ellos esperaban crear una infraestructura necesaria para tener acceso a contenido en varios formatos que estuviera en las computadoras conectadas a esta red y que combinara texto e imágenes.

Estos chicos empezaron a probar este protocolo dentro del mismo CERN, con la red de computadoras que había ahí mismo. Empezaron por usar la infraestructura del CERN para alojar a la naciente Internet.

En una habitación del cuarto piso (la habitación 404) les permitieron poner lo que sería la base central de la red, cualquier petición de ficheros por parte de un usuario era encaminada a esta oficina donde dos o tres personas se encargaban de localizar el archivo manualmente y mandarlo hasta el usuario que lo había solicitado. Todo a través de la red.

¿Pero qué pasaba cuando los chicos de la oficina 404 no podían encontrar el archivo o este no existía? Pues ellos se encargaban de mandar un mensaje que dijera “Room 404: file not found”.

Cuando el Internet se mundializó, el error 404 se siguió manteniendo y hasta nuestros días se puede ver cuando escribimos mal una dirección o cuando la página o archivo que buscamos en Internet ha sido borrado.

Fuente: CULTURIZANDO

Aniversario del IBM 5150, PC

El 12 de agosto de 1981, en una conferencia de prensa de la ciudad de Nueva York (EE.UU.), la empresa anunció la IBM Personal Computer (IBM 5150) por el precio de US$ 1565. Dos décadas antes, una computadora IBM a menudo costaba hasta US$ nueve millones y requería un gran espacio, con aire acondicionado y una plantilla de 60 personas.

El modelo 5150 se convirtió en el primer dispositivo de la llamada era PC de difusión masiva a nivel mundial, que, según empresas como Apple, está muriendo a causa de la popularización de los dispositivos móviles como los smartphones y las tabletas.

Sin embargo, el PC sigue siendo parte importante de nuestras vidas y el centro de procesamiento de todos nuestros datos digitales, además de ser un importante medio de entretenimiento.

Pese a ser creador de la categoría PC, IBM abandonó su fabricación en 2005, cuando decidió venderle esa línea de su negocio a la empresa china Lenovo, para concentrarse únicamente en servicios.

Fuente: GADGETMANÍA

autobus las palmas aeropuerto cetona de frambuesa