Actualidad informática

Noticias y novedades sobre informática

La guía del fabricante de medicamentos para la galaxia

En 2016, la empresa farmacéutica Sunovion asignó a un grupo de profesionales experimentados una misión inusual. En la sede central de la firma en Marlborough, Massachusetts, a todos los químicos se les pidió que participaran en un juego para ver quién podía descubrir las mejores pistas de medicamentos nuevos. En sus puestos de trabajo había una cuadrícula de cientos de estructuras químicas, de las cuales sólo diez estaban etiquetadas con información sobre sus efectos biológicos. Los expertos tuvieron que seleccionar otras moléculas que podrían resultar ser candidatas a medicamentos, utilizando sus conocimientos de estructura química y biología, que tanto les costó aprender. De los 11 jugadores, 10 lucharon durante varias horas. Pero uno de ellos consiguió pasar en milisegundos, porque era un algoritmo.

Ese programa de computación fue la creación de Willem van Hoorn, jefe de quimioinformática de Exscientia, una empresa que usa inteligencia artificial (IA) para diseñar medicamentos. La firma, con sede en Dundee, Reino Unido, quería ampliar una incipiente asociación con Sunovion, por lo que las apuestas eran altas. «Mi credibilidad estaba en juego», dice van Hoorn. Veinte rondas de juego más tarde, él anotó los puntos. El alivio lo invadió. Su algoritmo había dominado al menos algunas de las artes oscuras de la química; sólo un experto en caza de drogas había derrotado a la máquina.

Desde entonces, Exscientia y Sunovion han seguido trabajando juntas para descubrir fármacos psiquiátricos. «Esta competencia realmente ayudó a que la gente que toma las decisiones de investigación química se comprometiera», dice Scott Brown, director de química computacional de Sunovion.

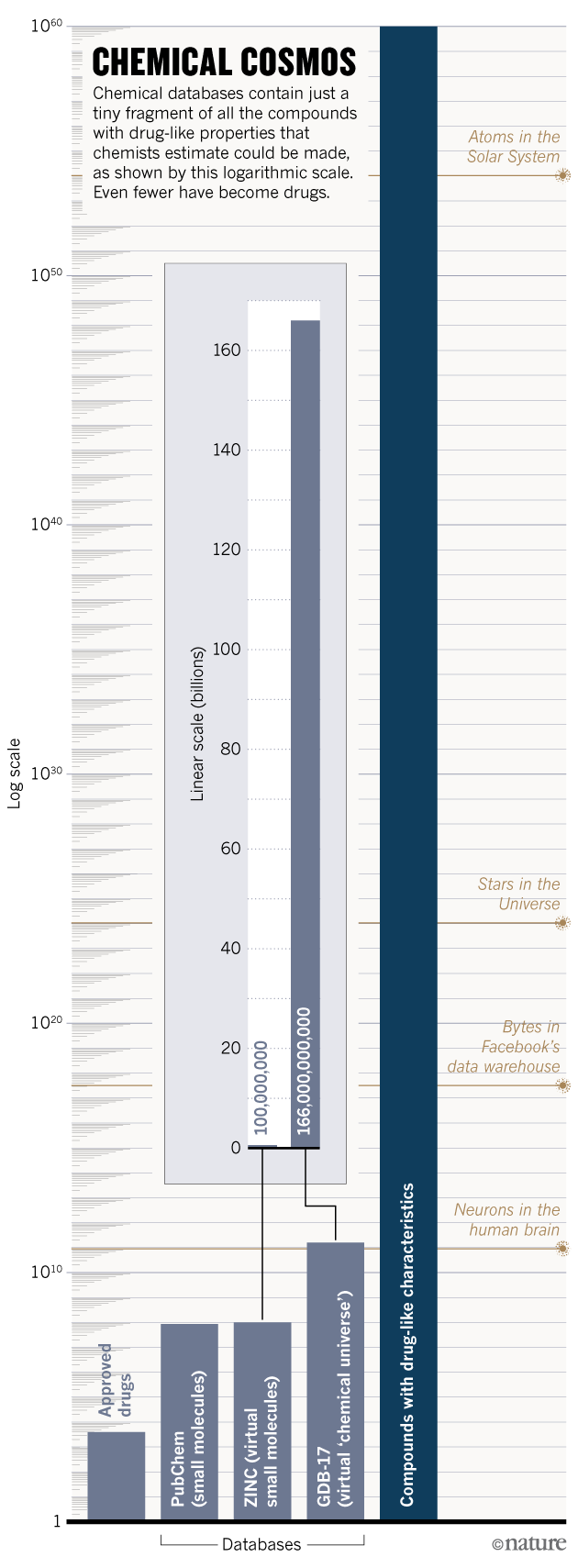

Exscientia es sólo uno de los numerosos grupos de la industria y el mundo académico que están recurriendo a las computadoras para explorar el asombroso y gran universo químico. Los químicos estiman que se podrían hacer 10^60 compuestos con características parecidas a las de un fármaco, es decir, moléculas más pequeñas que átomos hay en el Sistema Solar. La esperanza es que los algoritmos catalogarán, caracterizarán y compararán las propiedades de millones de compuestos para ayudar a los investigadores a encontrar rápidamente y de manera asequible los mejores candidatos para un objetivo. Los defensores argumentan que estas estrategias podrían hacer que los medicamentos sean más seguros, asegurar que menos medicamentos fallen en los ensayos clínicos y permitir el descubrimiento de nuevas clases de terapias. También podrían ayudar a abrir áreas de espacio químico que quedan inexploradas o supuestamente estériles.

Pero muchos químicos medicinales se muestran escépticos ante la exageración, no convencidos de que la inefable complejidad de la química pueda reducirse a simples líneas de código. Incluso los defensores de la IA reconocen que muchos intentos han fracasado: los compuestos generados por computadora pueden estar plagados de componentes difíciles de fabricar, como los anillos de 3 o 4 átomos, e infestados con grupos reactivos que activan las alarmas de seguridad. «La ejecución de algunos enfoques computacionales puede sufrir mucho cuando los investigadores simplemente no conocen el campo», dice van Hoorn. «Los compuestos que se les ocurren son simplemente ridículos», pero afirma que un toque humano experto podría domar a estos diseñadores digitales demasiado entusiastas. «Creo que algunas de estas ideas podrían funcionar si los informáticos colaboraran con gente que realmente respira química.»

Exploración espacial

Para navegar por el universo químico, ayuda tener un mapa. En 2001, el químico Jean-Louis Reymond, de la Universidad de Berna (Suiza), comenzó a utilizar ordenadores para trazar la mayor parte del espacio masivo posible. Dieciséis años después, ha acumulado la mayor base de datos de moléculas pequeñas del mundo, una gigantesca colección virtual de 166 mil millones de compuestos. La base de datos, llamada GDB-17, incluye todas las moléculas orgánicas químicamente factibles, compuestas de hasta 17 átomos, tantas como los ordenadores de Reymond puedan soportar. Sólo para que un ordenador pueda compilar una lista de los compuestos de la base de datos llevaría ahora más de 10 horas», dice Reymond.

Para dar sentido a esta plétora de posibles puntos de partida de medicamentos, Reymond ha ideado una forma de organizar su universo químico. Inspirándose en la tabla periódica, ha agrupado los compuestos en un espacio multidimensional en el que los compuestos vecinos tienen propiedades relacionadas. Las posiciones se asignan de acuerdo a 42 características, tales como cuántos átomos de carbono tiene cada compuesto.

Por cada medicamento que ha llegado al mercado, hay millones de compuestos que son químicamente casi idénticos a él – solo que tienen un hidrógeno extra aquí o doble enlace allí. Y algunos de estos funcionarán mejor que el medicamento aprobado. Los químicos no podrían concebir todas estas variaciones sin ayuda. «No hay manera de llegar a estos isómeros usando un bolígrafo y un pedazo de papel», dice Reymond.

Pero Reymond y su equipo pueden identificar «vecinos cercanos» terapéuticamente prometedores de drogas probadas mediante la búsqueda de similitudes entre los compuestos. Al utilizar un medicamento en particular como punto de partida, el equipo puede peinar los 166 mil millones de compuestos en la base de datos para obtener candidatos de seguimiento convincentes en sólo 3 minutos. En un experimento de prueba de principio, Reymond comenzó con una molécula conocida que une el receptor de acetilcolina nicotínica, un objetivo útil para trastornos que involucran el sistema nervioso o la función muscular, y compiló una lista corta de 344 compuestos relacionados. El equipo sintetizó tres, y descubrió que dos podrían activar el receptor de forma potente, y podrían ser útiles para tratar la atrofia muscular en el envejecimiento. El enfoque es como usar un mapa geológico para determinar dónde buscar oro, dice Reymond. «Necesitas alguna forma de elegir dónde vas a cavar», dice.

Un enfoque alternativo utiliza las computadoras para buscar oro en muchos lugares sin preocuparse demasiado por la ubicación inicial. En términos de búsqueda de medicamentos, esto significa que se deben buscar en sílice grandes bibliotecas químicas para encontrar pequeñas moléculas que se unen a una proteína dada. Primero, los investigadores tienen que tomar una instantánea de una proteína usando cristalografía de rayos X para determinar la forma de su sitio de unión. Luego, usando algoritmos de acoplamiento molecular, los químicos computacionales pueden escarbar a través de colecciones de compuestos para encontrar los mejores ajustes para cualquier sitio dado.

A medida que la potencia de computación ha explotado, las capacidades de estos algoritmos han mejorado. Los químicos de la Universidad de California en San Francisco, encabezados por Brian Shoichet, mostraron el potencial de este enfoque en 2016 en la búsqueda de una nueva clase de analgésicos. El equipo revisó más de tres millones de compuestos comercialmente disponibles para encontrar candidatos que activaran selectivamente la señalización del receptor de opiáceos para aliviar el dolor sin alterar la vía de señalización de detención de opiáceos estrechamente relacionada, que se cree que está asociada con los efectos secundarios de los opiáceos, incluyendo una menor frecuencia respiratoria y estreñimiento. Los investigadores rápidamente redujeron una biblioteca masiva de compuestos a sólo 23 compuestos altamente clasificados para el seguimiento.

En el tubo de ensayo, siete de los candidatos tuvieron la actividad deseada. El desarrollo posterior convirtió a uno de estos en PZM21, un compuesto que actúa sobre el receptor de los opiáceos sin activar la beta-arrestina. La firma biotecnológica Epiodyne, con sede en San Francisco, California, y cofundada por Shoichet, está ahora tratando de desarrollar un analgésico más seguro basado en los hallazgos. Shoichet planea utilizar el mismo enfoque para encontrar compuestos que modulen otros receptores acoplados a la proteína G (GPCR), una familia de proteínas que representa aproximadamente el 40% de los objetivos de medicamentos.

Su equipo también está llevando a cabo experimentos similares con una nebulosa virtual de 100 millones de compuestos que nunca se han hecho antes, pero que debería ser fácil de sintetizar. Los desarrolladores de medicamentos industriales también están probando este enfoque: la firma biotecnológica Nimbus Therapeutics, con sede en Cambridge, Massachusetts, incorpora en sus pantallas de acoplamiento compuestos virtuales con características de sustancias químicas naturales que normalmente tienen que ser obtenidas laboriosamente de entornos naturales como el suelo. El jurado todavía no está claro si esto conducirá a los medicamentos, pero Don Nicholson, director ejecutivo de la compañía, dice que para al menos un programa de diseño de fármacos, «de aquí vienen todos nuestros éxitos».

Los resultados preliminares de este tipo de pruebas virtuales están sacudiendo uno de los supuestos básicos de Shoichet sobre el espacio químico: que sólo vale la pena mirar en regiones establecidas y ricas en medicamentos. Galaxias bien caracterizadas de moléculas están tan inundadas con compuestos biológicamente activos que algunos argumentan que es una pérdida de tiempo buscar en otro lugar. «A lo largo de mi carrera he creído esa línea de razonamiento. Tenía sentido, aunque no hubiera tanta evidencia que lo apoyara «, dice Shoichet. Pero los resultados inéditos de sus cribas de 100 millones de compuestos están avivando su interés en las regiones menos exploradas del espacio químico. «Empiezo a pensar que esas galaxias están llenas de oro.»

… …

Ampliar en: nature

Según simulación informática, el whisky está mejor con agua añadida

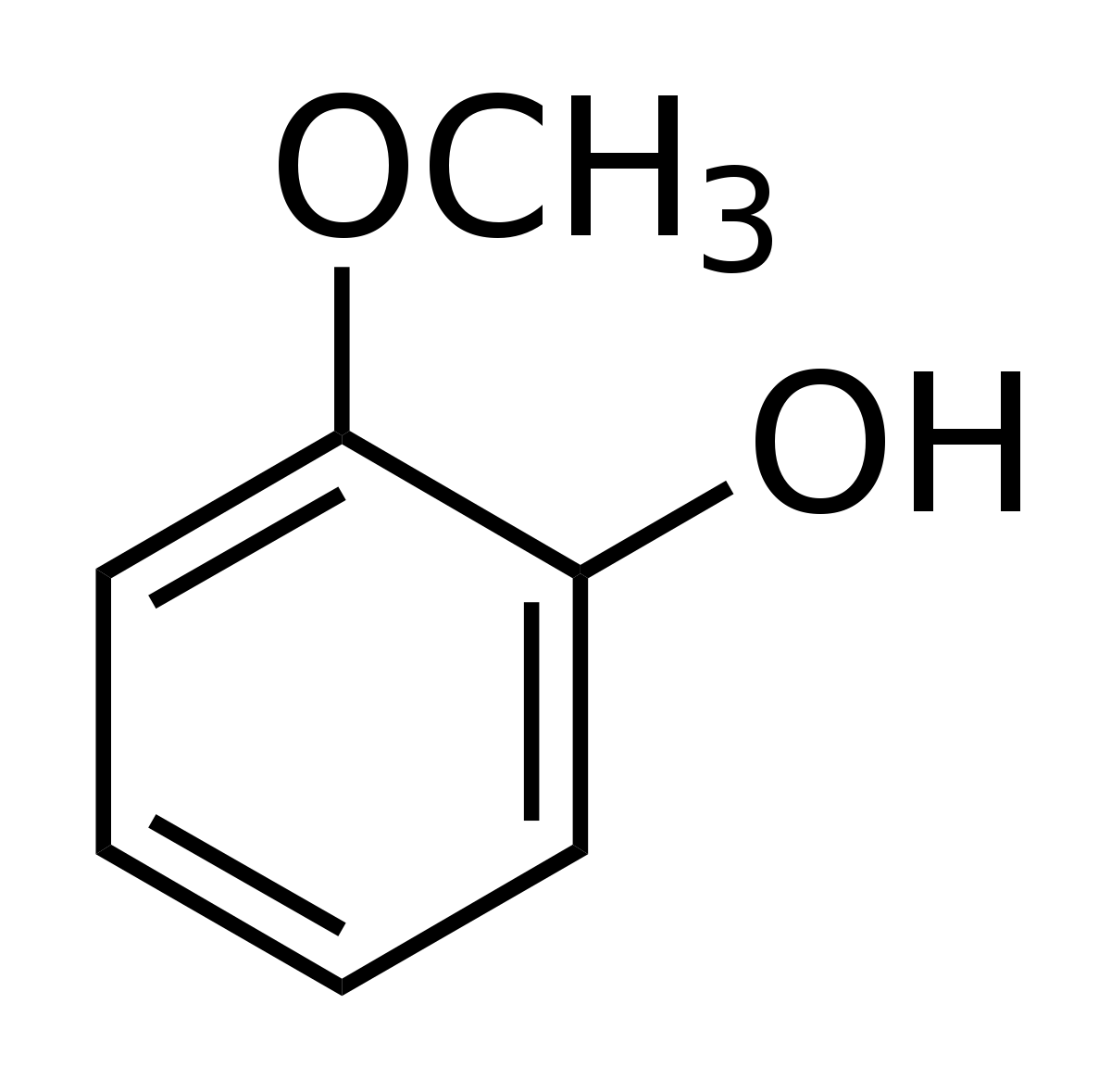

Según dos científicos suecos, la mejor manera de disfrutar un whisky es agregar un poco de agua. La dilución liberaría una pequeña molécula aromática, el guaiacol, particularmente presente en los whiskies escoceses.

Según dos científicos suecos, la mejor manera de disfrutar un whisky es agregar un poco de agua. La dilución liberaría una pequeña molécula aromática, el guaiacol, particularmente presente en los whiskies escoceses.

La fabricación del whisky comienza con etapas de fermentación y destilación. El whisky, que contiene aproximadamente el 70 % de alcohol por volumen en esta etapa, se envejece con los años. El alcohol se evapora durante esta maduración, resultando en un nivel de alcohol de aproximadamente 55-65 %. Antes del embotellado, el whisky se diluye hasta aproximadamente el 40 % añadiendo agua, lo que altera su sabor. Pero algunos aficionados todavía afirman verter un poco de agua en su copa para probar y mejorar su sabor.

En un artículo en Scientific Reports, Bjorn Karlsson y Ran Friedman querían saber si la adición de agua en el whisky realmente le dio más sabor. Para ello, utilizaron una simulación por ordenador y modelaron la composición del whisky. Hay dos hipótesis para explicar que la adición de agua mejora las cualidades gustativas del whisky, como explicó Bjorn Karlsson en el Washington Post. La primera es que el agua atrapa compuestos desagradables: ésteres de ácidos grasos. Pero según los investigadores, estos ésteres están presentes en concentraciones demasiado bajas para desempeñar un papel.

Guaiacol en la superficie del whisky diluido

La segunda hipótesis es que el agua libera moléculas que mejoran el sabor. El agua y el alcohol no se mezclan bien, los compuestos aromáticos pueden quedar atrapados en etanol y no llegar a la superficie. El whisky contiene muchos compuestos, pero los investigadores se han concentrado en guaiacol (C7H8O2), una pequeña molécula hidrofóbica que da un sabor ahumado, y más común en whisky escocés que whisky americano o irlandés.

Basándose en estas simulaciones, la concentración de etanol tuvo un efecto sobre el guaiacol. A diluciones por debajo del 45 %, es decir, a concentraciones de embotellado, el etanol se acumula en la superficie con guaiacol, donde se puede consumir. Pero por encima del 59 % de etanol, la concentración después de la destilación y antes de la dilución, el guaiacol está más rodeado de moléculas de etanol y menos presente en la superficie, y por lo tanto, en los eflujos liberados

Medida no invasiva de niveles de glucosa en bebés

Una nueva herramienta de diagnóstico basada en la luz, permite a los médicos controlar los niveles de azúcar en la sangre en pacientes que no pueden dar muestras de sangre.

El sistema está destinado a ayudar a prevenir la hipoglucemia en los bebés nacidos prematuramente. Ha sido desarrollado por investigadores suizos, en Swiss Federal Laboratories for Materials Science and Technology (EMPA) y el Hospital Universitario de Zurich.

La hipoglucemia puede conducir a daño cerebral en los bebés si persiste por más de una hora. Pero el control de la situación mediante muestras de sangre repetidas en poco tiempo es imposible porque la pérdida de sangre y el estrés serían demasiado intensos para que un bebé pudiera soportarlos.

El nuevo dispositivo, llamado Glucolight, no requiere muestras de sangre, ni tan siquiera para la calibración. En dispositivo, absorbe la glucosa a través de la piel y compara dos mediciones de fluorescencia para determinar la concentración de azúcar en sangre.

Cuenta con una cabeza de medición de microdiálisis, que se desarrolló en el Hospital Universitario de Zurich, y una membrana inteligente creada en APEM. También incorpora fuentes de luz, una bomba y un chip de microfluidos con un fluorómetro, desarrollado en el Hospital Universitario de Zurich.

La membrana “inteligente” contiene moléculas de colorante conocidas como espiropiranos, que se cargan con luz ultravioleta y vuelven a un estado neutro bajo luz visible. Como resultado, la membrana se abre cuando se irradia con luz UV, permitiendo que las moléculas de glucosa se difundan a su través a partir de la piel. Si se irradia con luz visible, considerablemente menos moléculas de glucosa pasan a través de la membrana.

Primero se toma una medida bajo luz visible. La pequeña cantidad de glucosa que pasa a través de la membrana se mezcla con enzimas reactivos y se bombea a través del chip de microfluidos, en el que se mide mediante el fluorómetro. El proceso se repite entonces con la luz UV. Un ordenador compara las dos lecturas.

Se espera que los estudios clínicos que utilizan el dispositivo, se incien este año en el Hospital Universitario de Zurich. Los investigadores han presentado una solicitud de patente y han comenzado las negociaciones relativas a la producción a gran escala del sensor. La investigación ha sido financiada por la Fundación Nacional de Ciencia de Suiza.

Moléculas de polímeros para almacenar la información

¿Y si todo el conocimiento humano se pudiera almacenar en línea, en tan poco espacio como el de una oficina, en lugar de en los gigantescos centros de datos que están invadiendo nuestro planeta? Los investigadores en química de polímeros plantean emplear este tipo de largas cadenas moleculares para almacenar información digital.

Un polímero es una serie de pequeñas moléculas, llamadas monómeros, asociadas para dar lugar a cadenas de gran longitud. La idea es incluir información sobre estas largas cadenas dando a cada monómero un valor de, 0 o 1, tal como se hace con la electrónica digital en base a dispositivos de silicio. El proceso está directamente inspirado en lo que la naturaleza hace desde millones de años a través del famoso polímero más conocido por el gran público, el ADN. En el ADN, son los cuatro nucleótidos A, T, G y C, en función del orden en el que están asociados, los que posibilitan la codificación de miles de millones de informaciones genéticas diferentes.

Acceder aquí: https://twitter.com/BarzanallanaUMU/status/592043906352680960

¿Por qué rebotan las pilas alcalinas viejas?

Una reacción química colateral en la pila es lo que provoca un cambio en la elasticidad del material.

Fuente: El Tao de la Física

La magia de la fluorescencia

Una joya divulgativa de 1946, de la mano de General Electric, y en castellano. Interesante documento que nos transporta a otras épocas; lo mejor, el épico final.

Fuente: La Ciencia es bellla

Del modelo atómico de Bohr al Higgs

La humanidad ha ido progresando en el conocimiento llamado “modelo estándar” de la Física de Partículas Elementales desde la formulación de la mecánica cuántica en el primer tercio del siglo XX. Para lograrlo ha sido imprescindible la construcción de instrumentos cada vez más potentes y el desarrollo de teorías físicas cada vez más abstractas. Estos esfuerzos han culminado con la producción y detección en el CERN del último ingrediente del modelo estándar, la partícula de Higgs.

Juan Luis Mañes, Catedrático de Física en la Facultad de Ciencia y Tecnología de la UPV/EHU, repasa los hitos principales desde la publicación del modelo de Bohr en 1913.

Fuente: CUADERNO DE CULTURA CIENTÍFICA

Premio Nobel de Química 2013

A estas alturas del año, seguro que todos ustedes saben que la Real Academia de Ciencias de Suecia ha otorgado el Nobel de Química 2013 al investigador austríaco Martin Karplus, al sudafricano Michael Levitt y al israelí Arieh Warshel por el “desarrollo de modelos multiescala de sistemas químicos complejos”…. cosa que es muy posible que a alguno de ustedes les suene a chino.

La concesión a estos tres investigadores de la máxima distinción científica en el campo de la alquimia ha levantado mucha polémica, pero desde mi punto de vista es más que merecida ya que sus descubrimientos en el campo de la química computacional están siendo de vital importancia en el desarrollo de muchas otras áreas científicas, lo que está repercutiendo positivamente en el día a día de los ciudadanos.

En el blog SCIENTIA se trata «¿Puede el Premio Nobel de Química 2013 salvarte la vida?» del que se pueden extraer las siguientes conclusiones:

Por un lado el desarrollo de la química computacional está siendo de vital importancia para la predicción y desarrollo de infinidad de reacciones químicas de gran importancia por lo que la concesión del Premio Nobel a los padres de esta rama de la química está más que justificada.

Por otra parte hemos de tener claro que la química computacional y la química experimental forman un binomio en el cual cada uno de los componentes se nutre del otro. La química computacional necesita a la experimental para corroborar sus predicciones y la química experimental necesita a la computacional para optimizar su rendimiento.

Pero la conclusión más importante que yo personalmente extraigo es la siguiente. En este post les he mostrado como en un solo trabajo un grupo de investigadores emplea herramientas pertenecientes a campos tan “teóricamente” distintos como la química, la informática, la medicina, la bioquímica, la farmacología, las matemáticas… lo que me ha servido para ratificarme en algo que llevo pensando muchos tiempo: en los tiempos que corren parcelar áreas científicas tiene cada vez manos sentido. El trabajo multidisciplinar es el futuro del avance científico.

![]()

Selenio y fotófono

En 1873 un ingeniero británico, Willoughby Smith, descubrió algo realmente inusual en el selenio, por total y completa casualidad una vez más. Willoughby estaba involucrado en la fabricación e instalación de cables submarinos de telégrafo eléctrico, y se hallaba intentando diseñar circuitos de prueba que permitiesen comprobar que el cable submarino transmitía perfectamente según se iba soltando bajo el agua.

Para su circuito de prueba hacía falta un semiconductor, y Willoughby empleó cilindros de selenio gris (recuerda, la forma cristalina), que no funcionaron bien: eran inconsistentes en sus propiedades eléctricas, de modo que presentaban una resistencia en el laboratorio y otra distinta –mucho mayor –al meterlos bajo el agua. El británico no hizo lo que imagino que hubiera hecho yo –sustituir el selenio por otro semiconductor– sino que intentó determinar por qué el selenio cambiaba su resistencia eléctrica.

Tras realizar experimentos en laboratorio Willoughby llegó a una conclusión sorprendente, que publicó en Nature bajo el título Effect of Light on Selenium during the passage of an Electric Current (Efecto de la luz sobre el selenio durante el paso de una corriente eléctrica): el selenio gris era extraordinariamente sensible a la luz. Al iluminarlo su resistencia eléctrica disminuía, de modo que al probar los circuitos bajo la luz del Sol el selenio gris conducía relativamente bien –para ser un semiconductor, por supuesto– pero al sumergirlo en las profundidades y la consecuente oscuridad su resistencia aumentaba mucho. Esto era un problema para probar cables telegráficos, pero una propiedad utilísima para muchas otras cosas.

Se trataba del primer semiconductor fotosensible que conocíamos, y los ojos de los ingenieros de todo el mundo se pusieron a hacer chiribitas. Entre ellos se encontraba nada menos que Alexander Graham Bell, que se planteó lo siguiente: ¿no sería posible convertir la voz en pulsos luminosos en un emisor y luego recibir esos pulsos con un receptor de selenio para convertirlos en impulsos eléctricos? Junto con su ayudante, Charles Sumner Tainter, Bell puso manos a la obra y los dos hombres consiguieron su propósito en 1880.

El aparato, bautizado con el magnífico nombre de fotófono, era de una sencillez propia de los genios. El emisor tenía un espejo parabólico de gran tamaño con una bombilla en su foco, que recibía directamente la voz de quien hablaba. El sonido hacía vibrar el espejo, con lo que los rayos de luz eran reflejados en distintas direcciones cuando el espejo vibraba: el haz se “esparcía” o se “concentraba” según la forma del espejo vibrante.

El receptor, a su vez, tenía otro espejo parabólico con una pieza de selenio en el foco unida a un circuito eléctrico: allí pasaba justo lo contrario. El receptor de selenio recibía pulsos de luz acompasados a la luz que llegaba al espejo, de modo que el circuito recibía pulsos eléctricos cuando el selenio recibía luz y, en consecuencia, disminuía su resistencia eléctrica. El aparato funcionaba estupendamente bien e imagino que a muchos les hubiera parecido magia. A mí lo que me sorprende es su absoluta sencillez.

El fotófono fue eclipsado unos años más tarde por la radio, pero siguió utilizándose con usos muy concretos pero importantísimos. A diferencia de las ondas de radio, mucho más difíciles de enfocar, el fotófono permitía comunicarse a distancia y sin cables de un modo muy preciso, con lo que en la guerra era muchísimo más útil que la radio… siempre que hubiera una línea de visión ininterrumpida entre emisor y receptor, por supuesto. Ése era uno de sus puntos flacos, ya que la niebla, la lluvia o una cadena montañosa lo dejaban fuera de juego.

Sin embargo, Alexander Graham Bell lo consideró hasta su muerte su mayor invento –más importante que el teléfono–, y el concepto no es tan diferente del que utilizaríamos muchos años más tarde al desarrollar la fibra óptica, que también convierte la información en pulsos luminosos que luego se transforman, en el receptor, en impulsos eléctricos. Sin embargo, ahora ya no usamos selenio como hizo Bell.

Durante un tiempo el selenio fue muy utilizado como fotorreceptor en muchos circuitos fotosensibles, como los de los fotómetros en fotografía o incluso células fotoeléctricas que usaban luz en vez de radiación ultravioleta o infrarroja como las modernas. Y es que el selenio, como otros semiconductores fotosensibles, es capaz no sólo de disminuir su resistencia eléctrica ante la luz: es capaz, si las condiciones son las adecuadas, de generar una corriente eléctrica al exponerlo a la luz. Es un material no sólo fotosensible, sino fotovoltaico. De hecho, algunos de los fotómetros de selenio usados en fotografía ni siquiera necesitan una pila para funcionar, sino que la pieza de selenio genera el suficiente voltaje para el aparato al exponerlo a la luz.

Ampliar en: El Tamiz

autobus las palmas aeropuerto cetona de frambuesa