Actualidad informática

Noticias y novedades sobre informática

IBM de nuevo número uno en la lista Top500

La organización Top500 publica su clasificación de superordenadores dos veces al año. En la lista publicada en Junio de 2012, IBM alcanzó de nuevo la primera posición.

La lista ha sido publicada en la Conferencia Internacional de Supercomputación que se celebra en Hamburgo (Alemania). Por primera vez desde noviembre de 2009, la lista está encabezada por un ordenador de un fabricante de Estados Unidos.

El ordenador Sequoia consigue una potencia de 16 petaflop/s y usa la friolera de millón y medio de núcleos (cores). La tecnología usada es BlueGene/Q. Sequoia es también la de mayor eficiencia energética de la lista.

Hace relativamente poco se alcanzó la cifra de 1 petaflop/s y ya estamos camino del exaflop/s. Tan solo tenemos que multiplicar la potencia por 50. La progresión de los superordenadores es fulgurante.

BlueGene/Q sigue la tecnología de las máquinas previas BlueGene, caracterizadas por baja frecuencia de reloj (solo 1,6 GHz) y bajo consumo. Esto hace que el gasto energético sea muy inferior al de sus competidores. Los superordenadores son máquinas muy complejas y el balanceo de todas sus partes es esencial. Es por ello que los núcleos no son muy rápidos y es el conjunto de las piezas el que proporciona el rendimiento global.

El número dos en la lista es el llamado K de Fujitsu con tecnología SPARC64. Con la mitad de cores alcanza 10 petaflop/s y su gasto energético es casi el doble. China posicionó su deslumbrante Tianhe (rio del cielo) en el tope de la lista en 2010, pero la lista cambia deprisa y ya ha bajado al quinto puesto.

IBM no solo ha logrado alcanzar el número 1. Ha sido capaz de colocar 5 en la lista de los 10 más potentes, gracias sobre todo a la tecnología BlueGene/Q que implementan el 1, 3, 7 y 8. El número 4, también de IBM incorpora la tecnología iDataPlex basada en procesadores X86.

El comprador, como casi siempre es el Departamento de Energía de Estados Unidos, DOE y la instalación es en el Lawrence Livermore National Laboratory.

______________

Este es el TOP10 de superordenadores más potentes del mundo en 2015:

- Tianhe-2: en China, con 3.12 millones de núcleos y un rendimiento máximo de 33.86 petaflops/s.

- Titan: en EEUU, 560.640 núcleos, 17.59 petaflops/s.

- Sequoia: en EEUU, 1.57 millones de núcleos, 17.17 petaflops/s.

- K Computer: en Japón, 705.024 núcleos, 10.51 petaflops/s.

- Mira: en EEUU, 786.432 núcleos, 8.58 petaflops/s.

- Piz Daint: en Suiza, 115.984 núcleos, 6.27 petaflops/s.

- Shaheen II: en Arabia Saudí, 196.608 núcleos, 5.53 petaflops/s.

- Stampede: en EEUU, 462.462 núcleos, 5.16 petaflops/s.

- JUQUEEN: en Alemania, 458.752 núcleos, 5.00 petaflops/s.

- Vulcan: en EEUU, 393.216 núcleos, 4.29 petaflops/s.

Fuente: ALT1040

Bajo licencia Creative Commons

Superordenador IBM para probar la relación materia-antimateria

Las rupturas son a menudo desordenada, y en la división de las partículas subatómicas, las partículas hijas no son una excepción. Ahora la capacidad de simular un famoso decaimiento de partícula podría ayudar a responder a una de las cuestiones más candentes en la física: por qué el universo parece contener más materia que antimateria.

De acuerdo a nuestra imagen actual, el Big Bang produjo partículas y antipartículas en cantidades iguales, la mayoría de las cuales se aniquilaron mutuamente para liberar energía. En algún momento, algún factor desconocido ha llevado a la existencia de más partículas que antipartículas.

Una pista de lo que esto podría ser surgió en 1964, cuando James Cronin y Val Fitch, en la Universidad de Chicago, observaron partículas subatómicas llamadas kaones, decaer en dos piones, otro tipo de partículas.

Creemos que la antimateria es como una copia exacta de la materia, pero a la inversa, con ciertas propiedades – por ejemplo, la antipartícula de una partícula cargada tiene la carga opuesta. Sin embargo, en la descomposición de Fitch y Cronin observaron que la antimateria deben diferir en algún otro modo fundamental. Ese es el tipo de asimetría necesaria para explicar el puzzle más grande de materia-antimateria, y en 1980, la pareja ganó el premio Nobel de Física.

La comprensión de las interacciones que participan en este decaimiento del kaón ha demostrado ser difícil, sin embargo. Un mecanismo teórico de la decadencia existe, pero nadie podía saber si sus predicciones estaban a la altura de las observaciones experimentales.

Ahora un equipo de investigadores del Reino Unido, EE.UU. y Alemania han utilizado el superordenador IBM BlueGene / P del Laboratorio Nacional Argonne en Illinois, además de otras supercomputadoras, para simular un kaon decaer en dos piones, por primera vez.

El equipo utilizauna técnica llamada celosía QCD para simular una región del espacio a través de cinco femtometros, en la que cientos de interacciones entre quarks y gluones que llevan la fuerza, se llevará a cabo. «El resultado es una especie de enjambre de todos los diferentes tipos de partículas, antipartículas y gluones», dice el miembro del equipo de Norman Christ de la Universidad de Columbia en Nueva York.

El equipo comenzó mediante la simulación de un kaon compuesto por un quark down y un antiquark extraño, y luego cambió a éste en un quark abajo. El modelo estándar de física de partículas, dice que este cambio se debe generar dos pares quark-antiquark necesarias para hacer dos piones. A continuación, el equipo hace la simulación de los piones, que permita calcular la probabilidad de que efectivamente se produjo por el Kaon. Después de 281 días de tiempo en la computadora, el resultado fue un valor para la probabilidad de que el kaon decaería en dos piones, que coincide con las mediciones experimentales (arxiv.org/abs/1111.1699).

«Este es un cálculo que no podíamos siquiera hemos tocado sin este superordenador», dice Christ. Sin embargo, el trabajo, que será publicado en Physical Review Letters, no explica del todo la asimetría materia-antimateria a apuntalar la decadencia kaon. Eso requerirá una simulación más complicada en una supercomputadora más potente. Si eso está de acuerdo con el experimento también puede significar que el modelo estándar, que abarca todas las partículas y fuerzas conocidas, pero es casi seguro que incompleto, es suficiente para explicar el enigma de materia-antimateria.

Aaron Roodman del SLAC National Accelerator Laboratory, en Palo Alto, California, quien no estuvo involucrado en el trabajo, dice que cualquier desajuste todavía puede revelar la necesidad de una nueva física. «Si no están de acuerdo, entonces puede ser que tengamos algo nuevo».

Fuente: NewScientist

Nueva aplicación de IBM presenta cerca de 1000 años de historia de las Matemáticas

Nerds de las Matemáticas e historiadores, es el momento para emocionarse. Las mentes de la matemáticas moderna, una nueva aplicación para iPad publicada por IBM, que presenta una línea de tiempo interactiva de la historia de las matemáticas y su impacto en la sociedad desde 1000 hasta 1960.

La aplicación se basa en un original, 50 metros de largo «Los hombres de la Matemática Moderna», instalación creada en 1964 por Charles y Ray Eames. Las mentes de las matemáticas modernas se pueden ver una versión digitalizada de la infografía original, así como navegar a través de una línea de tiempo interactiva con más de 500 biografías, los hitos de matemáticase e imágenes de los artefactos pertinentes.

IBM espera que las clases y los estudiantes al utilizar la aplicación, provoque que más gente desee estudiar matemáticas, ciencia o educación relacionada con la tecnología .

«Las carreras del futuro dependerán en gran medida de la creatividad, el pensamiento crítico, resolución de problemas y la colaboración – todos los temas que fueron la base de las «Las Mentes de la Matemática Moderna» y siguen siendo igual de relevantes hoy en día,» dijo Chid Apte, Director de analytics Research and Mathematical Sciences en IBM , en un comunicado de prensa. «¿Qué mejor que una aplicación móvil para reintroducir este clásico atemporal para inspirar una nueva generación de estudiantes?»

A partir del primer papa francés al célebre matemático John von Neumann, los usuarios pueden ver todos los principales eventos relacionados con las matemáticas o la persona en un diseño visualmente impactante. Puede tocar en una entrada para leer más sobre esto, y ver cómo los eventos de matemáticas y las superestrellas de las matemáticas se relacionan en el tiempo con otros eventos históricos, como la primera cruzada que se apoderó deJerusalén y la firma de la Declaración de la Independencia.

Y en caso de quienes no han estudiado las matemáticas desde la escuela secundaria, la aplicación también incluye un «Peep Show IBM Matemáticas» de nueve clips animados de dos minutos que le ayudarán a repasar conceptos matemáticos, como la topología y los exponentes.

La aplicación se encuentra disponible de forma gratuita en la App Store. Pero si la versión para iPad no es suficiente, siempre puedes visitar la línea de tiempo a gran escala en exhibición en el New York Hall of Science en Queens, Nueva York y el Museo de la Ciencia, en Boston, MA.

25 aniversario del sistema operativo de IBM OS/2

Hoy se conmemora el 25 aniversario del anuncio de IBM del OS/2 ,el dos de abril de 1987. Inicialmente concebido como un sucesor de modo protegido para PC-DOS, OS/2 se convirtió en el primer sistema operativo para PC, rival serio para Microsoft Windows. Durante un tiempo, IBM y Microsoft colaboraron en él, hasta que Microsoft retiró su apoyo por diversas razones, y centró sus esfuerzos en Windows NT en su lugar.

Sin embargo, durante la mayor parte de la década de 1990, OS/2 era un sistema operativo de PC mucho más estable, seguro y fiable que Windows. Era capaz de ejecutar aplicaciones de Windows y lo hizo mejor que Windows. El OS/2 Shell fue una obra maestra de diseño orientado a objetos.

Por desgracia, IBM nunca comprendió realmente el gran potencial que OS/2 tenía y no le dio recursos de desarrollo de software y soporte de marketing para hacer que se convirtiera en un competidor formidable para PC de escritorio frente a Windows, Mac OS X y Linux.

IBM abandonó el soporte para OS/2 a finales de 2006, pero Serenity Systems International sigue vendiendo OS/2, bajo el nombre de eComStation. Ha tenido unos primeros 25 años muy interesantes y plenos de acontecimientos.

Fuente: The Inquirer

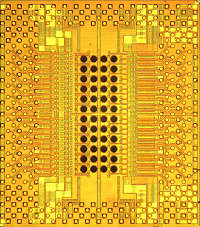

Optochip de IBM transfiere un trillón de bit de información por segundo

Los avances en las comunicaciones ópticas están siendo impulsados por una explosión de nuevas aplicaciones y servicios, así como la cantidad de datos que se crean y se transmiten a través de las redes corporativas y por los consumidores, siguen aumentando. Un terabit por segundo, el más reciente avance de IBM en tecnología de chips ópticos, proporciona cantidades sin precedentes de ancho de banda que podría algún día transportar grandes cargas de datos tales como mensajes a sitios de medios sociales, fotos digitales y videos publicados en línea, sensores utilizados para recopilar información sobre el clima, y transacciones registros de las compras en línea.»Llegar a un trillón de bit por segundo marca el último hito de Holey Optochip, la marca de IBM para desarrollar chips transceptores que pueden manejar el volumen de tráfico en la época de los datos importantes», dijo el investigador de IBM Clint Schow, parte del equipo que construyó el prototipo. «Hemos estado trabajando activamente en mayores niveles de integración, la eficiencia energética y el rendimiento de todos los componentes ópticos a través de los empaquetados y las innovaciones del circuito. Nuestro objetivo es mejorar la tecnología para su comercialización en la próxima década, con la colaboración de socios de fabricación «.Las redes ópticas ofrecen el potencial de mejorar significativamente las tasas de transferencia de datos acelerando el flujo de datos usando pulsos de luz, en lugar de enviar electrones sobre cables. Debido a esto, los investigadores han estado buscando maneras de hacer uso de señales ópticas dentro de estándares de bajo costo y alto volumen de las técnicas de fabricación de chips para uso generalizado.

Los avances en las comunicaciones ópticas están siendo impulsados por una explosión de nuevas aplicaciones y servicios, así como la cantidad de datos que se crean y se transmiten a través de las redes corporativas y por los consumidores, siguen aumentando. Un terabit por segundo, el más reciente avance de IBM en tecnología de chips ópticos, proporciona cantidades sin precedentes de ancho de banda que podría algún día transportar grandes cargas de datos tales como mensajes a sitios de medios sociales, fotos digitales y videos publicados en línea, sensores utilizados para recopilar información sobre el clima, y transacciones registros de las compras en línea.»Llegar a un trillón de bit por segundo marca el último hito de Holey Optochip, la marca de IBM para desarrollar chips transceptores que pueden manejar el volumen de tráfico en la época de los datos importantes», dijo el investigador de IBM Clint Schow, parte del equipo que construyó el prototipo. «Hemos estado trabajando activamente en mayores niveles de integración, la eficiencia energética y el rendimiento de todos los componentes ópticos a través de los empaquetados y las innovaciones del circuito. Nuestro objetivo es mejorar la tecnología para su comercialización en la próxima década, con la colaboración de socios de fabricación «.Las redes ópticas ofrecen el potencial de mejorar significativamente las tasas de transferencia de datos acelerando el flujo de datos usando pulsos de luz, en lugar de enviar electrones sobre cables. Debido a esto, los investigadores han estado buscando maneras de hacer uso de señales ópticas dentro de estándares de bajo costo y alto volumen de las técnicas de fabricación de chips para uso generalizado.

El uso de un nuevo enfoque, los científicos en los laboratorios de IBM desarrollaron el Optochip Holey con la fabricación de 48 cavidades a través de un chip de silicio CMOS estándar. Las cavidades permiten el acceso óptico a través de la parte posterior del chip a 24 canales receptores y 24 transmisores para producir un diseño ultracompacto, módulo óptico de alto rendimiento y de bajo consumo capaz de las elevadas tasas de registro de transferencia de datos.

La compacidad y capacidad de comunicación óptica se han convertido en indispensables en el diseño de grandes sistemas de manejo de datos. Con esto en mente, el módulo Holey Optochip está construido con componentes que están disponibles en el mercado hoy en día, ofreciendo la posibilidad de fabricarlos con las economías de escala.

En consonancia con las iniciativas de computación verde, el Optochip Holey logra récord de velocidad con una eficiencia energética (la cantidad de potencia necesaria para transmitir un bit de información) que está entre los mejores que se haya reportado. El transceptor consume menos de cinco vatios, la potencia consumida por una bombilla de 100 W podría alimentar 20 transceptores. Este progreso en las interconexiones de energía eficiente es necesario para permitir a las empresas que adoptan computación de alto rendimiento para manejar su carga de energía en el desempeño de aplicaciones de gran alcance, tales como análisis, modelado de datos y las previsiones.

Al demostrar los niveles sin precedentes de rendimiento, el Optochip Holey pone de manifiesto que la alta velocidad y bajo consumo de energía en las interconexiones son factibles a corto plazo y la óptica es el medio de transmisión único que puede mantenerse a la vanguardia de la demanda de aceleración mundial de la banda ancha. El futuro de la computación se basan en gran medida en la tecnología de chip óptico para facilitar el crecimiento de grandes datos y computación en la nube y el impulso de aplicaciones de próxima generación de centros de datos.

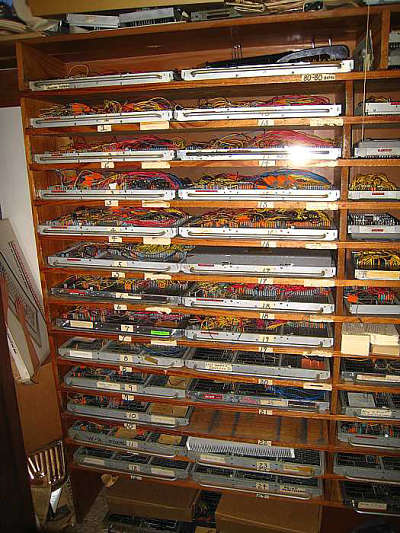

Un ordenador IBM programable mediante cableado, aún operativo

La empresa Sparkler Filters of Conroe, en Texas (EE.UU.) posee un ordenador IBM 402 que se programa aún con cables y utiliza tarjetas perforadas de 80 columnas con los datos a procesar (nada de pantallas). La empresa lo usa para contabilidad (ventas, pagos e inventario) por supuesto, antes de introducir los datos tienen que “agujerear” las tarjetas en un viejo IBM 029 (parecido a una monstruosa máquina de escribir) y luego amontonarlas en el orden correcto.

Fuente: VintageComputing.

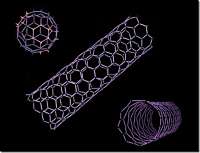

Científicos demuestran la eficacia de una nueva técnica de nanoimpresión

Científicos del Laboratorio de Investigación de IBM – Zurich con la colaboración de la ETH de Zurich han logrado posicionar los llamados nanotubos – que miden sólo 25 por 80 nanómetros – en una superficie de una manera muy precisa y sistemática con una orientación especial a nanoescala, mediante un proceso de nanoimpresión. Para demostrar que su método funciona, los científicos construyeron un Ampelmännchen «espera y cruza» (pictograma de peatones en los semáforos) de nanotubos de oro selectivamente orientados. Una aplicación interesante de este método podría ser un blindaje antifalsificación de objetos de valor como relojes, joyas u obras de arte.

Científicos del Laboratorio de Investigación de IBM – Zurich con la colaboración de la ETH de Zurich han logrado posicionar los llamados nanotubos – que miden sólo 25 por 80 nanómetros – en una superficie de una manera muy precisa y sistemática con una orientación especial a nanoescala, mediante un proceso de nanoimpresión. Para demostrar que su método funciona, los científicos construyeron un Ampelmännchen «espera y cruza» (pictograma de peatones en los semáforos) de nanotubos de oro selectivamente orientados. Una aplicación interesante de este método podría ser un blindaje antifalsificación de objetos de valor como relojes, joyas u obras de arte.

La revista Advanced Functional Materials publicó un artículo que describe este trabajo en su número del 22 de febrero 2012. Los investigadores han desarrollado un proceso de orientación e impresión a nanoescala que les permite imprimir cualquier patrón arbitrario con una resolución de partículas individual. La publicación describe cómo este método permite incluso que nanotubos oblongos se orienten específicamente en la misma dirección – longitudinal o transversalmente – preservando al mismo tiempo las propiedades a menudo únicas de los nanotubos.

El Dr. Heiko Wolf, jefe del equipo de proyecto de IBM Research – Zurich, explica, «Nosotros usamos la tensión superficial del agua y una plantilla de nanoestructuras para orientar a los nanotubos A continuación, se puede transferir a cualquier superficie a través de un proceso de nanoprinting».

Tales nanotubos, que son menores de 100 nanómetros, a menudo tienen propiedades únicas. Las partículas no esféricas son de interés debido a ciertas propiedades que pueden ser explotadas en función de su orientación. Por ejemplo, las propiedades ópticas de los nanotubos de oro utilizados en estos experimentos pueden ser dirigidas. Observado a través de un filtro de polarización, el color de la luz cambia dependiendo de la orientación de los tubos en relación con el filtro. De esta manera, los científicos han logrado crear Ampelmännchen con un peatón rojo y otro verde, con la misma clase de nanotubos, pero orientados en direcciones diferentes. Con sólo 60 micrómetros, el Ampelmännchen ® es aproximadamente 2500 veces más pequeño que los originales.

Los procedimientos adecuados para aplicar un gran número de nanoestructuras funcionales o partículas a las superficies de una manera eficiente y precisa son esenciales para la aplicación práctica de muchas innovaciones nanotecnológicas. Esta sofisticada técnica de impresión constituye un método de fabricación versátil y de gran alcance que podría prestarse a aplicaciones comerciales tales como la falsificación de pruebas o en electrónica y los sectores de TI o de tecnologías energéticas.

Fuente: PHYS.ORG

Empresas que más patentes han registrado en el 2011

La empresa especializada en patentes (IFI Claims) ha publicado la clasificación de las empresas que más patentes han registrado el año pasado a partir de los datos oficiales de la Oficina de Patentes norteamericana.

La empresa especializada en patentes (IFI Claims) ha publicado la clasificación de las empresas que más patentes han registrado el año pasado a partir de los datos oficiales de la Oficina de Patentes norteamericana.

Estas son las 10 principales empresas:

- IBM (6 180 patentes)

- Samsung

- Canon

- Panasonic

- Toshiba

- Microsoft

- Sony

- Seiko Epson

- Hon Hai Precision Industry (Foxconn)

- Hitachi

De estas diez empresas que encabezan el ranking, tan solo IBM y Microsoft son estadounidenses; el resto son todas japonesas excepto Samsung (Corea) y Hon Hai (Taiwan).

autobus las palmas aeropuerto cetona de frambuesa