Actualidad informática

Noticias y novedades sobre informática

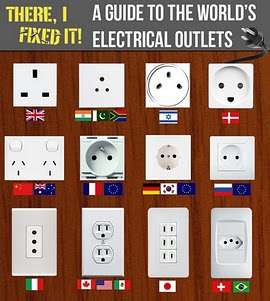

Mapa online que muestra los enchufes y conectores utilizados en cada país

En muchas ocasiones, las personas que viajan al exterior, ya sea por placer ó por negocios, desconocen los tipos de enchufes y conectores eléctricos que se utilizan en los países que deben visitar.

Para informarnos sobre éste tema, el sitio web Eurocom, dispone de un colorido mapa con ilustraciones de los enchufes y conectores, que muestra en forma muy ilustrativa, los distintos tipos de conexiones eléctricas utilizados en cada país.

En resumen, éste mapa online de Eurocon es un excelente recurso para viajeros frecuentes, que les permite estar informados sobre los enchufes y conectores eléctricos utilizados en cada uno de los distintos países del mundo, y conocer que tipo de adaptadores se necesitan para conectar sus equipos eléctricos. El servicio de Eurocon, es totalmente gratuito, y no requiere registración.

Link: Eurocom – mapa de enchufes y conectores en todo el mundo

Dispositivos de ahorro de energía. La mejor manera de ahorrar es no comprarlos

La crisis económica, unida a las continuas subidas en la factura de la electricidad está llevando a muchas familias españolas al límite de sus posibilidades. Esta situación de desesperanza es el caldo de cultivo perfecto para la aparición de productos milagro, que le permitirán ahorrar entre un 50 y un 75% de lo que paga a las eléctricas, por supuesto, sin tener que reducir el consumo.

Productos como energy saver pro, g-ner-g u otros muchos, prometen importantes ahorros simplemente enchufando a la red de su casa un aparato con una misteriosa tecnología. ¿Cómo lo consigue? Mejor dicho, ¿lo consigue?

La única manera legal de ahorrar energía es:

- sustituir las bombillas tradicionales por bombillas de bajo consumo o mejor LED.

- bajar el termostato de radiadores eléctricos y vigilar que no haya puntos de perdida de calor en ventanas, puertas, canales de ventilación de aire acondicionado etc

- apagar completamente los dispositivos que no se usa. Olvídese del stand-by. Hay dispositivos como las placas vitrocerámicas que tienen un alto consumo cuando están en stand by (es decir, siempre, a no ser que se incluya un interruptor en el circuito).

- Regular la temperatura de congelador y refrigerador. –16 y 6 grados son suficientes

- Encienda la lavadora y el lavavajillas solo cuando estén llenos.

- Olvídese de la secadora

- El aire acondicionado a 25 grados es suficiente

- Planche cuando tenga mucha ropa que planchar, empleando solo el tiempo necesario. No deje la plancha encendida mientras que va a hacer otra cosa.

La energía es la capacidad para realizar un trabajo. Se mide en Julios en el sistema internacional de unidades, pero por razones prácticas las eléctricas nos presentan el consumo de energía eléctrica en kwh. Es correcto porque la energía es el resultado de aplicar una potencia (Watio) durante un tiempo (hora):

E = P * t

Así, si usted tiene un radiador de 1000w y lo conecta durante una hora, en la factura de la luz se le cargará 1 kwh. Ningún aparato que conecte a la red eléctrica permitirá que el radiador consuma 1 kwh de energía tomando de la red eléctrica menos de esa energía, porque recordemos que la energía no puede crearse de la nada.

Los dispositivos conectados a la red eléctrica de corriente alterna (la que tenemos en casa) utilizan la energía de una manera peculiar. Parte de la energía es consumida realmente para producir un trabajo. Es la potencia activa, que se mide en watios y se representa por la letra P. La otra parte es la potencia reactiva, que surge cuando conectamos a la red motores eléctricos, cuyas bobinas almacenan temporalmente la energía en forma de campo magnético que son devueltos a la red en el siguiente ciclo. Se mide en voltio amperios reactivos (VAr) y se designa con la letra Q. La potencia aparente sería la resultante de ambas, y se mide en VoltioAmperios (VA).

Las eléctricas les cobra a las industrias por la potencia aparente y les instala las capacidades necesarias para acercar el factor de potencia lo más posible a la unidad, ya que si este factor de potencia es bajo, les obliga a poner tendido eléctrico más grueso, capaz de soportar intensidades de corriente más altas, para proporcionar una misma potencia efectiva en watios.

Si abrimos uno de estos dispositivos, comprobamos que efectivamente lo único que lleva dentro es un condensador.

Pero resulta que a los usuarios de tarifa de particulares se nos cobra solo por la potencia activa (los kW), por lo que al enchufar este aparato a la red solo le estamos produciendo ahorros a la compañía eléctrica. A nosotros no nos afecta en absoluto. Así que si quieres ahorrar, no te molestes en comprar estos aparatos. Habrás ahorrado 40 euros.

Fuente: LA MENTIRA ESTÁ AHÍ FUERA

Construye tu propio ordenador por 99 dólares

Se trata de Kano, un equipo que, con alma de la plataforma Raspberry Pi, podría cambiar el concepto de «hágalo usted mismo».

La idea es dejar que los usuarios de todas las edades dejen de consumir tecnología y comiencen a crearla a partir de plataformas libres como lo es Raspberry Pi. Según explican sus creadores a través de un video publicado en el portal de donaciones Kickstarter, el paquete básico de Kano permitirá al usuario programar su propia interfaz, armar y personalizar su computadora de una forma intuitiva y estimulante.

El paquete Kano incluye una tarjeta madre Raspberry Pi, manuales muy visuales para ensamblar la computadora, un altavoz que deberá ser construído desde el inicio, un teclado con trackpad, una carcasa, una antena Wi-Fi USB y cables HDMI y Mini-USB, entre otras cosas. El precio de este paquete que podría enseñar a chicos y grandes a programar juegos y programas, además de ensamblar una computadora desde cero, tendrá un costo de 99 dólares.

Además, el paquete incluye una tarjeta SD cargada con el sistema operativo Debian Linux modificado, juegos como Pong, Snake y Minecraft para que el usuario los programe y utilice de manera interactiva y visualmente atractiva.

Ampliar en: GADGETMANIA

El 90% de los ingresos de Mozilla en 2012 provino de Google

G

El dato procede del informe financiero anual de Mozilla correspondiente al año 2012. El total de ingresos de la Fundación Mozilla y sus filiales en 2012 fue de 311 millones de dólares, casi el doble (un 90,2% más) de los 163,5 millones que ingresó en 2011. Casi la totalidad de estos ingresos llegaron en concepto de royalties: 304,5 millones.

Una buena noticia para la fundación presidida por Mitchell Baker es que sus gastos no han crecido tan rápido como sus ingresos. En 2011, fueron de 145 millones de dólares, y en 2012 subieron el 43,4%, hasta 208 millones de dólares. De estos, el desarrollo de software se lleva la parte del león: 149 millones.

El anterior contrato de Mozilla con Google expiró en noviembre de 2011, pero fue renovado hasta noviembre de 2014. Cada vez que el contrato entre ambas entidades se acerca a su renovación, los miembros de la organización empiezan a sentir preocupación por que Google le dé la espalda a Mozilla, lo que convertiría sus proyectos en inviables económicamente.

Fuente: ITespresso.es

Por qué fallan las baterías de ion-litio

Los materiales en los electrodos de las baterías de iones de litio se expanden y se contraen durante la carga y descarga. Estos cambios de volumen favorecen la fractura de las partículas, lo que acorta la vida de la batería. Un grupo de científicos de ETH junto con colaboradores de la ISP cuantifican este efecto, por primera vez, mediante el uso de películas en 3D de alta resolución grabadas mediante tomografía de rayos x en Swiss Light Source.

Las baterías de litio se encuentran en nuestros teléfonos móviles celulares, ordenadores portátiles y cámaras digitales. Existen pocos dispositivos electrónicos portátiles que no dependan de estas fuentes de energía. Actualmente los electrodos de la batería contienen materiales activos conocidos como compuestos de intercalación. Almacenan la carga en su estructura química sin sufrir un cambio estructural importante. Eso hace que estas baterías tengan comparativamente larga vida y sean seguras. Sin embargo, los materiales de intercalación tienen un inconveniente: su densidad de energía, la cantidad de energía que pueden almacenar por unidad de volumen y masa es limitada.

En la búsqueda de baterías de mayor densidad de energía, los científicos han experimentado durante más de 20 años con materiales capaces de procesos repetitivos de aleación y desaleación con litio. Experimentos a escala de laboratorio han demostrado que las baterías con este tipo de materiales tienen densidades de energía varias veces mayores que la de los materiales de intercalación, sin embargo, estos materiales de aleación aún no son explotados en la industria debido a que su tiempo de vida es limitado. Martin Ebner, Ph.D. estudiante en el Laboratorio de Nanoelectrónica en el Departamento de Tecnología de la Información e Ingeniería Eléctrica (D-TET ) explica: » su capacidad normalmente desaparece después de un par de ciclos de carga y descarga». Esto se atribuye a una masiva – hasta tres veces – expansión del material del electrodo durante la carga. Durante la descarga, se contraen los materiales de nuevo, pero no llegan a su estado original. Partículas de los electrodos se rompen, la estructura del electrodo se desintegra, y los fragmentos pierden contacto con el resto de la célula.

Baterías, rayos X durante la operación

Para entender mejor este complejo de la degradación electroquímica y mecánica del electrodo y para comprender mejor cómo desarrollar mejores baterías, Martin Ebner el profesor de ETH y Vanessa Wood, jefe del Laboratorio de Nanoelectrónica en D – ITET, reconocieron la necesidad de estudiar en una batería los electrodos de forma no invasiva durante el funcionamiento. Para ello, recurrieron a una herramienta de imagen desarrollada por el profesor Marco Stampanoni. El professsor Stampanoni, trabaja en el Instituto de Ingeniería Biomédica de D – ITET y ejecuta la tomografía de rayos X en el Swiss Light Source, la instalación sincrotrón en el Instituto Paul Scherrer. La radiación de rayos X del sincrotrón espectralmente pura e intensa permite la adquisición rápida de imágenes de rayos X de alta resolución que pueden ser computacionalmente ensambladas en películas tridimensionales.

Los investigadores observaron en el interior de la batería, cargar y descargar más de 15 horas. Se reunieron las películas únicas, tridimensionales que captan los mecanismos de degradación que ocurren en la batería y se cuantifican los procesos que ocurren dentro de cada partícula para los miles de partículas en el electrodo. Los resultados de este estudio serán publicados en la revista Science, una versión pre-print está disponible en línea en Science Express .

Cambios estructurales irreversibles

Los datos ilustran que las partículas de óxido de estaño (SnO) se expanden durante la carga debido a la afluencia de iones de litio causando un aumento en volumen de la partícula. Los científicos demuestran que el material de litiación actúa como un proceso de núcleo-corteza, progresando de manera uniforme desde la superficie de la partícula hacia el núcleo. El material al someterse a esta reacción se expande linealmente con la carga almacenada. Las imágenes de rayos X muestran que la carga destruye la estructura de las partículas de forma irreversible con las grietas que se forma dentro de las partículas. «Esto – la formación de grietas no es al azar «, enfatiza Ebner. Las grietas crecen en lugares donde la red cristalina contiene defectos preexistentes. Durante la descarga, el volumen de la partícula disminuye, sin embargo, el material no llega a su estado original de nuevo, el proceso por lo tanto no es completamente reversible .

El cambio de volumen de las partículas individuales impulsa la expansión de todo el electrodo de 50 micrómetros a 120 micrómetros. Sin embargo, durante la descarga, los electrodos sólo se contraen a 80 micrómetros. Esta deformación permanente del electrodo demuestra que el aglutinante de polímero que contiene al electrodo aún no está optimizado para los materiales de expansión de gran volumen. Esto es crítico para el rendimiento de la batería debido a la deformación del aglutinante hace que las partículas individuales que se desconectan desde el electrodo y la batería pierdan capacidad .

Además de demostrar que la microscopía tomográfica de rayos X proporciona una idea de cambios morfológicos en las partículas y los electrodos, los investigadores muestran que esta técnica también se puede utilizar para obtener información química cuantitativa y espacial. Por ejemplo, los investigadores analizan la composición química a lo largo del electrodo de la batería para observar las diferencias en la dinámica de litiación a nivel de una sola partícula y comparar esto con el comportamiento medio de las partículas. Este enfoque es esencial para la comprensión de la influencia del tamaño de partícula, forma, y la homogeneidad de electrodo en el rendimiento de la batería .

Estas ideas sobre el funcionamiento de una batería no sería posible sin la configuración de tomografía de rayos X muy avanzada en el Swiss Light Source. «La visualización de las baterías en funcionamiento era esencialmente imposible hasta los últimos avances en tomografía de rayos X. Gracias a las instalaciones de clase mundial desarrolladas por el profesor Stampanoni y su equipo, podemos ver que hace la batería en el trabajo», añade Wood con entusiasmo.

Alternativas a los materiales cristalinos

Los investigadores eligieron óxido de estaño cristalino como un material modelo porque sufre una serie de transformaciones complejas también presentes en otros materiales, lo que permite una comprensión más profunda en el comportamiento de una variedad de materiales de la batería. Las ideas son la base para el desarrollo de nuevos materiales de los electrodos y de las estructuras de electrodos que sean tolerantes a la expansión de volumen. Para el Prof. Wood los resultados de este trabajo indican el beneficio del uso de materiales amorfos o nanoestructurados en lugar de los cristalinos». En la búsqueda de nuevos materiales, también hay que tener en cuenta que sólo son de interés industrial si pueden ser producidos en grandes cantidades a un bajo costo. Sin embargo, los materiales amorfos y nanoestructurados ofrecen un campo de juego suficiente para la innovación» subraya Wood.

Más información: Ebner M, Marone F, Stampanoni M, Wood V. Visualization and quantification of electrochemical and mechanical degradation in Lithium ion batteries. Science Express, publicado en línea 17 octubre 2013.

Skyrmion, la partícula que puede revolucionar la informática

No es la partícula de Dios, y seguramente su estudio jamás merezca un premio Nobel -además, su descubridor ya está muerto-, pero el halo de misterio que rodea a los skyrmions guarda similitudes con el bosón de Higgs. También su trayectoria es parecida. La partícula que podría inaugurar una nueva era de la informática desde el punto de vista del almacenamiento de datos fue formulada a principios de los 1960, poco antes que las primeras teorías sobre el bosón. Su padre, el físico británico Tony Skyrme, fallecido en 1987, ha pasado de puntillas por la historia de la ciencia.

Se le recuerda como un investigador modesto, de poca ambición, y a pesar de que su modelo matemático -al principio, la existencia de los skyrmions era sólo una hipótesis- solucionaba de manera solvente un problema físico de la época, a saber, el comportamiento de las partículas subatómicas, no alcanzó una gran repercusión. Tuvo mala suerte. Al menos, fue lo suficientemente audaz como para nombrar la partícula con su propio apellido.

En los 60, su hallazgo fue eclipsado por la formulación teórica de un elemento esencial de la física de partículas, los quarks, por culpa de los cuales los skyrmions llegaron al final de los 70 fatigados, como un pariente pobre de este componente fundamental de la materia.

Sin embargo, los 80 arrancaron con la aceptación del modelo de Skyrme por parte de sus colegas, pero entonces apareció en escena la teoría de cuerdas, centrando de nuevo el interés de la comunidad científica. El skyrmion desapareció del mapa: se convirtió en una partícula de culto sólo recordada por algunos nostálgicos.

Skyrme falleció, sin honores, justo antes del desarrollo de una aplicación científica que, de rebote, representaría un revulsivo para el skyrmion. En 1985, Klaus von Klitzing había obtenido el Nobel de Física por sus avances en el campo del efecto hall cuántico. Desde entonces, los dispositivos electrónicos basados en esta nueva vía fueron capaces de testar múltiples estructuras, entre ellas los skyrmions. En los 90, por fin, los científicos los vieron con sus propios ojos. La edad dorada de la partícula estaba a punto de iniciarse.

La primera aplicación

En la literatura científica, se describe a los skyrmions como un vórtice de átomos que surge al aplicar, de forma controlada, una carga magnética sobre las partículas de ciertos materiales, de tal forma que los espines de los electrones, que en condiciones normales se alinean en la misma dirección, adquieren en los skyrmions una forma de trenza.

El skyrmion halló su utilidad en una tecnología emergente emparentada con la computación cuántica, la espintrónica, cuyo principal objetivo es el desarrollo de sistemas de almacenamiento y procesamiento de datos más potentes y dotados de una mayor capacidad, gracias al desarrollo de los bits cuánticos.

Ha sido ahora cuando un equipo de investigadores del grupo Wiesendanger de la Universidad de Hamburgo ha logrado, por primera vez, leer y escribir datos utilizando skyrmions, un hito científico que se postula como una posible revolución en el futuro de los discos duros. No sólo desde el punto de vista de su capacidad: atendiendo también a una reducción significativa de su tamaño. Esto puede dar lugar a discos duros del tamaño de un grano de arroz.

Artículo completo en: Teknautas

No surgió el ojo para ver

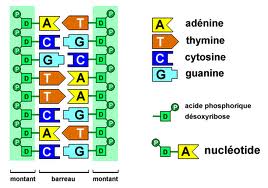

NO surgieron los oídos para oír, ni los ojos para ver, ni las piernas para andar. Oímos porque tenemos oídos, vemos porque tenemos ojos, y andamos porque tenemos piernas. La primera expresión denota la existencia de propósitos; la segunda, no. Y esa distinción es muy importante. De modo similar, Watson y Crick no investigaron la estructura del ADN para que se pudieran crear organismos transgénicos; y sin embargo, décadas después -gracias, entre otras, a sus investigaciones- se han podido crear esas modernas «quimeras».

Desde comienzos del siglo XX, ciencia y tecnología no han dejado de interaccionar. La ciencia ha sustentado el progreso tecnológico y la tecnología ha apoyado el científico. Ambas han progresado conjuntamente gracias a la curiosidad y la creatividad humana. La curiosidad ha impulsado la búsqueda de explicaciones a los fenómenos de la naturaleza, y gracias a la creatividad se han encontrado buenas explicaciones y hallado soluciones para resolver muchos problemas. A científicos e ingenieros les mueve su curiosidad y todos ellos se valen de su creatividad. La innovación es otra cosa. Innovar consiste en convertir ideas en nuevos productos, servicios o procedimientos y si, mediante su difusión, se imponen en el mercado, tienen éxito. Hay innovaciones basadas en conocimiento científico-tecnológico, y las hay basadas en otras formas de conocimiento, o en intuiciones y chispazos de unos pocos. Pero la esencia de las actividades científico-tecnológicas es diferente de la de las innovaciones. El motor de la ciencia es la curiosidad; el de la innovación es la búsqueda del éxito económico. El desarrollo científico reporta a nuestra sociedad beneficios múltiples, porque la ciencia genera conocimiento, mejora el nivel educativo y cultural de la ciudadanía, promueve la tolerancia, propicia la transparencia y es, por todo ello, un componente esencial de las sociedades abiertas. Y además, cuando es fuente de innovaciones, genera riqueza y bienestar.

La innovación es un factor de crecimiento económico y de mejora del bienestar, tanto si se basa en descubrimientos científico-tecnológicos, como si se fundamenta en otros procesos; por eso es tan importante. Pero que algo sea importante no quiere decir que su promoción deba ligarse a la de otras actividades también importantes. Raro será el joven bachiller que quiera estudiar ciencia para innovar, y raro el científico que se dedique a esa tarea con ese propósito; lo hacen para satisfacer su curiosidad.

Muchos piensan que la ciencia debe justificar su práctica y desarrollo porque es fuente de innovación. Pero eso es un error. Cuando la ciencia acaba siendo fuente de innovación ello ha sido el resultado de un proceso que bien podría haber cursado de otro modo, porque la conexión entre ciencia e innovación es azarosa, difusa. Por eso, no es bueno justificar el apoyo a la ciencia en función de la innovación que generará, porque quizás esta o aquella investigación no traigan innovación alguna; a pesar de ello, seguirá siendo socialmente beneficiosa. Al ligar a la innovación el interés de la ciencia y la tecnología se renuncia a valorar éstas por sus propios méritos, se las convierte en subsidiarias de un proceso cuyo motor y condicionantes son diferentes, y se las desposee de los atributos que las hacen atractivas y merecedoras de especial atención. En el fondo, es como si se desconfiase de su potencial, como si se considerase necesario reforzarlas con un aditamento, por el temor, quizás, de que carezcan de genuino interés. Muchas innovaciones tienen detrás investigación científica y tecnológica, pero pasa lo mismo que con el ojo: ni surgió el ojo para ver, ni se hace ciencia para innovar.

Fuente: Deia

Selenio y fotófono

En 1873 un ingeniero británico, Willoughby Smith, descubrió algo realmente inusual en el selenio, por total y completa casualidad una vez más. Willoughby estaba involucrado en la fabricación e instalación de cables submarinos de telégrafo eléctrico, y se hallaba intentando diseñar circuitos de prueba que permitiesen comprobar que el cable submarino transmitía perfectamente según se iba soltando bajo el agua.

Para su circuito de prueba hacía falta un semiconductor, y Willoughby empleó cilindros de selenio gris (recuerda, la forma cristalina), que no funcionaron bien: eran inconsistentes en sus propiedades eléctricas, de modo que presentaban una resistencia en el laboratorio y otra distinta –mucho mayor –al meterlos bajo el agua. El británico no hizo lo que imagino que hubiera hecho yo –sustituir el selenio por otro semiconductor– sino que intentó determinar por qué el selenio cambiaba su resistencia eléctrica.

Tras realizar experimentos en laboratorio Willoughby llegó a una conclusión sorprendente, que publicó en Nature bajo el título Effect of Light on Selenium during the passage of an Electric Current (Efecto de la luz sobre el selenio durante el paso de una corriente eléctrica): el selenio gris era extraordinariamente sensible a la luz. Al iluminarlo su resistencia eléctrica disminuía, de modo que al probar los circuitos bajo la luz del Sol el selenio gris conducía relativamente bien –para ser un semiconductor, por supuesto– pero al sumergirlo en las profundidades y la consecuente oscuridad su resistencia aumentaba mucho. Esto era un problema para probar cables telegráficos, pero una propiedad utilísima para muchas otras cosas.

Se trataba del primer semiconductor fotosensible que conocíamos, y los ojos de los ingenieros de todo el mundo se pusieron a hacer chiribitas. Entre ellos se encontraba nada menos que Alexander Graham Bell, que se planteó lo siguiente: ¿no sería posible convertir la voz en pulsos luminosos en un emisor y luego recibir esos pulsos con un receptor de selenio para convertirlos en impulsos eléctricos? Junto con su ayudante, Charles Sumner Tainter, Bell puso manos a la obra y los dos hombres consiguieron su propósito en 1880.

El aparato, bautizado con el magnífico nombre de fotófono, era de una sencillez propia de los genios. El emisor tenía un espejo parabólico de gran tamaño con una bombilla en su foco, que recibía directamente la voz de quien hablaba. El sonido hacía vibrar el espejo, con lo que los rayos de luz eran reflejados en distintas direcciones cuando el espejo vibraba: el haz se “esparcía” o se “concentraba” según la forma del espejo vibrante.

El receptor, a su vez, tenía otro espejo parabólico con una pieza de selenio en el foco unida a un circuito eléctrico: allí pasaba justo lo contrario. El receptor de selenio recibía pulsos de luz acompasados a la luz que llegaba al espejo, de modo que el circuito recibía pulsos eléctricos cuando el selenio recibía luz y, en consecuencia, disminuía su resistencia eléctrica. El aparato funcionaba estupendamente bien e imagino que a muchos les hubiera parecido magia. A mí lo que me sorprende es su absoluta sencillez.

El fotófono fue eclipsado unos años más tarde por la radio, pero siguió utilizándose con usos muy concretos pero importantísimos. A diferencia de las ondas de radio, mucho más difíciles de enfocar, el fotófono permitía comunicarse a distancia y sin cables de un modo muy preciso, con lo que en la guerra era muchísimo más útil que la radio… siempre que hubiera una línea de visión ininterrumpida entre emisor y receptor, por supuesto. Ése era uno de sus puntos flacos, ya que la niebla, la lluvia o una cadena montañosa lo dejaban fuera de juego.

Sin embargo, Alexander Graham Bell lo consideró hasta su muerte su mayor invento –más importante que el teléfono–, y el concepto no es tan diferente del que utilizaríamos muchos años más tarde al desarrollar la fibra óptica, que también convierte la información en pulsos luminosos que luego se transforman, en el receptor, en impulsos eléctricos. Sin embargo, ahora ya no usamos selenio como hizo Bell.

Durante un tiempo el selenio fue muy utilizado como fotorreceptor en muchos circuitos fotosensibles, como los de los fotómetros en fotografía o incluso células fotoeléctricas que usaban luz en vez de radiación ultravioleta o infrarroja como las modernas. Y es que el selenio, como otros semiconductores fotosensibles, es capaz no sólo de disminuir su resistencia eléctrica ante la luz: es capaz, si las condiciones son las adecuadas, de generar una corriente eléctrica al exponerlo a la luz. Es un material no sólo fotosensible, sino fotovoltaico. De hecho, algunos de los fotómetros de selenio usados en fotografía ni siquiera necesitan una pila para funcionar, sino que la pieza de selenio genera el suficiente voltaje para el aparato al exponerlo a la luz.

Ampliar en: El Tamiz

Nanoantenas de grafeno para una wifi de terabits por segundo

Imagina una red WiFi capaz de alcanzar velocidades de varios terabits por segundo, capaz de transferir una película en alta definición en menos de un segundo. Quizás parece utopía, pero Ian Akyildiz, del Instituto Técnico de Georgia (Georgia Tech), han desarrollado una nanoantena de grafeno capaz de lograrlo. Lo más interesante es que a distancias cortas (de pocos centímetros) se alcanzan velocidades de 100 Tbits/s lo que puede tener interés en la comunicación interna entre componentes de dispositivos electrónicos o entre redes de sensores en sistemas confinados (útiles en química, biología o medicina). Por supuesto, el mayor problema a día de hoy es el coste prohibitivo del grafeno (unos 3000 euros por metro cuadrado); en la nanoantena hay que fabricar dos trozos de grafeno de entre 2 y 100 nanómetros de ancho y un micrómetro de largo, que han de ser colocados en el lugar adecuado de la nanoantena. Quizás el grafeno trabajando a frecuencias de terahercios sea el futuro de la tecnología 5G que se podría implantar alrededor del año 2020. Nos lo ha contado Alex Wright, “Tuning In to Graphene,” News, Communications of the ACM 56: 15-17, Oct 2013 [pdf gratis].

Fuente: La Ciencia de la Mula Francis

autobus las palmas aeropuerto cetona de frambuesa