Actualidad informática

Noticias y novedades sobre informática

Nueve de noviembre, día del inventor en honor a Hedy Lamarr

El día del inventor se conmemora el nueve de noviembre por ser el cumpleaños de Hedy Lamarr (registrada al nacer con el nombre Hedwig Eva Maria Kiesler), actriz de cine austríaca de los años 30 del pasado siglo. ¿Suena un poco extraño? ¿El día del inventor, conmemorado por el nacimiento de una actriz?

La historia de esta artista e inventora resulta tan fascinante. Hedy empezó a los 16 años sus estudios de ingeniería lo que, para la época, ya era bastante extraño. Si bien era considerada extremadamente inteligente, decidió dejar la carrera y dedicarse a la actuación. Con su talento y su belleza, logró conquistar a un magnate de la industria de las armas, con quien contrajo matrimonio teniendo sólo 19 años.

Hedy, que era totalmente consciente de su inteligencia, aprovechaba cada oportunidad que tenía de compartir con los colegas de su marido para observar y aprender. Y además, entre tanto magnate y cenas de negocios, conoció a figuras históricas como Hitler y Mussolini.

Pronto sería mundialmente famosa por la secuencia de la película comercial Éxtasis, en la que, por espacio de diez minutos, aparece completamente desnuda, primero al borde de un lago, y luego corriendo por la campiña checa. Por dicha escena se la conocería como la primera mujer en la historia del cine que apareciera desnuda en una película comercial.

El matrimonio se volvió tormentoso, y Hedy decidió huir a Estados Unidos a escondidas. Es allí donde tiene la oportunidad de retomar sus estudios de ingeniería, y donde su vida dará un vuelco para destacarse en un área completamente diferente.

Los conocimientos de armas y guerras que había obtenido de su esposo comenzaron a serle útiles: empieza a investigar sobre misiles y torpedos. Ella sabía que era difícil que países en guerra utilizaran misiles dirigidos por radio, ya que las señales de estos serían muy fáciles de interceptar. Resultaba demasiado riesgoso.

Y es aquí donde aparece la chispa, esa iluminación necesaria en la mente del inventor para saltar al estrellato. ¿Qué pasaría si dichas frecuencias pudieran modificarse continuamente? Se complicaría así muchísimo su intercepción.

Basándose en el diseño de una pianola, Hedy Lamarr inventó lo que sería el precursor del Espectro por salto de frecuencia, o una señal de radio que se transmite en forma de varias radiofrecuencias aleatorias, lo que hace que el enemigo que pudiese llegar a interceptar dichas señales sólo obtenga un ruido indescifrable. Después de algunos meses de trabajo, en 1942, Hedy y su nueva pareja, un músico estadounidense llamado George Antheil, obtuvieron la patente de su invención.

La tecnología diseñada por Hedy, que hoy se conoce como «Espectro ensanchado», se sigue utilizando en la actualidad para diversos aparatos electrónicos, de uso tanto militar como civil, principalmente en telecomunicaciones y transmisión de distintos tipos de datos.

Si bien Hedy Lamarr no logró pasar a la historia como una gran actriz, e incluso después de su incursión en la tecnología empezó a desaparecer y terminó su vida (murió el 19 de enero de 2000) de una forma más bien decadente (incluso fue sorprendida robando de tiendas), sin duda su legado ingenieril ha sido importantísimo para el desarrollo de las telecomunicaciones.

Fuente: esceptica

¿Existe algo totalmente impredecible en la naturaleza?

Antonio Acín (ICFO/ICREA, Barcelona, ??España) y varios colegas responden a esta pregunta en un artículo en Nature Communications que presenta un protocolo cuántico para amplificar la aleatoriedad de los eventos naturales que sean aleatorios para hacerlos completamente aleatorios. El artículo no demuestra que estos eventos existan en la Naturaleza, pero introduce la siguiente dicotomía: o bien nuestro universo es completamente determinista, o bien existen eventos naturales que son totalmente aleatorios. Todo el mundo sabe que la física clásica es totalmente determinista (aunque el caos determinista limita su predictibilidad) y que la física cuántica permite lo aleatorio, aunque ello no implica la existencia de cualquier forma de aleatoriedad en la Naturaleza. El problema de distinguir entre (pseudo)aleatoriedad y aleatoriedad completa puede parecer de interés sólo para los filósofos, pero también es importante desde un punto de vista práctico, pues los bits aleatorios son útiles en muchas aplicaciones (protocolos criptográficos, juegos de azar o simulación numérica de sistemas físicos y biológicos). El artículo técnico es Rodrigo Gallego et al., “Full randomness from arbitrarily deterministic events,” Nature Communications 4: 2654, 30 Oct 2013 (arXiv:1210.6514 [quant-ph]).

En física clásica cualquier aleatoriedad observada un sistema es manifestación de nuestra descripción imperfecta de dicho sistema. En física cuántica todas las predicciones de los resultados de los experimentos se describen en términos probabilísticos (esto llevó a que físicos como Albert Einstein pensaran que es una descripción incompleta de la realidad). Sin embargo, los teoremas de no-go de John Bell implican que las teorías de variables ocultas (que explican la cuántica aludiendo a un mundo subcuántico clásico) son incompatibles con las predicciones de la mecánica cuántica. En concreto, todas las teorías de variables ocultas compatibles con una estructura causal local predicen correlaciones entre los eventos separados un intervalo de tipo espacio que satisfacen las llamadas desigualdades de Bell, pero estas desigualdades son violadas por algunas correlaciones entre partículas cuánticas. Estas correlaciones tienen su origen en la no-localidad de la física cuántica.

Artículo completo en: Francis (th)E mule Science’s News

Transistores sinápticos

No hace falta ser un Watson para darse cuenta de que incluso los mejores superordenadores del mundo son asombrosamente máquinas ineficientes y de alto consumo energético.

Nuestro cerebro tiene más de 86000 millones de neuronas, conectadas por sinapsis que no sólo completan circuitos lógicos innumerables, sino que continuamente se adaptan a los estímulos, mediante el fortalecimiento de algunas conexiones al tiempo que se debilitan las demás. Lo llamamos proceso de aprendizaje, y permite el tipo de procesos computacionales rápidos y altamente eficientes que dan vergüenza a Siri y Blue gene

Los científicos de materiales en la Escuela de Ingeniería y Ciencias Aplicadas (SEAS) de Harvard han creado un nuevo tipo de transistor que imita el comportamiento de una sinapsis. El nuevo dispositivo modula simultáneamente el flujo de información en un circuito y se adapta físicamente a los cambios de señales.

La explotación de las propiedades inusuales de materiales modernos, en el transistor sináptico podría marcar el comienzo de un nuevo tipo de inteligencia artificial: no con algoritmos inteligentes sino mediante la propia arquitectura de un ordenador. Los hallazgos aparecen en la revista Nature Communications.

«Hay un interés extraordinario en la construcción de electrónica de bajo consumo en estos días», dice el investigador principal Shriram Ramanathan, profesor asociado de ciencias de los materiales en SEAS, Harvard. «Históricamente, las personas se han concentrado en la velocidad, pero con la velocidad viene la disipación de energía. Con la electrónica cada vez más poderosa y omnipresente, podría tener un gran impacto al reducir la cantidad de energía que consumen.»

La mente humana, con toda su potencia de cálculo fenomenal, se ejecuta con aproximadamente 20 vatios de energía (menos de una bombilla del hogar), por lo que ofrece un modelo natural para los ingenieros.

«Hemos demostrado que es realmente análogo de la sinapsis en el cerebro», dice el coautor principal Jian Shi, un becario postdoctoral en SEAS. «Cada vez que una neurona inicia una acción y otra neurona reacciona, la sinapsis entre ellas aumenta la fuerza de su conexión. Y a más rapidez del pico de neuronas cada vez, más fuerte será la conexión sináptica. Esencialmente, se memoriza la acción entre las neuronas.»

En principio, un sistema de integración de millones de diminutos transistores y terminales sinápticas neuronales podría llevar la computación paralela a una nueva era de alto rendimiento ultraeficiente.

Mientras que los iones de calcio y los receptores efectuan un cambio en una sinapsis biológica, la versión artificial logra la mismo plasticidad con iones de oxígeno. Cuando se aplica un voltaje, estos iones se deslizan dentro y fuera de la red cristalina de una película muy delgada (80 nanómetros) de niquelato de samario, que actúa como el canal de sinapsis entre dos terminales de platino «dendrita» «axón» y. La concentración variable de iones en el niquelato aumenta o disminuye su conductancia – es decir, su capacidad para transportar información en una corriente eléctrica – y, al igual que en una sinapsis natural, la fuerza de la conexión depende del retardo de tiempo en el señal eléctrica.

Estructuralmente, el dispositivo consiste en el semiconductor de niquelato intercalado entre dos electrodos de platino y adyacente a un pequeño depósito de líquido iónico. Un circuito externo multiplexor convierte el tiempo de retardo en una magnitud de tensión que se aplica al líquido iónico, la creación de un campo eléctrico impulsa los iones ya sea hacia el niquelato o los elimina. Todo el dispositivo, sólo unos cientos de micrones de largo, está integrado en un chip de silicio.

El transistor sináptico ofrece varias ventajas inmediatas sobre los transistores de silicio tradicionales. Para empezar, no se limita al sistema binario de unos y ceros.

«Este sistema cambia su conductancia de una manera analógica, de forma continua, como la composición del material cambia,» explica Shi. «Sería bastante difícil de usar CMOS, la tecnología de circuitos tradicionales, para imitar una sinapsis, porque las sinapsis biológicas reales tienen un número prácticamente ilimitado de posibles estados, no sólo on u off.

El transistor sináptico ofrece otra ventaja: la memoria no volátil, lo que significa que incluso cuando se interrumpe la alimentación, el dispositivo recuerda su estado.

Además, el nuevo transistor es inherentemente eficiente con la energía. El niquelato pertenece a una clase inusual de materiales, llamado sistemas de electrones correlacionados, que pueden sufrir una transición aislante-metal. A una cierta temperatura – o, en este caso, cuando se expone a un campo externo – la conductancia del material cambia de repente.

«Aprovechamos la extrema sensibilidad de este material», dice Ramanathan. «Una muy pequeña excitación le permite obtener una señal grande, por lo que la energía de entrada necesaria para impulsar este cambio es potencialmente muy pequeña. Eso podría traducirse en un gran impulso a la eficiencia energética.»

El sistema niquelato también está bien posicionada para una perfecta integración en los sistemas basados ??en silicio existentes.

«En este trabajo se demuestra la operación a alta temperatura, pero la belleza de este tipo de dispositivo es que el comportamiento del» aprendizaje «es más o menos insensible a la temperatura, y eso es una gran ventaja», dijo Ramanathan.»Podemos operar en cualquier lugar entre la temperatura ambiente hasta por lo menos 160 Celsius.»

Por ahora, las limitaciones se refieren a los desafíos de la síntesis de un sistema de material relativamente inexplorada, y para el tamaño del dispositivo, lo que afecta a su velocidad. «En nuestro dispositivo de prueba de concepto, la constante de tiempo está realmente establecido por nuestra geometría experimental», dijo Ramanathan. «En otras palabras, hacer realmente un dispositivo súper rápido, lo único que tendría que hacer es limitar el líquido y colocar el electrodo de puerta más cerca de él.»

De hecho, Ramanathan y su equipo ya están planeando, con expertos de microfluidos en SEAS, para investigar las posibilidades y los límites de este «ultimate fluidic transistor.»

También cuenta con una subvención de la Academia Nacional de Ciencias para explorar la integración de transistores en los circuitos sinápticos bioinspirados, con L. Mahadevan, profesor Lola England de Valpine de Matemática Aplicada, de biología organicista y evolucionista y profesor de física.

«En SEAS es muy emocionante establecer que somos capaces de colaborar fácilmente con personas de intereses muy diversos», dice Ramanathan.

Para el científico de materiales, mucha curiosidad deriva de la exploración de las capacidades de los óxidos correlacionados (como el niquelato utilizado en este estudio) a partir de las aplicaciones posibles.

«Hay que crear nuevos instrumentos para poder sintetizar estos nuevos materiales, pero una vez que eres capaz de hacer eso, de verdad tienes un sistema completamente nuevo de material cuyas propiedades son prácticamente inexploradas», dice Ramanathan. «Es muy emocionante tener esos materiales para trabajar, que se sabe muy poco sobre ellos y se tiene la oportunidad de construir conocimiento a partir de cero.»

Esta investigación fue financiada por la National Science Foundation (NSF), Army Research Office’s Multidisciplinary University Research Initiative, y la Air Force Office of Scientific Research..El equipo también se benefició de las instalaciones del Centro de Harvard para sistemas de nanoescala, miembro de la Red de Infraestructura Nacional de Nanotecnología apoyado por la NSF. Sieu D. Ha, un becario postdoctoral en SEAS, fue el coautor principal, coautores adicionales incluyen estudiante graduado Usted Zhou y Frank Schoofs, un exestudiante postdoctoral.

Fuente: Jian Shi, Sieu D. Ha, You Zhou, Frank Schoofs, Shriram Ramanathan. A correlated nickelate synaptic transistor.Nature Communications, 2013; 4 DOI: 10.1038/ncomms3676

Nuevo software que resuelve CAPTCHA

CAPTCHA, el método para distinguir humanos de robots usando textos distorsionados, ha sido crackeado por la compañía Vicarious. Su objetivo, sin embargo, no es usar el software de forma maliciosa ni siquiera venderlo, sino avanzar en la senda de una verdadera inteligencia artificial.

En 1950, Alan Turing publicó un artículo en la revista Mind en el que se preguntaba ¿Pueden pensar las máquinas? Para resolver la pregunta sin ambigüedad, propuso el famoso test de Turing: un examinador hace preguntas a dos individuos que se hallan en otra habitación y se comunican por teletipo (el método ideal en tiempos de Turing, hoy sería simplemente internet). ¿Qué sucedería si una máquina tomara el papel de uno de ellos? ¿Sería capaz el examinador de descubrir a la máquina?

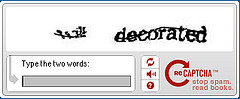

La forma más popular de distinguir humanos de robots es un algoritmo desarrollado en 2000 por la Carnegie Mellon University llamado CAPTCHA. Sus siglas significan Test de Turing público completamente automatizado para distinguir entre humanos y ordenadores. Más de 100.000 sitios web usan el algoritmo para distinguir la inteligencia basada en carbón (animal) de la basada en silíceo (ordenadores).

CAPTCHA presenta un conjunto de letras distorsionadas que un humano reconoce y un robot no (he de confesar que en múltiples ocasiones las letras presentadas me han resultado tan complicadas que me ha producido una notable irritación pasar de una secuencia fallida a otra). En 2009, Google presentó reCAPTCHA, una versión del algoritmo que además de su propósito original, es uno de los mayores esfuerzos de crowdsourcing que se están llevando a cabo. Se utiliza para descifrar palabras ilegibles de libros digitalizados. reCAPTCHA presenta dos palabras: una es conocida por el software y la otra es un texto digitalizado de un libro en papel que el sistema OCR (reconocimiento óptico de caracteres) ha sido incapaz de reconocer. Si el usuario acierta con la palabra conocida, el sistema asume que también lo ha hecho con la desconocida que se da por buena. De este modo, todos contribuimos al reconocimiento de textos en libros digitalizados.

CAPTCHA ha resultado sumamente útil. La única forma de romperlo de forma masiva en la actualidad es contratar empresas de mano de obra barata que usan a personas. Empresas con personal en Bangladesh que rompen siete CAPTCHAs por minuto a 50 céntimos la hora.

Para considerar CAPTCHA batido, basta con resolverlo un 1% de las veces. Ahora, una empresa llamada Vicarious dice ser capaz de resolverlo un 90% de las veces. Según la compañía, su intención no erar resolver CAPTCHA sino avanzar en una inteligencia artificial más parecida a la humana y la resolución de CAPTCHA es un simple subproducto. No pretenden usarlo de forma fraudulenta sino que es una demostración de cómo sus algoritmos emulan el funcionamiento del cerebro y de hecho, esto es solo una parte del camino de la emulación cerebral.

Vicarious dice que sus métodos son incluso más impresionantes que el aprendizaje que mostró el famoso IBM Watson. Ellos tratan de encontrar las matemáticas que subyacen a los procesos cerebrales. Vicarious ha recibido 15 millones de dólares de inversores como Dustin Moskovitz, cofundador de Facebook o el ex CEO de PayPal Peter Thiel.

El software de Vicarious: emula la visión humana en lo que ellos llaman redes corticales recursivas. Una capa de nodos detecta pixels. La siguiente capa detecta una agrupación específica de pixeles. La siguiente capa detecta una parte de una forma concreta. El proceso se repite hasta en ocho capas y usa más de ocho millones de nodos. Pusieron a trabajar el software para resolver un problema concreto y el resultado es que han resuelto CAPTCHA.

Fuente: ALT1040

Licencia CC

Teleportación cuántica de fotones

Gracias a una tecnología híbrida, es posible realizar una transmisión muy fiable de bits cuánticos fotónicos, como se ha demostrado en un experimento cuyos resultados han sido analizados cuidadosamente.Mediante el entrelazamiento cuántico de campos de luz separados en el espacio, unos investigadores japoneses y alemanes han conseguido teleportar qubits (bits cuánticos) fotónicos con notable fiabilidad. Esto significa que se ha logrado dar un paso decisivo una década y media después de los primeros experimentos en el campo de la teleportación óptica. El éxito del experimento llevado a cabo en la ciudad japonesa de Tokio es atribuible al uso de una técnica híbrida en la cual se han combinado dos enfoques tecnológicos conceptualmente distintos y que antes se consideraban del todo incompatibles.En la teleportación cuántica se transfieren estados cuánticos arbitrarios desde un emisor, a quien aquí podemos referirnos como Isabel, hasta un receptor, a quien podemos llamar Miguel, que está alejado en el espacio. Esto requiere que Isabel y Miguel inicialmente compartan un estado de entrelazamiento cuántico a través del espacio que les separa, un entrelazamiento cuántico que puede por ejemplo estar en la forma de fotones entrelazados cuánticamente.

La teleportación cuántica es de importancia fundamental para el procesamiento de información cuántica (la base de la computación cuántica) y la comunicación cuántica. Los fotones son particularmente valiosos como portadores de información ideales para la comunicación cuántica, ya que se les puede usar para transmitir señales a la velocidad de la luz. Un fotón puede representar un bit cuántico, al que se llama abreviadamente «qubit» y que es comparable a un dígito binario (bit) de un sistema clásico de procesamiento de información.

Los primeros intentos de teleportar fotones (partículas de luz) individuales fueron realizados por el físico austriaco Anton Zeilinger. Desde entonces, se han realizado varios experimentos relacionados con este concepto. Sin embargo, la teleportación de bits cuánticos fotónicos utilizando métodos convencionales ha demostrado tener limitaciones debido a deficiencias experimentales y dificultades con principios fundamentales.

Lo que hace que el experimento realizado en Tokio sea tan diferente es el uso de una técnica híbrida. Con su ayuda se ha logrado la teleportación cuántica completamente determinista, y de fiabilidad bastante buena, de qubits fotónicos. La precisión de la transferencia fue de entre un 79 y un 82 por ciento para cuatro qubits diferentes. Además, se teleportaron los qubits con una eficiencia mucho mayor que en experimentos anteriores, incluso con un grado bajo de entrelazamiento cuántico.El concepto de entrelazamiento cuántico fue formulado por primera vez por Erwin Schrödinger, y describe una situación en la que dos sistemas cuánticos, como por ejemplo dos partículas de luz, están en un estado conjunto, por lo que sus comportamientos son mutuamente dependientes a un nivel mayor del que es posible normalmente (bajo condiciones clásicas). En el experimento de Tokio, se consiguió el entrelazamiento continuo mediante la estrategia de entrelazar muchos fotones en «parejas». Los experimentos previos sólo tuvieron un fotón entrelazado cuánticamente con otro fotón, una solución menos eficiente.»El entrelazamiento de fotones funcionó muy bien en el experimento realizado en Tokio, prácticamente al pulsar un botón, tan pronto como el láser se encendía», destaca el profesor Peter van Loock de la Universidad Johannes Gutenberg en Maguncia, Alemania. Como físico teórico, van Loock asesoró a los físicos experimentales del equipo de investigación dirigido por el profesor Akira Furusawa, de la Universidad de Tokio, sobre cómo podían realizar más eficientemente el experimento de teleportación para poder lograr el éxito de la teleportación cuántica. Este entrelazamiento continuo se logró con la ayuda de «luz comprimida».

Fuente: resolviendo.co

Problemas excepcionales demandan ordenadores escepcionales

Las proteínas realizan la mayor parte del trabajo de la célula, catalizan la mayoría de las reacciones bioquímicas, inician y median las señales eléctricas en las neuronas y constituyen una parte importante de la estructura de nuestro cuerpo. Formadas por hasta varios miles de aminoácidos (de un conjunto de 20 tipos diferentes) encadenados entre ellos, las proteínas se pliegan bajo el efecto de fuerzas no covalentes entre diferentes partes de la molécula en formas con significado funcional; formas que no son estáticas, que cambian constantemente, al azar y también reaccionan a la influencia externa. Estos cambios conformacionales tienen un impacto en su función, lo que permite que las proteínas interactúen entre sí o con otras moléculas de señalización (hormonas, medicamentos …). El mal plegamiento de proteínas o modificaciones de los cambios conformacionales conducen a enfermedades, incluyendo la enfermedad de Alzheimer y Parkinson, y mucho dinero y esfuerzo se está poniendo en la comprensión de las estructuras de proteínas, caminos de plegado e interacciones con otras moléculas.

Varias herramientas experimentales se utilizan para estudiar la conformación de proteínas, pero todos están limitadas en su resolución espacial y temporal. En efecto, la más poderosa entre ellas, difracción de rayos X, sólo proporciona una instantánea de la estructura de las proteínas. Si queremos estudiar la dinámica de proteínas (como la conformación de una molécula cambia con el tiempo), entonces la simulación por ordenador ofrece una buena alternativa. Una simulación exacta requiere resolver las ecuaciones de la mecánica cuántica para moléculas grandes, pero esto es computacionalmente demasiado complicado para ser práctico. La dinámica molecular (MD) simula cada átomo de la molécula como evoluciona siguiendo las reglas de la mecánica clásica y campos de fuerza semi-empíricos. Las simulaciones MD se han utilizado desde mediados de los setenta para entender los procesos bioquímicos, y actualmente representan la mayor parte del tiempo asignado a ordenadores destinados a la investigación biomédica en los centros de supercómputo de la Fundación Nacional para la Ciencia, EE.UU..

A pesar de su popularidad, las simulaciones MD son computacionalmente costosas. La necesidad de captar las vibraciones de átomos rápidos requiere de pasos de cálculo de unos pocos femtosegundos, y cada paso involucra uno mil millones de operaciones para una molécula de cien mil átomos. Para simular un milisegundo en la vida de una única molécula de proteína se necesitan alrededor de mil millones de pasos y un sextillón (10 ^ 21) de operaciones. Como resultado, incluso utilizando los superordenadores más potentes disponibles, la mayoría de las simulaciones MD sólo estudian los procesos en tiempos de nanosegundos o microsegundos. Se necesitaría un tiempo excesivamente largo de supercomputadora para llegar a las escalas de tiempo de milisegundos en el que tienen lugar muchos cambios conformacionales de proteínas y sus interacciones. En un. Documento reciente Ron O. Dror y sus colegas de D. E. Shaw Research muestran estudios recientes que están superando este problema.

Una solución, el cálculo de las diferentes partes de la molécula en paralelo, ha demostrado ser particularmente difícil. Las innovaciones recientes en los algoritmos paralelos han mejorado parcialmente la situación, permitiendo agrupaciones de superordenadores para calcular en el plazo de tiempo de microsegundos. De hecho, en algunos problemas, parte de la simulación puede ser dividida en muchas trayectorias separadas cortas que se pueden ejecutar en paralelo en cientos de miles de ordenadores personales. Este es el proyecto Folding@Home, que permite a cualquier persona con un ordenador (o incluso una PlayStation moderna) y conexión a internet la oportunidad de donar tiempo de simulación y colaborar con la investigación científica. Más de cien estudios publicados se han producido gracias a esta iniciativa.

Los mayores avances en la optimización de simulación MD se han confeccionado siguiendo esa ruta de adaptar nuestras herramientas para la tarea. Esta es una solución bien conocida en ingeniería y en biología. Por ejemplo, los ojos se adaptan a las escenas que puedan ver, haciéndolos más eficientes, y los oídos a los sonidos que puedan escuchar. En la ingeniería del ordenador, las unidades de procesamiento gráfico (GPU) fueron diseñadas para operaciones con gráficos y en esa tarea es que superan a los procesadores generales mucho más potentes. Son particularmente un buen ejemplo del hecho de que el hardware de propósito integrado puede conducir a la computación más eficiente de problemas particulares.

La investigación de D. E. Shaw seguido esta idea en el diseño de una máquina específicamente diseñada para simulación MD, llamada Anton. Sus chips, contienen un «conjunto de unidades aritméticas de lógica cableada para el cálculo de las interacciones de partículas», están conectados entre ellos de una manera que evita el uso de la gestión de memoria que es computacionalmente cara. Anton lleva a cabo todas sus operaciones en circuitos construidos para tal fin, a diferencia de proyectos anteriores (FASTRUN, Motor MD, MDGRAPE), donde sólo las partes más costosas computacionalmente de la simulación fueron optimizados. Gracias a esta arquitectura especial, Anton puede realizar 20 microsegundos de una simulación MD de todos los átomos por día, alrededor de 100 veces más rápido que cualquier otra alternativa.

En su opinión, los desarrolladores de Anton sugiern problemas que son susceptibles de beneficiarse de los avances en este campo. Mejores simulaciones MD ayudarán en el desarrollo de fármacos, mediante la producción de predicciones más precisas de la eficacia con que se unen a las proteínas, y en el diseño de proteínas para ser utilizadas como biosensores para el cáncer o anticuerpos. Además, el estudio de la dinámica de otras moléculas grandes tales como ARN y ADN también se beneficiarán de la construcción de ordenadores especiales.

Fuente: Exceptional problems demand exceptional computers en Mapping Ignorance.

Tecnología de correo electrónico a prueba de vigilancia

No es sorprendente buscar un proveedor de correo electrónico más seguro después de toda la debacle de la vigilancia gubernamental. Por eso Circle Lavabit y Silent han unido sus fuerzas en Dark Mail Alliance para el desarrollo de una nueva tecnología de correo electrónico a prueba de espías. El correo Dark Mail’s «Email 3.0» aplica tecnología de cifrado peer-to-peer no sólo para el cuerpo de la misiva digital, sino también a sus metadatos (campos: A:, De: y Asunto ) que terceras personas tienen más probabilidades de ver. Una desventaja es que el cifrado sólo funciona entre las cuentas de correo Dark Mail los mensajes enviados utilizando la tecnología a direcciones de Gmail o Hotmail no serán protegidos de miradas indiscretas. Las dos empresas son conocidas, se debe a que sus desarrollos se usaban para ofrecer servicios de correo electrónico seguro, con problemas legales a principios de este año. Sin embargo, están decididos a resurgir de sus cenizas y poner su tecnología a disposición del público a través de aplicaciones móviles y de escritorio para el año 2014.

Fuente: endgaget

autobus las palmas aeropuerto cetona de frambuesa