Actualidad informática

Noticias y novedades sobre informática

Funcionamiento del sistema DNS de internet

Los servidores DNS son una pieza fundamental dentro del funcionamiento de Internet. Sin los servidores DNS sería muy complicado, por no decir imposible, navegar puesto que son los encargados de traducir un nombre de dominio a la dirección IP que le corresponde y, por tanto, ayudan a trazar ese camino que surcarán los paquetes de datos entre nuestro ordenador y el servidor que aloja una página web o un servicio determinado.

Apple patenta un diseño de ordenador sin pantalla y con proyector

51 patentes ha presentado Apple en la oficina de patentes y marcas de Estados Unidos (UPSTO), que revelan la intención de la firma de presentar, en un futuro próximo, una nueva generación de ordenadores Mac que funcionarían sin pantalla y estarían dotados de un proyector inteligente.

La nueva patente describe un ordenador sin cables que “no requeriría de un gran espacio físico” para su uso y que aprovecharía cualquier tipo de superficie vertical para proyectar la pantalla mediante un proyector inteligente. La nueva generación de ordenadores dispondrían así de la misma potencia que un ordenador de sobremesa y al estar dotado de un proyector inteligente, este dispositivo permitiría que el usuario pudiera trabajar con su equipo siempre que pudiera encontrar “una superficie en la que poder proyectar la imagen de la pantalla”, asegura el texto que ha sido registrado en la oficina de patentes de EE.UU.

Fuente: ITespresso.es

La encuesta del millón de muertes

La muerte en La India es un asunto privado. El epidemiólogo Prabhat Jha y otros investigadores llevan años luchando porque la situación cambie y los millones de muertes que se producen en el país, muchas en remotas aldeas, aparezcan en algún registro público. Un programa estatal bautizado como el Estudio del Millón de Muertes (Million Death Study) pretende documentar las muertes producidas entre 1997 y 2013 mediante encuestas personales a un millón de individuos. Hasta el momento llevan realizadas 450000 y los primeros datos están sirviendo para trazar un mapa de la mortalidad en el país que ya se está utilizando para cambiar la política sanitaria.

Tal y como explican en Nature, cuando tenía solo diez años el propio Prabhat Jha vivió la experiencia de la ‘muerte anónima’. Él y su familia vivían en Canadá cuando recibieron la noticia de que su abuelo había muerto en La India. La causa no estaba clara y, como sucede de forma habitual, el anciano había muerto en su casa, sin visitar ningún hospital. La madre de Jha regresó a la aldea en busca de información, pero no averiguó nada. Años más tarde, cuando Jha se hizo médico, revisó las notas de su madre y llegó a la conclusión de que su abuelo había muerto por un infarto cerebral, aunque la causa de la muerte nunca constará en los archivos públicos ni en ninguna estadística.

Los esfuerzos por documentar las causas de las muertes están dando sus primeros frutos. La revista Nature publicaba hace unos días una serie de gráficos ilustrando los niveles de incidencia de distintas enfermedades por regiones. El proceso consiste en la visita sobre el terreno de unos 900 encuestadores que acuden a distintos lugares del país para preguntar por la causa de muertes no registradas. Con los datos obtenidos, dos médicos analizan cada caso y concluyen esta denominada “autopsia verbal” que determina la causa de la muerte.

El sistema alternativo que se propone consiste en introducir los síntomas en un programa matemático y determinar conforme al modelo estadístico cuál es la afectación real de la enfermedad. Algunos estudios apuntan que los ordenadores pueden ser más precisos que los propios médicos a la hora de determinar cuál ha sido la causa de una enfermedad, y ya se está utilizando un modelo mixto en casos como el programa INDEPTH, que registra los nacimientos y muertes en 17 países africanos y asiáticos con un modelo probabilístico y verbal a la vez. El objetivo, en cualquier caso, es acercarse lo más posible a la realidad para poder determinar de qué muere la gente, cómo se extienden las enfermedades y qué medidas se pueden tomar para atajarlas.

Referencias: Global health: One million deaths (Nature) | Verbal autopsy methods questioned (Nature) | Más info: Million Death Study

Artículo completo en: CUADERNO DE CULTURA CIENTÍFICA

Economía sumergida de los hackers

Según un estudio de Dell sobre la economía sumergida del hacking, eso es lo que se paga de media a un hacker por los datos de una tarjeta de crédito Visa o Mastercard estadounidense. Obviamente, no encontraréis estos servicios buscando en Google: hay que irse a partes más oscuras de la red, sólo accesibles buceando con herramientas como Tor.

Los precios varían. En el caso de necesitar más datos para usar la tarjeta de crédito, puedes conseguir todos los datos de la identidad de una persona (incluyendo teléfonos, PINs de tarjetas y números de la seguridad social) por 25 dólares. Incluso puedes conseguir acceso a una cuenta bancaria con entre 70000 y 150000 dólares por el módico precio de 300 dólares.

Eso sí, no estamos hablando de cuentas o tarjetas específicas, sino una cualquiera de las que los hackers tendrán almacenadas. Y es que cada vez que un usuario poco precavido instala un keylogger o un troyano, los datos que obtienen no se explotan directamente: los analizan y almacenan para después venderlos.

¿Por qué hacerlo así y no sacar directamente el dinero de esas cuentas robadas? La razón es sencilla: para mantenerse ocultos. Es difícil saber cuándo y por qué se filtraron las credenciales de tu cuenta bancaria, pero en el momento en el que en esa cuenta haya movimientos sospechosos será fácil encontrar al culpable. Y al que encontrarán no será al hacker original, sino al que ha comprado la cuenta si no ha tomado las precauciones necesarias. Un regalo envenenado, como quien dice.

Pero no sólo hay almacenes de cuentas bancarias y tarjetas. El estudio de Dell comenta los precios para otros servicios, digamos, poco ortodoxos: hasta 100 dólares por obtener todos los datos posibles de una persona concreta a través de redes sociales, ingeniería social e infección con troyanos; troyanos con kits anti-detección por algo menos de 300 dólares; o redes de hasta 15.000 bots por 250 dólares.

Fuente: GENBETA

Licencia CC

Adornos navideños cuánticos

Desde hace pocos la iluminación de las calles en las fiestas cambió radicalmente. Además del cambio estético, también supuso un importante cambio tecnológico. Las bombillas incandescentes tradicionales fueron sustituidas por bombillas LED (Light Emitting Diode). La bombilla incandescente, es decir, la bombilla de toda la vida, no tiene nada que ver con estas nuevas bombillas LED, ni tampoco su rendimiento energético.

En la bombilla incandescente, la corriente eléctrica pasa por un filamento de wolframio (o tungsteno) extremadamente delgado -su espesor apenas supera una décima de milímetro- y largo -desenrollado mide más de 2 metros-. Debido a la elevada resistencia eléctrica del filamento, éste se calienta hasta alcanzar temperaturas superiores a los 2000 C. Los objetos que se encuentran a esas temperaturas emiten radiación visible, con lo que la bombilla emite luz. Sin embargo, la mayor parte de la radiación que emiten estas bombillas es infrarroja, que nosotros percibimos en forma de calor. De hecho, esa es la principal causa de la ineficiencia de las bombillas incandescentes, en las que sólo el 10% de la energía aportada se transforma en luz, el resto se pierde en forma de calor.

Las bombillas LED son totalmente diferentes y, aunque pueda parecer extraño, su funcionamiento es una consecuencia directa de la física cuántica. Son luces cuánticas. Curiosamente, el mecanismo que explica la emisión de luz en un LED es el opuesto al efecto fotoeléctrico, por el que Einstein recibiera el Premio Nobel en 1921. Si en el efecto fotoeléctrico la aplicación de luz sobre una material metálico induce una corriente eléctrica, en un LED se crea luz al aplicar corriente. Un LED es un diodo, cuyo componente principal es un semiconductor. Cuando la corriente pasa a través del semiconductor los electrones del diodo aumentan su energía pero inmediatamente después vuelven a su estado energético inicial emitiendo un fotón o, lo que es lo mismo, luz. Estas bombillas apenas se calientan, por lo que son extremadamente eficientes. De hecho, consumen unas 10 veces menos que las bombillas incandescentes, y también duran mucho más, unas 100 veces más, de modo que pueden estar encendidas durante más de 10 años ininterrumpidamente sin fundirse.

Las bombillas LED no son un invento reciente. Se conocen desde la década de los 60. Los primeros diodos emitían luz roja, que ahora son tan frecuentes en los aparatos electrónicos que nos rodean por casa. Posteriormente, se desarrollaron los verdes y a finales de los noventa Shuji Nakamura, que en el 2006 fue galardonado con el premio de la Tecnología del Milenio (considerado como el Premio Nobel de la Tecnología), logró obtener diodos azules. Este fue un gran avance, ya que su combinación con los diodos verdes y rojos permitía la obtención de luz blanca, y ampliar enormemente las aplicaciones tecnológicas de los LED.

A pesar de su ineficiencia, hemos estado utilizando las bombillas incandescentes durante más de 100 años. Sin embargo, gracias a la apuesta decidida de Europa por el ahorro energético, su venta ya está prohibida. No es un gran problema, ya que tenemos muchas alternativas: las luces halógenas (que también son incandescentes y, por lo tanto, no muy eficientes), las fluorescentes de bajo consumo y, cómo no, las bombillas LED, que dentro de pocos años, tan pronto bajen algo más su precio, serán las que seguramente iluminen nuestros hogares.

Retomando el debate del derroche energético del alumbrado navideño, en una ciudad como Bilbao sólo se necesitan 125 kW de potencia para alumbrar las más de las 500000 bombillas LED que se han instalado. Considerando que las luces sólo se encienden desde las 18 hasta las 22, y que el precio actual del kW-h ronda los 0.1 euros, ¡el coste diario no supera los 50 euros! No es para tanto, ¿no? En fin, si realmente contribuye a fomentar el optimismo ciudadano en estas Navidades me parece que es asumible. Por supuesto, no siempre ha sido igual. Antes del alumbrado cuántico, cuando se utilizaban las bombillas incandescentes tradicionales, el consumo era unas diez veces mayor.

Fuente: Cuaderno de Cultura Científica

Los productos de la ciencia son bienes culturales que hay que preservar

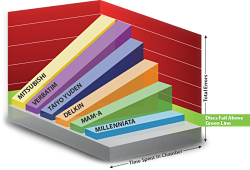

Todavía conservo los datos de mis primeras simulaciones por ordenador en cartuchos de cintas magnéticas y en discos flexibles de 5¼ y 3½ pulgadas (una pulgada equivale a 2.54 cm) . Hoy en día son imposibles de recuperar, luego los puedo dar por perdidos. Un estudio publicado en Current Biology indica que el 80% de los datos de hace 20 años se ha perdido. Esta figura muestra el porcentaje de datos recuperables de 516 trabajos en Ecología publicados entre 1991 y 2011 (según sus propios autores). Nos lo cuentan Elizabeth Gibney, Richard Van Noorden, “Scientists losing data at a rapid rate. Decline can mean 80% of data are unavailable after 20 years,” News, Nature AOP 19 Dec 2013, que se hacen eco de Timothy H. Vines et al., “The Availability of Research Data Declines Rapidly with Article Age,” Current Biology, AOP 19 Dec 2013.

La ciencia es un bien cultural y los bienes culturales son patrimonio de toda la humanidad. Los esfuerzos que los gobiernos realizan para preservar el patrimonio cultural también se deberían dirigir hacia la preservación de los datos en bruto utilizados en los análisis publicados en artículos científicos. En muchos campos, como en Ecología y Climatología, poder disponer de los datos originales de estudios realizados hace décadas sería de una enorme utilidad. Por desgracia, en la mayoría de los casos ya son imposibles de recuperar. Bienes culturales que se han perdido en la eternidad.

El proyecto de Michael Hildreth (físico de la Univ. Notre Dame, Indiana) “Data and Software Preservation for Open Science” (financiado por la NSF de EEUU) es un primer paso en la dirección correcta, pero aún queda mucho camino por recorrer. Sobre todo en cuanto a la confianza de los propios investigadores en la “ciencia abierta” (open science). Este tipo de iniciativas no sólo son muy interesantes, también son muy necesarias.

Fuente: La Ciencia de la Mula Francis

autobus las palmas aeropuerto cetona de frambuesa