Actualidad informática

Noticias y novedades sobre informática

Diferencia de archivos jpg y png

No todas las imágenes tienen las mismas características. Una foto, un plano o un logo requieren de un tratamiento distinto a la hora de manejarlas o almacenarlas. Además, como producto tecnológico que son, están sometidas a los rigores de la tecnología de ese momento, las leyes de mercado, los derechos de autor, y la pericia de quiénes los diseñan.

El formato PNG (Portable Network Graphics) surge como un intento de mejorar al formato GIF (y de paso eludir el copyright al que estaba sometido), que había dado muy buenos resultados para trabajar con dibujos, en un momento en que los ordenadores no eran capaces de manejar imágenes con la misma velocidad que ahora. Como su antecesor, PNG comprime las imágenes con un algoritmo sin pérdida de datos (es decir, recuperamos el dibujo tal como lo almacenamos, luego veremos que esto no tiene por qué ser así), y además es capaz de soportar paletas de colores más grandes e imágenes con más profundidad.

Sin embargo, el JPG es un formato que parte de la compresión JPEG (Joint Photographic Expert Group), un método ingenioso de ahorrar espacio en las imágenes con gran cantidad de colores – como las fotografías- que aprovecha que el ojo humano no es capaz de distinguir variaciones mínimas de color para comprimir con pérdida. Es decir, la trampa consiste en representar con el mismo código de color áreas que formadas por varios colores muy parecidos entre sí.

Voy a intentar explicarlo con un símil. Imaginemos que vamos a una hamburguesería y tomo nota de lo que quieren mis amigos: Cinco hamburguesas completas, una de ellas sin cebolla y otra con mucho pepinillo, dos perritos calientes completos y uno más solo con ketchup. Imaginemos ahora que quiero ahorrarme molestias y pido cinco hamburguesas completas y tres perritos completos. Desde luego he perdido parte de la información deliberadamente, pero me compensa.

La versatilidad de JPG estriba en que es posible comprimir gran cantidad de datos sin que el usuario perciba el cambio. Además, se puede regular esa tasa de compresión. Sin embargo, la compresión JPG da malos resultados para los dibujos, donde lo más recomendables es usar PNG.

Como dije antes, los formatos están sujetos a los vaivenes de la tecnología. Es por ello que el formato JPG, siendo más antiguo que PNG, ha tenido la capacidad de adaptarse a los cambios que exigía el tiempo, como el uso de paletas CMYK -importantísimo para la impresión de calidad- y el uso de metadatos (información adicional como fecha, hora, localización…) que utiliza el formato de datos intercambiable Exif.

Fuente: HABLANDO DE CIENCIA

Autor: Jorge Frías Perles

Licencia CC

Transmisión molecular de información

Investigadores de la Universidad de York, en Toronto (Canadá), liderados por Nariman Farsad, han creado un sistema para la transmisión de textos mediante señales moleculares, en vez de las convencionales eléctricas, lumínicas o radioeléctricas. Un concepto que copia a la naturaleza la cual, por lo general, utiliza moléculas químicas para hacer comunicar las células o las neuronas. En concreto, el primer mensaje que han conseguido transmitir es el título del himno nacional de Canadá, «O, Canada».

Fuente: Biblumliteraria

El vacío proporciona un terreno sólido para la nueva definición del kilogramo

De todas las unidades estándar actualmente en uso en todo el mundo, el kilogramo – la unidad oficial de la masa en el Sistema Internacional de Unidades (SI) – es el único que todavía se basa en un objeto físico para su definición. Sin embargo, la revisión de esta definición obsoleta requerirá mediciones precisas que los investigadores aún no son capaces de hacer, dijo Patrick Abbott, del Instituto Nacional de Estándares y Tecnología (NIST) de Gaithersburg (EE.UU.), Md. Abbott presentará una visión general de los esfuerzos actuales en la tecnología del vacío para redefinir el kilogramo en el 60º AVS International Symposium and Exhibition, que se celebró del 27 de octubre al uno de noviembre de 2013, en Long Beach, California.

Abbott también describirá el desarrollo de su equipo del NIST de un nuevo sistema para permitir una comparación directa de un objeto que está siendo intervenido en el vacío a uno fuera de un vacío. «El nuestro es el único proyecto de su tipo en el mundo», dijo Abbott , «y creemos que será fundamental en la difusión precisa del kilogramo redefinido.»

El kilogramo oficial, llamado el Kilogramo Prototipo Internacional (IPK), se almacena en una oficina en las afueras de París, Francia, y ha servido como el estándar al que kilogramos prototipos de todas las naciones se han comparado en los últimos 125 años. Cada pocas décadas, los prototipos nacionales se realizan, por lo general a mano, a Francia, donde se miden contra el IPK. Sin embargo, las discrepancias entre los prototipos nacionales y el modelo oficial han estado aumentando a un ritmo de 0.050 miligramos (mg) cada 100 años. Y nadie sabe por qué.

«En realidad no es claro si el IPK es cada vez más ligero o los prototipos nacionales son cada vez más pesados», dijo Abbott. La pérdida de masa debida al desgaste es poco probable debido a que el IPK casi nunca se saca de su urna. Para hacer frente a estas discrepancias, una asamblea internacional de metrología – los investigadores que estudian la ciencia de la medición – decidió en 2007 dejar de depender del prototipo y redefinir el kilogramo utilizando algo más fiable: una constante de la naturaleza.

Los metrólogos finalmente eligieron la constante de Planck, que describe la relación entre la energía de un fotón y la frecuencia de la luz que emite. Su valor se ha medido con una incertidumbre relativa de entre 30×10^?9 y 35×10^-9. Sin embargo, para asegurar el acuerdo entre el sistema actual y el kilogramo definido en base a la constante de Planck, los investigadores tendrán que mejorar sus mediciones a una incertidumbre relativa de 20×10^-9.Y para obtener mejores mediciones, tendrán la capacidad de realizar la metrología «estado del arte» en el vacío.

Actualmente, los investigadores utilizan dos tipos de experimento para medir la constante de Planck, y ambos requieren vacío. Un método implica la determinación del número de átomos en una esfera de silicio de alta pureza con una masa nominal de un kilogramo. La otra, llamada la balanza watt, mide la constante de una comparación indirecta o «virtual» de energía mecánica a la energía electromagnética. El uso de vacío asegura que no hay contaminación de partículas en el aire y reduce la incertidumbre en algunas de las mediciones que se llevan a cabo con la interferometría láser.

Los investigadores que utilizan el experimento balanza watt en los institutos nacionales de medición alrededor del mundo están trabajando para encontrar los materiales más adecuados para la medición de la constante de Planck con este método. También se está trabajando para encontrar un nivel de vacío que sea lo suficientemente bueno para obtener resultados sin ser demasiado difícil de construir y mantener. Hasta ahora, los investigadores están en condiciones de tener una nueva definición del kilogramo en 2018, dijo Abbott.

Mientras que muchos equipos de todo el mundo trabajan para mejorar las mediciones de la constante de Planck, el grupo de Abbott está mirando más allá de la redefinición y hacia la realización práctica de estas mediciones.

«Cada vez que se produce la redefinición, se requerirá un método robusto para difundir el kilogramo realizado en el vacío a un mundo que funciona en el aire», dijo Abbott. Su grupo trabaja en la creación de un sistema para cerrar la interfaz de vacío /aire usando una técnica de suspensión magnética. La puesta en marcha permitirá una comparación directa entre la masa de un kilogramo estándar en el vacío y la masa de una muestra en la atmósfera de una habitación normal.

Esto se basa en los materiales proporcionados por Instituto Americano de Física , a través de Newswise.

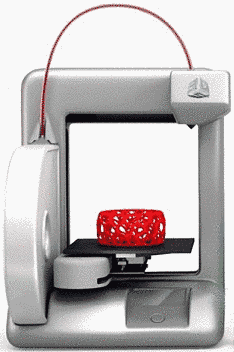

Compuesto natural puede ser utilizado para la impresión 3-D de implantes

Investigadores de la Universidad Estatal de Carolina del Norte, la Universidad de Carolina del Norte en Chapel Hill y Laser Zentrum Hannover han descubierto que un compuesto de origen natural puede ser incorporado en los procesos de impresión en tres dimensiones (3-D) para crear médica implantes de polímeros no tóxicos. El compuesto es riboflavina, que es conocido como vitamina B2.

«Esto abre la puerta a una gama mucho más amplia de materiales para implantes biocompatibles, que pueden ser utilizados para desarrollar diseños de implantes personalizados utilizando la tecnología de impresión 3-D,» dice el Dr. Roger Narayan, autor principal de un artículo que describe la obra y profesor del servicio de ingeniería biomédica en la NC State y UNC-Chapel Hill (EE.UU.).

Los investigadores de este estudio se centraron en una técnica de impresión 3-D llamada polimerización de dos fotones, ya que esta técnica se puede utilizar para crear objetos pequeños con las características detalladas – tales como andamios para la ingeniería de tejidos, microagujas u otros dispositivos de liberación de fármacos implantables.

La polimerización de dos fotones es una técnica de impresión 3-D para la fabricación de estructuras sólidas a pequeña escala a partir de muchos tipos de precursores líquidos fotorreactivos. Los precursores líquidos contienen químicos que reaccionan a la luz, convirtiendo el líquido en un polímero sólido. Al exponer el precursor líquido al volumen esperado de la luz, la técnica permite a los usuarios para «imprimir» los objetos 3-D.

La polimerización de dos fotones tiene sus inconvenientes, sin embargo. La mayoría de los productos químicos mezclados en los precursores para hacerlos fotorreactivo también son tóxicos, lo que podría ser problemático si las estructuras se utilizan en un implante médico o están en contacto directo con el cuerpo.

Pero ahora los investigadores han determinado que la riboflavina se puede mezclar con un material precursor para que sea fotorreactivo. Y riboflavina es a la vez no tóxica y biocompatible – es una vitamina que se encuentra en todo, desde los espárragos al queso cottage.

Fuente: Alexander K Nguyen, Shaun D Gittard, Anastasia Koroleva, Sabrina Schlie, Arune Gaidukeviciute, Boris N Chichkov, Roger J Narayan. Two-photon polymerization of polyethylene glycol diacrylate scaffolds with riboflavin and triethanolamine used as a water-soluble photoinitiator. Regenerative Medicine, 2013; 8 (6): 725 DOI:10.2217/rme.13.60

Ordenadores cuánticos, la confianza es buena y la prueba es mejor

Un ordenador cuántico puede resolver tareas en las que falla un ordenador clásico. La cuestión de cómo se puede, sin embargo, comprobar la fiabilidad de una computadora cuántica fue respondida recientemente en un experimento en la Universidad de Viena. Las conclusiones se publican en la revista científica Nature Physics.

El aprovechamiento de los fenómenos cuánticos, como la superposición y el entrelazamiento, representa una gran promesa para construir futuros superordenadores utilizando la tecnología cuántica. Una gran ventaja de este tipo de ordenadores cuánticos es que son capaces de realizar una variedad de tareas mucho más rápido que sus homólogos convencionales. El uso de los ordenadores cuánticos para estos fines plantea un reto importante: ¿cómo se pueden verificar los resultados proporcionados por un ordenador cuántico?

Solo recientemente los desarrollos teóricos han proporcionado métodos para poner a prueba un ordenador cuántico sin tener un ordenador cuántico adicional a mano. Un equipo de investigación internacional en torno a Philip Walther en la Universidad de Viena ha demostrado ahora un protocolo nuevo, donde los resultados computacionales cuánticos pueden ser verificadas sin necesidad de utilizar los recursos informáticos cuánticos adicionales.

Trampas para un ordenador cuántico

Con el fin de probar los ordenadores cuánticos los científicos insertaron «trampas» en las tareas. Las trampas son cálculos intermedios cortos de los que el usuario sabe el resultado de antemano. En caso de que el ordenador cuántico no haga su trabajo correctamente la trampa entrega un resultado que difiere del esperado. «De esta manera, el usuario puede verificar el grado de fiabilidad del ordenador cuántico y si realmente lo es», explica Elham Kashefi (Edimburgo) y Joseph Fitzsimons (Singapur), coautores del artículo. Los más trampas que el usuario se basa en las tareas que el mejor, el usuario puede estar seguro de que el ordenador cuántico hecho, calcula con precisión.

«Hemos diseñado la prueba, de tal manera que el ordenador cuántico no puede distinguir la trampa de sus tareas normales», dice Stefanie Barz (Viena), primer autor del estudio. Este es un requisito importante para garantizar que el ordenador cuántico no es capaz de ajustar el resultado de la prueba. Los investigadores también probaron si el ordenador cuántico realmente recurre a los recursos cuántica. De esta manera, pueden asegurarse de que incluso un ordenador cuántico maliciosamente construido no puede engañar y aceptar resultados erróneos.

Aplicación de la idea con fotones

Para esta primera demostración, los investigadores utilizaron una computadora cuántica óptica, donde las partículas de luz individuales, llamadas fotones, llevan la información. El protocolo demostrado es genérico, pero los ordenadores cuánticos ópticos parece que son ideales para esta tarea. La movilidad de los fotones permite una fácil interacción con el ordenador cuántico. Philip Walther es optimista sobre las perspectivas planteadas por este experimento que muestra mecanismos de control prometedores para futuros ordenadores cuánticos. Y, por otra parte, que podría conducir a nuevas herramientas para sondear los recursos más complejos de la cuántica.

Fuente: Stefanie Barz, Joseph F. Fitzsimons, Elham Kashefi, Philip Walther. Experimental verification of quantum computation. Nature Physics, 2013; DOI:10.1038/nphys2763

Montar un ordenador PC a partir de piezas

Hace unos años atrás, construir un computador era la mejor opción para obtener exactamente lo que se quería de hardware, sin tener que gastar una gran cantidad de dinero. Armar su propia PC era el sueño de toda persona que fuese entusiasta de los computadores, y posiblemente muchos lo intentaron.

Todo esto pasó durante el pasado, así qué, ¿aún vale la pena armar tu propio computador hoy en día? ¿es más económico y práctico?

Los ordenadores del presente

Ya no se arman ordenadores desde cero y ya no se consiguen esos que se les llamaba «clon», que solían ser más económicos. Todo esto ha cambiado solamente porque el mercado es distinto también.

Se puede comprar portátiles o computadores de escritorio, pero usualmente las personas se deciden por las primeras. ¿Por qué? Porque su precio ha bajado considerablemente en los últimos años y porque son más cómodas. Su arquitectura es perfecta para hacer cosas simples, pero también hay unas más potentes que sirven para los gamers más dedicados. Además, su mejor ventaja es que se pueden llevar a todos lados, algo muy importante en esta era donde los dispositivos móviles son la primera opción para los usuarios.

Ventajas de armar un computador propio

- Personalización: esto es lo más importante y la mejor ventaja que tiene el proceso de armar un ordenador completamente. El usuario puede decidir qué características tendrá y qué componentes necesita; se tendrá control entero del hardware decidiendo también la calidad de los componentes.

- Actualización: una cosa que siempre se escuchaba cuando los «clones» se vendían, es que estos se podían actualizar como se quisiera, colocando más RAM, más puertos USB o un disco duro más amplio. Se les comparaba con las portátiles porque eran costosas y no se les podía hacer ningún cambio. Esto todavía es cierto: si se arma un ordenador se puede prever que sus componentes den la posibilidad de expansión más adelante.

- Precio: esta será una ventaja únicamente si se pueden conseguir componentes que sean más baratos que lo que costaría comprando un computadora ya armado.

Desventajas de armar un PC propio

- Garantía: cuando se compra un PC ya armado se tiene garantía para toda la maquina, lo que quiere decir que si funciona mal o se daña, se puede mandar al fabricante para que la arregle o la reemplace. Con un computador armado por el usuario, los arreglos deberá hacerlos él o ella, lo que será bastante trabajo. Se tendría que investigar qué pieza está dando problemas para poder resolver el problema. La parte positiva es que las piezas también tienen garantía.

- Esfuerzo: obviamente, armar el PC tomará muchísimo tiempo y trabajo, especialmente si se es principiante. Para aquellos que ya sepan muy bien qué están haciendo les tomará mucho menos tiempo, pero nunca se le podrá comparar con salir a una tienda o comprar online un PC que ya está listo.

- Precio: menciono nuevamente el precio, ahora como desventaja, porque hay que considerar que los fabricantes obtienen piezas con descuentos porque compran en grandes cantidades. Esto quiere decir que es posible que la misma pieza se consiga más costosa, a menos que se esté pendiente de ofertas o se consiga un vendedor que haga rebajas por comprar varias piezas. Además, también está el importante factor de para qué queremos el computador, y dependiendo de las necesidades el precio será o bajo, o realmente alto. Por ejemplo, los gamers y profesionales de la edición encontrarán que sus computadores finalmente alcanzan costos de 2000 a incluso 6000 dólares.

Así qué, ¿vale la pena armar un PC?

La respuesta es muy subjetiva porque va a depender de cada usuario. Primero hay que tener en cuenta que el usuario debe querer un computador de escritorio para pensar en que quiere armarlo por su cuenta. Después, se debe reflexionar para qué se quiere el PC: ¿es para uso diario, para navegar por Internet y usar Microsoft Word? o, ¿es para un gamer hardcore?

Fuente: gizmología

Autora: Renata Franco

Licencia Creative Commons Atribución-NoComercial 2.5

Realidad Aumentada para adelantar camiones

Conducir puede ser muy relajante, pero cuando nos encontramos con un enorme camión en una carretera estrecha puede acabar toda la tranquilidad en pocos segundos. Lo normal es ir moviéndose poco a poco en busca de información para saber si es un buen momento para adelantar, o esperar algún signo del camionero que nos ayude a saber si podemos o no podemos acelerar, algo que podría ser mucho más sencillo con algo como lo que están construyendo en la universidad de Porto, en Portugal (podéis ver el artículo aquí).

Se trata de un sistema de realidad aumentada que permitirá ver lo que hay delante del camión. El vehículo llevará una pequeña cámara incorporada y los coches que enfoquen enfoquen el dispositivo que ha sido desarrollado en la parte trasera del camión podrán ver lo que se está filmando, verificando así si vienen coches en sentido contrario y permitiendo tomar la decisión de una forma más segura.

Lo comentan en newscientist.com. El programa detecta la trasera del camión y muestra la información de forma automática, en caso contrario (cuando no detecta nada) sigue siendo completamente invisible, por lo que en ningún momento interfiere en la visibilidad normal del conductor.

El delay del vídeo mostrado y la realidad es de 200 milisegundos, un tiempo bastante bueno, aunque seguramente podrá mejorarse antes de estar listo para comercializarse.

Fuente: wwwhat’s news

![]()

autobus las palmas aeropuerto cetona de frambuesa