Actualidad informática

Noticias y novedades sobre informática

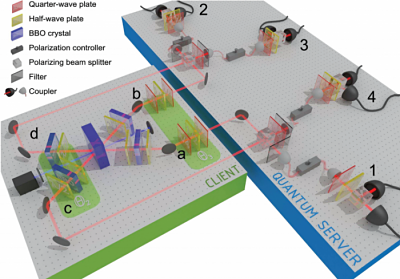

Protocolo «doble ciego» de computación cuántica universasl

Supón que has desarrollado el algoritmo cuántico del siglo, pero no tienes un ordenador cuántico para ejecutarlo. Una compañía privada posee un ordenador cuántico que podrías usar, pero no quieres que vean tu código fuente, tu entrada y la salida de tu algoritmo; ellos tampoco confían en tí y no quieren que piratees los secretos de su máquina. Barz et al. publican en Science un protocolo cuántico que os satisfará a ambos, ni tú ni ellos desvelaréis vuestros secretos; el único requisito es que te permitan manipular a tu antojo un solo cubit, uno solo. Este problema se denomina computación cuántica “ciega” (blind QC), pero a mí me gusta más el título de esta entrada. En estudios anteriores se demostró cómo es posible ejecutar cualquier algoritmo cuántico realizando medidas en un solo cubit que está entrelazado con los cubits de dicho ordenador cuántico. Para ocultar el algoritmo, el cliente utiliza el nuevo protocolo que realiza el cálculo gracias a un entrelazamiento cuántico aleatorio. Solo quien controle el único cubit puede conocer la entrada, el algoritmo y la salida; la compañía solo podrá observar cubits aletaorios entrelazados. Además, el funcionamiento del ordenador cuántico es confidencial pues el programador solo puede observar un único cubit. No describiré este protocolo cuántico en detalle, pero adelanto que es muy bonito, aunque algo técnico. Nos lo cuenta Vlatko Vedral, “Moving Beyond Trust in Quantum Computing,” Science 335: 294-295, 20 Jan. 2012, que se hace eco del artículo técnico de Stefanie Barz et al., “Demonstration of Blind Quantum Computing,”Science 335: 303-308, 20 Jan. 2012.

Artículo completo en: Ciencia Imprescindible

El software del colisionador de partículas (LHC)

Por primera vez se han dado en el LHC colisiones a 7 TeV. En el instante en que sus detectores registran sucesos relacionados con una colisión, los desafíos se mueven desde el reino del hardware y el software, ya que el LHC producirá, literalmente, más datos de lo que podemos manejar. Tenemos que averiguar a lo que aferrarse en tiempo real, y enviarlo a todo el mundo a través de conexiones dedicadas a 10 GBp/s; y la necesidad por parte del extremo receptor de guardarlo de forma segura y llevar a cabo el tipo de análisis que se espera revele una nueva física. Vamos a proporcionar una breve visión a los temas de cómputo creado por el LHC.

Encontrar lo que estamos interesados

El LHC no es sólo excepcional en términos de la energía que puede alcanzar, sino que tiene una muy alta luminosidad, lo que significa que produce colisiones a una velocidad asombrosa. Howard Gordon indicó que las interacciones se llevarán a cabo a un ritmo de 600 millones de eventos por segundo para cada detector. Incluso si tuviéramos la capacidad de guardar los comprobantes de todos ellos (que no), muchos representarían a la física conocida. Srini Rajagopalan, un empleado de Brookhaven que trabaja en el CERN, dijo que de los millones de colisiones que ocurren cada segundo, estaremos almacenando aproximadamente 400 de ellas.

Obviamente, este proceso es un sacrificio muy importante, complicado por el hecho de que estamos esperando para ver las partículas que han sido predichas por las diferentes teorías (lo ideal, nos gustaría también detectar cosas que los teóricos no esperaban). ¿Cómo funciona esto? Un indicio se proporcionó cuando a Stephanie Majewski se le preguntó sobre un modelo para la existencia de dimensiones más allá de nuestro bien conocido universo de cuatro. «Las dimensiones extra nos darán un montón de muones», dijo Majewski, «no podía faltar.» En resumen, la mayoría de cosas que estamos esperando o la esperanza de encontrarlas son el producto de algunas predicciones bastante específicas, y producirán patrones igualmente predecibles de partículas en los detectores (Chris Lee cubrió esto en detalle un poco más).

Rajagopalan describe cómo el software del detector ATLAS, incluyó lo que llamó «filtros de eventos». Básicamente, el software puede determinar el grado en que las partículas y la energía que sale de una colisión coinciden con un patrón que es de esperar que al ser producido por una partícula dada. Estas expectativas pueden basarse tanto en lo que ya hemos visto en partículas conocidas como el quark top, o lo que predice la teoría.

En este momento, el software cuenta con 300 filtros de eventos, pero aparentemente puede manejar hasta 8000, y dar prioridad a cada una de ellos, entonces, por ejemplo, es probable que trate de capturar eventos de más potencial Higgs que los quarks arriba (top).

Estos filtros pueden tener diversos grados de restricciones, lo que significa que se pueden establecer para capturar eventos que son similares a, pero que no se ajustan exactamente a las predicciones. También es posible detectar la superposición parcial entre eventos. Así, por ejemplo, una partícula desconocida podría producir un conjunto de familias como parte de su decaimiento, incluso si no hay un filtro específico para las partículas, el evento puede ser capturado porque se ve un poco como algo que también se desintegra a través de un conjunto similar de partículas.

Esto último es importante en caso de que los teóricos empezaran a proponer ideas mucho después de que el LHC hubiera comenzado la recolección de datos. Cuando Howard Gordon planteó esto, es posible tomar nuevas ideas y compararlas con los modelos existentes para identificar los posibles lugares de solapamiento, y para ir desde allí a los datos primarios y probar contra las predicciones en detalle.

La física computacional

En la interfaz principal de ATLAS para EE.UU., el principal papel de Brookhaven será simplemente almacenar cualquier dato que llegue del evento a través de filtros a medida, y su distribución a diferentes (Tier 2 y 3) lugares de todo el país (Brookhaven también cuenta con una red de 10000 núcleos que llevará a cabo un análisis). Como lo describió Ofer Rind, ya que cada caso es esencialmente independiente, todos ellos se pueden analizar por separado, es un problema «paralelo», en términos de informática.

Como resultado, la comunidad de «física de altas energías» tiene una gran experiencia con la informática en red (grid). «Hemos estado haciendo esto por un tiempo, y con mucho menos dinero», dijo Rind.

Parte de esa potencia de cálculo, simplemente va a convertir los datos en bruto a las identidades de las partículas y las pistas, y otra parte a modelar lo que podría ser similar a una partícula teórica. Pero, a medida que más datos estén disponibles, muchos de los cálculos implican simplemente escanear eventos para determinar qué tanto o ninguno de ellos coincide con las predicciones teóricas. Los usuarios de la red serán capaces de especificar un programa de análisis (entre ellos uno que envíe la tarea), de identificar los datos que deben procesarse, y simplemente establecer el trabajo sobre la marcha. Sobre la base de la prioridad del trabajo, la red usará más tiempo de procesador de repuesto, y luego procesará el software y los datos juntos en las mismas máquinas, lo que permite el análisis a realizar.

En un futuro próximo, este tipo de programas deben comenzar a construir un catálogo de las colisiones que tienen el número correcto, propiedades de correctas de los muones, fotones de la energía correcta, etc, para contener una indicación de algo que es nuevo para la física. Y, una vez se identifican una señal de ruido fuera de la estadística, entonces se podría estar listo para iniciar la actualización del modelo estándar (y, posiblemente, todos de la cosmología).

Fuente: arstechnica

Investigadores encuentran que los errores cuánticos funcionan

Físicos de la Universidad de Queensland han encontrado que el campo emergente de la computación cuántica puede ser más estable de lo que se pensaba anteriormente.

El Dr. Tom Stace, de la Escuela de Matemáticas y Física de la UQ, ha estudiado el efecto de los errores en los ordenadores cuánticos y encontró que incluso con un 50% de pérdida de componentes aún podría funcionar.

La investigación teórica realizada junto con el Dr. Andrew Doherty de la UQ y el Dr. Sean Barrett de la Universidad Macquarie, se publicó recientemente en la revista científica Physical Review Letters.

“Nuestros resultados demuestran que pueden tolerarse errores y pérdidas relativamente grandes, y por lo tanto puede confirmar que los ordenadores cuánticos son genuinamente factibles”, dijo el Dr. Stace.

“Lo que demuestra nuestro trabajo es que un dispositivo cuántico teóricamente útil puede construirse incluso si un 10% de sus componentes sufren un error, o hasta un 50% de sus componentes se han perdido por completo”.

El Dr. Stace dijo que aunque la computación cuántica estaba aún en sus albores, tiene el potencial de revolucionar los ordenadores debido a su potencial de ser mucho más potente que los ordenadores actuales, especialmente en campos tales como la banca donde las transacciones seguras son primordiales.

“Pero uno de los retos principales de la computación cuántica es diseñar un dispositivo que sea insensible a los errores, incluso aunque sus elementos constituyentes sean en sí mismos propensos al error”, dijo.

“Los dispositivos cuánticos son muy sensibles al ruido de su alrededor, y su rendimiento puede verse gravemente impedido por los errores. Nuestra investigación se centra, por tanto, en cómo podríamos construir un dispositivo útil a partir de componentes imperfectos”.

“Este trabajo teórico nos da una idea cuantitativa de cómo de precisa tiene que ser la ingeniería cuántica para hacer dispositivos útiles”.

Fuente: Ciencia Kanija

Bajo licencia Creative Commons

___________________

Enlaces relacioandos:

– Habrá ordenadores portátiles con coprocesadores cuánticos a temperatura ambiente algún día

– El físico español Cirac gana el Príncipe de Asturias de Investigación Científica

– Computadores cuánticos, más cerca de la realidad

– Nuevo material que supone avance en la computación cuántica

Científicos descubren que la fuerza de la luz tiene una energía de “empuje”

Un equipo de investigadores de la Universidad de Yale ha descubierto una fuerza de la luz “repulsiva” que puede usarse para manipular componentes en microchips de silicio, lo que significa que futuros nanodispositivos podrían estar controlados por la luz en lugar de la electricidad.

El equipo descubrió anteriormente una fuerza de la luz “atractiva” que podría manipularse para mover componentes en interruptores semiconductores de diminutos sistemas micro y electro mecánicos en un chip. Los científicos han descubierto ahora una fuerza repulsiva complementaria. Los investigadores habían teorizado la existencia de ambas fuerzas desde 2005, pero la segunda había estado sin demostrarse hasta ahora. El equipo, liderado por Hong Tang, profesor asistente en la Escuela de Ingeniería y Ciencia Aplicada de Yale, informa de sus hallazgos en la publicación on-line avanzada del 13 de julio de Nature Photonics.

“Esto completa el cuadro”, dijo Tang. “Hemos demostrado que esta es una fuerza de luz bipolar con componentes atractivos y repulsivos”.

Las fuerzas de luz atractivas y repulsivas que descubrió el equipo de Tang son distintas fuerza de presión de radiación de la luz, la cual empuja un objeto cuando la luz brilla sobre él. En lugar de esto, empujan o tiran en los laterales de la dirección en la que viaja la luz.

Anteriormente, los ingenieros usaron la fuerza atractiva que descubrieron para mover componentes de un chip de silicio en una dirección, tal como tirar de un interruptor a nanoescala para abrirlo, pero fueron incapaces de empujarlo en la dirección opuesta.

Usar ambas fuerzas significa que ahora tienen control completo en ambas direcciones. “Hemos demostrado que estas son fuerzas ajustables que podemos usar en ingeniería”, dijo Tang.

Para crear la fuerza repulsiva, o el “empujón”, en un chip de silicio, el equipo dividió un rayo de luz infrarroja en dos rayos separados y forzó a cada uno a viajar una longitud distinta de un nanocable de silicio, llamado guía de onda. Como resultado, los dos rayos de luz quedan desfasados uno respecto al otro, creando una fuerza repulsiva con una intensidad que puede controlarse – cuanto más desfasado estén los dos rayos, mayor será la fuerza.

“Podemos controlar cómo interactúan los rayos de luz”, dijo Mo Li, asociada de posdoctorado en ingeniería eléctrica en Yale y autor principal del artículo. “Esto no es posible en el espacio libre – sólo es posible cuando la luz está confinada en las guías de onda de nanoescala que se colocan muy cerca entre sí en el chip”.

“La fuerza de la luz es intrigante debido a que funciona de forma opuesta a los objetos cargados”, dijo Wolfram Pernice, otro profesor de posdoctorado en el grupo de Tang. “Las cargas opuestas se atraen entre sí, mientras que los rayos de luz desfasados se repelen en este caso”.

Estas fuerzas de luz pueden algún día controlar dispositivos de telecomunicaciones que requerirían mucha menos energía pero serían mucho más rápidos que sus homólogos actuales, comenta Tang. Un beneficio añadido de usar luz en lugar de electricidad es que puede ser enviada a través de un circuito sin casi interferencia en la señal, y se elimina la necesidad de un gran número de cables eléctricos.

Fuente: Ciencia Kanija

Bajo licencia Creative Commons

________________

Enlaces relacionados:

Simulación Cuántica en camino. El Matrix no está lejos…

Aun con todo el inmenso poder de las computadoras de hoy día, hay al menos un tipo de problemas que ni todas las computadoras del mundo combinadas en una sola puede atacar, y ese es el problema de simular efectos cuánticos. Pero eso está empezando a cambiar…

El problema es que efectos cuánticos (es decir, los efectos de la física que ocurren en las escalas mas inimaginablemente pequeñas, como lo que ocurre entre y dentro de los átomos) tienen la extraña propiedad de que pueden existir en mas de un estado simultáneamente.

Es decir, es como si tuviéramos un bombilla, la cual estuviera encendida y apagada al mismo tiempo, algo que suena ridículo pero que aunque contra-intuitivo, es la manera en que funciona la naturaleza a pequeñas escalas, es decir, un mismo electrón puede estar en dos estados a la misma vez, en dos lugares a la misma vez, en dos estados magnéticos a la misma vez, etc. Y cuando digo dos estados, no solo me refiero a dos, sino que a hasta una infinidad de estos estados simultáneos.

Muchos dirán que esto es solo teoría, pero lo cierto es que esto ha sido comprobado en miles de experimentos durante décadas. Inclusive, la razón por la cual nuestros televisores, celulares, y cientos de otros aparatos domésticos funcionan es precisamente debido a esta singularidad de la naturaleza. Es el famoso «Principio de Superposición», que dice que una misma cosa puede estar en una infinidad de estados simultáneos, hasta que uno interactúe con su información.

Pues sucede, que simular estos estados cuánticos es un gran problema para las computadoras «clásicas» que utilizamos hoy día, ya que estas se basan en una arquitectura binaria, es decir, de 2, en donde cada pedazo (o «bit», que es lo que significa «pedazo» en Inglés) solo puede estar en 1 de 2 posibles estados, en el estado 0 (cero) o el estado 1 (uno), pero nunca ambos a la vez.

En contraste, una computadora cuántica utiliza Qbits, en donde cada Qbit puede estar en «0», o en «1», o «en 0 y 1″.

Eso significa que si una computadora clásica (de «bits») quisiera simular tan solo 2 átomos que tuvieran tan solo 2 estados (digamos 0 y 1), que tal computadora necesitaría darle seguimiento a 4 posibles combinaciones entre esos dos bits, que son 00, 01, 10 y 11. Si tuviéramos 3 átomos, hablamos de 8 combinaciones (000, 001, 010, 011, 100, 101, 110, 111), y si hablamos de tan solo 4 átomos entonces requeriríamos de 16 combinaciones.

Para que tengan una idea, el tan solo almacenar los posibles estados de 24 átomos, que en una computadora clásica requeriría de tan solo 24 bits (o 3 Bytes), en una computadora cuántica se necesitarían 16,777,216 bits, o unos 2 GigaBytes. Es decir, que para que una computadora clásica pueda simular a una cuántica, se necesita almacenar información exponencialmente, o en este caso mas precisamente se necesitan 2N bits para almacenar los estados de N Qbits. Es por eso que en el ejemplo anterior si queremos almacenar los estados de 24 bits, necesitamos de 224 bits, que son 16,777,216 bits.

Y debido a esta exponencialidad, es impráctico poder simular cualquier sistema cuántico de un tamaño útil para obtener resultados, ya que por ejemplo para simular un sistema cuántico con tan solo 256 Qbits, se necesitarían mas bits que la cantidad de fotones visibles en todo el Universo conocido (un número que no cabrían en varias páginas aquí).

Y es aquí en donde llegamos al tema de hoy, Simulación Cuántica.

Sucede que desde el 2002 ya se dieron los primeros pasos para simular efectos cuánticos (y efectos clásicos) con una computadora cuántica. La gran ventaja de esto es que a diferencia de una computadora clásica, una cuántica puede estar en «todos los estados posibles» a la vez, por lo que para simular un sistema de 256 Qbits solo se necesitan 256 Qbits (valga la redundancia).

Hoy día ya se están creando las primeras simulaciones casi prácticas que nos permitirán simular prácticamente cualquier cosa en el futuro, inclusive partes del Universo mismo, idéntico a la película The Matrix.

Inicialmente estos experimentos tienen un fin práctico inmediato, y es el de poder simular complejos materiales sintéticos. Hoy día por ejemplo si alguien tiene una idea de algún novedoso nuevo material, su única opción para «simularlo» es construyendo de alguna manera uno real (un proceso complejo, lento y caro), y después midiendo sus propiedades con todo tipo de herramientas.

Sin embargo, con un simulador cuántico, es posible crear una simulación del objeto en el mundo cuántico, y poder interactuar con el material como si existiera de verdad, lo que aceleraría la creación de nuevos y asombrosos materiales desde una tarea laboriosa que toma años o décadas, a una que tome días o quizás segundos.

Este a propósito es un excelente ejemplo de como todo, incluyendo en este caso la tecnología, avanza no de manera gradual (o lineal), sino que exponencial, pues este tipo de herramientas aceleran tanto la industria, que los nuevos adelantos en sí mismo nos permiten acelerar otras tantas mas de manera exponencial también (como en este caso, la industrias de construcción civil, de arquitectura, la textil, y hasta la de viajes espaciales).

Es esta una razón por la cual tardamos miles de años en crear computadoras, pero tan solo tardamos unas décadas en crear el Internet, unos años en crear celulares, y ya hoy día es casi cada unos cuantos meses que sale algo nuevo y novedoso, y este paso solo continuará acelerándose, hasta que lleguemos a una singularidad, pero ese ya es tema para otro artículo…

A los científicos que quieran mas información sobre esto, consulten este enlace del 2002, y a los que quieran un extracto de desarrollos recientes (y menos técnico), pueden leer este otro articulo recién publicado, el cual me inspiró a escribir este artículo de hoy.

Y como siempre, si disfrutaste de este tema, puedes aprender mucho mas de temas similares y explicados de manera que cualquiera los pueda entender, en mi libro gratuito Máquinas en el Paraíso, cuyo enlace aparece en el encabezado de eliax.

Fuente: Eliax

autobus las palmas aeropuerto cetona de frambuesa