Actualidad informática

Noticias y novedades sobre informática

Geoffrey Hinton, el padre del aprendizaje profundo (deep learning)

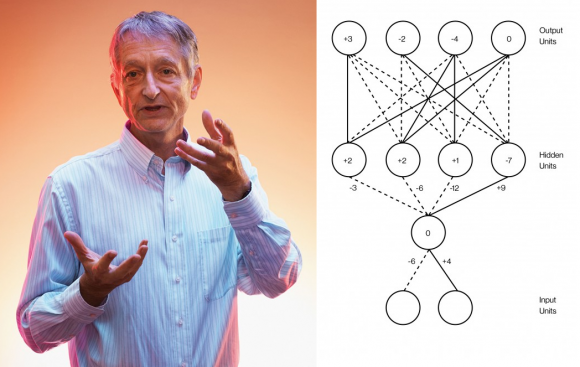

La Inteligencia Artificial está de moda gracias al aprendizaje profundo (deep learning), las redes de neuronas artificiales multicapa entrenadas con un algoritmo de retropropagación (backprop). Mucha gente cree ver una revolución emergente en esta tecnología; sin embargo, casi nada ha cambiado desde que el padre del aprendizaje profundo, Geoffrey Hinton, junto a dos colegas, introdujera el algoritmo de retropropagación en 1986. No solo lo digo yo en mis charlas, también lo dice él mismo, quien ahora es el científico más citado en aprendizaje profundo con gran diferencia respecto al siguiente.

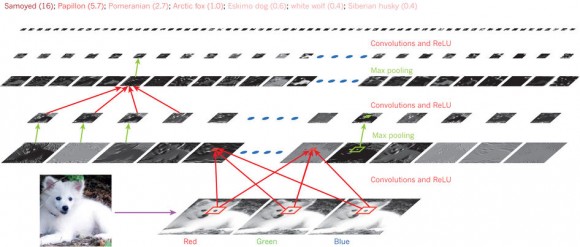

En 2012, Hinton y dos estudiantes demostraron que las redes de neuronas artificiales convolucionales podían reconocer imágenes con mayor precisión que cualquier otra técnica basada en inteligencia artificial. El secreto de estas redes era su número de neuronas por capa (la red tenía nueve capas): la primera capa tenía 150 528 neuronas (para recibir como entrada una imagen en color de 224 × 224 × 3 píxeles); tras aplicar 96 filtros de 11 × 11 × 3 se pasaba a la segunda capa con 253 440 neuronas; tras aplicar 256 filtros de 5 × 5 × 48 se pasaba a la tercera capa de 86 624 neuronas; tras 384 filtros de 3 × 3 × 256 se pasaba a la cuarta capa de 64 896 neuronas; tras aplicar 384 filtros de 3 × 3 × 192 se pasaba a la quinta capa de 64 896 neuronas; tras otros 256 filtros de 3 × 3 × 192 se pasaba a la sexta capa de 43 264 neuronas; finalmente, sin filtros, se encuentran tres capas de 4096, 4096, y 1000 neuronas. Esta última capa clasifica las imágenes de entrada en hasta 1000 clases diferentes.

Puede parecer que cambiar cientos o miles de neuronas por millones de neuronas es un cambio pequeño. Sin embargo, la potencia lograda con el cambio sorprendió a muchos, lo que llevó a Hinton a volver a publicar en Nature (no lo hacía desde 1986) y a que muchas empresas (Google, Apple, Facebook, etc.) se apuntasen al carro del aprendizaje profundo. Sin embargo, los grandes problemas de las redes de neuronas artificiales entrenadas con retropropagación no han sido resueltos aún. Entre ellos el problema del cuello de botella de la información (information bottleneck), descubierto en 1999.

El propio Hinton dice que “la mayoría de las conferencias sobre aprendizaje profundo solo presentan pequeñas variaciones de los algoritmos, sin plantearse problemas profundos sobre estos algoritmos”. En la inteligencia artificial hay más ingeniería que ciencia básica. Los avances futuros requieren una comprensión básica de cómo funcionan los sistemas de aprendizaje profundo y qué relación tienen con el funcionamiento de la mente humana.

Ampliar en: NAUKAS

Eugene Goostman no piensa ni es inteligente aunque haya pasado el test de Turing

Aún cuando nosotros mismo no tenemos muy claro qué es la inteligencia juzgar si un programa de ordenador es inteligente no es nada complicado, y a pesar de lo bien que lo está vendiendo la Universidad de Reading en Turing Test success marks milestone in computing history lo de Eugene Goostman no es para tanto.

Resumiendo, Alan Turing dijo en 1950 que en el año 2000 habría ordenadores capaces de mantener una conversación con una persona usando mensajes de texto que serían capaces de engañar a estas personas durante al menos cinco minutos, y que esto pasaría con una probabilidad del 30 por ciento.

Pero tal y como se puede leer en No Skynet: Turing test ‘success’ isn’t all it seems ya allá por 1991 un bot llamado PC Therapist creado por Joseph Weintraub logró engañar al 50 por ciento de los jueces en un test de Turing con 10 jueces, mientras que en 2011 el Cleverbot de Rollo Carpenter llegó a engañar a un 59,3 por ciento de los 30 jueces de otra prueba similar.

Vaya, que lo del 33 por ciento de Eugene está bien, pero tampoco es para tanto.

Y conviene no olvidar además que el hacerse pasar por un adolescente de 13 años le permite enmascarar de alguna forma su falta de conocimientos sobre algún tema o el tipo de respuestas que da, y que además se supone que no tiene el inglés como lengua materna, a diferencia de los jueces, lo que de nuevo jugaba a su favor.

Ampliar en: microsiervos

Test de Turing

Eugene Gootsman es un programa que se hace pasar por un chaval de 13 años de Ucrania, desarrollado por tres investigadores provenientes de Rusia y Ucrania. En un evento organizado por la Universidad de Reading, consiguió engañar a los jueces el 33% de las veces de que en realidad era una persona humana, lo que según los escritos de Alan Turing es suficiente como para declararla una “máquina pensante”. Sin embargo, ¿es eso cierto?

La realidad es que no existe un solo test de Turing, ni sus reglas son tan específicas. Ideado por el genio Alan Turing en la década de los 50, fue la respuesta a una duda que se hacían muchos científicos con la llegada de las computadoras: ¿pueden las máquinas pensar? En vez de responder a una pregunta tan difícil, Turing la replanteó de la siguiente manera: “¿Existen ordenadores imaginables capaces de cumplir en el juego de imitación?”. Dicho “juego de imitación” consiste en que dos jugadores, uno hombre y otro mujer, intentan convencer a un interrogador de que son mujeres a base de notas escritas.

Turing sustituyó al hombre con un ordenador que tendría que imitar a base de textos a un “hombre haciéndose pasar por una mujer”. Esta prueba evolucionó hasta convertirse en lo que se conoce como “el test estándar”, en el que un interrogador tiene que decidir cuál de los participantes es un ser humano y cuál es una máquina imitando a uno. Por lo tanto, el propósito del test de Turing no es específicamente engañar al interrogador, sino imitar a un ser humano; parece que es lo mismo, pero en realidad no lo es porque lo segundo implica algo mas que reaccionar a las preguntas del interrogador, es decir, algo mas que “Si me pregunta esto, respondo esto”.

De hecho, el test que “Eugene” ha pasado en realidad está basado en una predicción de Turing de que para el año 2000, máquinas con 100 MB de almacenamiento serían capaces de engañar al 30% de los jueces en pruebas de cinco minutos de duración. Decir que “Eugene” ha pasado el Test de Turing puede ser demasiado optimista, sobre todo teniendo en cuenta que esa no es la interpretación actual.

Ampliar en: Omicrono

Primer ordenador que imita cerebro biológico, por IBM en camino

La gente que nos trajo el Internet (DARPA, la Agencia de

Proyectos de Investigaciones Avanzadas de Defensa de los EEUU), junto a IBM y 5 otras universidades, acaban de anunciar un proyecto en donde DARPA contribuirá con un monto inicial de US$4.9 Millones de dólares para patrocinar la investigación de la construcción de la primera super-computadora del mundo que imite a un cerebro biológico, en este caso el cerebro equivalente a un gato.

El campo de investigación a donde irán estos primeros fondos se llama «Computación Cognitiva», y como dicen en el artículo, traerá bajo una misma sombrilla a neurobiólogos, científicos de materiales, científicos en computación y psicólogos.

Por ahora la idea es utilizar el sistema que se construya en el proceso de análisis de datos a gran escala, toma de decisiones y reconocimiento de imágenes.

Según Dharmendra Modha, el científico de IBM que lidera este proyecto, «La mente tiene una habilidad sorprendente de integrar información ambigua distribuida por los sentidos, y puede con poco esfuerzo crear categorías de tiempo, espacio, objetos e interrelaciones de datos sensoriales.»

La idea entonces es utilizar computación cognitiva para crear máquinas con inteligencias similares a la de la mente, logrando esto haciendo ingeniería inversa en la estructura, dinámica, funcionamiento y comportamiento del cerebro.

Por ahora, una de las tareas mas difíciles será lograr la ingeniería necesaria para integrar los resultados de este proyecto en algo tangible, pero como dicen, ya hemos llegado a una etapa en donde la tecnología puede acercarse al nivel de miniaturización a gran escala necesaria como para acercarse a la escala de las neuronas, que tienen una densidad de 10,000 millones por centímetro cuadrado, esto gracias a los avances recientes en Nanotecnología.

Noten que IBM ya ha podido simular previamente al menos el potencial crudo de computación de parte del cerebro de un ratón, al emular 55 millones de neuronas conectadas a medio millón de millones de sinapsis.

Algo interesante es que como dice uno de los colaboradores del proyecto, esta es la primera vez que ha gran escala se intentará crear un sistema que no tenga un final u objetivo específico, sino que será algo totalmente genérico que se podrá adaptar a cualquier situación a la mano.

Nota interesante: Es una gran coincidencia que en mi charla en el ITLA de hace apenas 3 días titulada «Hacia la Humanidad 2.0 y mas allá…» este fue justo uno de los temas que expuse, en donde expliqué que actualmente hay 3 principales maneras de lograr una Inteligencia Artificial (IA).

La primera es IA a Fuerza Bruta. Esto implica tratar de lograr algoritmos que puedan pensar o imitar la inteligencia. Esto es extremadamente difícil de lograr (aunque bastante efectivo en video-juegos si se aplica a un fin en específico, como manejar un auto o ser el enemigo en un juego de combate).

La segunda es IA Emergente, en donde uno empieza al igual que la evolución con algo extremadamente sencillo y después por medio de procesos evolutivos uno hace que la mente artificial vaya cobrando inteligencia y consciencia poco a poco. Esto es lo mas sencillo pero al final es el mas complejo de entender.

Y la última manera es lo que llamé «IA Trasplantada», que es lo que este proyecto piensa hacer, lo que es copiar la estructura del cerebro (sin entender completamente cómo esta funciona) con el objetivo de que la versión artificial posea el mismo nivel cognitivo que el cerebro biológico emulado.

autobus las palmas aeropuerto cetona de frambuesa